2. 江苏省大气环境与装备技术协同创新中心(南京信息工程大学 自动化学院), 江苏 南京 210044

2. Jiangsu Province Atmospheric Environment and Equipment Technology Collaborative Innovation Center(School of Automation, Nanjing University of Information Science and Technology), Nanjing 210044, China

人体解析旨在将图像中的人体部件(例如头发, 帽子等)进行精细化分割, 是一项细粒度级别的语义分割任务.人体解析任务具有重要的研究意义, 能够使机器更好地理解以人为中心的图像内容, 也可为行人重识别[1, 2]、行为识别[3]、视频事件检测、智能安防等相关任务的发展提供技术支撑.然而, 人体解析仍是一个具有挑战性的工作, 一方面主要体现在现实场景中以人为中心的图像具有复杂的背景, 将人体的部件从复杂背景精确分割具有一定的难度; 另一方面, 人体图像中存在的遮挡以及人体姿态变化幅度大等问题都会增加人体解析任务的挑战性.

人体解析任务与语义分割[4]具有内在的关联性, 语义分割方法的发展对于人体解析任务的研究也具有积极的借鉴作用.近年来, 深度卷积网络在图像分类、目标检测等许多视觉问题中获得了广泛的应用, 有效推动了这些问题的研究进展.许多研究者也将卷积神经网络推广应用于语义分割任务.Long等人[5]将全卷积神经网络应用于语义分割任务, 并提出跳跃结构, 将不同尺寸的特征相互融合, 分割效果得到显著提升.Chen等人[6]提出空洞卷积并将其应用到语义分割, 空洞卷积实现了在保存语义特征分辨率的前提下提高特征的语义信息.Chen等人[7]在以往工作的基础上, 基于空洞卷积提出了一种空间金字塔状的卷积操作, 有效地提取多尺度特征, 并且结合Conditional Random Fields(CRF)后端处理, 进一步推动语义分割领域的发展.

语义分割网络的研究积累也促进了人体分割算法的发展.Liang等人[8]提出了一种上下文相关的卷积神经网络框架, 该模型可以同时获取图像多层的上下文信息, 有效提升了模型对衣服特征的辨别能力.Liang等人[9]提出一种深度局部-全局长短记忆模型, 该方法可以在特征提取时有效地利用像素位置的空间依赖关系.Chen等人[10]利用了多尺度信息, 并提出了一种注意力机制以更好地将多尺度特征进行融合.

人体解析任务主要是以人体为研究对象, 为了达到更好的分割精度, 需要充分利用人体结构信息.Gong等人[11]提出了一种名为SSL的自监督损失函数, 该方法使用的人体结构信息是通过直接提取对应的语义分割区域中心而得到, 巧妙地将人体结构信息应用到人体解析任务, 但是该方法提取到的人体姿态信息较为粗糙, 当人体姿态复杂时分割效果不理想.Liang等人[12]提出了JPPNet, 将人体姿态估计与人体解析两个任务有效地结合到一起, 该网络结构在预测人体姿态信息的同时进行人体解析任务, 并将两个任务的预测结果进行多次融合迭代, 进而达到相互辅助与相互促进的作用.虽然该方法有利于改进四肢部件的分割效果, 但在增强语义特征的过程中特征图分辨率会有所降低, 造成像素位置信息的损失[13], 小目标人体部件分割性能不尽人意.总体而言, 尽管现有方法在人体解析任务中取得了一定成果, 但是, 由于人体姿态的复杂性, 当前方法[10, 11, 14, 15]往往不能准确理解人体的结构信息, 对于四肢等人体部件容易造成误判, 同时对于小尺度目标区域的分割精度不够理想, 如何建立更为准确的人体解析模型仍是需要深入研究的难点问题.

针对上述问题, 本文提出了一种联合姿态先验的双分支人体精确解析方法.该方法通过估计人体姿态先验信息, 更好地理解人体各个部件之间的联系, 为后续解析任务提供指导信息.并且, 设计了双分支融合的解析模型, 其中全卷积网络解析分支得到全局分割结果, 检测解析分支则引入目标检测策略, 可对检测到的小目标部件进行精细分割.本文的人体解析方法能够有效提升四肢部件和小目标部件的分割性能, 在LIP[11]数据集上Mean Intersection over union(mIoU)的评测指标为52.19%, 相对于目前最好方法JPPNet取得的51.37%结果提升0.82%, 尤其是左鞋和右鞋分别提升9.87%和9.58%, 在ATR[14]数据集上的分割结果也验证了本文方法的有效性.

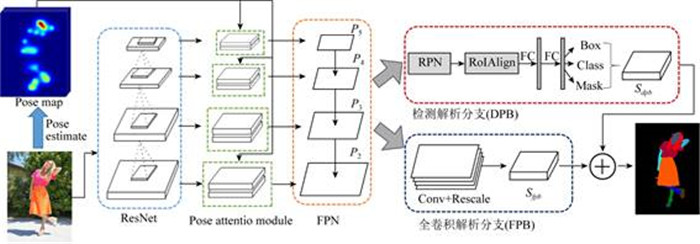

1 人体精确解析网络模型本文的主要工作是提出了联合姿态先验的人体解析双分支网络模型, 具体网络结构如图 1所示.首先主干网络联合人体结构先验提取多尺度语义特征, 然后通过两个分支得到人体解析结果.其中一个是全卷积解析分支, 用来直接预测每个像素点的类别; 另外一个为检测解析分支, 首先对图像中的人体部件进行检测, 然后对检测框所对应的区域中的人体部件进行分割; 网络的最终输出是两个分支融合的结果.

|

Fig. 1 Posture prior driven double-branch human parsing network architecture 图 1 联合姿态先验的人体解析双分支网络模型 |

1.1 人体结构先验驱动的主干网络

为了实现像素粒度的人体解析, 特征提取主干网络在增强特征的语义信息的同时应尽量提高特征图的分辨率.为此, 本文使用基于深度残差网络ResNet[13]的特征金字塔网络[16]提取人体图像的多尺度特征, 由顶向下逐步提取语义信息, 然后通过横向结构将不同分辨率的特征由底向上进行融合, 最终融合得到的多尺度特征分别记作{P2, P3, P4, P5}, 使其兼具高层语义与底层位置信息.

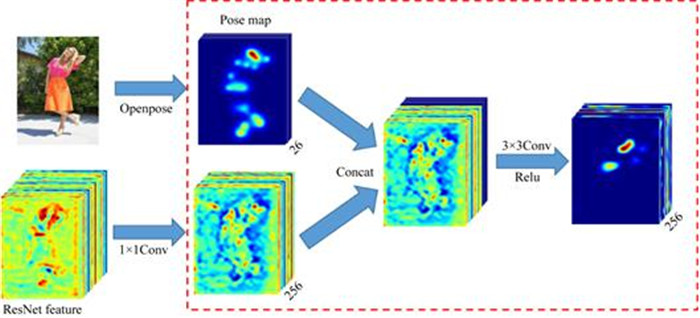

人体结构信息有利于增强人体特征的表达能力, 可以用于指导人体解析任务.为此, 本文的主干网络进一步将人体姿态先验作为注意力信息, 融合至多尺度特征的横向结构中, 记作Pose Attention模块, 网络结构如图 2所示.本文基于Openpose[17]模型估计人体关键点置信图

|

Fig. 2 Pose Attention module 图 2 Pose Attention模块结构 |

1.2 全卷积解析分支

受金字塔模型的层级语义解析思想[18]启发, 融合不同尺寸的特征能够更好地提取全局特征.为此, 本文分别将{P3, P4, P5}上采样使其与P2维度一致, 并将4个特征拼接在一起, 然后通过一个1×1的卷积对该特征进行降维的同时使多尺度特征更好地进行融合.最后使用一个1×1的卷积经过softmax并将其进行4倍上采样得到分类的置信图

在人体解析任务中有许多小目标, 例如帽子、鞋子、太阳眼镜和袜子.基于全卷积网络的分割模型为增强特征的表达能力特征维度会降低, 这会导致小目标丢失许多信息, 无法对其进行准确分割.为解决该问题, 本文引入目标检测来辅助人体解析, 该分支记作检测解析分支(DPB).

借鉴Mask R-CNN[19]的思想, 首先通过RPN[20]网络提取出目标的候选框, 然后根据候选框的大小将其分配到{P2, P3, P4, P5}上, 通过ROIAlign[19]将候选框所对应的特征采样为固定大小进行分类与分割.由于感兴趣区域(RoI)之间可能有重叠, 这就导致同一个像素点可能同时预测为多个类别, 因此, 本文不是直接使用RoI对应的分割结果.首先, 对于检测到的RoI使用非极大值抑制得到最终的检测框集合Box, 以及检测框集合对应的类别集合Cls及其预测为该类别的得分集合score和Box包含的检测框内图像预测为前景的像素集合mask; 最终该分支得到的预测结果记作

本文模型具有双分支结构, 各分支具有自身的学习任务.为了更好地对模型进行优化, 本文采用端到端的训练方法, 整体损失函数为两个分支损失函数之和, 具体可以表示为

| $L = {L_{FPB}} + {L_{DPB}}$ | (1) |

其中, LFPB、LDPB分别对应于FPB分支与DPB分支的损失函数.

关于FPB分支, LFPB具体定义为逐像素点softmax交叉熵损失:

| ${L_{parsing}} = - \frac{1}{m}\sum\limits_{i = 1}^m {\sum\limits_{j = 1}^n {1\{ {y^{(i)}} = j\} \log ({p_j})} } $ | (2) |

m为像素点个数, n为类别数, y(i)为第i个像素点类别, log(pj)为第i个像素点预测为第j类的概率值.

对于DPB分支, 其损失函数具体包括4项:

| ${L_{class}} = - \frac{1}{m}\sum\limits_{i = 1}^m {\sum\limits_{t = 1}^n {1\{ {y^{(i)}} = t\} \alpha {{(1 - {p_t})}^\gamma }\log ({p_t})} } ;\gamma = 2, \alpha = 0.25$ |

上式中m为样本个数, n为类别数,

| ${L_{bbox}} = smoot{h_{L1}}(x) = \left\{ \begin{gathered} 0.5{x^2}{\text{, if}}|x| < 1 \hfill \\ |x| - 0.5, {\text{ otherwise}} \hfill \\ \end{gathered} \right.$ | (4) |

Lmask应用于检测解析分支的分割分支, 与Mask R-CNN设置相同, 采用sigmoid二值交叉熵损失.

在训练候选框提取器(RPN)时的损失函数为

|

Fig. 3 The plot of loss function versus number of iterations 图 3 损失函数衰减曲线 |

3 实验结果与分析

本文主要在两个比较流行的单人人体解析数据集上进行了研究, 分别为LIP数据集和ATR数据集, 并进一步与当前比较先进的方法进行比较.本文所有实验均使用基于ResNet-50的FPN网络作为基准网络.本文选取标准评测指标Intersection over union(IoU)、Mean accuracy和Overall accuracy作为实验的评估方法.本文网络模型是使用caffe2实现, 以基于ResNet-50的FPN网络作为基准网络.在训练和测试时, 输入图像的长宽中较短的一条边缩放为400, 另一条边缩放相同的比例, 但是设定最大长度为666.每个GPU的mini-batch设定为4.本文在一个显存为12G的GTX Titan X GPU上训练, 初始学习率设为0.002 5, 基于ResNet-50的模型迭代90K次, 在迭代60K和80K时学习率相继缩小10倍.本文采用动量(momentum)随机梯度下降算法作为优化方法, 将momentum设定为0.9, weight decay设定为0.000 1.在训练时使用在coco数据集预训练的参数对网络初始化, 只使用左右翻转进行数据增广.

3.1 数据集LIP数据集是一个用于人体解析任务的大规模数据集.该数据集包含背景一共有20类, 共有50 462个样本, 其中训练集30 462张图像, 测试集与验证集分别为10 000张图像.该数据集背景较为复杂, 人体姿态幅度大并且存在遮挡问题, 目前该数据集依旧具有很大挑战性.

ATR数据集包含17 706张图像, 共有17类目标和1个背景类.ATR数据集没有划分训练集和测试集, 本文在其中随机选取3 000张图像作为测试集, 剩余14 706张图像作为训练集.

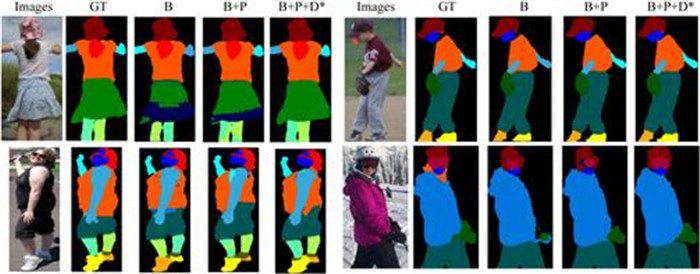

3.2 本文方法分析为探究Pose Attention模块、DPB分支的有效性, 本文主要在难度较大的LIP数据集上进行对比实验, 首先将各模块去除, 仅保留全卷积网络作为本文的基准网络B, 并通过递进组合的方式, 验证不同模块的有效性.由于P2特征尺寸为原输入的1/4, 需将基准网络B最后预测的结果上采样4倍还原为输入尺寸.如表 1所示, 基准网络B在mIoU的评测指标下达到44.23%的准确率.使用基准网络B对输入图像进行分割, 一些失败的样本如图 4所示.经过分析与观察预测图 4中结果, 主要有以下问题:(1)当姿态复杂时, 四肢等部件容易造成左右混淆, 尤其是当图像中的行人为背影或侧身时; (2)对于小目标分割不精确.图 4中, B表示基准网络, P、D分别表示Pose Attention模块和DPB模块, *表示分类损失为focal loss.

| Table 1 The results of each module on the validation set of LIP and the result of JPPNet 表 1 本文模型的各个模块在LIP测试集的对比实验结果及当前最新方法JPPNet结果 |

|

Fig. 4 The visualization of each Blob's prediction results on the validation set of LIP 图 4 各个模块在LIP测试集的预测结果可视化 |

本文首先在基准网络B中引入Pose Attention模块, 分别在生成{P2, P3, P4, P5}的横向结构中插入Pose Attention模块.如表 1所示, 此模块使预测结果在mIoU的测量指标下得到4.83%的提升, 主要表现在鞋子、腿部、胳膊等四肢人体部件的提升, l-shoes和r-shoes的性能分别得到18.46%和18.13%的显著提升.实验结果表明, 引入人体姿态信息能够有效提升模型对具有左右属性的四肢部件的判别能力.表 1中, B表示基准网络, P、D分别表示Pose Attention模块和DPB模块, *表示分类损失为focal loss.

Pose Attention模块作用在生成多尺度特征{P2, P3, P4, P5}的横向结构中, 为了进一步验证其有效性, 本文做了如下对比实验.只在生成特征P2的横向结果中加入Pose Attention模块, 该方法记作PL2;与上述描述类似, PL3、PL4、PL5分别表示只在生成特征P3、P4、P5的横向结构中加入Pose Attention模块.如表 2所示, 人体姿态信息引入各个生成多尺度特征的横向结构中都能使结果有相应提升.

| Table 2 The mIoU pose attention module at different locations 表 2 Pose Attention模块在不同位置处的mIoU指标比较 |

人体姿态关键点能够帮助我们更好地理解人体结构信息, 能够有效地提升与人体四肢相关的部件的分割性能.本文为进一步分析不同部位的关键点对模型性能的影响, 在测试阶段分别将对应部位的关键点响应置为0.为验证与胳膊相关的关键点对模型的作用, 本文将手肘、手腕、肩膀关键点对应的通道响应设为0, 结果见表 3, 与使用所有关键点的结果对比, l-arm与r-arm的结果下降10.37%与9.80%, 其他部件的分割性能基本不变.当将腿部相关的关键点响应置为0时, 在IoU的评测指标下, l-leg与r-leg的结果分别为49.25%与49.21%;当将脚部相关的关键点响应置为0时, l-shoe与r-shoe的结果分别为28.17%与23.01%.同时, 为了研究人体姿态估计误差对模型性能的影响, 本文将人体姿态估计的标签作为人体结构信息.由于只有LIP数据集有人体关键点标注, 因此, 本文只在该数据集进行此对比实验, 在mIoU的评测指标下结果为51.93%, 与使用Openpose模型的预测结果接近, 实验结果表明, 本文方法对人体姿态估计误差具有一定的鲁棒性.

| Table 3 The effect of different human poses 表 3 不同人体姿态关键点对模型性能的影响 |

为了验证DPB分支的作用, 本文在引入Pose Attention模块的基础上进一步引入DPB模块.如表 1所示, 引入DPB能够使鞋子、太阳眼镜、袜子、围巾等小目标的分割性能得到显著提升, 其中, l-shoe提升3.82%, r-shoe提升3.75%, 整体性能提升3.14%.

根据文献[11]对LIP数据集样本进行统计, 本文观察到样本类别存在较大程度的不均衡问题, 包含脸部、头发等目标的样本比较多, 围巾、连体衣等在数据集中出现的次数较少.针对上述问题, 本文在检测分支预测类别时选用focal loss.如表 1所示, 当分类损失为focal loss时mIoU为52.19%, 相对于仅使用交叉熵损失时的结果51.55%提升0.64%, 这主要表现在数量较少的样本类别中.

本文采用双分支的网络结构, 最终人体各部件分割得分S=Sfpb+Sdpb.关于FPB分支与DPB分支结果融合策略的探讨, 本文做如下对比实验.首先, 将Sfpb与Sdpb拼接, 然后通过一个3×3的卷积与一个1×1的卷积得到最终分类的置信图S, 在mIoU的评测指标下结果为51.66%.实验结果表明, 本文的融合策略更加简洁、高效.

3.4 对比实验对于LIP数据集, 本文与当前几种比较好的方法比较, 结果见表 4.在Mean accuracy与mIoU的评测指标下, 本文的方法比当前最好的方法JPPNet的结果分别提升3.13%和0.82%.将人体姿态估计信息作为人体结构先验, 模型能够更好地理解人体各个部件之间的关系, 有利于人体部件的分割.在卷积神经网络提取特征的过程中小尺度目标的信息损失较为严重, 检测解析分支能够将小目标部件所对应的区域放大, 对其进行精确分割. JPPNet在mIoU的评测指标下各类的得分见表 1, 本文方法对于四肢部件和小目标部件的分割性能均优于JPPNet, 其中左鞋和右鞋分别得到9.87%和9.58%的显著提升, 太阳眼镜提升10.84%.值得注意的是, 本文方法的基准网络使用的是ResNet-50提取的特征, 而JPPNet的基准网络使用的是ResNet-101, 而且本文在测试时只使用原始图像, 没有对输入进行翻转以及多尺度测试.

| Table 4 Parsing performance of multiple methods on validation set of LIP 表 4 本文及其对比方法在LIP测试集上的解析结果 |

对于ATR数据集主要与当前主流的3种方法进行对比, 见表 5, 由于JPPNet方法在训练阶段需要人体姿态关键点的标注信息, 但是ATR数据集并未提供该标注信息, JPPNet在该数据集上并不适用, 因此表 5中没有与此方法进行对比.本文的方法比Attention+SSL[11]的结果在Mean accuracy的评测指标下高4.94%, 在Mean IoU的评测指标下要高5.38%.

| Table 5 Parsing performance of multiple methods on ATR dataset 表 5 本文及其对比方法在ATR数据集上的解析结果 |

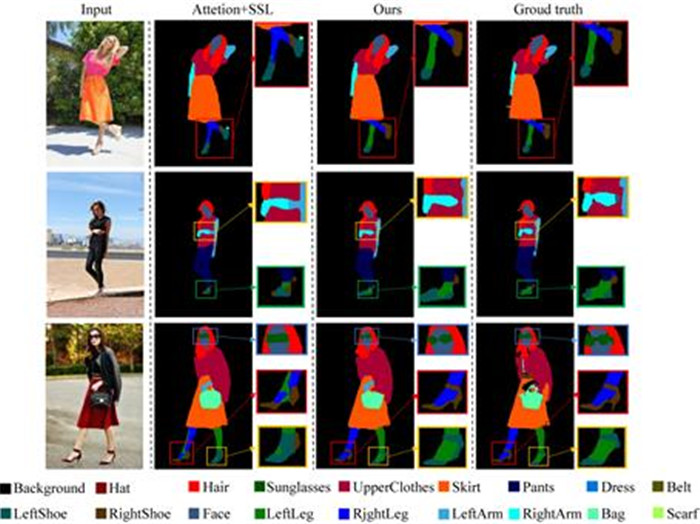

本文选取ATR数据集部分预测结果可视化, 如图 5所示, 第1列为输入图像, 第2列为Attention+SSL方法的预测结果, 第3列为本文方法的可视化结果, 同时, 为方便对比分析, 本文将标签可视化, 如第4列所示. Attention+SSL方法由于缺少准确的人体结构先验信息, 当人体姿态复杂时, 容易对左右鞋、左右腿等人体四肢部件造成误判, 本文方法在添加可靠的人体结构信息的情况下可对人体四肢相关部件进行准确分割; 如图 5第3行可视化结果所示, 本文方法对于小目标部件中的太阳眼镜分割效果明显优于Attention+SSL方法, 可对其边缘部位准确分割; 对于鞋子这类小目标, 本文方法在对其准确分类的同时还能对其边缘进行精确分割.

|

Fig. 5 The visualization of segmentation results upon the ATR dataset 图 5 ATR数据集分割结果可视化 |

4 结论

针对人体四肢等部件和小目标分割不精确的问题, 本文提出了一种联合姿态先验的人体解析双分支网络模型.实验结果表明, 该方法能够实现人体部件的精确分割, 对太阳眼镜等小目标和与四肢相关的部件有较好的分割效果.下一步研究工作的重点将是如何提升四肢部件和小目标部件除外的人体部件的分割性能, 以及如何优化算法提升模型的检测速度.

| [1] |

Zhao R, Ouyang W, Wang X. Unsupervised salience learning for person re-identification. In: Proc. of the 2013 IEEE Conf. on Computer Vision and Pattern Recognition (CVPR). IEEE, 2013. 3586-3593.

|

| [2] |

Cai H, Wang Z, Cheng J. Multi-scale body-part mask guided attention for person re-identification. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition Workshops. 2019. https://www.researchgate.net/publication/332147948_Multi-layer_attention_for_person_re-identification

|

| [3] |

Gan C, Lin M, Yang Y, et al. Concepts not alone: Exploring pairwise relationships for zero-shot video activity recognition. In: Proc. of the 30th AAAI Conf. on Artificial Intelligence. 2016. https://dl.acm.org/doi/10.5555/3016387.3016394

|

| [4] |

Tian X, Wang L, Ding Q. Review of image semantic segmentation based on deep learning. Ruan Jian Xue Bao/Journal of Software, 2019, 30(2): 440-468(in Chinese with English abstract). http://www.jos.org.cn/1000-9825/5659.htm [doi:10.13328/j.cnki.jos.005659]

|

| [5] |

Long J, Shelhamer E, Darrell T. Fully convolutional networks for semantic segmentation. IEEE Annals of the History of Computing, 2017(4): 640-651.

http://d.old.wanfangdata.com.cn/Periodical/nygcxb201918019 |

| [6] |

Chen LC, Papandreou G, Kokkinos I, et al. Semantic image segmentation with deep convolutional nets and fully connected CRFS. arXiv Preprint arXiv: 1412.7062, 2014. https://www.researchgate.net/publication/269932975_Semantic_Image_Segmentation_with_Deep_Convolutional_Nets_and_Fully_Connected_CRFs

|

| [7] |

Chen LC, Papandreou G, Kokkinos I, et al. Deeplab:Semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected CRFS. IEEE Trans. on Pattern Analysis and Machine Intelligence, 2018, 40(4): 834-848.

[doi:10.1109/TPAMI.2017.2699184] |

| [8] |

Liang X, Xu C, Shen X, Yang J, Liu S, Tang J, Lin L, Yan S. Human parsing with contextualized convolutional neural network. In: Proc. of the IEEE Int'l Conf. on Computer Vision. 2015. 1386-1394. https://dl.acm.org/doi/10.1109/ICCV.2015.163

|

| [9] |

LiangX, ShenX, Xiang D, Feng J, Lin L, Yan S. Semantic object parsing with local-global long short-term memory. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2016. 3185-3193. https://www.researchgate.net/publication/311610262_Semantic_Object_Parsing_with_Local-Global_Long_Short-Term_Memory

|

| [10] |

Chen LC, Yang Y, Wang J, et al. Attention to scale: Scale-aware semantic image segmentation. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2016. 3640-3649. http://www.oalib.com/paper/4055008

|

| [11] |

Gong K, Liang X, Zhang D, et al. Look into Person: Self-supervised structure-sensitive learning and a new benchmark for human parsing. 2017.[doi: 10.1109/CVPR.2017.715]

|

| [12] |

Liang X, Ke G, Shen X, et al. Look into Person:Joint body parsing & pose estimation network and a new benchmark. IEEE Trans. on Pattern Analysis & Machine Intelligence, 2018(99): 1.

https://arxiv.org/abs/1804.01984 |

| [13] |

He K, Zhang X, Ren S, et al. Deep residual learning for image recognition. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2016. 770-778. https://www.cv-foundation.org/openaccess/content_cvpr_2016/papers/He_Deep_Residual_Learning_CVPR_2016_paper.pdf

|

| [14] |

Liang X, Yang J, Yang J, et al. Deep human parsing with active template regression. IEEE Trans. on Pattern Analysis & Machine Intelligence, 2015, 37(12): 2402.

https://www.ncbi.nlm.nih.gov/pubmed/26539846 |

| [15] |

Yang L, Song Q, Wang Z, et al. Parsing R-CNN for instance-level human analysis. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2019. 364-373. https://www.researchgate.net/publication/338509707_Parsing_R-CNN_for_Instance-Level_Human_Analysis

|

| [16] |

Lin TY, Dollár P, Girshick R, et al. Feature pyramid networks for object detection. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2017. 2117-2125. https://www.researchgate.net/publication/311573567_Feature_Pyramid_Networks_for_Object_Detection

|

| [17] |

Cao Z, Simon T, Wei SE, et al. Realtime multi-person 2D pose estimation using part affinity fields. In: Proc. of the IEEE Conf. on Computer Vision & Pattern Recognition. 2017. https://www.researchgate.net/publication/310953055_Realtime_Multi-Person_2D_Pose_Estimation_using_Part_Affinity_Fields

|

| [18] |

Zhao H, Shi J, Qi X, et al. Pyramid scene parsing network. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2017. 2881-2890. https://arxiv.org/abs/1612.01105

|

| [19] |

He K, Gkioxari G, Dollár P, et al. Mask R-CNN. In: Proc. of the 2017 IEEE Int'l Conf. on Computer Vision (ICCV). 2017.

|

| [20] |

Ren S, He K, Girshick R, et al. Faster R-CNN:Towards real-time object detection with region proposal networks. In:Advances in Neural Information Processing Systems, 2015, 91-99.

https://arxiv.org/pdf/1506.01497 |

| [21] |

Lin TY, Goyal P, Girshick R, et al. Focal loss for dense object detection. IEEE Trans. on Pattern Analysis & Machine Intelligence, 2017(99): 2999-3007.

http://www.wanfangdata.com.cn/details/detail.do?_type=perio&id=10.1177/136140968800200204 |

| [22] |

Girshick R. Fast R-CNN. In: Proc. of the IEEE Int'l Conf. on Computer Vision. 2015. 1440-1448.

|

| [4] |

田萱, 王亮, 丁琪.基于深度学习的图像语义分割方法综述.软件学报, 2019, 30(2): 440-468. http://www.jos.org.cn/1000-9825/5659.htm

|

2020, Vol. 31

2020, Vol. 31