2. 复旦大学 计算机科学技术学院, 上海 200433

2. School of Computer Science, Fudan University, Shanghai 200433, China

近年来, 作为人工智能(artificial intelligence, 简称AI)的核心技术, 深度学习在图像、语音、文本处理等领域取得了大量关键性突破.尤其在2016年和2017年, 由Google公司开发的AlphaGo围棋机器人, 利用深度学习技术完善了围棋算法, 分别战胜围棋界的世界冠军李世石和柯洁, 震惊了整个科技界[1].

人工智能是机器产生的智能, 在计算机领域是指根据对环境的感知, 做出合理的行动并获得最大收益的计算机程序[2].也就是说, 要想实现人工智能, 需要把人类理解和判断事物的能力教给计算机, 让计算机拥有类似人类的识别能力[3].人类在认识一个新事物时, 首先要形成对该事物的初步印象.例如, 要识别出飞机, 就需要看到相应的图片或者真实物体.数据标注可视为模仿人类学习过程中的经验学习, 相当于人类从书本中获取已有知识的认知行为.具体操作时, 数据标注把需要计算机识别和分辨的图片事先打上标签, 让计算机不断地识别这些图片的特征, 最终实现计算机能够自主识别[4].数据标注为人工智能企业提供了大量带标签的数据, 供机器训练和学习, 保证了算法模型的有效性.

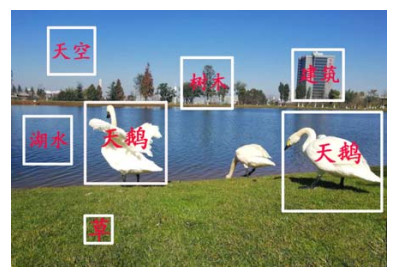

1 数据标注概述 1.1 数据标注的起源2007年, 斯坦福大学教授李飞飞等人开始启动ImageNet项目, 该项目主要借助亚马逊的劳务众包平台Mechanical Turk(AMT)来完成图片的分类和标注, 以便为机器学习算法提供更好的数据集[5].截至2010年, 已有来自167个国家的4万多名工作者提供了14 197 122张标记过的图片, 共分成21 841种类别[6].从2010年到2017年, ImageNet项目每年举办一次大规模的计算机视觉识别挑战赛, 各参赛团队通过编写算法来正确分类、检测和定位物体及场景.ImageNet项目的成功, 改变了人工智能领域中大众的认知, 即数据是人工智能研究的核心, 数据比算法重要得多[7].从此, 数据标注拉开了序幕.目前, 学术界尚未对数据标注的概念形成一个统一的认识, 比较认可的是由王翀和李飞飞等人提出的定义.他们认为, 标注[8]是对未处理的初级数据, 包括语音、图片、文本、视频等进行加工处理, 并转换为机器可识别信息的过程.原始数据一般通过数据采集获得, 随后的数据标注相当于对数据进行加工, 然后输送到人工智能算法和模型里完成调用[9].数据标注产业主要是根据用户或企业的需求, 对图像、声音、文字等对象进行不同方式的标注[10], 从而为人工智能算法提供大量的训练数据以供机器学习使用[11].图 1显示了一个图像标注的示例, 标注者需要识别和标注图片中的景物如天空、树木、建筑、湖水和草等对象.

|

Fig. 1 Example of data annotation 图 1 数据标注示例 |

1.2 数据标注的应用场景

数据标注产业的发展, 促进了人工智能的蓬勃兴起, 其主要的应用行业和不同行业的标注场景总结如下.

(1) 自动驾驶[12]:利用标注数据来训练自动驾驶模型, 使其能够感知周围的环境并在很少或没有人为输入的情况下移动.自动驾驶中的数据标注涉及行人识别、车辆识别、红绿灯识别、道路识别等内容, 可以为相关企业提供精确的训练数据, 为智能交通保驾护航.

(2) 智能安防[13]:数据标注扩大了现有安防系统的感知范围, 通过融合各种来源的数据并进行协同分析, 提高监控和报警的准确性; 其对应的标注场景有面部识别、人脸探测、视觉搜索、人脸关键信息点提取以及车牌识别等.

(3) 智慧医疗:人工智能和大数据分析技术应用于医疗行业, 可以深入洞察医学知识和数据, 帮助医生和患者解决在医学影像、新药研发、肿瘤与基因、健康管理等领域所面临的影像识别困难、药物研发成本巨大、癌症治疗效果不佳等难题[14].其所涉及的场景有手术工具标识、处方识别、医疗影像标注、语音标注等.

(4) 工业4.0:利用标注数据训练和验证机器人应用程序的计算机视觉模型, 从而使模型对工业环境内的各类障碍物、机械设备和机器人有更加精确的感知[15], 实现工业智能机器与所处环境中人和物的安全交互.对应的场景有机械手臂导航、仓储码垛、自动分拣或抓取、自动焊接等.

(5) 新零售:将人工智能和机器学习应用于新零售行业, 可以通过商品销售数据以及用户的真实反馈促进电子商务的销售, 提高用户的个性化体验以及预测客户需求[16], 并实现线上货物推荐的精准化.新零售中涉及的标注场景包括超市货架识别、无人超市系统和电子商务智能搜索与推荐等.

(6) 智慧农业:依托精准的数据标注实现对农作物的定位以及对其成熟度和生长状态的识别, 实现农作物智能采摘并解决精准农药撒播问题[17], 从而减少人力消耗并提高农药利用率.目前, 智慧农业中有关数据标注的场景有栽培管理、精准水肥和安全监测等.

1.3 数据标注的分类方法本节详细比较了不同数据标注分类方法的概念和优缺点, 见表 1.

| Table 1 Classification of data annotation 表 1 数据标注分类 |

如表 1所示, 目前数据标注有3种常用的划分方式:(1)按照标注对象进行分类, 包括图像标注、视频标注、语音标注和文本标注[22]; (2)根据标注的构成形式, 将其分为结构化标注、非结构化标注和半结构化标注[23-26]; (3)根据标注者类型, 分为人工标注和机器标注[27].

图像标注包括图像标注和视频标注, 因为视频也是由连续播放的图像所组成[28].图像标注一般要求标注人员使用不同的颜色来对不同的目标标记物进行轮廓识别, 然后给相应的轮廓打上标签, 用标签来概述轮廓内的内容, 以便让算法模型能够识别图像中的不同标记物[29, 30].图像标注常用于人脸识别、自动驾驶车辆识别等应用[31].语音标注是通过算法模型识别转录后的文本内容并与对应的音频进行逻辑关联[32].语音标注的应用场景包括自然语言处理、实时翻译等, 语音标注的常用方法是语音转写.文本标注是指根据一定的标准或准则对文字内容进行诸如分词、语义判断、词性标注、文本翻译、主题事件归纳等注释工作, 其应用场景有名片自动识别、证照识别等[33].目前, 常用的文本标注任务有情感标注、实体标注、词性标注及其他文本类标注.图 2以文本标注中的中文文本词性标注为例进行说明, 其中, n, v和a分别代表句子中词语的词性, 即n表示名词、v表示动词、a表示形容词、wp代表断句.

|

Fig. 2 Example of text annotation 图 2 文本标注示例 |

下面第1.4节中提到的标框标注就是典型的半结构化标注, 如在豆瓣影评上对某部电影进行评价或在小组会议上发表自己的观点等都属于非结构化标注, 而对电影类型进行标注就属于结构化标注.人工标注和机器标注比较好理解, 这里就不再举例.除了表 1所列举的分类方法外, 元数据标注也受到了一些学者的关注.郭晓明等人使用基于相似度计算的语义标注算法DM-SAAS(database metadata semantic annotation algorithm based on similarity)实现了元数据自动语义标注[34], 也为数据标注工作研究者提供了思路.

1.4 数据标注的任务常见的数据标注任务包括分类标注、标框标注、区域标注、描点标注和其他标注等.下面介绍每一种任务的具体内容[35].

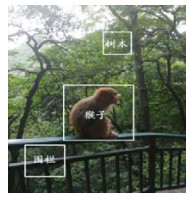

1) 分类标注.分类标注是从给定的标签集中选择合适的标签分配给被标注的对象[36].通常, 一张图可以有很多分类/标签, 如运动、读书、购物、旅行等.对于文字, 又可以标注出主语、谓语、宾语, 名词和动词等[37].此项任务适用于文本、图像、语音、视频等不同的标注对象[38].本文以图像的分类标注为例进行说明, 如图 3所示.图 3显示了一张公园的风景图, 标注者需要对树木、猴子、围栏等不同对象加以区分和识别.

|

Fig. 3 Classification annotation 图 3 分类标注 |

2) 标框标注.标框标注就是从图像中选出要检测的对象[39], 此方法仅适用于图像标注.标框标注可细分为多边形拉框和四边形拉框两种形式.多边形拉框是将被标注元素的轮廓以多边型的方式勾勒出来, 不同的被标注元素有不同的轮廓, 除了同样需要添加单级或多级标签以外, 多边型标注还有可能会涉及到物体遮挡的逻辑关系, 从而实现细线条的种类识别[40].四边形拉框主要是用特定软件对图像中需要处理的元素(比如人、车、动物等)进行一个拉框处理, 同时, 用1个或多个独立的标签来代表 1个或多个需要处理的元素.例如, 图 4对人物的帽子进行了多边形拉框标注, 图 5则对天鹅进行了四边形拉框标注.

|

Fig. 4 Polygonal frame 图 4 多边形拉框 |

|

Fig. 5 Quadrilateral frame 图 5 四边形拉框 |

3) 区域标注.与标框标注相比, 区域标注的要求更加精确[41], 而且边缘可以是柔性的, 并仅限于图像标注, 其主要的应用场景包括自动驾驶中的道路识别和地图识别等.在图 6中, 区域标注的任务是在地图上用曲线将城市中不同行政区域的轮廓形式勾勒出来, 并用不同的颜色(浅蓝、浅棕、紫色和粉色)加以区分.

|

Fig. 6 Region annotation 图 6 区域标注 |

4) 描点标注.描点标注是指将需要标注的元素(比如人脸、肢体)按照需求位置进行点位标识, 从而实现特定部位关键点的识别[42].例如, 图 7采用描点标注的方法对图示人物的骨骼关节进行了描点标识.人脸识别、骨骼识别等技术中的标注方法与人物骨骼关节点的标注方法相同[43].

|

Fig. 7 Point annotation 图 7 描点标注 |

5) 其他标注.数据标注的任务除了上述4种以外, 还有很多个性化的标注任务.例如, 自动摘要就是从新闻事件或者文章中提取出最关键的信息, 然后用更加精炼的语言写成摘要[44].自动摘要与分类标注类似, 但两者存在一定差异.常见的分类标注有比较明确的界定, 比如在对给定图片中的人物、风景和物体进行分类标注时, 标注者一般不会产生歧义; 而自动摘要需要先对文章的主要观点进行标注, 相对于分类标注来说, 在标注的客观性和准确性上都没有那么严格, 所以自动摘要不属于分类标注.

2 数据标注中的数据集、工具和平台随着人工智能、机器学习等行业对标注数据的海量需求, 许多企业和研究机构纷纷推出了带标注的公开数据集.为了提高数据标注效率, 一些标注工具和平台也应运而生[45].下面将对常用的标注数据集、部分主流的数据标注工具、平台及其适用场合进行阐述.

2.1 常用标注数据集本文将标注数据集划分为图像、视频、文本和语音标注数据集这4大类, 表 2描述了这些数据集的来源、用途和特性.ImageNet、COCO和PASCAL VOC是3个典型的图像标注数据集.它们广泛应用于图像分类、定位和检测的研究中.由于ImageNet数据集拥有专门的维护团队, 而且文档详细, 它几乎成为了目前检验深度学习图像领域算法性能的“标准”数据集.COCO数据集是在微软公司赞助下生成的数据集, 除了图像的类别和位置标注信息外, 该数据集还提供图像的语义文本描述.因此, 它也成为评价图像语义理解算法性能的“标准”数据集. Youtube-8M是谷歌公司从YouTube上采集到的超大规模的开源视频数据集, 这些视频共计800万个, 总时长为50万小时, 包括4 800个类别.Yelp数据集由美国最大的点评网站提供, 包括了470万条用户评价, 15多万条商户信息, 20万张图片和12个城市信息.研究者利用Yelp数据集不仅能进行自然语言处理和情感分析, 还可以用于图片分类和图像挖掘.Librispeech数据集是目前最大的免费语音识别数据库之一, 由近1 000h的多人朗读的清晰音频及其对应的文本组成.它是衡量当前语音识别技术最权威的开源数据集.

| Table 2 Partial common annotation datasets 表 2 部分常用的标注数据集 |

2.2 商业的数据标注平台

通常, 商用的数据标注工具一般是由众包标注平台来提供.数据标注众包模式[46, 47]平台最早出现在美国, 除了亚马逊的Mechanical Turk[48]平台外, 还有Figure-eight、CrowdFlower、Mighty AI等初创型标注平台[49].近年来, 国内的一些互联网公司、大数据公司和人工智能公司也纷纷推出了自己的数据标注众包平台和商用标注工具, 如数据堂、百度众测、阿里众包、京东微工等.这些商业的数据标注平台基本上都能对图片、视频、文本和语音等数据进行标注, 但各自的业务方向也有一定侧重, 有的以处理图像见长, 有的则更擅长做一些视频标注[50].

无论是开源的标注工具还是商用的数据标注平台, 它们至少要包含以下内容[51].

1) 进度条:用于指示数据标注的进度.一方面方便标注人员查看进度, 另一方面也利于统计.

2) 标注主体(指需要标注的对象):可以根据标注形式进行设计, 一般可以分为单个标注(指对某一个对象进行标注)和多个标注(指对多个对象进行标注)的形式[52].

3) 数据导入、导出功能.

4) 收藏功能:针对模棱两可的数据, 可以减少工作量并提高工作效率.

5) 质检机制:通过随机分发部分已标注过的数据, 检测标注人员的可靠性.

2.3 开源的数据标注工具在选择数据标注工具时, 需要考虑标注对象(如图像、视频、文本等)、标注需求(如画框、描点、分类等)和不同的数据集格式[53](比如COCO、PASCAL VOC、JSON等).常用标注工具见表 3.

| Table 3 Partial open source data annotation tools 表 3 部分开源的数据标注工具 |

表 3中列举了一些开源的数据标注工具及其特点.表 3中除了COCO UI和LabelMe工具在使用时需要MIT许可外, 其他工具均为开源使用.大部分的开源工具都可以运行在Windows、Linux、Mac OS系统上, 仅有个别工具是针对特定操作系统开发的(如RectLabel); 而且这些开源工具大多只针对特定对象进行标注, 只有一少部分工具(如精灵标注助手)能够同时标注图像、视频和文本.除了表 3中列举的标注工具外, 市场上还有一些特殊功能的标注工具, 例如人脸数据标注[54]和3D点云标注工具.不同标注工具的标注结果会有一些差异, 但很少有研究关注它们的标注效率和标注结果的质量[55].

3 数据标注规范 3.1 数据标注的角色传统手工数据标注中的用户角色可以分为3类[56].

1) 标注员:负责标注数据, 通常由经过一定专业培训的人员来担任.在一些特定场合或者对标注质量要求极高的行业(例如医疗), 也可以直接由模型训练人员(程序员)或者领域专家来担任.

2) 审核员:负责审核已标注的数据, 完成数据校对和数据统计, 适时修改错误并补充遗漏的标注.这个角色往往由经验丰富的标注人员或权威专家来担任.

3) 管理员:负责管理相关人员, 发放和回收标注任务.

数据标注过程中的各个角色之间相互制约, 各司其职, 每个角色都是数据标注工作中不可或缺的一部分.此外, 已标注的数据往往用于机器学习和人工智能中的算法, 这就需要模型训练人员利用人工标注好的数据训练出算法模型.而产品评估人员则需要反复验证模型的标注效果, 并对模型是否满足上线目标进行评估.

3.2 数据标注的质量标准本节根据标注对象本身的特征和标注需求来阐述数据标注要遵循的质量标准[57], 当然, 在实际操作中还需要根据实际情况进一步细化.

1) 图像标注的质量标准

机器学习中图像识别的训练是根据像素点进行的, 因此, 图像标注的质量好坏取决于像素点的判定准确性.标注像素点越接近标注物的边缘像素, 标注质量就越高, 标注难度也就越大; 反之, 则标注质量较差, 标注难度较小.按照100%准确率的图像标注要求, 标注像素点与标注物的边缘像素点的误差应该在1个像素以内[59].

2) 语音标注的质量标准

在进行语音标注时, 标注员需要时刻关注语音数据发音的时间轴与标注区域的音标是否同步.所以, 标注与发音时间轴的误差要控制在1个语音帧以内.如果误差超过1个语音帧, 则很容易标注到下一个发音, 从而产生更多的噪声数据.

3) 文本标注的质量标准

由于文本标注中的任务较多, 不同任务的质量标准各有不同.例如, 中文分词的质量标准是标注好的分词与词典中的词语一致, 不存在歧义.情感标注的质量标准则要求对标注句子的情感分类级别正确.多音字标注的质量标准是借助专业性工具(如字典)来标注一个字的全部读音; 而语义标注的质量标准是标注清楚词语或句子的真实语义.

3.3 数据标注的流程本节以众包模式下的数据标注为例, 提出了一个完整的数据标注流程, 如图 8所示.数据标注流程首先从标注数据的采集[58]开始, 采集的对象包括视频、图片、音频和文本等多种类型和多种格式的数据.由于采集到的数据可能存在缺失值、噪声数据、重复数据等质量问题, 故首先需要执行数据清洗任务[59], 以便获得高质量的数据, 然后对清洗后的数据进行标注, 这是数据标注流程中最重要的一个环节.在具体流程中, 管理员会根据不同的标注需求, 将待标注的数据划分为不同的标注任务.每一个标注任务都有不同的规范和标注点要求, 并且一个标注任务将会分配给多个标注员完成.数据标注员完成标注工作后, 将相关数据交给模型训练人员, 后者利用这些标注好的数据来训练出需要的算法模型.标注数据的质量主要由审核员来检验, 审核员进行模型测试并将测试结果反馈给模型训练人员, 而模型训练人员通过不断地调整参数, 以便获得性能更好的算法模型.如果经过参数调整后不能得到最优的算法模型, 则说明已标注的数据不满足需求.这时, 审核员就会向标注员反馈数据问题, 标注员则需要重新标注数据.最后, 审核员将最优模型指标发送给产品评估人员使用, 并进行上线前的最后评估.

|

Fig. 8 Basic process of data annotation 图 8 数据标注基本流程 |

4 数据标注实例——情感分析 4.1 情感分析概述

随着电子商务、社交网络和移动互联网的蓬勃发展, 互联网上出现了大量带有情感色彩的文本数据.针对文本数据的情感分析, 能够帮助政府部门及企事业单位更好地理解用户的观点, 并及时解决出现的各类问题, 以进一步提高服务质量[60].因此, 情感分析广泛应用在舆情管控、商业决策、观点搜索、信息预测和情绪管理等场景.

词语、句子和文章是文本情感分析中的3个级别[61].词语级别的情感分析用来确定词语的情感倾向方向和强度, 句子级别的情感分析是先对句子进行命名实体识别和句法分析, 在采用基于词典和机器学习的研究方法对句子进行情感分析.文章级的情感分析则是分析文章段落的情感倾向方向.情感倾向是主体对某一客体主观存在的内在评价的一种倾向.它由情感倾向方向和情感倾向度来衡量[62].情感倾向方向也称为情感极性.在情绪文本中, 情感倾向方向是用户对客体表达其自身观点态度, 即支持(正面情感)、反对(负面情感)、中立(中性情感); 情感倾向度是指主体对客体表达正面情感或负面情感时的强弱程度, 不同的情感程度往往是通过不同的情感词或情感语气等来体现.在情感倾向分析研究中, 通过对每个情感词赋予不同的权值来区分两者的程度.

4.2 情感分析中的数据标注情绪文本的分析和挖掘涉及到文本数据标注中的多项任务, 下面将对这些任务进行阐述.

1) 中文分词

中文分词是将一个汉字序列切分为一个个单独的词, 中文分词是汉语文本处理的基础.例如, 要判断句子A=“今天是国庆节, 可是我们还要加班.”的情感, 首先要将其切分为一个个单词, 如果采用自动分词, 其结果为

“今天/是/国庆节/, /可是/我们/还/要/加班/.”

如果采用基于字标注的分词方法, 则其结果为

“今/B天/E是/S国/S庆/M节/E/, S/可/S是/E我/B们/E还/S要/S加/S班/E./S”,

其中, B表示词首, M表示词中, E表示词尾, S代表单独成词.它们形成了4个构词位置.

2) 词性标注

词性标注是将词划分为对应的语法分类, 以表达这个词在上下文中的含义.词的语法分类主要为名词、动词、形容词、量词、代词、副词、连词、助词等.上述句子A的词性标注结果如图 9所示.

|

Fig. 9 Examples of part-of-speech annotation 图 9 词性标注示例 |

其中, n, v, conj, p和adv分别代表句子中的名词、动词、连词、代词和副词, w表示标点符号, wp代表断句.

3) 情感标注

句子A中并没有明确表示情绪的词, 不过联系上下文可知, 句子表达的情绪是“低落”.为了判断句子A所表达的情绪, 我们可以使用一些中文情感极性词典进行分析, 比如来源于台湾大学的NTUSD和知网的情感极性字典.但是本例中如果只依靠中文情感极性词典, 计算机就很难准确判断句子A所反映的真实情绪.因此, 事先要采用人工标注的方法来对一些带情绪的语句进行情感标注.通常, 人类的基本情绪可以划分为6种, 即快乐、愤怒、悲伤、恐惧、惊讶和嫉妒.为了正确识别情绪, 每一类情绪都要有对应的标注数据, 然后利用这些带情绪标注的数据集来训练情绪分类模型.情绪分类算法可以采用K最近邻(K-nearest neighbor, 简称KNN)、支持向量机(support vector machines, 简称SVM)、深度置信网络(deep belief network, 简称DBN)和长短期记忆网络(long short-term memory, 简称LSTM)等实现.一旦分类模型训练成功, 就能准确地识别句子A所表达的情绪.

5 数据标注质量评估本文按照数据标注对象, 将数据标注结果评估算法分为图像(含视频)、文本和语音这3类标注结果评估算法, 下面按照时间顺序对这3类评估算法进行简要概述.

5.1 图像标注质量评估算法目前, 比较常用的图像标注质量评估算法[63]有多数投票算法(majority voting, 简称MV)、期望最大化算法(expectation maximization, 简称EM)和RY算法.MV是由约翰逊提出的一种通用性强的质量控制算法.它将绝大多数用户选择的结果视为最终结果[64-68].MV算法的基本思想是:假设有m个图像标注任务(t1, …, tm), 每个任务ti对应一个二元分类, 任务管理员将这些任务分配给众包平台中的员工, 其中, W代表所有员工的集合.为了提高标注质量和标注的可靠性, 将需要标注的对象xi提供给N(N={w1, …, wN}≤W, wj∈W)个工人进行标注.每个工人wj对xi做出预测并创建一个标签

| $ {\hat y_i} = \left\{ {\begin{array}{*{20}{l}} {1,}&{\frac{1}{N}\sum\nolimits_{j = 1}^N {y_i^j} > \frac{1}{2}}\\ {random{\rm{ }}guess,}&{\frac{1}{N}\sum\nolimits_{j = 1}^N {y_i^j} = \frac{1}{2}}\\ {0,}&{\frac{1}{N}\sum\nolimits_{j = 1}^N {y_i^j} < \frac{1}{2}} \end{array}} \right. $ | (1) |

由于MV算法把大多数人认为正确的标签作为最终标签且简单易用, 所以常被其他众包质量评估算法当作基准算法.但是在现实生活中, 大多数人认为正确的并不总是正确.为了解决这个问题, Dawid等人[69]提出了EM算法.EM算法[70-72]需要构建出一次标注任务中标注者的标注错误率混淆矩阵, 并与实际观测标注结果进行比较, 二者比较结果的差异越大, 就代表标注的结果越差.RY算法[73, 74]是在MV算法和EM算法基础上的改进算法[75, 76].Raykar和Yu等人利用two-coin模型, 在公式(1)的基础上描述每个数据标注者的素质, 并估计了敏感性(specificity)、特异性(sensitivity)的概率, 通过对标注者的特异性和敏感性进行建模分析, 过滤垃圾标注者并提高标注者的质量.

上述3种算法中的MV算法和EM算法主要用于标注者质量未知的情况下.它们可以检测并剔除低质量的标注者, 检测到的低质量标注者越多, 则说明标注质量越差.

5.2 文本标注质量评估算法常用的文本标注质量评估算法有6种.

1) Papineni等人提出的BLEU(bilingual evaluation understudy)[77]算法是一种基于精确度的相似性度量方法.它根据分析待评估数据和参考数据中N元组(N-gram)共同出现的程度来衡量机器标注数据与人工标注数据的相似性(即机器标注数据的质量).共同出现的程度越高, 就代表文本标注的质量越好.

2) Yew提出的ROUGE(recall-oriented understudy for gisting evaluation)[78]算法是一种基于召回率的相似性度量方法.与BLEU类似, 它主要考察待评估标注的充分性和忠实性, 并通过计算N元组在参考数据和待评估数据的共现率来评估文本标注的质量.ROUGE算法一共有4种改进算法[79], 即ROUGE-N[80]、ROUGE-L[81]、ROUGE-W[82]和ROUGE-S[83].

3) Lavie等人提出的METEOR[84]算法是一种基于精确度和召回率的相似性度量方法, 与单纯基于精度的BLEU算法相比, 其结果和人工标注结果的相关性较高.METEOR算法解决了BLEU算法中的固有缺陷, 即同义词匹配问题以及ROUGE算法无法评估文本数据流畅度的缺陷.

4) Vedantam等人提出的CIDEr(consensus-based image description evaluation)算法[85]是一种用于评估图像描述(image caption或image description)的算法, 图像描述是指用一段描述性的文字说明图像中物体之间的关系.CIDEr算法将每个句子都看作“文档”, 将其表示成TF-IDF(term frequency-inverse document frequency)向量的形式, 通过对每个n元组进行(TF-IDF)权重计算, 比较模型生成的描述与人工描述之间的余弦相似度.如果余弦相似度越高, 则代表图像描述的质量越好.2017年, 研究者提出了改进的CIDEr-D[86]算法.它通过增加截断(clipping)和基于长度的高斯惩罚来解决CIDEr算法中对一个句子经过人工判断得分很低, 但在自动计算标准中得分很高的情况.

5) Anderson等人提出的SPICE(semantic propositional image caption evaluation)算法[87]也用于评估图像描述质量.它使用基于图的语义表示来编码标注数据中的对象、属性和关系.将待评价Caption和人工标注Caption用概率上下文无关文法依赖解析树[88]解析成语法依赖树, 然后用基于规则的方法把依赖解析树映射成场景图, 最后用F-score来评估两个场景图的相似性.分值越高, 则表示图像的描述质量越好.

6) Demartini等人提出的ZenCrowd算法[89, 90]使用二元组{good, bad}来建模众包标注者的可靠性(reliability).该算法只使用1个参数就解决了数据稀疏性造成的变量估计偏差过大问题[91].ZenCrowd算法计算每个众包标注者的可靠度以及使用可靠度来更新每个样本属于特定类别的概率, 标注者的可靠度越高, 标注质量就越好.

5.3 语音标注质量评估算法目前, 语音标注质量评估算法主要有词错误率(word error rate, 简称WER)算法[92]和句子错误率(sentence error rate, 简称SER)算法[93].词错误率[94]表示为了让识别出来的词序列和标准的词序列之间保持一致, 而需要进行替换、删除或者插入的某些词.WER的计算公式如下:

| $ WER = \left( {S + D + I} \right)/N = \left( {S + D + I} \right)/\left( {S + D + H} \right) $ | (2) |

其中, S为替换的字数, D为删除的字数, I为插入的字数, H为正确的字数, N为(替换+删除+正确)的字数.WER的值越低, 表示标注效果越好; 反之, 则表示标注效果越差.中文标注一般用字符错误率(character error rate, 简称CER)[95]来表示WER.目前, 主要用字符串编辑距离(levenshtein distance)来计算词错误率.

SER算法被用来识别句子中是否出现词识别错误, 其计算公式如下:

| $ SER = SEN/STN $ | (3) |

SEN(error number of sentence)是指句子识别错误的个数, 也就是说, 如果句子中出现一个词识别错误, 那么这个句子被认为识别错误, STN(total number of sentence)指句子总数.SER的值越高, 就代表语音标注的质量越差; 反之, 则表示语音标注的质量较好.最后, 表 4对比了上述各个标注质量评估算法的优缺点.

| Table 4 Comparison of evaluation algorithms for data annotation quality 表 4 各数据标注质量评估算法对比 |

6 数据标注发展趋势

随着人工智能的兴起, 深度学习、增强学习、机器学习等人工智能领域对数据标注的需求度越来越高, 数据标注的重要性也不断凸显.但是其在发展过程中也面临着一些挑战和问题, 具体内容如下所示.

● 挑战 1:不同的行业应用对数据标注的任务存在一定的差异性, 现有的标注任务还不够细化, 无法满足行业的新技术需求.

现有的标注任务主要分为5大类, 不过随着人工智能技术的普及, 一些行业对数据标注提出了更高的需求.例如智能安防是数据标注的一个典型应用行业, 常用的标注任务为图像标注中的人脸标注和行人标注.人脸标注可用于识别住户或来访者的身份, 行人标注用来统计一定区域里的人群数量, 并判断该区域是否出现过于拥挤的现象, 以避免出现踩踏事件.但是随着技术的进步, 居民对智能安防系统提出了更高的需求, 希望能从以往的被动防御走向主动预警.为此, 现有的标注任务已经不能满足这一需求, 需要出现更加专业和更加细化的标注内容.

● 挑战 2:尽管数据标注工具能够在一定程度上帮助标注员完成标注任务, 但是整体的标注效率仍然较为低下.

在图像标注工作中, 传统的人工标注方法是由标注员根据标注需求, 并借助相关工具在图片上完成诸如分类、画框、注释和标记等工作.比如在COCO+Stuff数据集中[96], 标记一个图像大约需要20min, 如果要标记整个数据集则需要约53 000h!数据标注需求的高速增长与标注效率的低效并存.

● 挑战 3:现有数据标注平台普遍采用众包模式来分配标注任务、造成标注结果的质量层次不齐, 影响算法模型的准确性.

人工智能应用对数据标注的质量要求非常高, 然而数据标注质量的参差不齐, 成为人工智能企业最为苦恼的事情.现阶段, 数据标注主要依靠人力来完成, 当标注员面临复杂的标注任务或者百万级的标注数据量时就会产生巨大的心理压力; 再加上数据标注工作本身的重复性高、标注时间紧迫以及缺少严格的质量审核流程, 就会造成标注任务的合格率低、标注不完备[97]、标注不及时等问题.这些问题影响了后续分析结果的准确性, 也会阻碍人工智能的发展过程[98].

● 挑战 4:基于众包模式的数据标注任务会造成用户数据缺乏安全性, 并面临隐私泄露的风险.

一些金融机构和政府部门格外关注外包标注数据的安全性, 但是一些互联网企业为了降低标注成本, 会将用户私人社交内容标注工作层层转包给其他国家的合同工.据路透社报道, Facebook将部分的数据标注工作外包给了印度公司WiPro, 该公司雇用了260多名工人, 按照5个类别对用户发布的私人帖子进行标注.鉴于Facebook之前在数据安全上的表现, 数据标注的外包行为引起了许多用户的担忧, 进而引发了用户对隐私信息泄露的忧虑

综上, 在新环境和新技术下, 数据标注的研究方向在于:

(1) 针对特定的行业需求, 研究如何细化本行业的标注任务;

(2) 开发人工标注+机器辅助标注并存的半自动化标注工具, 同时, 逐步提高机器标注的占比并减少人工标注的比例;

(3) 研究提高数据标注质量的技术和方法;

(4) 研究能够保证数据标注安全性和隐私性的技术和措施.

下面简要介绍各研究热点所涉及的相关理论和技术.

6.1 细化数据标注任务随着人工智能技术在一些行业的广泛应用, 这些行业原有的数据标注任务已经不再满足业务需求.以智能安防为例, 为了促进智能安防系统从传统的被动防御走向智能化的主动预警, 一些新的数据标注任务也应运而生.例如, 当一个神情紧张或者头戴面罩的小偷手握一根棍子准备翻越小区外墙企图实施盗窃行为时, 安防系统应该马上启动报警系统, 并及时向安防人员发出警告, 以保障住户的财产安全.实现异常情况预警的新标注任务, 包括表情标注、危险品标注和行为标注, 利用这些数据标注就能帮助安防系统识别紧张的表情、违法的面罩和违规的翻越行为以及可能的凶器——棍子.从技术角度来看, 新标注任务为异常行为的识别与建模提供了高质量的训练数据, 也有利于提高模型训练的准确性.因此, 针对特定的行业需求细化标注任务, 将是今后数据标注的一个发展趋势.

6.2 半自动化数据标注工具的研发随着AI技术的发展, 数据标注工具需要从只支持人工标注逐渐转化为人工标注+AI辅助标注的方法.其基本思路为:基于以往的标注, 可以通过AI模型对数据进行预处理, 然后由标注人员在此基础上做一些校正.以图像标注为例, 标注工具首先通过预训练的语义分割模型来处理图像, 并生成多个图像片段、分类标签及其置信度分数.置信度分数最高的片段用于对标签的初始化, 呈现给标注者.标注者可以从机器生成的多个候选标签中为当前片段选择合适的标签, 或者对机器未覆盖到的对象添加分割段.AI辅助标注技术的应用, 能够极大地降低人力成本并使标注速度大幅提升.目前, 已经有一些数据标注公司开发了相应的半自动化工具, 但是从标注比例来看, 机器标注占30%左右, 而人工标注占比达到70%左右.因此, 数据标注工具的发展趋势是开发以人工标注为主机器标注为辅的半自动化标注工具, 同时减少人工标注的比例, 并逐步提高机器标注的占比.

6.3 数据标注质量的改善为了改善数据标注的质量, 可以从以下3个层面开展相关研究.

● 方法 1.现有的众包工作大多集中在标签推理和激励机制的设计上[99, 100], 今后可以考虑利用自适应群体教学(即通过监督人群以教学的形式进行标注)来提高标注质量, 或者利用隐藏在“脏数据”[101, 102]中的有用信息以降低标注样品(构建机器学习算法模型时用到的人工标注数据)的比例, 它主要通过在脏数据上迭代地训练分类器, 并根据迭代期间的估计置信度移动聚类中心, 校正或删除样本.删除样本用来去除某些无法校正的低质量标注样品, 以达到在保证标注样品质量的情况下降低标注样品比例, 并实现对机器标注数据质量的提高.还可以利用模式识别结合一致性对标注数据进行评估, 并对标注人员排序, 以提高标注质量.

● 方法 2.针对被标注数据数量过大的情况, 可以采取自动识别和概率统计[103]相结合的方法提高对异常数据识别的效率, 这里主要是指基于SOM(self-organizing map)和SVM [104]的概率分布自动识别模式.SOM具有良好的矢量量化、数据融合和快速聚类能力, SVM在样本统计学习和倾向泛化方面表现良好.因此, 将它们结合为两层结构模式, 可以快速地识别异常数据的概率分布.同时, 通过关联数据将同一类标注对象进行整合并分类管理, 以便度量和监视大型标注团队的性能和质量.这样也能有效地提高数据标注的效率和质量.

● 方法 3.将学习人群模型[105]与交互式可视化相结合, 使专家能够快速访问最不确定的实例标签并去和工作人员进行验证, 以此来提高标注数据的质量.

此外, 如何将人类经验与学习规则充分结合以获取符合算法需求的高质量标注数据, 如何对标注人员进行规范培训, 如何制定标准的审核流程和控制标注质检的成本, 如何从非专家提供的大量噪声标签中推断出真正的标签等, 都是目前数据标注质量需要尽快解决的问题和研究的方向.

6.4 数据标注中的安全性与隐私保护为了保证数据标注平台中数据的安全性和隐私不被泄露, 可以考虑采取数据治理、数据分割、数据安全传输和区块链等技术.数据治理是指对数据采集、数据清洗、数据标注到数据交付生命周期的每个阶段进行识别、度量、监控、预警等一系列管理活动, 并通过改善和提高组织的管理水平确保数据在一个可控环境下使用.数据分割是指将涉密的待标注数据拆分成多个部分, 分别指派给没有关联的不同团队, 并且用数据接口的方式来传输数据, 避免客户的数据被直接打包并互相传送, 以便尽可能地提高安全性.待标注的数据在分发和交付时都会涉及到数据传输, 为了解决数据传输过程中存在的被盗、暴露和复制等安全性问题, 就需要设计和开发出一个安全的标注数据传输框架, 该框架需要提供数据加密、数据压缩和自动数据发送等功能[106].此外, 基于区块链的数据标注平台采用强加密算法以及分布式技术来保障数据的安全, 而且由于实现了社区自治, 标注人员直接与提供标注需求的企业对接并获得标注报酬, 避免标注任务的层层转包.平台一旦建设完成, 全网节点均是平台的维护成员.区块链技术的使用可以避免企业用户(上传数据的账户)恶意搜集数据, 也能防止个人用户(标注人员账户)批量搜集数据.

7 总结数据标注的准确性决定了人工智能算法的有效性, 因此, 数据标注不仅需要有系统的方法、技术和工具, 还需要有质量保障体系.本文概述了数据标注的发展, 指明了数据标注目前存在的标注效率低下、标注结果的质量层次不齐、数据标注缺乏安全性以及标注任务还不够细化等问题.此外, 本文还分析了数据标注未来的研究方向:(1)半自动化数据标注工具的研发; (2)数据标注质量的改善; (3)数据标注中的安全性与隐私保护; 以及(4)细化数据标注任务.

人工智能的终极目标是让“人工智能自主学习, 自主标记, 而不依赖人类对人工智能的标注与训练”[107].斯坦福大学已经通过一种编程方式生成训练数据的“弱监督”范式, 并开发了基于弱监督编程范式Snorkel的开源框架:编程训练数据(programming training data)[108].同时, 编程训练数据应用于多任务学习(MTL)场景, 解决了为一个或多个相关任务提供噪声标签的问题[109].亚利桑那州立大学的研究人员提出了一种基于机器教学的自适应交互型众包教学框架(JEDI)[110].它能够保证样本标注数据训练的有效性和多样性以及标注的质量.未来, 我们期待人工智能实现真正的“智能”, 能够反向作用于数据标注产业, 使得人工标注逐渐转变为半自动化标注, 进而向自动化标注迈进.

| [1] |

Xuan Z. Hidden "foxconn" labor-intensive industry in artificial intelligence industry. Internet Weekly, 2018, 675(21): 28-29(in Chinese with English abstract).

http://www.cnki.com.cn/Article/CJFDTotal-HLZK201821009.htm |

| [2] |

Bengio Y. Learning deep architectures for AI. Foundations and Trends in Machine Learning, 2009, 2(1): 1-127.

http://d.old.wanfangdata.com.cn/OAPaper/oai_arXiv.org_1206.5538 |

| [3] |

Corea F. How AI is changing the insurance landscape. In: Applied Artificial Intelligence: Where AI Can Be Used in Business. 2019. 5-10.

|

| [4] |

Alonso O. Challenges with label quality for supervised learning. Journal of Data and Information Quality, 2015, 6(1): 1-3.

http://cn.bing.com/academic/profile?id=df876aa2909fdc52b927787c7b5ecb17&encoded=0&v=paper_preview&mkt=zh-cn |

| [5] |

Brendel W, Rauber J, Bethge M, et al. Decision-based adversarial attacks: Reliable attacks against black-box machine learning models. In: Proc. of the Int'l Conf. on Learning Representations. 2018. 1-12.

|

| [6] |

IMAGENET. 2010. http://image-net.org/about-stats

|

| [7] |

Kornblith S, Shlens J, Le QV, et al. Do better ImageNet models transfer better? In: Proc. of the Computer Vision and Pattern Recognition. 2019. 2661-2671.

|

| [8] |

Zhu J, Kaplan R, Johnson J, et al. HiDDeN: Hiding data with deep networks. In: Proc. of the European Conf. on Computer Vision. 2018. 682-697.

|

| [9] |

Wang C, Blei DM, Li F, et al. Simultaneous image classification and annotation. In: Proc. of the Computer Vision and Pattern Recognition. 2009. 1903-1910.

|

| [10] |

Bearman A, Russakovsky O, Ferrari V, et al. What's the point: Semantic segmentation with point supervision. In: Proc. of the European Conf. on Computer Vision. 2016. 549-565.

|

| [11] |

Debattista J, Auer S, Lange C, et al. Luzzu-A methodology and framework for linked data quality assessment. Journal of Data and Information Quality, 2016, 8(1): 1-32.

http://www.wanfangdata.com.cn/details/detail.do?_type=perio&id=9a69d582833415c1438722603f186eb3 |

| [12] |

Reitan EH, Saib SH. Computer graphics in an automatic aircraft landing system. In: Proc. of the National Computer Conf. 1976. 689-700.

|

| [13] |

Kodali RK, Jain V, Bose S, et al. IoT based smart security and home automation system. In: Proc. of the Int'l Conf. on Computing Communication and Automation. 2016. 1286-1289.

|

| [14] |

Syed L, Jabeen S, Manimala S, et al. Data science algorithms and techniques for smart healthcare using IoT and big data analytics: Towards smarter algorithms. In: Proc. of the Smart Techniques for a Smarter Planet. 2019. 211-241.

|

| [15] |

Khan M, Wu X, Xu X, et al. Big data challenges and opportunities in the hype of Industry 4.0. In: Proc. of the IEEE ICC 2017. IEEE, 2017. https://ieeexplore.ieee.org/document/7996801

|

| [16] | |

| [17] |

Zhang Y, Lu Y. Research on the problems and strategies of rural E-commerce in the age of internet + agriculture. In: Proc. of the Semantics Knowledge and Grid. 2018. 257-260.

|

| [18] |

Christen P, Gayler RW, Tran K, et al. Automatic discovery of abnormal values in large textual databases. Journal of Data and Information Quality, 2016, 7(1): 1-31.

http://cn.bing.com/academic/profile?id=0b0df87c1029b8490ddeb79cccfd4d1e&encoded=0&v=paper_preview&mkt=zh-cn |

| [19] |

Sivarajah U, Kamal MM, Irani Z, et al. Critical analysis of big data challenges and analytical methods. Journal of Business Research, 2017, 70: 263-286.

[doi:10.1016/j.jbusres.2016.08.001] |

| [20] |

Guo XM, Ma LL, Su K, et al. Research on automatic evaluation method of metadata quality of data repositories based on sematic annotation. Computer Applications and Software, 2018, 35(6): 29-33, 88(in Chinese with English abstract).

http://d.old.wanfangdata.com.cn/Periodical/jsjyyyrj201806004 |

| [21] |

Khashabi D, Khot T, Sabharwal A, Clark P, Etzioni O, Roth D. Question answering via integer programming over semi-structured knowledge. In: Proc. of the Int'l Joint Conf. on Artificial Intelligence. 2016. 1145-1152.

|

| [22] |

Ling H, Gao J, Kar A, et al. Fast interactive object annotation with Curve-GCN. Computer Vision and Pattern Recognition, 2019, 1: 5257-5266.

http://cn.bing.com/academic/profile?id=172728d93166d01631d6b93c1bfa6c9e&encoded=0&v=paper_preview&mkt=zh-cn |

| [23] |

Barbosa L, Carvalho BW, Zadrozny B, et al. Pooling hybrid representations for Web structured data annotation. arXiv: 1610. 00493, 2016.

|

| [24] |

Jing K. Review of evaluation of social tagging system. Jiangsu Science & Technology Information, 2018, 35(11): 8-10(in Chinese with English abstract).

[doi:10.3969/j.issn.1004-7530.2018.11.003] |

| [25] |

Zhang L, Wang T, Liu Y, et al. A semi-structured information semantic annotation method for Web pages. Neural Computing and Applications, 2019(5): 1-11.

http://cn.bing.com/academic/profile?id=fd576fccab4ea56363b589a00f06fb74&encoded=0&v=paper_preview&mkt=zh-cn |

| [26] |

Cai L, Liang Y, Zhu YY, et al. History and development tendency of data quality. Computer Science, 2018, 45(4): 1-10(in Chinese with English abstract).

http://d.old.wanfangdata.com.cn/Periodical/jsjkx201804001 |

| [27] |

Egorow O, Lotz A, Siegert I, et al. Accelerating manual annotation of filled pauses by automatic pre-selection. In: Proc. of the Int'l Conf. on Companion Technology. 2018. 263-286.

|

| [28] |

Zheng G, Mukherjee S, Dong XL, et al. OpenTag: Open attribute value extraction from product profiles. In: Proc. of the Knowledge Discovery and Data Mining. 2018. 1049-1058.

|

| [29] |

Barthelmess P, Kaiser EC, Huang X, et al. Collaborative multimodal photo annotation over digital paper. In: Proc. of the Int'l Conf. on Multimodal Interfaces. 2006. 4-11.

|

| [30] |

Zhang B, Hao J, Ma G, et al. Automatic image annotation based on semi-paired probabilistic canonical correlation analysis. Ruan Jian Xue Bao/Journal of Software, 2017, 28(2): 292-309(in Chinese with English abstract).

[doi:10.13328/j.cnki.jos.005047] |

| [31] |

Vielhauer C, Schott M, Kratzer C, et al. Nested object watermarking:Transparency and capacity evaluation. Electronic Imaging, 2008, 6819: 1-18.

http://d.old.wanfangdata.com.cn/NSTLHY/NSTL_HYCC024895408/ |

| [32] |

Luo L, Yang Z, Yang P, et al. An attention-based BiLSTM-CRF approach to document-level chemical named entity recognition. Bioinformatics, 2018, 34(8): 1381-1388.

[doi:10.1093/bioinformatics/btx761] |

| [33] |

Pearson J, Robinson S, Jones M, et al. PaperChains: Dynamic sketch+voice annotations. In: Proc. of the Conf. on Computer Supported Cooperative Work. 2015. 383-392.

|

| [34] |

Ceolin D, Groth PT, Maccatrozzo V, et al. Combining user reputation and provenance analysis for trust assessment. Journal of Data and Information Quality, 2016, 7(1): 1-28.

http://cn.bing.com/academic/profile?id=3cffc08b5b0eb86e6493fb44ad35f8fd&encoded=0&v=paper_preview&mkt=zh-cn |

| [35] |

Levinson J, Askeland J, Becker J, et al. Towards fully autonomous driving: Systems and algorithms. In: Proc. of the 2011 IEEE Intelligent Vehicles Symp. 2011. 163-168.

|

| [36] |

Hillier LW, Graves T, Fulton RS, et al. Generation and annotation of the DNA sequences of human chromosomes 2 and 4. Nature, 2005, 434(7034): 724-731.

[doi:10.1038/nature03466] |

| [37] |

Gambhir M, Gupta V. Recent automatic text summarization techniques:A survey. Artificial Intelligence Review, 2017, 47(1): 1-66.

http://cn.bing.com/academic/profile?id=4d36076837c961a447b99edd4f90d046&encoded=0&v=paper_preview&mkt=zh-cn |

| [38] |

Liu C, Su T, Yu L, et al. Self-correction method for automatic data annotation. In: Proc. of the Asian Conf. on Pattern Recognition. 2017. 911-916.

|

| [39] |

Uijlings JR, Konyushkova K, Lampert CH, et al. Learning intelligent dialogs for bounding box annotation. In: Proc. of the Computer Vision and Pattern Recognition. 2018. 9175-9184.

|

| [40] |

Wang C. Image annotation refinement using random walk with restarts. In: Proc. of the ACM Multimedia. 2016. 647-650.

|

| [41] |

Parmar BR, Jarrett TR, Burgon NS, et al. Comparison of left atrial area marked ablated in electroanatomical maps with scar in MRI. Journal of Cardiovascular Electrophysiology, 2014, 25(5): 457-463.

[doi:10.1111/jce.12357] |

| [42] |

Perrott DR, Marlborough K. Minimum audible movement angle:Marking the end points of the path traveled by a moving sound source. The Journal of the Acoustical Society of America, 1989, 85(4): 1773-1775.

[doi:10.1121/1.397968] |

| [43] |

Best-Rowden L, Jain AK. Longitudinal study of automatic face recognition. IEEE Trans. on Pattern Analysis and Machine Intelligence, 2017, 40(1): 148-162.

http://www.wanfangdata.com.cn/details/detail.do?_type=perio&id=CC0214897605 |

| [44] |

Müller RH, Clegg DL. Automatic paper chromatography. Annals of the New York Academy of Sciences, 1949, 53(5): 1108-1118.

http://d.old.wanfangdata.com.cn/Periodical/fxyq201406019 |

| [45] |

Sikos LF. RDF-powered semantic video annotation tools with concept mapping to linked data for next-generation video indexing:A comprehensive review. Multimedia Tools and Applications, 2017, 76(12): 14437-14460.

[doi:10.1007/s11042-016-3705-7] |

| [46] |

Willis CG, Law E, Williams AC, et al. CrowdCurio:An online crowdsourcing platform to facilitate climate change studies using herbarium specimens. New Phytologist, 2017, 215(1): 479-488.

[doi:10.1111/nph.14535] |

| [47] |

Dolmaya JM. Analyzing the crowdsourcing model and its impact on public perceptions of translation. Translator, 2012, 18(2): 167-191.

[doi:10.1080/13556509.2012.10799507] |

| [48] |

Aktas A, Alexa C, Andreev V, et al. Measurement of inclusive jet production in deep-inelastic scattering at high and determination of the strong coupling. Physics Letters B, 2007, 653: 134-144.

[doi:10.1016/j.physletb.2007.07.050] |

| [49] |

Chen K, Chang C, Wu C, et al. Quadrant of euphoria:A crowdsourcing platform for QoE assessment. IEEE Network, 2010, 24(2): 28-35.

http://cn.bing.com/academic/profile?id=248ff084b45b53314d840aab6a13c8e5&encoded=0&v=paper_preview&mkt=zh-cn |

| [50] |

Kohler T. Crowdsourcing-based business models:How to create and capture value. California Management Review, 2015, 57(4): 63-84.

[doi:10.1525/cmr.2015.57.4.63] |

| [51] |

Chalam KV, Jain P, Shah VA, et al. Evaluation of Web-based annotation of ophthalmic images for multicentric clinical trials. Indian Journal of Ophthalmology, 2006, 54(2): 479-488.

http://d.old.wanfangdata.com.cn/OAPaper/oai_doaj-articles_a9da617a11c60676749efeabcd117bad |

| [52] |

Tang J, Li H, Qi G, et al. Image annotation by graph-based inference with integrated multiple/single instance representations. IEEE Trans. on Multimedia, 2010, 12(2): 131-141.

[doi:10.1109/TMM.2009.2037373] |

| [53] |

Zhou H, Gao B, Wu J, et al. Adaptive feeding:Achieving fast and accurate detections by adaptively combining object detectors. Computer Vision and Pattern Recognition, 2017, 1: 3523-3533.

http://cn.bing.com/academic/profile?id=14a0e93e605509ff19831984b1f95370&encoded=0&v=paper_preview&mkt=zh-cn |

| [54] |

Jongejan B. Automatic annotation of head velocity and acceleration in Anvil. In: Proc. of the Language Resources and Evaluation. 2012. 201-208.

|

| [55] |

Tulasi RL, Rao MS, Ankita K, et al. Ontology-based automatic annotation: An approach for efficient retrieval of semantic results of Web documents. In: Proc. of the 1st Int'l Conf. on Computational Intelligence and Informatics. 2017. 57-63.

|

| [56] |

Xie C, Mao X, Huang J, et al. KOBAS 2.0: A Web server for annotation and identification of enriched pathways and diseases. In: Proc. of the Nucleic Acids Research. 2011. 316-322.

|

| [57] |

Liu P, Zhang Y. Data Annotation Engineering. Beijing: Tsinghua University Press, 2019.

|

| [58] |

Berriel RF, Rossi FS, De Souza AF, et al. Automatic large-scale data acquisition via crowdsourcing for crosswalk classification: A deep learning approach. In: Proc. of the Computers and Graphics. 2017. 32-42.

|

| [59] |

Boselli R, Cesarini M, Mercorio F, et al. An AI planning system for data cleaning. In: Proc. of the European Conf. on Machine Learning. 2017. 349-353.

|

| [60] |

Li R, Lin Z, Lin HL, et al. Text emotion analysis:A survey. Journal of Computer Research and Development, 2018, 55(1): 30-52(in Chinese with English abstract).

http://d.old.wanfangdata.com.cn/Periodical/jsjyjyfz201801003 |

| [61] |

Lei LY. Research on fine-grained sentiment analysis base on Chinese[MS. Thesis]. Hengyang: University of South China, 2014(in Chinese with English abstract).

|

| [62] |

Cai L, Pan J, Wei BL, et al. Visualization analysis for spatio-temporal pattern of hotspots and sentiment change towards microblog check-in data. Miniature Microcomputer System, 2018, 39(9): 1889-1894(in Chinese with English abstract).

[doi:10.3969/j.issn.1000-1220.2018.09.001] |

| [63] |

Cao W. Research of the algorithm of region-value annotation in crowdsouring[MS. Thesis]. Nanjing: Nanjing University of Finance and Economics, 2017(in Chinese with English abstract).

|

| [64] |

Gennari R, Tonelli S, Vittorini P, et al. Challenges in quality of temporal data-Starting with gold standards. Journal of Data and Information Quality, 2015, 6(2): 2-3.

http://www.wanfangdata.com.cn/details/detail.do?_type=perio&id=a5ab35ab803e661e235ab1f50cb884a5 |

| [65] |

Xu TZ, Xu ZY. Combination method of Fisher theory and the majority of voting for data fusion. Science and Technology Information, 2009, 27: 445(in Chinese with English abstract).

http://d.old.wanfangdata.com.cn/Periodical/kjxx200927386 |

| [66] |

Wang Y, Rao Y, Zhan X, et al. Sentiment and emotion classification over noisy labels. In: Proc. of the Knowledge Based Systems. 2016. 207-216.

|

| [67] |

Snow R, O'Connor B, Jurafsky D, et al. Cheap and fast-But is it good? Evaluating non-expert annotations for natural language tasks. In: Proc. of the Conf. on Empirical Methods in Natural Language Processing. 2008. 254-263.

|

| [68] |

Sorokin A, Forsyth D. Utility data annotation with Amazon Mechanical Turk. In: Proc. of the 2008 IEEE Computer Society Conf. on Computer Vision and Pattern Recognition Workshop on Internet Vision, 2008. 1-8.

|

| [69] |

Gupta R. Modeling multiple time series annotations as noisy distortions of the ground truth:An expectation-Maximization approach. IEEE Trans. on Affective Computing, 2018, 9(1): 76-89.

[doi:10.1109/TAFFC.2016.2592918] |

| [70] |

Zeng J, Liu Z, Cao X, et al. Fast online EM for big topic modeling. IEEE Trans. on Knowledge and Data Engineering, 2016, 28(3): 675-688.

[doi:10.1109/TKDE.2015.2492565] |

| [71] |

Wang W, Zhou Z. Crowdsourcing label quality:A theoretical analysis. Science in China Series F:Information Sciences, 2015, 58(11): 1-12.

http://cn.bing.com/academic/profile?id=55f22a918dd3c3aeca85714f56f3f347&encoded=0&v=paper_preview&mkt=zh-cn |

| [72] |

Dawid AP, Skene AM. Maximum likelihood estimation of observer error-rates using the EM algorithm. Journal of the Royal Statistical Society, 1979, 28(1): 20-28.

http://cn.bing.com/academic/profile?id=96fc567876c2e2e1392e99844edbb8e9&encoded=0&v=paper_preview&mkt=zh-cn |

| [73] |

Raykar VC, Yu S, Zhao LH, et al. Supervised learning from multiple experts: Whom to trust when everyone lies a bit. In: Proc. of the 26th Int'l Conf. on Machine Learning. Quebec, 2009. 889-896.

|

| [74] |

Raykar VC, Yu S, Zhao LH, et al. Learning from crowds. Journal of Machine Learning Research, 2010, 11(2): 1297-1322.

http://d.old.wanfangdata.com.cn/NSTLQK/NSTL_QKJJ0232655774/ |

| [75] |

Yu H, Chen Y. Clustering ensemble method using three-way decisions based on spark. Journal of Zhengzhou University (Natura Science Edition), 2018, 50(1): 23-29(in Chinese with English abstract).

http://www.wanfangdata.com.cn/details/detail.do?_type=perio&id=zzdxxb201801004 |

| [76] |

Vogel T, Heise A, Draisbach U, et al. Reach for gold:An annealing standard to evaluate duplicate detection results. Journal of Data and Information Quality, 2014, 5(1): 1-25.

http://cn.bing.com/academic/profile?id=b8539901da6fbe2318f04ecafe067ebf&encoded=0&v=paper_preview&mkt=zh-cn |

| [77] |

Papineni K, Roukos S, Ward T, et al. Bleu: A method for automatic evaluation of machine translation. In: Proc. of the Meeting of the Association for Computational Linguistics. 2002. 311-318.

|

| [78] |

Lavie A, Agarwal A. METEOR: An automatic metric for MT evaluation with high levels of correlation with human judgments. In: Proc. of the Workshop on Statistical Machine Translation. 2007. 228-231.

|

| [79] |

Jiang YH, Ding L, Li JE, et al. Abstractive summarization model considering hybrid lexical features. Journal of Hebei University of Science and Technology, 2019, 40(2): 152-158(in Chinese with English abstract).

http://d.old.wanfangdata.com.cn/Periodical/hbkjdx201902009 |

| [80] |

Jin F, Huang M, Lu Z, et al. Towards automatic generation of gene summary. In: Proc. of the North American Chapter of the Association for Computational Linguistics. 2009. 97-105.

|

| [81] |

Plaza L. A semantic graph-based approach to biomedical summarization. Artificial Intelligence in Medicine, 2011, 53(1): 1-14.

http://d.old.wanfangdata.com.cn/OAPaper/oai_doaj-articles_c5cea2af679816283d62d34b82e61af2 |

| [82] |

Campr M, Ježek K. Comparing semantic models for evaluating automatic document summarization. In: Proc. of the Text Speech and Dialogue. 2015. 252-260.

|

| [83] |

Kang SZ, Hong MA, Huang RY. An opinion and MRW based sentiment summarization framework. Acta Electronica Sinica, 2017, 45(12): 3005-3011.

http://www.en.cnki.com.cn/Article_en/CJFDTotal-DZXU201712024.htm |

| [84] |

Lin C. ROUGE: A package for automatic evaluation of summaries. In: Proc. of the Meeting of the Association for Computational Linguistics. 2004. 74-81.

|

| [85] |

Vedantam R, Zitnick CL, Parikh D, et al. CIDEr: Consensus-based image description evaluation. In: Proc. of the Computer Vision and Pattern Recognition. 2015. 4566-4575.

|

| [86] |

Chen T, Liao Y, Chuang C, et al. Show, adapt and tell: Adversarial training of cross-domain image captioner. arXiv: 1705.00930, 2017.

|

| [87] |

Anderson P, Fernando B, Johnson M, et al. SPICE: Semantic propositional image caption evaluation. In: Proc. of the European Conf. on Computer Vision. 2016. 382-398.

|

| [88] |

Cui Y, Yang G, Veit A, et al. Learning to evaluate image captioning. In: Proc. of the Computer Vision and Pattern Recognition. 2018. 5804-5812.

|

| [89] |

Demartini G, Difallah DE, Cudremauroux P. ZenCrowd: Leveraging probabilistic reasoning and crowdsourcing techniques for large-scale entity linking. In: Proc. of the Int'l Conf. on World Wide Web. ACM, 2012. 469-478.

|

| [90] |

Zhang J, Sheng VS, Wu J, et al. Multi-class ground truth inference in crowdsourcing with clustering. IEEE Trans. on Knowledge and Data Engineering, 2016, 28(4): 1080-1085.

[doi:10.1109/TKDE.2015.2504974] |

| [91] |

Ruckhaus E, Vidal M, Castillo S, et al. Analyzing linked data quality with LiQuate. In: Proc. of the European Semantic Web Conf. 2014. 488-493.

|

| [92] |

Ruiz N, Federico M. Phonetically-oriented word error alignment for speech recognition error analysis in speech translation. In: Proc. of the Automatic Speech Recognition and Understanding. 2016. 296-302.

|

| [93] |

Augello A, Cuzzocrea A, Pilato G, et al. An innovative similarity measure for sentence plagiarism detection. In: Proc. of the Int'l Conf. on Computational Science and Its Applications. 2016. 552-566.

|

| [94] |

Spiccia C, Augello A, Pilato G, et al. Semantic word error rate for sentence similarity. In: Proc. of the IEEE Int'l Conf. on Semantic Computing. 2016. 266-269.

|

| [95] |

Escudero JP, Novoa J, Mahu R, et al. An improved DNN-based spectral feature mapping that removes noise and reverberation for robust automatic speech recognition. arXiv: 1803.09016, 2018.

|

| [96] |

Andriluka M, Uijlings JR, Ferrari V, et al. Fluid annotation: A human-machine collaboration interface for full image annotation. In: Proc. of the ACM Multimedia. 2018. 1957-1966.

|

| [97] |

Yang B, Kaul M, Jensen CS. Using incomplete information for complete weight annotation of road networks. IEEE Trans. on Knowledge and Data Engineering, 2014, 26(5): 1267-1279.

[doi:10.1109/TKDE.2013.89] |

| [98] |

Marcheggiani D, Sebastiani F. On the effects of low-quality training data on information extraction from clinical reports. Journal of Data and Information Quality, 2017, 9(1): 1-25.

http://cn.bing.com/academic/profile?id=88c52a05d1b39d40c5cceb91840cda62&encoded=0&v=paper_preview&mkt=zh-cn |

| [99] |

Maccartney B, Galley M, Manning CD, et al. A phrase-based alignment model for natural language inference. In: Proc. of the Empirical Methods in Natural Language Processing. 2008. 802-811.

|

| [100] |

Gururangan S, Swayamdipta S, Levy O, et al. Annotation artifacts in natural language inference data. In: Proc. of the NAACLHLT. 2018. 107-112.

|

| [101] |

Wang Z, Xu Y, Suo B, et al. A provenance storage method based on parallel database. In: Proc. of the Int'l Conf. on Information Science and Control Engineering. 2015. 63-66.

|

| [102] |

Liu C, Su T, Yu L, et al. Self-correction method for automatic data annotation. In: Proc. of the Asian Conf. on Pattern Recognition. 2017. 911-916.

|

| [103] |

Skala W, Wohlschlager T, Senn S, et al. MoFi:A software tool for annotating glycoprotein mass spectra by integrating hybrid data from the intact protein and glycopeptide level. Analytical Chemistry, 2018, 90(9): 5728-5736.

[doi:10.1021/acs.analchem.8b00019] |

| [104] |

Zhu J, Zhang H, Guo J, et al. Data distributions automatic identification based on SOM and support vector machines. In: Proc. of the Int'l Conf. on Machine Learning and Cybernetics. 2002. 340-344.

|

| [105] |

Wang J. A review of China's statistical data quality research. In: Proc. of the 20162nd Fortune Today Forum. 2016. 393-394(in Chinese with English abstract).

|

| [106] |

Yang Y, He H, Wang D, et al. A framework to data delivery security for big data annotation delivery system. In: Proc. of the Mobile Adhoc and Sensor Systems. 2018. 532-536.

|

| [107] |

Verhulst SG. Where and when AI and CI meet:Exploring the intersection of artificial and collective intelligence towards the goal of innovating how we govern. AI and Society, 2018, 33(2): 293-297.

[doi:10.1007/s00146-018-0830-z] |

| [108] |

Ratner A, Varma P, Hancock B, et al. Weak supervision: A new programming paradigm for machine learning. In: Proc. of the Stanford AI Lab Blog. 2019.

|

| [109] |

Shetty R, Fritz M, Schiele B. Adversarial scene editing: Automatic object removal from weak supervision. arXiv: 1806.01911, 2018.

|

| [110] |

Zhou Y, Nelakurthi AR, He J. Unlearn what you have learned: Adaptive crowd teaching with exponentially decayed memory learners. arXiv: 1804.06481, 2018.

|

| [1] |

轩中. 人工智能行业中隐藏的"富士康"式劳动密集型产业. 互联网周刊, 2018, 675(21): 28-29.

http://www.cnki.com.cn/Article/CJFDTotal-HLZK201821009.htm |

| [20] |

郭晓明, 马良荔, 苏凯, 等. 基于语义标注的数据资源库元数据质量自动评估方法研究. 计算机应用与软件, 2018, 35(6): 29-33, 88.

http://d.old.wanfangdata.com.cn/Periodical/jsjyyyrj201806004 |

| [24] |

敬凯. 社会化标注系统评价研究述评. 江苏科技信息, 2018, 35(11): 8-10.

[doi:10.3969/j.issn.1004-7530.2018.11.003] |

| [26] |

蔡莉, 梁宇, 朱扬勇, 等. 数据质量的历史沿革和发展趋势. 计算机科学, 2018, 45(4): 1-10.

http://d.old.wanfangdata.com.cn/Periodical/jsjkx201804001 |

| [30] |

张博, 郝杰, 马刚, 等. 基于弱匹配概率典型相关性分析的图像自动标注. 软件学报, 2017, 28(2): 292-309.

[doi:10.13328/j.cnki.jos.005047] |

| [57] |

刘鹏, 张燕. 数据标注工程. 北京: 清华大学出版社, 2019.

|

| [60] |

李然, 林政, 林海伦, 等. 文本情绪分析综述. 计算机研究与发展, 2018, 55(1): 30-52.

http://d.old.wanfangdata.com.cn/Periodical/jsjyjyfz201801003 |

| [61] |

雷龙艳.中文微博细粒度情绪识别研究[硕士学位论文].衡阳: 南华大学, 2014.

|

| [62] |

蔡莉, 潘俊, 魏宝乐, 等. 签到数据的热点区域时空模式与情感变化的可视化分析. 小型微型计算机系统, 2018, 39(9): 1889-1894.

[doi:10.3969/j.issn.1000-1220.2018.09.001] |

| [63] |

曹伟.众包域值标注算法研究[硕士学位论文].南京: 南京财经大学, 2017.

|

| [65] |

徐太征, 徐中宇. Fisher理论和多数投票法相结合的数据融合算法. 科技信息, 2009, 27: 445, 488.

http://d.old.wanfangdata.com.cn/Periodical/kjxx200927386 |

| [75] |

于洪, 陈云. 基于Spark的3支聚类集成方法. 郑州大学学报(理学版), 2018, 50(1): 20-26.

http://www.wanfangdata.com.cn/details/detail.do?_type=perio&id=zzdxxb201801004 |

| [79] |

江跃华, 丁磊, 李娇娥, 等. 融合词汇特征的生成式摘要模型. 河北科技大学学报, 2019, 40(2): 152-158.

http://d.old.wanfangdata.com.cn/Periodical/hbkjdx201902009 |

| [105] |

王晶.中国统计数据质量研究综述.见: 2016年第2届今日财富论坛.2016.393-394.

|

2020, Vol. 31

2020, Vol. 31