2. 江苏省电子商务重点实验室(南京财经大学), 江苏 南京 210023

2. Jiangsu Provincial Key Laboratory of Electronic Business(Nanjing University of Finance and Economics), Nanjing 210023, China

近些年来, 随着数字信息技术的快速发展、图像数据库规模不断扩大, 为有效管理和利用海量的图像数据, 基于内容的图像检索(CBIR)[1]技术在计算机视觉领域得到了广泛的研究与应用.通过计算机软件对图像的特征进行自动识别和提取, 以用于图像的检索和分类[2].由于形状是大多数物体固有的视觉属性, 是人类视觉系统对物体进行识别和分类的重要依据, 因此, 形状分析成为CBIR研究领域十分活跃的分支, 并且已经在文本分析、神经科学、农业、生物医药、工程技术等领域产生了大量的应用[3, 4].

在图像处理中, 对于从场景中分割出来的目标形状, 我们可以将其表示为分布在目标区域的所有像素点的集合, 如果可以将其简化成一条仅由边界像素点构成的曲线, 而且形状信息能够完全保持(该闭合曲线所围成的区域即为目标区域), 我们称该类形状为轮廓线形状.如果形状存在不联通的目标区域, 或区域是联通的, 但目标区域内有孔洞, 使其具有复杂的内部结构, 则该类形状为区域形状.我们在图 1中给出了形状分类框图以及两类形状的示例图像和对应的边界图, 以便于观察这两类形状的特点, 其中, 轮廓线形状和区域形状的示例分别取自MPEG-7 CE-1轮廓线形状图像库和MPEG-7 CE-2区域形状图像库.

|

Fig. 1 Classification of shapes and its example images and edge maps 图 1 形状的分类及其示例图像和边界图 |

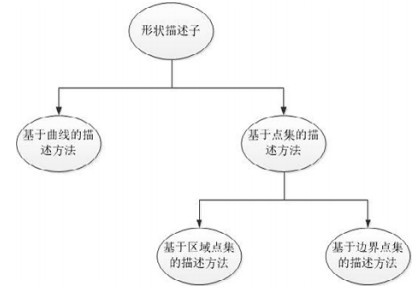

形状描述是形状分析的核心步骤, 旨在提取目标形状的有效特征, 以用于后续目标形状的匹配、检索和分类等形状分析任务[4].现有的形状描述方法可分为基于曲线的描述方法和基于点集的描述方法两大类.

基于曲线的描述方法根据目标边界像素点的邻接关系进行轮廓跟踪, 从而得到一条轮廓线曲线, 即轮廓的有序点集.这类方法近些年得到广泛和深入的研究, 研究成果[5-23]如傅里叶描述子[13, 14]和曲率尺度空间[15, 16], 二者是经典的轮廓线形状描述子, 后者被MPEG-7推荐为标准的轮廓线形状描述子, 其在MPEG-7 CE-1形状测试集上获得了75.44%的检索准确率[15].又如多尺度凹凸性[5]、内部距离[6]、三角形面积[7]、轮廓柔韧性[8]、形状树[17]、分段多项式描述子[18]、局部仿射不变描述子[19]以及一些其他轮廓线描述子[9-12, 20-23].该类方法可借助曲线分析的数学工具, 如傅里叶变换、小波变换、微分几何等, 产生许多具有强辨识力的形状描述子, 还可以利用深度学习的方法对特征进行有效的选取[24, 25].而在形状匹配阶段, 可以借助像素点的有序信息进行轮廓线的精确匹配, 如采用动态规划的匹配方法, 又如利用距离度量学习的方法进行形状相似度的度量[26].该类方法形式优美, 性能优越, 虽然这些方法在MPEG-7 CE-1轮廓线形状测试集上报告的检索精确率大都超过了85%, 但这些方法是专门为轮廓线形状设计的, 需要把目标形状的轮廓表示为一条曲线才能进行特征抽取, 因而只能处理图 1中的轮廓线形状.但对于图 1中的区域形状, 由于其轮廓不能用一条曲线来进行表示, 该类方法则无能为力.综上, 我们可以看出基于曲线的描述方法因对目标形状轮廓的提取质量有着严重的依赖性, 不能处理具有复杂内部结构的区域形状, 因此具有很大的局限性, 不能用于一般的形状识别任务.

基于点集的方法是另一类形状描述方法, 该类方法将目标形状区域的像素点看成一般的点集, 抽取点集的几何特性, 产生形状描述子.该类方法又可进一步地分为基于区域点集的描述方法和基于边界点集的描述方法:前者在抽取形状的特征时, 考虑目标形状区域的所有像素点, 即将所有的目标像素点看成一个点集; 而后者则仅考虑目标形状的边界像素点, 将边界像素点构成一个点集来进行特征抽取.我们在图 2中给出了形状描述方法的分类框图.由基于点集的形状描述机制可知, 基于区域点集的描述方法和基于边界点集的描述方法都能够描述轮廓线形状和区域形状.

|

Fig. 2 Classification of shape decription methods 图 2 形状描述方法的分类 |

人类的视觉系统对目标的边界信息非常敏感.从图 1中形状的边界图可以看出, 无论是轮廓线形状还是区域形状, 在移去目标区域内的所有像素点, 仅保留边界像素点的情况下, 人的视觉系统仍然能对目标形状进行准确辨识.因此, 目标形状的边界像素点为我们抽取具有强辨识力的形状特征提供了重要的线索.相较于基于曲线的描述方法, 基于边界点集的描述方法克服了前者仅能处理轮廓线形状的局限性, 能够一般地处理两类目标形状, 且由于不需要对边界点进行序化操作, 从而避免了因序化操作所带来的不稳定性.而相较于基于区域点集的描述方法, 基于边界点集的描述方法由于仅需处理边界像素点, 因此降低了点集的基数, 从而具有非常高的计算效率; 且其直接从边界提取特征, 使得描述子更具辨识能力.因此, 本文着眼于基于边界点集的形状描述方法.其主要贡献在于:提出了一种目标边界的分层描述模型, 通过对目标边界从多个方向的分层度量, 多尺度地抽取了目标形状几何特征, 无论是在标准的MPEG-7 CE-2区域形状测试集上, 还是在MPEG-7 CE-1轮廓线形状测试集上, 该方法都以较低的计算成本, 取得了比同类方法(基于点集的描述方法)更高的形状检索精确率.

1 相关工作本文提出的是一种新的基于边界点集的形状描述方法, 所以, 与本文联系最紧密的工作是近年来一些基于点集的形状描述方法.本节中, 我们对一些常见的基于点集的方法按基于区域点集和基于边界点集的分类展开综述.

常用的基于区域点集的形状描述方法有几何不变矩[27]、Zernike矩(Zernike moments, 简称ZM)[28]、伪Zernike矩[29]等各种基于矩的形状描述方法和通用傅里叶描述子(generic Fourier descriptor, 简称GFD)[30]等基于傅里叶变换的形状描述方法.在众多基于矩的形状描述方法中, Zernike矩[28]是一种经典的基于区域点集的形状描述方法.它将图像投影到一组定义在单位圆上的基于Zernike多项式的正交化函数, 矩的大小用以生成对图像进行描述的特征向量.Zernike矩能够很容易地构造图像的任意高阶矩, 并能够使用较少的矩来重建图像.虽然其计算比较复杂, 但是Zernike矩在图像旋转和噪声敏感度方面具有较大的优越性.由于Zernike矩具有图像旋转不变性和较低的噪声敏感度, 且可以构造任意高阶矩, 所以被广泛地应用于模式识别等领域中, MPEG-7标准中已将Zernike矩列为一种标准的区域描述符[31].基于Zernike矩, 文献[32]提出一种Zernike矩边缘梯度方法(Zernike moments & edge gradient, 简称ZMEG)用于商标图像检索, 这种方法将Zernike矩作为目标形状的全局特征, 提取形状的边缘梯度共生矩阵作为局部特征, 结合全局特征和局部特征对形状进行描述.文献[30]提出一种通用傅里叶描述子, 该方法首先对图像进行预处理, 将原始图像变换为极坐标图像, 再对其进行二维傅里叶变换, 用其变换系数的模作为描述子.该方法满足对目标形状的旋转、缩放和平移的不变性, 适合于一般的形状图像检索应用.近年来, Yang等人[33]提出一种自适应分层质心的算法, 这种方法递归地对形状区域进行分割, 通过若干次分割, 将形状区域分割成越来越小的区块, 每一次递归, 计算当前的形状区块的质心, 根据得到的质心, 将当前区块分割成4个更小的区块, 将每次递归产生的区块质心坐标构成的集合, 作为描述形状的特征向量.基于这种对图像递归地进行分块的技术, Sidiropoulos等人[34]提出了一种自适应分层密度直方图(adaptive hierarchical density histogram, 简称AHDH)的方法, 该方法用每一个形状区块的密度特征代替质心坐标来产生特征向量, 以此来表示形状区块像素点的分布特性.这两种方法在对形状进行分割时, 分割的方向依赖于目标形状所处的坐标系统, 因此不满足旋转不变性.此外, 随着递归次数的增加, 区块数量会呈指数级增长, 导致计算的复杂度很高, 难以满足实时性需求.

形状上下文(shape contexts, 简称SC)[35]是经典的基于边界点集的形状分析方法, 该方法将目标形状的边界像素点重新采样成指定个数的点集(一般100个~300个点), 将这个点集中的每一个点分别作为参考点, 通过在该点放置一个极坐标栅格来统计点集中的其他各点相对于该点的空间分布, 并产生直方图作为该点的描述子, 也称为该点的形状上下文.该方法有效地抽取了边界上点的空间分布信息和相对位置关系, 抽取的形状特征具有较强的辨识力, 在MPEG-7 CE-1形状测试集上取得了76.51%的识别准确率.距离集(distance set, 简称DS)描述方法[36]是另一种基于边界点集的形状描述方法, 该方法对目标形状边界上的点重新采样得到N个点的点集, 对点集中的每一个点, 计算该点与其最邻近的n(n≤N)个点的距离, 构成一个距离集.经过归一化处理的距离集可以用来描述该点与其临近各点的空间关系, 而由各点的距离集构成的集合, 即距离集的集合, 构成了描述整个点集的空间安排.该方法在MPEG-7 CE-1形状测试集上取得了78.38%的检索精确率.形状上下文和距离集在形状匹配阶段都需要计算点到点的优化问题, 该优化问题可归结为经典的二次指派问题, 而求解该问题的匈牙利算法[37]的时间复杂度为O(N3), 这里, N表示点集的规模.根据文献[35]的报告, 形状上下文方法在执行一次两个形状的匹配时, 在对每个形状仅采样100个点的情况下, 便需要耗费0.2s.而根据文献[36]的报告, 距离集方法在执行形状匹配时, 在采样250个点的情况下, 需要耗费0.7s.很显然, 考虑到匹配算法的计算复杂度, 在使用该类方法时, 对轮廓点进行重新采样得到的点集规模不能太大(一般不超过300个点).而对于具有复杂内部结构的区域形状, 如果对边界点重采样构成的点集规模太小, 显然不足以描述形状的复杂结构信息.形状上下文和距离集虽然能处理区域形状, 但是由于二者计算效率低, 所以有着很大的局限性.文献[38]提出一种称为轮廓点分布直方图(contour points distribution histogram, 简称CPDH)的方法, 该方法将极坐标栅格放置于整个形状的质心, 从而得到描述整个形状轮廓像素点空间关系的轮廓点分布直方图.形状的相似性用EMD(earth mover’s distance)距离进行度量.该方法实质上是一种全局描述子, 因不需要为点集中的每一个点进行特征描述, 因此无论在形状描述还是匹配阶段, 都减少了计算量.该方法在MPEG-7 CE-1形状测试集上取得了76.56%的检索精确率.

近年来, 一些研究工作将复杂网络模型应用于形状分析当中.

文献[39]提出, 将目标形状的边界建模为一个小世界复杂网络.在该模型中, 形状边界上的像素点对应网络上的节点, 像素点间的连线对应网络上的边, 像素点间的归一化欧氏距离作为边的权值.通过网络的动态演化, 提取各时刻网络的度特征和联合度特征, 组合成一个特征向量作为描述子, 在形状匹配阶段, 则通过特征向量间的欧氏距离来确定形状间相似度.文献[40]中提出一种无序点集描述方法(unordered point-set description, 简称UPSD), 该方法将目标形状边界看成无序点集, 提出一种新的基于复杂网络模型的目标边界无序点集形状分析方法.该方法用自主的网络动态演化机制分层地提取形状特征, 通过对网络的局部测量和全局测量, 获取网络的无权特征和加权特征, 构成形状的局部描述子和全局描述子.该描述子为目标形状的识别提供了具有强辨识能力的特征, 在形状匹配阶段, 用较低计算复杂度的Hausdorff距离和L-1距离分别作为局部距离和全局距离, 从而节省了时间成本.该方法在MPEG-7 CE-1形状测试集上取得了78.18%的检索精确率.

2 边界点集的分层描述模型对于一个目标形状的图像, 我们首先抽取目标形状的边界像素点, 得到边界的无序点集B0, 该点集由边

界像素点的坐标构成, 用(x, y)表示像素点的坐标, 则目标形状边界的中心点

| ${\bar x_0} = \frac{{\sum\nolimits_{(x, y) \in {B_0}} x }}{{|{B_0}|}}, {\bar y_0} = \frac{{\sum\nolimits_{(x, y) \in {B_0}} y }}{{|{B_0}|}}$ | (1) |

其中, |·|表示集合的基数.我们用中心点

| ${\bar B_0} = \{ (x - {\bar x_0}, y - {\bar y_0})|(x, y) \in {B_0}\} $ | (2) |

再将边界

| $\bar B_0^\theta = \{ (x\cos \theta + y\sin \theta , y\cos \theta - x\sin \theta )|(x, y) \in {\bar B_0}\} $ | (3) |

记边界

| $\bar B_1^\theta = \{ (x, y)|x \leqslant \bar x_0^\theta , y \geqslant \bar y_0^\theta , (x, y) \in \bar B_0^\theta \} $ | (4) |

显然,

同样, 我们进一步计算子边界

如此迭代地分割下去, 将经过l层分割得到的边界记为

| $\bar B_l^\theta = \{ (x, y)|x \leqslant \bar x_{l - 1}^\theta , y \geqslant \bar y_{l - 1}^\theta , (x, y) \in \bar B_{l - 1}^\theta \} $ | (5) |

其中,

我们对θ在区间[0, 2π)上均匀地采样m个角度, 用j=0, 1, …, m-1表示它们的索引.让变量θ依次取这m个值, 这样我们可以对目标形状边界

| $\mathit{\Psi } (m, l) = \{ \bar B_i^j, i = 1, 2, ..., l, j = 0, 1, ..., m - 1\} $ | (6) |

我们称其为目标形状边界的分层描述模型, 其中, m和l为模型的参数, 分别表示该描述模型的方向角的个数和分层的层级数.

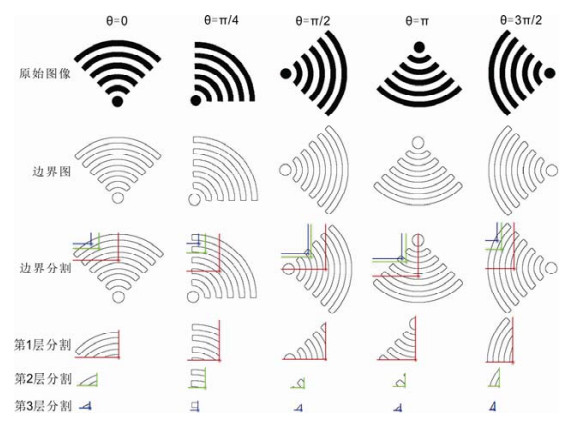

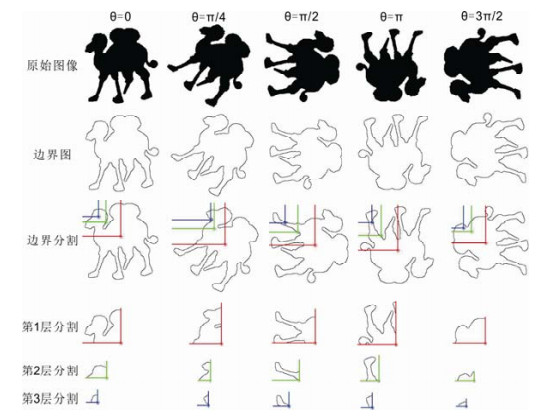

图 3和图 4给出了目标形状边界的分层描述模型示意图, 其中, 图 3为对区域形状边界的分层描述, 图 4为对轮廓线形状边界的分层描述, 模型的参数取m=5, l=3.

|

Fig. 3 Visual illustration of iteratively partitioning the edge of region-based image in progressively smaller part along different directions 图 3 沿不同方向对区域形状的边界迭代地分割示意图 |

|

Fig. 4 Visual illustration of iteratively partitioning the edge of contour-based image in progressively smaller part along different directions 图 4 沿不同方向对轮廓线形状边界迭代地分割示意图 |

3 分层度量方法

第2节定义了描述目标形状边界的分层描述模型

如前所述, 当前层边界是对上一层边界进行一次分割得到的, 分割后的边界是上一层边界的一个子集, 当前层边界上的像素点在上一层边界中占的比重, 构成了当前层边界对上一层边界的几何分割的一个度量, 这里我们将该特征称为分割比, 定义为

| $d_i^j = \frac{{\left| {\bar B_i^j} \right|}}{{\left| {\bar B_{i - 1}^j} \right|}}$ | (7) |

图 5给出了边界分割比的示意图, 其中, 第1行和第2行分别表示图 3和图 4中的区域形状和轮廓线形状在j取0、i分别取1, 2, 3时的分割比特征.

|

Fig. 5 Visual illustration of partition ratio 图 5 形状边界的分割比特征示意图 |

3.2 分散度

度量边界点在二维坐标平面上的分散程度, 是另一类刻画形状边界几何特性的有用特征.为描述这一特性, 我们对子边界

首先, 计算子边界

| $\mathit{\Omega } = \{ {c_k} = \sqrt {{{({x_k} - \bar x_{i - 1}^j)}^2} + {{({y_k} - \bar y_{i - 1}^j)}^2}} , k = 1, 2, ..., |\bar B_i^j|\} $ | (8) |

计算该序列的均值:

| $\rho _i^j = \frac{{\sum\limits_{k = 1}^{k = |\mathit{\Omega } |} {\frac{{{c_k}}}{{\max (\mathit{\Omega } )}}} }}{{|\mathit{\Omega } |}}$ | (9) |

作为对子边界

| $\sigma _i^j = \frac{{\sum\limits_{k = 1}^{k = |\mathit{\Omega } |} {{{\left( {\frac{{{c_k}}}{{\max (\mathit{\Omega } )}} - \rho _i^j} \right)}^2}} }}{{|\mathit{\Omega } |}}$ | (10) |

得到对子边界

离心率是一种被广泛应用的形状特征, 它反映了目标形状像素点绕着中心点的分散程度[41].这里, 我们定义子边界

首先计算子边界

| ${\mu _{p, q}} = \sum\nolimits_{(x, y) \in \bar B_i^j} {{{(x - \bar x_i^j)}^p}{{(y - \bar y_i^j)}^q}} $ | (11) |

这里,

| $U = \left[ {\begin{array}{*{20}{c}} {{\mu _{2, 0}}}&{{\mu _{1, 1}}} \\ {{\mu _{1, 1}}}&{{\mu _{0, 2}}} \end{array}} \right]$ | (12) |

而边界的主惯性矩是U的特征值, 这样, 边界

| ${e_{cc}} = \sqrt {\frac{{{\lambda _{\max }}}}{{{\lambda _{\min }}}}} $ | (13) |

这里, λmax和λmin是U的特征值中的最大和最小值.这种描述方法仅仅取决于形状本身, 无关于形状的大小和方向.从公式(13)可以看出ecc > 1, 这里, 我们取

| $e_i^j = \frac{1}{{{e_{cc}}}}$ | (14) |

组合上述定义的两类分散度度量, 得到特征向量:

| $s_i^j = [\begin{array}{*{20}{c}} {\rho _i^j}&{\sigma _i^j}&{e_i^j} \end{array}]$ | (15) |

作为描述子边界

总结给出的分层度量方法具有如下优点.

(1) 具有形状描述的一般性.该度量方法既可以描述轮廓线形状, 又可以描述区域形状;

(2) 具有特征抽取的可拓展性.除了分割比和分散度, 我们可以将更多其他的对目标边界的几何度量纳入到给出的分层描述模型, 从而满足不同精度的检索需求;

(3) 具有对目标形状的多尺度描述性.本文提出的分层描述机制使得该形状描述子具有内在的由粗到细的多尺度表征能力;

(4) 较低的计算复杂性.由于我们在特征提取时仅仅考虑目标形状的边界像素点, 使得给出的分层度量方法具有较高的计算效率.

4 形状相似度度量方法形状相似度度量的主要任务是测量一副检索图像的特征向量与图像数据集中图像特征向量之间的差异.本节基于定义的目标形状边界点集的分层描述方法, 提出一种循环移位的特征匹配方法, 以度量两个目标形状的相似度.

4.1 形状描述子的构造用我们前面提出的形状边界分层描述模型

| $D = \left[ {\begin{array}{*{20}{c}} {d_1^0}&{d_2^0}&{...}&{d_l^0} \\ {d_1^1}&{d_2^1}&{...}&{d_l^1} \\ \vdots & \vdots & \ddots & \vdots \\ {d_1^{m - 1}}&{d_2^{m - 1}}&{...}&{d_l^{m - 1}} \end{array}} \right], S = \left[ {\begin{array}{*{20}{c}} {s_1^0}&{s_2^0}&{...}&{s_l^0} \\ {s_1^1}&{s_2^1}&{...}&{s_l^1} \\ \vdots & \vdots & \ddots & \vdots \\ {s_1^{m - 1}}&{s_2^{m - 1}}&{...}&{s_l^{m - 1}} \end{array}} \right]$ | (16) |

显然, 矩阵D的规模为m×l, 矩阵S的规模为m×3l(因为

组合矩阵D和矩阵S, 产生一个对目标形状进行综合描述的规模为m×4l的矩阵F0:

| $ F_{0}=[\omega \cdot D \quad(1-\omega) \cdot S] $ | (17) |

其中, ω∈[0, 1]为权重变量, 用以调节描述矩阵D和S在形状相似性度度量中的贡献.

4.2 循环移位特征匹配我们将特征矩阵F0的每一行表示成一个行向量Vi, i=0, 1, …, m-1, 这样, 特征矩阵F0就可以改写成一个列向量的形式, 即:

| ${F_0} = \left[ {\begin{array}{*{20}{c}} {{V_0}} \\ {{V_1}} \\ \vdots \\ {{V_{m - 1}}} \end{array}} \right]$ | (18) |

需要指出的是, 当目标形状发生旋转时, 我们对目标进行分割的起始方向会发生改变, 使得方向序列(长度为m)会发生循环移位.为此, 对于一个待识别的目标形状A, 在将其与数据集里的形状进行匹配之前, 我们先准备其特征矩阵F0以及F0的m-1个循环移位后的版本:

| ${F_1} = \left[ {\begin{array}{*{20}{c}} {{V_1}} \\ {{V_2}} \\ \vdots \\ {{V_{m - 1}}} \\ {{V_0}} \end{array}} \right], {F_2} = \left[ {\begin{array}{*{20}{c}} {{V_2}} \\ \vdots \\ {{V_{m - 1}}} \\ {{V_0}} \\ {{V_1}} \end{array}} \right], {F_3} = \left[ {\begin{array}{*{20}{c}} {{V_3}} \\ \vdots \\ {{V_0}} \\ {{V_1}} \\ {{V_2}} \end{array}} \right], ..., {F_{m - 1}} = \left[ {\begin{array}{*{20}{c}} {{V_{m - 1}}} \\ {{V_0}} \\ {{V_1}} \\ \vdots \\ {{V_{m - 2}}} \end{array}} \right]$ | (19) |

这样, 形状A与数据集里面的形状B之间的差异度可以定义为

| $dis(A, B) = \mathop {\min }\limits_{j = 0, 1, ..., m - 1} ||F_j^A - F_0^B||$ | (20) |

这里, ||·||表示L-1距离.

5 算法性能分析本节对前面提出的形状描述方法和特征匹配算法的不变性和计算时间复杂度进行分析.

5.1 不变性分析因在进行分层描述之前已将坐标原点移到了形状边界的中心点, 所以产生的描述子已满足对目标形状的平移不变性.由分割比

本文提出的形状描述算法的输入有:(1)目标形状的边界点集B0; (2)对角度区间[0, 2π)的采样频率m;

(3) 分层的层级数l.我们在算法1中给出了形状描述算法的伪代码.

算法1. Calculating Hierarchical Descriptor of Unordered Edge Point-set.

Input:

B0: the edge-point set of a shape;

m: the number of sampling angles in range [0, 2π];

l: the number of hierarchical level;

Output:

1: Initialize

2:

3:

4: for j=0 to m-1 do /*The loop control variable j is the index of the sampled angles*/

5:

6: for i=1 to l do /*The loop control variable i is the index of the hierarchical levels*/

7: if

8:

9:

10:

11:

12:

13:

14:

15:

16:

17:

18: else

19: break;

20: end if

21: end for

22:

23: end for

24: Return

该算法最耗时的计算是从第4步~第23步的外层循环(执行m次).其内层循环(第6步~第21步)共执行l次, 执行第i次内层循环会将子边界

以上是形状描述算法的时间复杂度分析, 本文提出方法的另外一部分是形状匹配任务.在得到形状描述矩阵F0(公式(17)和公式(18))后, 我们要对其进行m-1次循环移位(公式(19)), 由于F0的规模为m×4l, 所以循环移位操作的时间复杂度为O(ml).计算两个特征矩阵的L-1距离的时间复杂度为O(ml), 而我们要将形状A的特征矩阵及其m-1个循环移位版本与形状B的特征矩阵进行匹配(公式(20)), 因此, 计算两个形状距离的时间复杂度为O(lm2), 从而整个形状匹配阶段的时间复杂度为O(ml+lm2)=O(lm2).值指出的是, l为本文提出的形状描述算法的一个输入参数, 若

上述分析表明, 本文提出的算法无论在形状描述阶段, 还是在形状匹配阶段, 都有着可接受的计算复杂度.

6 实验结果和讨论为评估本文提出的目标形状识别算法的性能, 我们将MPEG-7 CE-2区域形状测试集和MPEG-7 CE-1轮廓线形状测试集这两个被广泛采用的形状测试集作为基准测试集.因本文提出的方法属于基于边界点集的描述方法, 所以在实验中, 我们选择的主要比较对象为4种基于边界点集的形状描述方法——形状上下文SC[35]、距离集DS[36]、无序点集描述方法UPSD[40]和轮廓点分布直方图CPDH[38].另外, 两种基于区域点集的描述方法:Zernike矩ZM[28]、自适应密度直方图AHDH[34]和一种区域点集和边界点集相结合的描述方法:Zernike矩边缘梯度ZMEG[32], 在实验中也被纳入为比较对象.其中, ZM[28]是MPEG-7推荐的标准的区域形状描述方法; 而AHDH[34]同本文的算法一样, 都属于分层的形状描述方法.我们的实验参数设置如下:角度采样频率m=72, 层级数l=3;构建特征矩阵过程中, 用以调节描述矩阵D和S在形状相似性度量中贡献的权重参数ω=0.8.实验平台为一台CPU为Intel Core i5-4590 3.30GHz, 内存8G, 操作系统为Win10的台式计算机, 算法用Matlab编程实现.

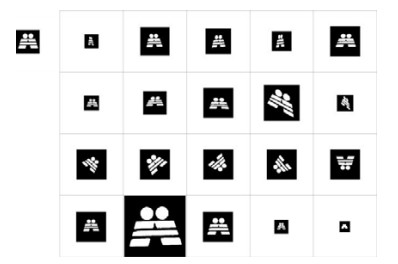

6.1 MPEG-7 CE-2区域形状测试集我们用于算法评估的第1组实验是在MPEG-7 CE-2区域形状测试集[30]上进行的.MPEG-7 CE-2测试集总共包含3 621幅区域形状图像, 其中的部分样本如图 6所示.该测试集中有651个样本, 被分成31组, 每组有21个样本, 同一组中的样本属于同类形状, 图 7给出了第8组形状的21个样本.我们采用被广泛用于形状检索性能评估的方法——bulls-eye test评估方法[6-12, 15-17, 19-23, 34-36, 38, 40, 43, 44]进行算法的性能评估.采用该方法, 我们把数据集中651个样本依次作为检索样本跟测试集中的3 621样本进行形状相似性比较, 返回差异度最小的前2×21=42幅图像, 统计返回的42幅图像中, 与查询样本属于同一组的数目.假设返回r幅属于同一组的样本, 显然r≤21, 计算r/21×100%的值作为该查询样本的检索率, 651个样本的平均检索率作为整个测试的检索率(bulls-eye test score).

|

Fig. 6 Samples from MPEG-7 CE-2 dataset 图 6 MPEG-7 CE-2数据集的样本 |

|

Fig. 7 All the samples in the group 8 of MPEG-7 CE-2 dataset 图 7 MPEG-7 CE-2数据集中第8组形状的所有样本 |

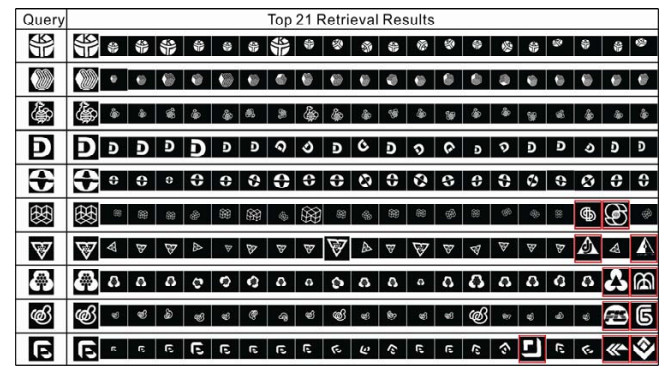

我们在图 8中给出部分形状的前21个检索结果(框以红色矩形的形状是错误的检索结果), 并在表 1中给出了本文提出的方法和参与比较的两种基于边界点集的方法SC[35]和UPSD[40]、两种基于区域点集的方法ZM[28], AHDH[34]和一种区域点集和边界点集相结合的方法ZMEG[32]在MPEG-7 CE-2区域形状测试集上的检索率.从表中给出的数据可以看出, 与同类基于边界点集的方法SC和UPSD相比, 本文提出方法的检索精确率分别高出了15.48个和2.33个百分点.与基于区域点集的方法ZM相比, 本文的方法高出了6.26个百分点; 与区域点集和边界点集相结合的方法ZMEG相比, 本文的方法高出了4.04个百分点.值得指出的是, 与本文的思想最为接近的是同样采用分层描述的AHDH方法, 但该方法在MPEG-7 CE-2测试集上仅取得了49.94%的检索率.其主要原因是, 该方法仅从单个方向上对目标形状进行描述, 该方法的描述和匹配依赖于目标形状的方向; 而本文提出的方法采用了一种旋转分层的描述框架, 从多个方向上描述了形状的分层复杂性, 因此其形状匹配结果不依赖于形状的方向.该组实验结果表明:本文提出的方法在MPEG-7 CE-2区域形状测试集上的测试性能要优于参与比较的同类方法, 也好于参与比较的两种基于区域点集的形状描述方法和一种区域点集和边界点集相结合的方法, 从而证明本文提出的方法比其他方法更能有效地处理包含复杂内部结构的形状图像, 对目标形状检索具有一般性.需要指出的是, 对于DS[36]和CPDH[38], 由于报告这两种方法的文献没有给出在MPEG-7 CE-2测试集的测试结果, 也没有给出具体的实现细节, 因此在本组实验中, 我们略去了与这两种方法的比较, 但在下一组实验中, 我们将直接引用这两种方法报告的结果作为对比.

|

Fig. 8 Top 21 retrieval results of partial shapesin MPEG-7 CE-2 dataset 图 8 MPEG-7 CE-2数据集中部分形状的前21个检索结果 |

| Table 1 Retrieval rates of the compared methods on the MPEG-7 CE-2 shape dataset 表 1 各种对比方法在MPEG-7 CE-2形状测试集上的检索率 |

6.2 MPEG-7 CE-1轮廓线形状测试集

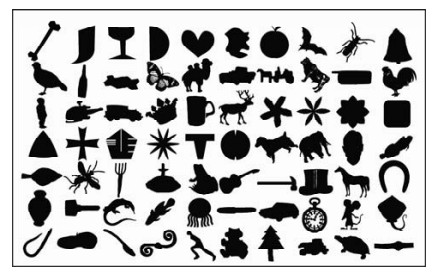

我们用于算法评估的第2组实验是在MPEG-7 CE-1轮廓线形状测试集[42]上进行的.MPEG-7 CE-1轮廓线形状测试集是被广泛采用的用于形状检索性能评估的标准测试集.该测试集共包含1 400幅轮廓线形状图像, 它们被分成70种形状类型, 不同类型形状的样本如图 9所示, 每种类型的形状包含20个样本, 如图 10所示.该组实验我们依然用bulls-eye test评估方法.与上一组实验不同的是, 这里我们用测试集中的每一个样本作为一个查询样本, 跟测试集中的所有样本进行相似性比较; 然后, 根据形状的差异度进行排序, 返回差异度最小的前2×20=40幅图像, 统计返回的这40幅图像中有多少幅与查询样本属于同一类.假设有r幅返回图像跟查询图像属于同一类, 显然r≤20, 计算r/20×100%的值作为该查询样本的检索率, 取1 400个检索样本的检索率的平均值作为整个测试的检索率(bulls-eye test score).

|

Fig. 9 All kinds of shapes from the MPEG-7 CE-1 dataset 图 9 MPEG-7 CE-1数据集的所有类型形状样本 |

|

Fig. 10 All the samples of the camel shape in the MPEG-7 CE-1 dataset 图 10 MPEG-7 CE-1数据集中骆驼形状的所有样本 |

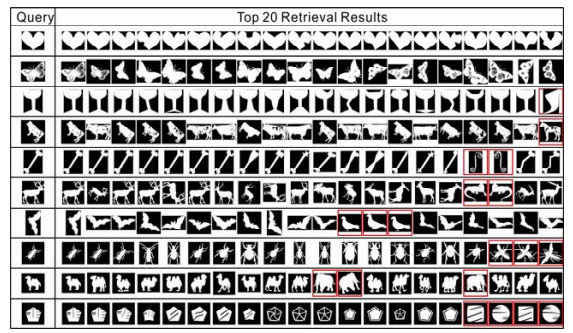

我们在图 11中给出了部分形状的前20个检索结果(框以红色矩形的形状是错误的检索结果), 并在表 2中给出了本文提出的方法和参与比较的4种基于边界点集的方法(带“*”标识的结果直接引自参考文献)、两种基于区域点集的方法和一种区域点集和边界点集相结合的方法在MPEG-7 CE-1轮廓线形状测试集上的检索率.

|

Fig. 11 Top 20 retrieval results of partial shapesin MPEG-7 CE-1dataset 图 11 MPEG-7 CE-1数据集中部分形状的前20个检索结果 |

| Table 2 Retrieval rates of the compared methods on the MPEG-7 CE-1 shape dataset 表 2 各种对比方法在MPEG-7 CE-1形状测试集上的检索率 |

从表中给出的数据可以看出, 与同类基于边界点集的方法SC[35], DS[36], UPSD[40]和CPDH[38]相比, 本文提出方法的检索精确率分别高出了6.1, 4.23, 4.43和6.05个百分点; 与基于区域点集的方法ZM[28]和AHDH[34]相比, 本文的方法分别高出了13.71和18.66个百分点; 与区域点集和边界点集相结合的方法ZMEG[32]相比, 本文的方法高出了11.97个百分点.在本组实验中, 我们还比较了各类算法执行的效率, 需要指出的是:对于数据集中的形状, 用于表征这些形状的形状描述子可以在线下进行提取, 所以这里我们比较的是各算法执行线上形状匹配的效率.根据文献[35]报告的结果, 采用Shape Contexts方法, 执行一次两个形状的匹配计算(采样100个点), 在一台Pentium Ⅲ/ 500MHZ的计算机上需要耗时2×10-1s; 根据文献[36]报告的结果, 采用Distance Sets方法, 执行一次两个形状的匹配计算(采样250个点), 在一台Pentium Ⅲ/667MHZ的计算机上大约耗时7×10-1s; 根据文献[40]报告的结果, 采用Unordered Point-set Description方法, 在一台CPU为Intel Core i7-4770/3.4GHZ的计算机上, 执行一次两个形状的匹配计算(采样300个点), 耗时为9.4×10-4s; 而采用本文提出的方法, 在一台CPU为Intel Core i5-4590/ 3.30GHZ的计算机上, 执行一次两个形状的匹配计算, 仅用时2.7×10-4s.我们在表 3中给出了几种经典方法和本文提出的方法在MPEG-7 CE-1形状测试集上的匹配时间复杂度和平均匹配时间对比(带“*”标识的结果直接引自参考文献).该组实验结果表明:相较于参与比较的其他方法, 本文提出的方法不仅具有更好的检索精确度, 而且具有更高的计算效率.

| Table 3 Time complexity and average matching time of several remarkable methodsand the proposed method on the MPEG-7 CE-1 shape dataset 表 3 null匹配时间复杂度和平均匹配时间 |

对于一些基于曲线的方法, 如多尺度凹凸性[5]、内部距离[6]、三角形面积[7]、轮廓柔韧性[8]、形状树[17]、局部仿射不变描述子[19], 虽然这些方法在MPEG-7 CE-1测试集上报告的结果大都超过85%, 但这些方法是专门为轮廓线形状设计的, 对于MPEG-7 CE-2中的区域形状, 这些方法则不能对其进行有效地处理.值得指出的是, 本文提出的方法虽然没有用到边界点的有序信息, 但其在MPEG-7 CE-1上的识别率已超过了一些基于曲线的方法, 如生物序列(biological code, 简称BC)[43]、距离内缘比率(distance interior ratio)[44]等方法.

7 结论本文提出了基于目标边界无序点集的形状描述方法, 以应用于一般的形状图像检索任务.该方法通过对目标形状的边界点集沿各个方向的逐层分割, 建立了一种对目标形状边界的分层描述模型, 对各层子边界的分割比和分散度的几何度量, 多尺度地描述了目标形状边界点的空间分布特性.通过在MPEG-7 CE-2区域形状测试集和MPEG-7 CE-1轮廓线形状测试集上的两组图像检索实验和其他同类方法的对比, 验证了该方法的有效性.

总结该算法具有如下优点.是一种通用的形状图像描述算法, 既能描述轮廓线形状, 又能描述区域形状; 具有特征抽取的开放性, 虽然基于本文提出的描述框架, 我们仅用了分割比和分散度这两种几何度量对每一层子边界进行了度量, 但该描述框架具有一般性, 每一层子边界还可以引入其他几何度量, 如矩特征、傅里叶特征等, 以满足对不同精度的形状图像识别任务的要求; 具有内在的多尺度特性和对旋转、缩放和平移的不变性; 具有比同类方法更好的检索精确率和更高的计算效率.

在未来的研究工作中, 在目标形状的特征抽取阶段, 我们会将一些其他的边界度量方法纳入到给出的分层描述框架中, 结合机器学习的方法进行有效的特征选取, 从而获取更加精确的形状描述子; 在形状匹配阶段, 我们将考虑结合动态规划和距离度量学习的方法, 来进行更加准确的形状相似度的度量.

| [1] |

Smeulders AWM, Worring M, Santini S, Gupta A, Jain R. Content-Based image retrieval at the end of the early years. IEEE Trans. on Pattern Analysis and Machine Intelligence, 2000, 22(12): 1349-1380.

[doi:10.1109/34.895972] |

| [2] |

Cao J, Wu Z, Wu J, Liu W. Towards information-theoretic K-means clusteringfor image indexing. Signal Processing, 2013, 93(7): 2026-2037.

[doi:10.1016/j.sigpro.2012.07.030] |

| [3] |

Cao J, Wang B, Brown D. Similarity based leaf image retrieval using multiscale R-angle description. Information Sciences, 2016, 374: 51-64.

[doi:10.1016/j.ins.2016.09.023] |

| [4] |

Costa LDF, Cesar RM. Shape Analysis and Classification:Theory and Practice. Florida: CRC Press LLC, 2001: 1-25.

|

| [5] |

Adamek T, O'Connor NE. A multiscale representation method for nonrigid shapes with a single closed contour. IEEE Trans. on Circuits and Systems for Video Technology, 2004, 14(5): 742-753.

[doi:10.1109/TCSVT.2004.826776] |

| [6] |

Ling H, Jacobs DW. Shape classification using the inner-diatance. IEEE Trans. on Pattern Analysis and Machine Intelligence, 2007, 29(2): 286-299.

[doi:10.1109/TPAMI.2007.41] |

| [7] |

Alajlan N, Rube IE, Kamel MS, Freeman G. Shape retrieval using triangle-area representation and dynamic space warping. Pattern Recognition, 2007, 40(7): 1911-1920.

[doi:10.1016/j.patcog.2006.12.005] |

| [8] |

Xu C, Liu J, Tang X. 2D shape matching by contour flexibility. IEEE Trans. on Pattern Analysis and Machine Intelligence, 2009, 31(1): 180-186.

[doi:10.1109/TPAMI.2008.199] |

| [9] |

Biswas S, Aggarwal G, Chellappa R. An efficient and robust algorithm for shape indexing and retrieval. IEEE Trans. on Multimedia, 2010, 12(5): 372-384.

[doi:10.1109/TMM.2010.2050735] |

| [10] |

Bai X, Yang X, Latecki LJ, Liu W, Tu Z. Learning context-sensitive shape similarity by graph transduction. IEEE Trans. on Pattern Analysis and Machine Intelligence, 2010, 32(5): 861-874.

[doi:10.1109/TPAMI.2009.85] |

| [11] |

Wang J, Bai X, You X, Liu W, Latecki LJ. Shape matching and classification using height functions. Pattern Recognition Letters, 2012, 33(2): 134-143.

http://d.old.wanfangdata.com.cn/NSTLQK/NSTL_QKJJ0225879282/ |

| [12] |

Wang B, Gao Y. Hierarchical string cuts:A translation, rotation, scale and mirror invariant descriptor for fast shape retrieval. IEEE Trans. on Image Processing, 2014, 23(9): 4101-4111.

[doi:10.1109/TIP.2014.2343457] |

| [13] |

Zahn CT, Roskies RZ. Fourier descriptors for plane closed curves. IEEE Trans. on Computers, 1972, C-21(3): 269-281.

[doi:10.1109/TC.1972.5008949] |

| [14] |

Persoon E, Fu KS. Shape discrimination using Fourier descriptors. IEEE Trans. on Pattern Analysis and Machine Intelligence, 1986, 3: 388-397.

http://d.old.wanfangdata.com.cn/Periodical/zghyhzxb201706019 |

| [15] |

Mokhtarian F, Abbasi S, Kittler J. Efficient and robust retrieval by shape content through curvature scale space. In: Proc. of the Int'l Workshop on Image Databases and Multimedia Search. Amsterdam, 1996. 51-58.

|

| [16] |

Mokhtarian F, Bober M. Curvature Scale Space Representation: Theory, Application, and MPEG-7 Standardization. Kluwer Academic Publishers, 2003.

|

| [17] |

Felzenszwalb PF, Schwartz JD. Hierarchical matching of deformable shapes. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition (CVPR). Minneapolis, 2007. 1-8.

|

| [18] |

Xiong GQ, Qi DX, Guo FH. A class of orthonormal complete piecewise polygonal systems and applications. Science in China (Information Sciences), 2012, 42(1): 70-82(in Chinese with English abstract).

http://d.old.wanfangdata.com.cn/Conference/7404304 |

| [19] |

Wang Z, Liang M. Locally affine invariant descriptors for shape matching and retrieval. IEEE Signal Processing Letters, 2010, 17(9): 803-806.

[doi:10.1109/LSP.2010.2057506] |

| [20] |

Hu RX, Jia W, Ling H, Zhao Y, Gui J. Angular pattern and binary angular pattern for shape retrieval. IEEE Trans. on Image Processing, 2014, 23(3): 1118-1127.

[doi:10.1109/TIP.2013.2286330] |

| [21] |

Daliri MR, Torre V. Robust symbolic representation for shape recognition and retrieval. Pattern Recognition, 2008, 41(5): 1782-1798.

[doi:10.1016/j.patcog.2007.10.020] |

| [22] |

Attalla E, Siy P. Robust shape similarity based on contour segmentation polygonal multiresolution and elastic matching. Pattern Recognition, 2005, 38(12): 2229-2241.

[doi:10.1016/j.patcog.2005.02.009] |

| [23] |

Super BJ. Retrieval from shape databases using chance probability function and fixed correspondence. Int'l Journal of Pattern Recognition and Artificial Intelligence, 2006, 20(8): 1117-1137.

[doi:10.1142/S0218001406005174] |

| [24] |

Li Z, Liu J, Tang J, Lu H. Robust structured subspace learning for data representation. IEEE Trans. on Pattern Analysis and Machine Intelligence, 2015, 37(10): 2085-2098.

[doi:10.1109/TPAMI.2015.2400461] |

| [25] |

Li Z, Liu J, Yang Y, Zhou X, Lu H. Clustering-Guided sparse structural learning for unsupervised feature selection. IEEE Trans. on Knowlege and Data Engineering, 2014, 26(9): 2138-2150.

[doi:10.1109/TKDE.2013.65] |

| [26] |

Li Z, Tang J. Weakly supervised deep metric learning for community-contributed image retrieval. IEEE Trans. on Multimedia, 2015, 17(11): 1989-1999.

[doi:10.1109/TMM.2015.2477035] |

| [27] |

Hu MK. Visual pattern recognition by moment invariants. IRE Trans. on Information Theory, 1962, IT-8: 179-187.

http://d.old.wanfangdata.com.cn/NSTLQK/10.1109-TIT.1962.1057692/ |

| [28] |

Khotanzad A, Hong YH. Invariant image recognition in Zernike moments. IEEE Trans. on Pattern Analysis and Machine Intelligence, 1990, 12(5): 250-261.

http://d.old.wanfangdata.com.cn/OAPaper/oai_doaj-articles_a295c4b92c9c017d52853d416a480cc3 |

| [29] |

Nassery P, Faez K. Signature pattern recognition using pseudo Zernike moments and a fuzzy logic classifier. In: Proc. of the IEEE Int'l Conf. on Image Processing. 1996. 197-200.

|

| [30] |

Zhang D, Lu G. Shape based image retrieval using generic Fourier descriptor. Signal Processing:Image Communition, 2002, 17(10): 825-848.

[doi:10.1016/S0923-5965(02)00084-X] |

| [31] |

Zhang D, Lu G. Review of shape representation and description techniques. Pattern Recognition, 2004, 37(1): 1-19.

http://www.sciencedirect.com/science/article/pii/S0031320303002759 |

| [32] |

Anuar FM, Setchi R, Lai YK. Trademark image retrieval using an integrated shape descriptor. Expert Systems with Applications, 2013, 40(1): 105-121.

http://d.old.wanfangdata.com.cn/NSTLQK/NSTL_QKJJ0228867946/ |

| [33] |

Yang M, Qiu G, Huang J, Elliman D. Near-duplicate image recognition and content-based image retrieval using adaptive hierarchical geometric centroids. In: Proc. of the 18th Int'l Conf. on Pattern Recognition (ICPR 2006). 2006. 958-961.

|

| [34] |

Sidiropoulos P, Vrochidis S, Kompatsiaris I. Content-Baesd binary image retrieval using the adaptive hierarchical density histogram. Pattern Recognition, 2011, 44(4): 739-750.

[doi:10.1016/j.patcog.2010.09.014] |

| [35] |

Belongie S, Malik J, Puzicha J. Shape matching and object recognition using shape contexts. IEEE Trans. on Pattern Analysis and Machine Intelligence, 2002, 24(4): 509-522.

[doi:10.1109/34.993558] |

| [36] |

Crigorescu C, Petkov N. Distance sets for shape filters and shape recognition. IEEE Trans. on Image Processing, 2003, 12(10): 1274-1286.

[doi:10.1109/TIP.2003.816010] |

| [37] |

Papadimitriou CH, Steiglitz K. Combinatorial Optimization: Algorithms and Complexity. New York: Dover Publications, INC, 1998. 248-254.

|

| [38] |

Shu X, Wu XJ. A novel contour descriptor for 2D shape matching and its application to image retrieval. Image and Vision Computing, 2011, 29(4): 286-294.

[doi:10.1016/j.imavis.2010.11.001] |

| [39] |

Backes AR, Casanova D, Bruno OM. A complex network-based approach for boundary shape analysis. Pattern Recognition, 2009, 42(1): 54-67.

|

| [40] |

Wang B. Shape recognition using unordered point-set description and matching of object contour. Ruan Jian Xue Bao/Journal of Software, 2016, 27(12): 3131-3142(in Chinese with English abstract).

http://www.jos.org.cn/1000-9825/5101.htm [doi:10.13328/j.cnki.jos.005101] |

| [41] |

Mokhtarian F, Abbasi S. Matching shape with self-intersections:Application on leaf classification. IEEE Trans. on Image Processing, 2004, 13(5): 653-661.

[doi:10.1109/TIP.2004.826126] |

| [42] |

Latecki LJ, Lakamper R, Eckhardt U. Shape descriptors for non-rigid shapes with a single closed contour. In: Proc. of the IEEE Conf. Computer Vision and Pattern Recognition (CVPR). 2000. 424-429.

|

| [43] |

Bicego M, Lovato P. A bioinformatics approach to 2D shape classification. Computer Vision and Image Understanding, 2016, 145: 59-69.

[doi:10.1016/j.cviu.2015.11.011] |

| [44] |

Kaothanthong N, Chun J, Tokuyama T. Distance interior ratio:A new shape signature for 2D shape retrieval. Pattern Recognition Letters, 2016, 78: 14-21.

[doi:10.1016/j.patrec.2016.03.029] |

| [18] |

熊刚强, 齐东旭, 郭芬红. 一类完备的正交分段多项式函数系及其应用. 中国科学:信息科学, 2012, 42(1): 70-82.

http://d.old.wanfangdata.com.cn/Conference/7404304 |

| [40] |

王斌. 用于形状识别的目标轮廓无序点集描述与匹配. 软件学报, 2016, 27(12): 3131-3142.

http://www.jos.org.cn/1000-9825/5101.htm [doi:10.13328/j.cnki.jos.005101] |

2019, Vol. 30

2019, Vol. 30