2. 中国人民解放军91917部队, 北京 100071;

3. 模式识别国家重点实验室(中国科学院 自动化研究所), 北京 100190

2. Unit 91917 of People's Liberation Army of China, Beijing 100071, China;

3. State Key Laboratory of Pattern Recognition(Institute of Automation, Chinese Academy of Sciences), Beijing 100190, China

目标跟踪是计算机视觉领域研究的热点之一, 当前广泛应用于视频监控、人机交互等实际问题中, 具有重要的研究价值.但是受限于实际环境的复杂性, 例如遮挡、光照变化、目标形变以及背景相似干扰等, 当前跟踪算法在准确性、鲁棒性以及实时性上还很难满足实际应用需求.因此它仍是一个极具挑战性的课题.

基于相关滤波的跟踪方法以其出色的性能和速度优势, 在跟踪领域引起了很大的关注.近年来, 涌现出了大量基于相关滤波的跟踪方法, 如KCF[1]、SAMF[2]、LCT[3]、MUSTer[4]和CACF[5], 这些方法多数采用手工特征, 因此限制了算法的准确性和鲁棒性.随着CNN在目标识别领域中的成功应用, 深度学习进入了目标跟踪领域, 比较有代表性的基于CNN的跟踪方法有DeepSRDCF[6]、HCF[7]、SiamFC[8]、CFNet[9]和DCFNet[10]等, 但这些算法仅考虑了对图像中目标表观特征的提取, 特征响应存在多峰现象, 跟踪结果易产生漂移.本文结合连续CRF模型提出了一种新的端到端的目标跟踪方法, 充分考虑了图像相邻超像素块之间的相似性关系, 利用该关系约束了初始响应值, 抑制了跟踪过程中的漂移现象.

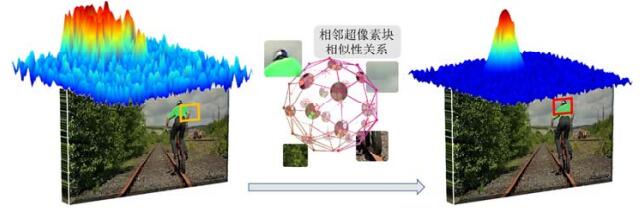

本文提出的基于条件随机场的深度相关滤波目标跟踪算法, 在跟踪一段视频序列时, 将其中每一帧图片的目标候选区域通过深度卷积神经网络提取特征, 运用相关滤波计算初始响应图, 与此同时, 根据相邻超像素块之间的位置关系构建相似度矩阵.然后结合当前图片的初始响应与相似度矩阵更新响应图, 最终确认目标的位置信息.如图 1所示, 初始响应图中目标位置附近多峰现象严重, 本文加入了相邻超像素块之间的相似性关系, 利用该关系去约束初始响应图, 去除了多峰现象, 抑制了跟踪过程中的漂移, 使得优化后的响应图更加平滑, 提高了判别目标位置的鲁棒性.

|

Fig. 1 Process of model optimization 图 1 算法模型优化过程 |

本文的贡献及创新点总结如下.

(1) 将连续CRF模型运用到目标跟踪领域中, 通过对CRF模型中单个势节点和相邻势节点之间的关系建模, 优化了基于深度学习的DCF跟踪算法, 有效缓解了不同情况下的跟踪漂移问题, 特别是在目标尺度变化时, 明显提高了跟踪的成功率;

(2) 设计了一个端到端的框架, 将CRF模型嵌入深度卷积神经网络中, 在保持算法实时性的前提下, 提升了算法的跟踪精度;

(3) 构建了一个基于图像相邻超像素块之间位置关系的相似度矩阵, 在响应图中校正了目标的相对位置, 减少了目标周边背景噪声的影响;

(4) 将本文算法在OTB-2013的50个视频序列和OTB-2015的100个视频序列[11]上进行了大量的测试, 并与9种近年来在国际上具有代表性的相关算法进行了对比分析, 显著性实验结果验证了算法的有效性、准确性和鲁棒性.

1 相关工作本文的主要贡献是将CRF模型运用到目标跟踪领域, 优化基于深度学习的DCF跟踪算法.涉及到本文相关工作的两个方面主要包括基于DCF的跟踪方法以及CRF的应用情况.

1.1 基于DCF的目标跟踪方法基于DCF的目标跟踪算法利用快速傅里叶变换进行滤波器的训练和响应图的计算, 极大地提高了跟踪效率, 具有很好的扩展性.传统的基于DCF的算法有KCF、MOSSE[12]和CSK[13], 随后出现了各种改进算法, 包括优化尺度变换的跟踪器SAMF和fDSST[14]、将颜色信息考虑在内的Staple[15]和CN[16]、希望跟踪器能长期跟踪的LCT和MUSTer、考虑缓和边界效应的SRDCF[17]和CACF, 但这些方法多数使用手工特征, 因此限制了算法的鲁棒性.

随着CNN在图片分类[18, 19]、目标检测[20]以及图像分割[21]工作中的迅速发展, 目标跟踪领域也开始将深度卷积神经网络作为解决问题的工具之一.越来越多的算法将DCF框架和CNN结合在一起, 例如HCF和HDT[22], 提出使用分层卷积特征对跟踪目标进行学习和表达, 代替了原来的HOG特征.SRDCF和DeepSRDCF改善了DCF中存在的边界效应, 后者在前者基础上将手工特征替换为CNN特征, 并说明了在解决跟踪问题时, 采取CNN的底层特征效果较好, 得出解决跟踪问题并不需要太高语义信息的结论.CFNet和DCFNet在SiamFC的结构上加入了CF层, 实现了网络的端到端训练, 用实验表明这种网络结构可以用较少的卷积层而不会降低精度.

1.2 CRF的应用CRF由Lafferty等人[23]提出, 结合了最大熵模型和隐马尔可夫模型的特点, 是一种无向图模型, 近年来在分词、词性标注和命名实体识别等序列标注任务中取得了良好的效果.CRF模型很少应用在处理连续的回归问题上, 最早采用连续CRF模型的工作之一是Qin等人[24]提出的, 应用在文献检索中解决全球排名问题, 在一定的约束条件下, 可以用确定的规范化因子来优化极大似然函数.在这之后, 连续CRF模型被成功开发应用在各种结构化回归问题中, 例如图像降噪[25]和遥感领域[26], 值得一提的是, 随着CNN的普及应用, Liu等人[27]成功地将连续CRF模型用于图像深度估计, 结合深度值的连续性, 学习连续CRF在CNN框架中的势能函数.

到目前为止, 还没有将连续CRF模型应用到目标跟踪领域的鲁棒性算法, 本文提出的目标跟踪模型建立在连续图像响应值上, 用连续CRF来估计目标候选区域的响应, 旨在共同探索CRF模型结合CNN的跟踪方法在学习目标特征表示时的能力和潜力.

2 基于CRF的相关滤波跟踪方法本节首先对基于CRF的相关滤波目标跟踪方法进行简要概述, 然后详细介绍本文算法中各个模块的原理和实现方法, 最后, 介绍改进后的算法流程以及网络的优化过程.

2.1 基于CRF的深度相关滤波目标跟踪概述目标跟踪的主要目的在于确定目标在视频帧中的位置信息, 需要通过相应的目标表观特征描述方法将其中相对稳定的统计特征或某些不变的特征提取出来, 一般通过相关滤波器来获取目标候选区域的响应, 作为判断目标位置的标准, 与背景加以区分.由于视频中的每一帧图像都由若干个像素组成, 假设可以将每一张图像分割成若干个超像素块, 并且认为图像模型是由很多超像素块所构成.

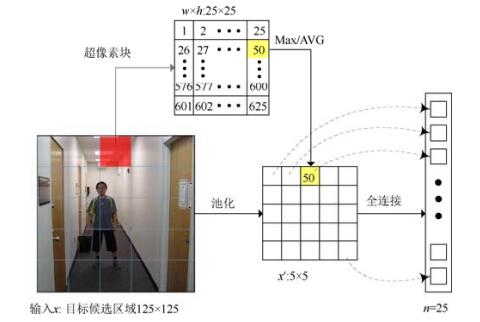

如图 2所示, 输入

|

Fig. 2 An illustration of the superpixel pooling method 图 2 图像超像素化过程 |

根据传统的CRF参数化模型[28], 在随机变量X取值为x的条件下, 随机变量Y取值为y的条件概率密度函数可以表示为

| $\Pr (y\left| x \right.) = \frac{1}{{Z(x)}}\exp \left[ {\sum\limits_{i, l} {{\mu _l}{s_l}({y_i}, x, i)} + \sum\limits_{i, j, k} {{\lambda _k}{t_k}({y_i}, {y_j}, x, i, j)} } \right]$ | (1) |

式中, i, j=1, 2, ..., n, sl和tk是特征函数, μl和λk是对应的权值, 求和是在所有可能的输出序列上进行的, Z(x)表示规范化因子, 本文将特征表示部分用能量函数G(y, x)来表示, 因此条件概率密度函数可以写为

| $\Pr (y\left| x \right.) = \frac{1}{{Z(x)}}\exp \left( { - G(y, x)} \right)$ | (2) |

式(2)中, 规范化因子Z(x)表示为

| $Z(x) = \int_y {\exp \left\{ {\sum\limits_{i, l} {{\mu _l}{s_l}({y_i}, x, i)} + \sum\limits_{i, k} {{\lambda _k}{t_k}({y_{i - 1}}, {y_i}, x, i)} } \right\}} {\text{d}}y$ | (3) |

由于这里的y是连续值, 与离散情况不同, 因此用积分来替换原来的求和运算.为了预测目标位置, 可用模型的最大后验概率(maximum a posteriori, 简称MAP)来推断视频帧的响应值, 具体表示为

| ${y^ * } = \mathop {\arg \max }\limits_{y \in {\mathbb{R}^n}} \Pr (y\left| x \right.)$ | (4) |

能量函数G(y, x)由一元状态函数V和二元转移函数E构成, 这里, V对应于图像中n个超像素块, 旨在回归每个超像素块对应的响应; E依赖于图像中S对相邻超像素块之间的关系, 该关系的相似性会起到约束响应值的作用, 超像素块间的相似度越高, 对应的响应值越接近.这里的函数V和函数E可以表示为

| $\sum\limits_{i \in n} {V({y_i}, x)} = - \sum\limits_{i, l} {{\mu _l}{s_l}({y_i}, x, i)} $ | (5) |

| $\sum\limits_{(i, j) \in S} {E({y_i}, {y_j}, x)} = - \sum\limits_{i, j, k} {{\lambda _k}{t_k}({y_i}, {y_j}, x, i, j)} $ | (6) |

因此, 能量函数G(y, x)可以表示为

| $G(y, x) = \sum\limits_{i \in n} {V({y_i}, x)} + \sum\limits_{(i, j) \in S} {E({y_i}, {y_j}, x)} $ | (7) |

本文将V和E嵌入到统一的CNN框架中, 结合相关滤波建立一个深度网络来得到图片目标候选区的响应值, 从而准确地预测目标的位置信息.

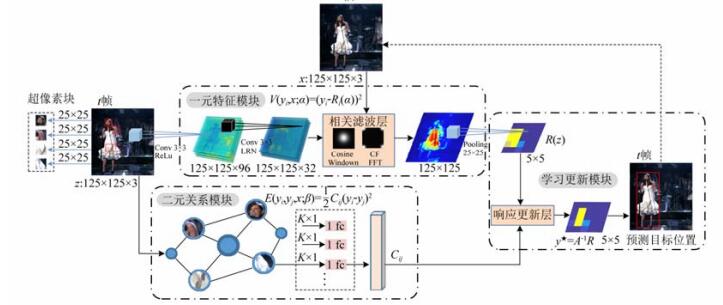

2.2 基于CRF和DCF的深度目标跟踪模型图 3展示了本文提出的基于CRF的深度网络框架, 整个网络架构包括一元特征模块、二元关系模块和学习更新模块3个部分.一元特征模块实现了在深度网络中对图片目标候选区的特征提取, 并且通过相关滤波输出初始响应值; 二元关系模块通过网络输出一组一维向量, 该向量建立了相邻超像素块之间的相似性关系, 用来约束一元特征模块中的初始图片响应; 学习更新模块结合一元特征模块中的初始响应值和二元关系模块中的相似度矩阵更新响应图, 最终确认目标的位置信息.

|

Fig. 3 Improved deep correlation filters via conditional random field 图 3 基于CRF和DCF的深度目标跟踪模型 |

2.2.1 一元特征模块

本文使用一元状态函数V对一元特征模块进行建模, 目的是通过训练深度网络获取图像目标候选区域的特征, 得到理想的滤波器, 输出初始响应.

| $ V({y_i}, x;\alpha ) = {\left( {{y_i} - {R_i}(\alpha )} \right)^2}, ~\forall i = 1, 2, \ldots , n $ | (8) |

这里, yi表示理想状态下的响应, Ri(α)表示网络输出的响应, α为网络中的参数.

如第2.1节所述, 将图像分为n个超像素块, 每个超像素块的区域

| $R(z) = \sum\limits_{l = 1}^D {{\varphi ^l}(z)} \otimes {w^l}$ | (9) |

这里,

| ${w^l} = \frac{{{{\hat \varphi }^l}(x) \odot {{\hat y}^ * }}}{{\sum\nolimits_{i = 1}^D {{{\hat \varphi }^i}(x) \odot {{\left( {{{\hat \varphi }^i}(x)} \right)}^ * } + \lambda } }}$ | (10) |

这里, y表示目标位置的真实值,

本文使用二元转移函数E对二元关系模块进行建模, 目的是为了通过相邻超像素块之间的相似性关系来平滑视频帧的输出响应.

| $E({y_i}, {y_j}, x;\beta ) = \frac{1}{2}{C_{ij}}{({y_i} - {y_j})^2}, \forall i, j = 1, 2, ..., n$ | (11) |

其中, Cij表示相邻超像素块vi和vj之间的依赖关系, 可以用全连接层来表示:

| ${C_{ij}} = {\beta ^T}{[S_{ij}^{(1)}, ..., S_{ij}^{(K)}]^T} = \sum\limits_{k = 1}^K {{\beta _k}} S_{ij}^{(k)}$ | (12) |

这里, β是网络参数, S(k)表示相邻超像素块之间的第k种相似性关系矩阵.可以用位置信息、HOG特征等建立相邻超像素块之间的相似性关系, 本文将这k种相似性关系的模型表示为

| $S_{ij}^{(k)} = \gamma {\left\| {S_i^{(k)} - S_j^{(k)}} \right\|_2}, k = 1, 2, ..., K$ | (13) |

其中,

根据式(8)给出的一元状态函数V和式(11)给出的二元转移函数E的定义, 能量函数G(y, x)可以表示为

| $G(y, x) = \sum\limits_{i \in n} {{{\left( {{y_i} - {R_i}} \right)}^2}} + \sum\limits_{(i, j) \in S} {\frac{1}{2}{C_{ij}}{{({y_i} - {y_j})}^2}} $ | (14) |

为了便于函数表达和计算, 这里定义矩阵A:

| $ A=I+D–C $ | (15) |

其中, I表示n×n的单位阵, D表示由

| $\begin{array}{l} G(y, x) &= ({y^T}Iy - 2{R^T}y + {R^T}R) + \frac{1}{2}\sum\limits_i {\sum\limits_j {{C_{ij}}} } (y_i^2 - 2{y_i}{y_j} + y_j^2) \\ & = {y^T}Iy - 2{R^T}y + {R^T}R + \frac{1}{2}\sum\limits_i {D(y_i^2 + y_j^2) - \sum\limits_i {\sum\limits_j {{C_{ij}}} } } {y_i}{y_j} \\ & = {y^T}Ay - 2{R^T}y + {R^T}R \\ \end{array} $ | (16) |

由于上式中关于y的二次项系数是矩阵A, 这里的A是正定阵, 结合均值θ服从先验norm分布, 且θ~N(μ0, Σ0)的多维高斯分布的公式为

| $P(\theta ) = {(2\pi )^{ - \frac{n}{2}}} \cdot {\left| {{\Sigma _0}} \right|^{ - \frac{1}{2}}} \cdot \exp \left\{ { - \frac{1}{2}{{\left( {\theta - {\mu _0}} \right)}^T}{\Sigma _0}^T\left( {\theta - {\mu _0}} \right)} \right\}$ | (17) |

规范化因子Z(x)的积分可推算得到:

| $\begin{array}{l} Z(x) &= \int_y {\exp } \left\{ { - G(y, x)} \right\}{\text{d}}y \\ &= \exp ( - {R^T}R)\int_y {\exp } \left\{ { - {y^T}Ay + 2{R^T}y} \right\}{\text{d}}y \\ & = \frac{{{{({{\pi }})}^{\frac{n}{2}}}}}{{{{\left| A \right|}^{\frac{1}{2}}}}}\exp ({R^T}{A^{ - 1}}R - {R^T}R) \\ \end{array} $ | (18) |

根据式(1)、式(16)和式(18), 推出CRF的先验概率模型可以表示为

| $\begin{array}{l} \Pr (y\left| x \right.) &= \frac{1}{{Z(x)}}\exp \left\{ { - G(y, x)} \right\} \\ &= \frac{{\exp ( - {y^T}Ay + 2{R^T}y - {R^T}R)}}{{\frac{{{{({{\pi }})}^{\frac{n}{2}}}}}{{{{\left| A \right|}^{\frac{1}{2}}}}}\exp ({R^T}{A^{ - 1}}R - {R^T}R)}} \\ &= \frac{{{{\left| A \right|}^{\frac{1}{2}}}}}{{{{({{\pi }})}^{\frac{n}{2}}}}}\exp ( - {y^T}Ay + 2{R^T}y - {R^T}{A^{ - 1}}R) \\ \end{array} $ | (19) |

这里, R=[R1, ..., Rn]T, 是在初始响应的基础上做池化后得到的矩阵, |·|表示矩阵的行列式, A–1是A的逆矩阵.因此, 根据式(4)可以得到图像中目标候选区域的响应值为

| $\begin{array}{l} {y^ \star }& = \mathop {\arg \max }\limits_y \log \Pr (y\left| x \right.) \\ & \mathop { = \arg \max }\limits_y - {y^T}Ay + 2{R^T}y \\ \end{array} $ | (20) |

根据式(15)中对矩阵A的定义, 矩阵A是对称阵, 即AT=A, 令:

| $\left. \begin{array}{l} \frac{{\partial ( - {y^T}Ay + 2{R^T}y)}}{{\partial y}} = 0 \hfill \\ \Rightarrow - (A + {A^T})y + 2R = 0 \hfill \\ \Rightarrow y = {A^{ - 1}}R \hfill \\ \end{array} \right\}$ | (21) |

因此, 式(20)的闭式解为

| $ y^★=A^{–1}R $ | (22) |

当不考虑二元关系模块中相邻超像素块之间的关系时, 即Cij=0时, 上式可以表示为y★=R, 这是一般的CNN回归模型, 本文将其作为比较的基准算法, 在第3节会对比这种模型的实验结果.

本文算法将矩阵A定为位置关系矩阵, 根据第2.2.1节中对超像素块区域的定义, 利用相邻超像素块vi={ai, bi, wi, hi}和vj={aj, bj, wj, hj}之间的欧式距离建立的相似性关系Cij和度矩阵D可以表示为

| ${C_{ij}} = {\text{d}}({S_i}, {S_j}) = \sqrt {{{({a_i} - {a_j})}^2} + {{({b_i} - {b_j})}^2}} $ | (23) |

| ${D_{jj}} = \sum\nolimits_i {\sqrt {{{({a_i} - {a_j})}^2} + {{({b_i} - {b_j})}^2}} } $ | (24) |

根据式(15)将矩阵A带入式(22)可以更新初始响应矩阵, 校正目标的位置信息, 得到校正后的响应y★, 从而确定目标的位置, 具体流程详见算法1.

算法1. 基于条件随机场的鲁棒性深度相关滤波目标跟踪算法.

输入: 视频帧序列Fn={I1, I2, ..., In}; 初始帧目标位置{x1, y1, w1, h1};

输出: 预测目标的位置{xt, yt, wt, ht}.

01: FOR t from 1 to n DO

02: IF t=1 THEN

03: 根据{x1, y1, w1, h1}确定目标位置;

04: ELSE

05: 以It–1的目标位置为中心, 在It中剪取目标候选区域图像块z, 利用网络提取该区域的特征φ(z);

06: 根据式(9)使用相关滤波方法计算z的响应R(z);

07: 利用如图 2所示的方法对z做超像素化;

08: 根据式(15)对z中相邻超像素块间的位置信息构建相似度矩阵A;

09: 根据式(22)更新z的响应图y★;

10: 根据y★更新It中目标的位置信息;

11: END IF

12: END FOR

2.3 网络优化本文将CRF和基于深度学习的DCF跟踪网络相结合, 设计了一个新的端到端的网络框架.为了使模型的跟踪效果更优, 算法鲁棒性更强, 本文使用了基于随机梯度下降的反向传播来优化网络参数.

假设通过网络获取的当前帧响应为y★, 理想的响应值为

| $L(\theta ) = {\left\| {{y^ \star } - \tilde y} \right\|^2} + \gamma {\left\| \theta \right\|^2}$ | (25) |

其中, θ表示网络中的所有参数, γ用来约束正则化项.

| $ \left. \begin{array}{l} {y^{^ \star }} = {A^{ - 1}}R, \\ R = {\mathcal{F}^{ - 1}}\left( {\sum\limits_{l = 1}^D {{{\hat w}^{l * }}} \odot {{\hat \varphi }^{l * }}\left( z \right)} \right), \\ {w^l} = \frac{{{{\hat \varphi }^l}(x) \odot {{\hat y}^ * }}}{{\sum\nolimits_{i = 1}^D {{{\hat \varphi }^i}(x) \odot {{\left( {{{\hat \varphi }^i}(x)} \right)}^ * } + \lambda } }} \\ \end{array} \right\} $ | (26) |

根据文献[31], 离散傅里叶变换与离散傅里叶逆变换的梯度可用下述公式计算:

| ${\hat y^ \star } = \mathcal{F}({y^ \star }), \frac{{\partial L}}{{\partial {{\hat y}^ \star }_{}^ * }} = \mathcal{F}\left( {\frac{{\partial L}}{{\partial {y^ \star }}}} \right), \frac{{\partial L}}{{\partial {y^ \star }}} = {\mathcal{F}^{ - 1}}\left( {\frac{{\partial L}}{{\partial {{\hat y}^ \star }_{}^ * }}} \right)$ | (27) |

在学习更新模块中, 前向传播过程只包含一般矩阵乘法, 因此可以计算矩阵的导数:

| $\frac{{\partial L}}{{\partial {{\hat R}^ * }}} = \mathcal{F}\left( {\frac{{\partial L}}{{\partial R}}} \right)$ | (28) |

在二元转移模块中, 由于关系矩阵A可以通过位置信息直接构建, 因此这支网络无需从响应更新层反向传播更新参数.在一元特征模块中, 损失函数对响应更新层的偏导数可以表示为

| $\frac{{\partial L}}{{\partial R}} = \frac{{\partial L}}{{\partial {y^ \star }}}\frac{{\partial {y^ \star }}}{{\partial R}} = {({A^{ - 1}})^T}\frac{{\partial L}}{{\partial {y^ \star }}}$ | (29) |

在该模块中, 网络的输入分别为当前帧图片z和前一帧图片x对应网络的检测分支与学习分支.

| $\frac{{\partial L}}{{\partial {\varphi ^l}(z)}} = {\mathcal{F}^{ - 1}}\left( {\frac{{\partial L}}{{\partial {{\left( {{{\hat \varphi }^l}(z)} \right)}^ * }}}} \right)$ | (30) |

| $\frac{{\partial L}}{{\partial {{\left( {{{\hat \varphi }^l}(z)} \right)}^ * }}} = \frac{{\partial L}}{{\partial {{\hat R}^ * }}}\frac{{\partial {{\hat R}^ * }}}{{\partial {{\left( {{{\hat \varphi }^l}(z)} \right)}^ * }}} = \frac{{\partial L}}{{\partial {{\hat R}^ * }}}({\hat w^l})$ | (31) |

| $\frac{{\partial L}}{{\partial {\varphi ^l}(x)}} = {\mathcal{F}^{ - 1}}\left( {\frac{{\partial L}}{{\partial {{\left( {{{\hat \varphi }^l}(x)} \right)}^ * }}} + {{\left( {\frac{{\partial L}}{{\partial {{\hat \varphi }^l}(x)}}} \right)}^ * }} \right)$ | (32) |

| $\frac{{\partial L}}{{\partial {{\hat \varphi }^l}(x)}} = \frac{{\partial L}}{{\partial {{\hat R}^ * }}}\frac{{\partial {{\hat R}^ * }}}{{\partial {{\hat \varphi }^l}(x)}} = \frac{{\partial L}}{{\partial {{\hat R}^ * }}}\frac{{{{\left( {{{\hat \varphi }^l}(z)} \right)}^ * }{{\hat y}^ * } - {{\hat R}^ * }{{\left( {{{\hat \varphi }^l}(x)} \right)}^ * }}}{{\sum\limits_{k = 1}^D {{{\hat \varphi }^k}(x){{\left( {{{\hat \varphi }^k}(x)} \right)}^ * }} + \lambda }}$ | (33) |

| $\frac{{\partial L}}{{\partial {{\left( {{{\hat \varphi }^l}(x)} \right)}^ * }}} = \frac{{\partial L}}{{\partial {{\hat R}^ * }}}\frac{{\partial {{\hat R}^ * }}}{{\partial {{\left( {{{\hat \varphi }^l}(x)} \right)}^ * }}} = \frac{{\partial L}}{{\partial {{\hat R}^ * }}}\frac{{ - {{\hat R}^ * }{{\hat \varphi }^l}(x)}}{{\sum\limits_{k = 1}^D {{{\hat \varphi }^k}(x){{\left( {{{\hat \varphi }^k}(x)} \right)}^ * }} + \lambda }}$ | (34) |

误差经过反向传播到有实值的特征图后, 余下的传播过程可以看作是传统的卷积神经网络优化问题, 这里不再赘述.由于本文算法中反向传播涉及的运算只是复频域中的哈达玛积以及一般的矩阵乘法, 因此可以在大量数据集中进行离线训练, 再通过网络模型进行在线跟踪.

3 实验结果及分析本文算法在Matlab 2015b上实现, 网络层使用MatConvNet工具[32]训练.计算机配置为Intel i7®CoreTM- 4770CPU@3.40GHz×8, 内存为32GB RAM, 显卡为NVIDIA GeForce GTX Titan X.本文的训练视频来源于NUS-PRO[33]、TempleColor128[34]和UAV123[35], 大约共有166 643帧.对于每个视频, 本文选取相邻t–1和t两帧进行配对, 然后将每帧裁剪出以目标位置为中心、1.5倍padding大小的图片块, 并统一成125×125个像素点.学习率γ设为0.072, 目标候选区域padding为2.3.本文利用随机梯度下降的方法更新网络参数, 大约训练了20 epoch.网络测试所选用的数据集为OTB-2013和OTB-2015, 其中, 训练集与测试集无交叉, 包含了各种具有挑战性的场景, 如:目标遮挡、光照变化以及目标快速运动等.本文选取了9种当前国际上具有代表性的相关算法, 分别是DCFNet算法、SRDCF算法、CFNet算法、KCF算法、LCT算法、MEEM算法、Staple算法、SAMF算法、DSST算法, 并将本文算法与这9种算法进行了对比实验.其中, DCFNet算法是基于CNN直接回归图像中目标候选区域响应的一般回归算法, 本文将其作为对比的基准算法.

3.1 定性评估实验图 4给出了5种跟踪算法在数据集中5个视频序列上的部分跟踪结果, 视频按照从左到右、从上到下的顺序分别是carScale(第110、167、183、194帧)、bird2(第49、60、70、75帧)、tiger1(第34、37、39、93帧)、deer(第11、26、28、33帧)、trans(第37、43、50、53帧).其中, 不同的跟踪算法用不同的颜色表示, 红色为本文算法, 左上角的数字为当前图像帧数.通过它们在具体视频序列中的表现, 对结果进行比对和分析后可以发现, 本文提出的算法对目标位置的预测结果是比较理想的.

|

Fig. 4 Qualitative comparision of our approach with other four state-of-the-art trackers 图 4 本文算法与其他4种跟踪算法的部分跟踪结果对比 |

(1) 快速尺度变化:以“CarScale”为例, 目标在跟踪过程中出现了剧烈的尺度变化, 虽然给出的5种算法都能始终跟踪目标, 但是只有本文算法能够很好地适应目标的尺度, 随着目标尺度的变化实现理想跟踪.

(2) 目标平面内/外旋转、目标形变:以“bird2”为例, 目标在跟踪过程中出现了内外旋转变化, 对算法的高度旋转不变性提出了要求, 这里, DCFNet、SRDCF以及KCF跟踪结果都有偏差, 只有本文提出的算法和CFNet方法能够较好地跟踪目标.

(3) 遮挡、光照变化:以“tiger1”为例, 在第34、37和39帧时, 目标被树叶遮挡, 跟踪结果中其他算法都出现了不同程度的跟踪漂移, 只有本文算法对目标遮挡问题具有较好的鲁棒性, 能够始终准确地跟踪目标, 在第93帧时, 背景光照出现了剧烈变化, 除了本文提出的算法和DCFNet方法能够较好地跟踪目标外, 其他算法都偏离了目标.

(4) 运动模糊、低分辨率:以“deer”为例, 这段视频跟踪目标的分辨率较低, 而且小鹿在跳跃中运动出现了模糊, 考验了算法在复杂条件下对目标特征的提取, 在跟踪结果中, DCFNet和KCF都出现了跟踪失败, 本文算法能够始终鲁棒地跟踪目标, 对低分辨率的模糊运动目标具有较好的处理能力.

(5) 快速运动、相似背景:以“trans”为例, 目标在快速运动过程中伴随着与目标相似的背景, 对算法跟踪的准确性具有很大的挑战, 只有本文提出的算法和DCFNet方法能够始终准确地跟踪目标, 而其他算法都出现了不同程度的漂移现象.

3.2 定量分析结果为了综合评价算法的跟踪性能, 本文采用跟踪精度和跟踪成功率这两个通用的评价指标来进行定量分析.其中, 跟踪精度是指当平均中心位置误差小于20像素时, 算法成功跟踪的帧数与视频总帧数的比值; 跟踪成功率是指当覆盖率overlap>0.5时, 算法成功跟踪的帧数与视频总帧数的比值.

在数据集OTB-2013下, 由图 5(a)和图 5(b)可以得到所列10种算法的跟踪精度和跟踪成功率曲线AUC(area under curve)值.由图 5(a)可以看出, 本文算法的精度最高, 达到了0.856, 相比DCFNet算法, 提高了6.1%, 相比CFNet算法, 提高了3.4%;由图 5(b)中的曲线可以看出, 本文算法的跟踪成功率最高, AUC值达到了0.652, 相比DCFNet算法, 提高了3%, 相比CFNet算法, 提高了4.2%.这种跟踪精度和跟踪成功率的明显提升, 是因为本文引入了相邻超像素块之间的相似性关系, 使得响应图更加平滑, 校正了目标位置.

|

Fig. 5 Precision and success plots showing comparisions with state-of-the-art methods on OTB-2013 and OTB-2015 图 5 在OTB-2013和OTB-2015数据集下, 测试序列的成功率曲线和精度曲线 |

在数据集OTB-2015下, 由图 5(c)和图 5(d)中的曲线可以看出, 与所列的9种其他跟踪算法相比, 本文算法的跟踪精度最高, 达到了0.797, 相比DCFNet算法, 提高了4.8%, 相比CFNet算法, 提高了1.7%;跟踪成功率也最高, AUC值达到了0.612, 相比DCFNet算法, 提高了3.5%, 相比CFNet算法, 提高了2.4%, 验证了算法的有效性和鲁棒性.

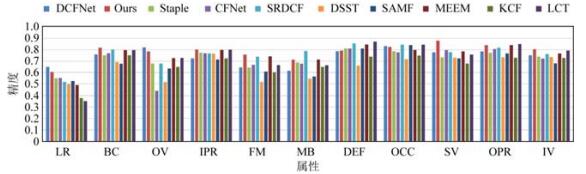

为了进一步分析跟踪算法在不同跟踪条件下的跟踪性能, 表 1和图 6分别给出了10种算法在数据集OTB-2013下11种不同属性的跟踪结果, 包括算法的成功率和跟踪精度.表 1中红色加粗的数字表示最优结果, 蓝色加粗的数字表示次优结果, 黑色加粗的数字表示排名第3的结果, 其中的字母缩写分别表示不同的跟踪条件, 分别是:LR(低分辨率)、BC(背景杂波)、OV(目标超出视野)、IPR(平面内旋转)、FM(快速运动)、MB(运动模糊)、DEF(目标形变)、OCC(目标遮挡)、SV(尺度变化)、OPR(平面外旋转)、IV(光照变化).

| Table 1 Success score of average AUC for each attribute on OTB-2013 表 1 不同属性下算法在OTB-2013中的跟踪成功率对比结果 |

|

Fig. 6 Precision score at 20 pixels for 11 attributes on OTB-2013 图 6 OTB-2013中11种属性下算法的跟踪精度对比结果 |

由表 1和图 6可以看出, 在11种不同属性的跟踪条件中, 除了DEF属性, 本文算法的成功率和跟踪精度在其他属性中均处于最优或次优的位置, 尤其是在SV属性下, 成功率达到了0.664, 比第2名的DCFNet高了4.5%, 比第3名的SRDCF高了7.7%, 展现了本文算法在目标尺度变化上的跟踪优势, 同时也表明了对于其他复杂条件下的跟踪, 本文算法也具有较好的鲁棒性.

3.3 算法跟踪速率评估表 2给出了各种算法在OTB-2013和OTB-2015这两个数据集上的平均视频跟踪速率(单位为fps).可以发现, 本文算法的跟踪速度与DCFNet相近, 比CFNet高约14帧/s左右, 这是因为在滤波器的在线更新过程中, 通过向量的傅里叶变换和点积运算取代了时域的卷积运算, 同时避开了矩阵求逆, 将原先矩阵相乘O(n3)的计算量转换为了傅里叶变换nlog(n)和向量点乘n, 极大地提高了滤波器的训练速度.

| Table 2 Tracking speed for OTB-2013 and OTB-2015 compared with baseline methods 表 2 各种算法在OTB-2013和OTB-2015数据集上的平均视频跟踪速度 |

总体来说, 本文算法在基于深度学习的跟踪算法中, 跟踪速率较快, 可以实现跟踪的实时性要求.

4 结论本文将连续CRF模型运用到目标跟踪领域中, 将一元状态函数与二元转移函数嵌入到深度卷积神经网络中, 设计了一个端到端的框架.该算法通过结合一元状态函数得到的初始响应图和二元转移函数得到的相似度矩阵对目标位置进行校正, 从而得到了一个更平滑、更精确的响应图, 提高了跟踪的精度.本文在OTB-2013和OTB-2015这两个数据集上进行了大量的测试, 在复杂的跟踪条件下, 与近年来9种在国际上具有代表性的相关算法进行了对比分析, 实验结果表明, 优化后的算法不仅得到了精度高、鲁棒性好的跟踪结果, 同时也较好地解决了跟踪过程中的各类复杂状况, 有效地提高了目标跟踪的成功率.

在今后的工作中, 我们将会继续研究由相邻超像素块之间依赖关系构建的相似度矩阵, 并且进一步优化各类参数, 从而校正目标位置的响应, 提高算法的鲁棒性.

| [1] |

Henriques JF, Rui C, Martins P, et al. High-speed tracking with kernelized correlation filters. IEEE Trans. on Pattern Analysis & Machine Intelligence, 2014, 37(3): 583-596.

http://cn.bing.com/academic/profile?id=22a95188d7f3b68216fa40f016abc7d9&encoded=0&v=paper_preview&mkt=zh-cn |

| [2] |

Li Y, Zhu J. A scale adaptive kernel correlation filter tracker with feature integration. In: Proc. of the European Conf. on Computer Vision Workshops. 2014, 8926: 254-265. https://link.springer.com/chapter/10.1007%2F978-3-319-16181-5_18

|

| [3] |

Ma C, Yang X, Zhang C, et al. Long-term correlation tracking. In: Proc. of the Computer Vision and Pattern Recognition. 2015. 5388-5396. https://www.researchgate.net/publication/304555000_Long-term_correlation_tracking

|

| [4] |

Hong Z, Chen Z, Wang C, Mei X, Prokhorov D, Tao D. MUlti-store tracker (MUSTer): A cognitive psychology inspired approach to object tracking. In: Proc. of the 2015 IEEE Conf. on Computer Vision and Pattern Recognition (CVPR). 2015. 749-758.[doi: 10.1109/CVPR.2015.7298675]

|

| [5] |

Mueller M, Smith N, Ghanem B. Context-aware correlation filter tracking. In: Proc. of the 2017 IEEE Conf. on Computer Vision and Pattern Recognition (CVPR). 2017. 1387-1395.[doi: 10.1109/CVPR.2017.152]

|

| [6] |

Danelljan M, Häger G, Khan FS, Felsberg M. Convolutional features for correlation filter based visual tracking. In: Proc. of the IEEE Int'l Conf. on Computer Vision Workshop. IEEE Computer Society, 2015. 621-629. https://www.researchgate.net/publication/304407698_Convolutional_Features_for_Correlation_Filter_Based_Visual_Tracking

|

| [7] |

Ma C, Huang JB, Yang X, Yang MH. Hierarchical convolutional features for visual tracking. In: Proc. of the IEEE Int'l Conf. on Computer Vision. 2015. 3074-3082. https://www.researchgate.net/publication/285228356_Hierarchical_Convolutional_Features_for_Visual_Tracking

|

| [8] |

Bertinetto L, Valmadre J, Henriques JF, Vedaldi A, Torr PHS. Fully-convolutional siamese networks for object tracking. In: Proc. of the European Conf. on Computer Vision. 2016. 850-865.

|

| [9] |

Valmadre J, Bertinetto L, Henriques J, Vedaldi A, Torr PHS. End-to-end representation learning for correlation filter based tracking. In: Proc. of the 2017 IEEE Conf. on Computer Vision and Pattern Recognition (CVPR). 2017. 5000-5008. https://www.researchgate.net/publication/320971954_End-to-End_Representation_Learning_for_Correlation_Filter_Based_Tracking

|

| [10] |

Wang Q, Gao J, Xing J, Zhang M, Hu W. DCFNet: Discriminant correlation filters network for visual tracking. 2017. https://www.researchgate.net/publication/316098189_DCFNet_Discriminant_Correlation_Filters_Network_for_Visual_Tracking

|

| [11] |

Wu Y, Lim J, Yang MH. Object tracking benchmark. IEEE Trans. on Pattern Analysis & Machine Intelligence, 2015, 37(9): 1834-1848.

http://d.old.wanfangdata.com.cn/Periodical/nyjxxb201711005 |

| [12] |

Bolme DS, Beveridge JR, Draper BA, Lui YM. Visual object tracking using adaptive correlation filters. In: Proc. of the 23rd IEEE Conf. on Computer Vision and Pattern Recognition, CVPR 2010. 2010. 2544-2550. https://www.researchgate.net/publication/221362729_Visual_object_tracking_using_adaptive_correlation_filters

|

| [13] |

Henriques JF, Rui C, Martins P, et al. Exploiting the circulant structure of tracking-by-detection with kernels. In: Proc. of the European Conf. on Computer Vision. 2012. 702-715. https://link.springer.com/chapter/10.1007%2F978-3-642-33765-9_50

|

| [14] |

Danelljan M, Hager G, Khan FS, Felsberg M. Discriminative scale space tracking. IEEE Trans. on Pattern Analysis & Machine Intelligence, 2016, 39(8): 1561-1575.

http://d.old.wanfangdata.com.cn/NSTLHY/NSTL_HYCC0213108266/ |

| [15] |

Bertinetto L, Valmadre J, Golodetz S, Miksik O, Torr PHS. Staple: Complementary learners for real-time tracking. In: Proc. of the Int'l Conf. on Computer Vision and Pattern Recognition (CVPR). 2016. 1401-1409. http://www.oalib.com/paper/4016386

|

| [16] |

Danelljan M, Khan FS, Felsberg M, Weijer J. Adaptive color attributes for real-time visual tracking. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2014. 1090-1097. https://www.researchgate.net/publication/286593879_Adaptive_Color_Attributes_for_Real-Time_Visual_Tracking

|

| [17] |

Danelljan M, Häger G, Khan FS, Felsberg M. Learning spatially regularized correlation filters for visual tracking. In: Proc. of the IEEE Int'l Conf. on Computer Vision. 2015. 4310-4318.

|

| [18] |

Krizhevsky A, Sutskever I, Hinton GE. ImageNet classification with deep convolutional neural networks. In: Proc. of the Int'l Conf. on Neural Information Processing Systems. Curran Associates Inc., 2012. 1097-1105. https://www.researchgate.net/publication/267960550_ImageNet_Classification_with_Deep_Convolutional_Neural_Networks

|

| [19] |

He K, Zhang X, Ren S, Sun J. Deep residual learning for image recognition. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2016. 770-778. http://www.oalib.com/paper/4016438

|

| [20] |

Ren S, Girshick R, Girshick R, Sun J. Faster R-CNN:Towards real-time object detection with region proposal networks. IEEE Trans. on Pattern Analysis & Machine Intelligence, 2017, 39(6): 1137-1149.

http://cn.bing.com/academic/profile?id=89bacd206ab7340f74ac7e7ea03ff929&encoded=0&v=paper_preview&mkt=zh-cn |

| [21] |

Sun W, Wang R. Fully convolutional networks for semantic segmentation of very high resolution remotely sensed images combined with DSM. IEEE Geoscience & Remote Sensing Letters, 2018, PP(99): 1-5.

http://cn.bing.com/academic/profile?id=e915d325d94d0f9c0b03855f391eeb7e&encoded=0&v=paper_preview&mkt=zh-cn |

| [22] |

Qi Y, Zhang S, Qin L, Lim J, Yang MH. Hedged deep tracking. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2016. 4303-4311.

|

| [23] |

Lafferty J, McCallum A, Pereira F. Conditional random fields: Probabilistic models for segmenting and labeling sequence data. In: Proc. of the 18th Int'l Conf. on Machine Learning. 2001. 282-289. https://www.researchgate.net/publication/2529190_Conditional_Random_Fields_Probabilistic_Models_for_Segmenting_and_Labeling_Sequence_Data

|

| [24] |

Qin T, Liu TY, Zhang XD, Wang DS, Li H. Global ranking using continuous conditional random fields. In: Proc. of the Conf. on Neural Information Processing Systems. Vancouver, 2008. 1281-1288.

|

| [25] |

Ristovski K, Radosavljevic V, Vucetic S, Obradovic Z. Continuous conditional random fields for efficient regression in large fully connected graphs. In: Proc. of the AAAI Conf. on Artificial Intelligence. 2013. 840-846. https://www.researchgate.net/publication/288411174_Continuous_Conditional_Random_Fields_for_efficient_regression_in_large_fully_connected_graphs

|

| [26] |

Radosavljevic V, Vucetic S, Obradovic Z. Continuous conditional random fields for regression in remote sensing. In: Proc. of the European Conf. on Artificial Intelligence. 2010. 809-814. https://www.researchgate.net/publication/258544095_Gaussian_conditional_random_fields_for_regression_in_remote_sensing

|

| [27] |

Liu F, Shen C, Lin G. Deep convolutional neural fields for depth estimation from a single image. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2015. 5162-5170. https://www.researchgate.net/publication/268747978_Deep_Convolutional_Neural_Fields_for_Depth_Estimation_from_a_Single_Image

|

| [28] |

Li H. The Method of Statistical Learning. Beijing: Tsinghua University Press, 2012.

|

| [29] |

Wang X, Shrivastava A, Gupta A. A-fast-RCNN: Hard positive generation via adversary for object detection. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2017. 3039-3048.

|

| [30] |

Danelljan M, Hager G, Khan FS, Felsberg M. Accurate scale estimation for robust visual tracking. In: Proc. of the British Machine Vision Conf. 2014.

|

| [31] |

Boeddeker C, Hanebrink P, Drude L, Heymann J, Haeb-Umbach R. On the computation of complex-valued gradients with application to statistically optimum beamforming. Technical Report, Department of Communications Engineering, Institute for Electrical Engineering and Information Technology, Paderborn University, 2017.

|

| [32] |

Hong S, You T, Kwak S, Han B. Online tracking by learning discriminative saliency map with convolutional neural network. In: Proc. of the Int'l Conf. on Machine Learning. 2015. 597-606.

|

| [33] |

Li A, Lin M, Wu Y, Yang MH, Yan S. NUS-PRO:A new visual tracking challenge. IEEE Trans. on Pattern Analysis & Machine Intelligence, 2016, 38(2): 335-349.

http://d.old.wanfangdata.com.cn/Periodical/nyzhyj201501022 |

| [34] |

Liang P, Blasch E, Ling H. Encoding color information for visual tracking:Algorithms and benchmark. IEEE Trans. on Image Processing, 2015, 24(12): 5630-5644.

[doi:10.1109/TIP.2015.2482905] |

| [35] |

Mueller M, Smith N, Ghanem B. A benchmark and simulator for UAV tracking. Far East Journal of Mathematical Sciences, 2013, 2(2): 445-461.

http://cn.bing.com/academic/profile?id=8f5e16c682dda504fca20994331083a8&encoded=0&v=paper_preview&mkt=zh-cn |

| [28] |

李航. 统计学习方法. 北京: 清华大学出版社, 2012.

|

2019, Vol. 30

2019, Vol. 30