当前, 计算机视觉领域的核心研究包括图像分类、物体检测和图像语义分割(image semantic segmentation, 简称ISS)等, 其中, ISS是一门涉及计算机视觉、模式识别与人工智能等研究领域的交叉学科, 是数字图像处理与机器视觉的研究重点.ISS在虚拟现实、工业自动化、视频检测等不同领域有广泛的应用, 具有重要的研究意义和应用价值.ISS由Ohta等人首次提出, 其定义是:为图像中的每一个像素分配一个预先定义好的表示其语义类别的标签[1].与传统的图像分割相比, ISS在其基础上为图像中的目标或前景加上一定的语义信息, 能够根据图像本身的纹理、场景和其他高层语义特征来得出图像本身需要表达的信息, 更具实用价值.近年来, 国内外众多科研机构相继开展了针对该领域的学术研究, 人工智能、模式识别以及计算机视觉方面的国内外学术会议都会对该领域和相关研究成果做重点讨论.这些机构和组织有效地推动了ISS技术的发展.

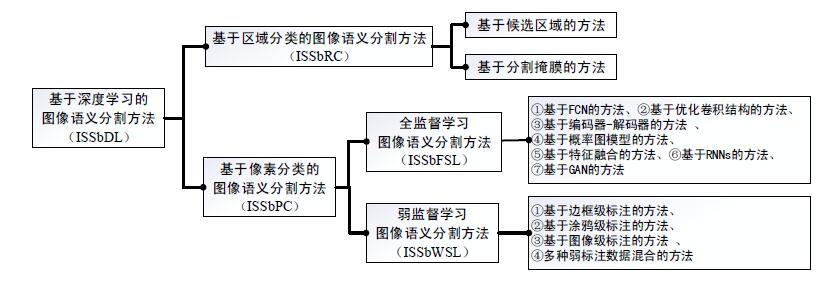

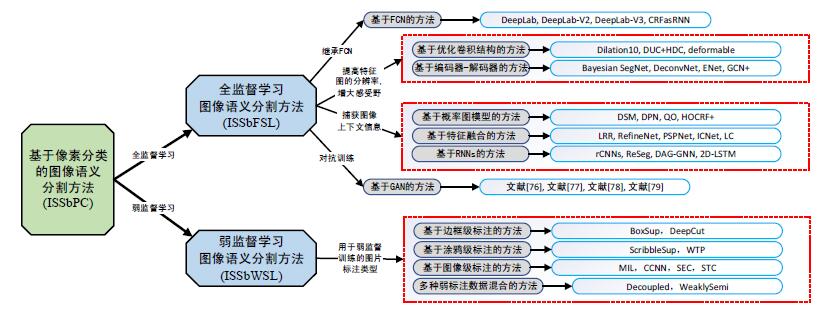

近年来, 深度学习(deep learning, 简称DL)技术[2]迅猛发展, 基于深度学习的图像语义分割方法(image semantic segmentation based on deep learning, 简称ISSbDL)也日新月异.鉴于目前国内还没有全面细致论述ISSbDL方法的综述文献[3, 4], 我们总结并整理了相关研究后得到本文.如图 1所示, 按照ISS的方法特点和处理粒度, 将ISSbDL方法分为基于区域分类的图像语义分割方法(ISS based on the regional classification, 简称ISSbRC)和基于像素分类的图像语义分割方法(ISS based on the pixel classification, 简称ISSbPC), 对每类方法按照处理特点又细分为若干种不同的子方法.

|

Fig. 1 A taxonomy of ISSbDL 图 1 基于深度学习的图像语义分割方法分类 |

本文第1节介绍DL与ISS的相关背景及ISSbDL的早期研究.第2节对ISSbRC方法进行详细介绍和总结.第3节对ISSbPC方法进行分析和总结, 并根据处理特点进一步分类, 详细介绍每类子方法的基本思想和优缺点.第4节对ISS相关实验进行分析与比较, 并介绍常用公共数据集和算法性能评价指标.第5节总结讨论ISS未来的发展方向和发展趋势.

1 相关背景及早期研究介绍DL的概念由Hinton等人[2]在2006年首次提出, 是机器学习中一种基于对数据进行表征学习的方法.DL技术能够有效地提取图像中的低级、中级和高级语义信息, 并结合分类器辅助进行像素分类, 提高了ISS方法的分割准确率.目前, 主流的DL模型有卷积神经网络(convolutional neural network, 简称CNN)[5]、循环神经网络(recurrent neural network, 简称RNN)[6]和生成对抗网络(generative adversarial network, 简称GAN)[7]等.

其中, CNN的基本结构由输入层、卷积层、池化层、全连接层及输出层组成.输入图像经过CNN多个卷积操作和池化操作进行特征提取, 将低层粗糙特征逐步转变为高层精细特征, 高层特征再经过全连接层和输出层后进行分类.CNN由于其特殊的网络结构, 特别适合处理图像数据, 对平移、伸缩、倾斜等图像形变具有较高的不变性.RNN由一连串重复的神经网络模块序列组成, 序列中的每个元素都执行相似的任务, 图像上下文(image context)之间的连续信息可合理利用.当前, 具有代表性的RNN包括传统的RNN序列模型、长短期记忆神经网络(long short-term memory, 简称LSTM)[8]以及门控递归单元(gated recurrent unit, 简称GRU)[9].GAN由一个生成器网络(generator network)和一个判别器网络(discriminator network)组成, 其基本思想是:从训练库中获取大量训练样本进行学习, 生成器网络不断产生人造样本, 判别器网络不断对人造样本进行判断, 训练时, 让两组网络相互对抗、相互提高.

在ISS领域, CNN因其高效的学习性能和良好的应用效果, 受到研究者更多的青睐, 成为研究热点.除CNN外, RNN因其递归处理历史信息和建模历史记忆的特点, 特别适合处理与时空序列有关的信息, 也常被一些研究者用于捕获图像上下文信息.此外, GAN模型避免了一些传统生成模型在实际应用中的困难, 具有新颖性和良好的适应性, 在ISS研究中也正逐渐得到重视.总的来说, DL技术利用深层模型来学习图像特征, 促进了ISS领域中相关研究的发展, 掀起了一股ISSbDL的研究热潮.

2013年, 文献[10]尝试使用DL技术对室内场景进行语义分割:利用CNN对RGB-D图像进行特征提取的同时, 将RGB图像聚类得到超像素, 然后使用分类器对超像素进行分类, 完成ISS任务.文献[11]则在上述工作的基础上, 利用深层CNN提取、整合不同分辨率图像的特征, 并使用分割树对粗糙图像块中的超像素进行平滑预测处理.这些早期的ISSbDL方法[10, 11]出现在ISS由传统的机器学习方式向深度学习方式过渡的阶段, 先使用聚类操作生成超像素, 再用CNN等分类器对超像素进行分类.图像分割过程分阶段进行, 耗时、费力, 分割过程无法有效利用图像的全局语义特征, 分割结果比较粗糙.

随着DL技术的发展, 研究者又进一步改进, 先将图像划分为一系列目标候选区域, 再用DL技术对目标区域进行分类, 避免生成超像素, 提高了分割效率, 本文第2节所介绍的基于区域分类的图像语义分割方法即为此类改进.另一些研究者则直接利用深度神经网络(deep neural network, 简称DNN)以像素分类的方式进行分割, 将分割过程改为端到端(end-to-end)的模式, 避免了预先生成图像块所带来的问题, 提高了分割准确率, 本文将在第3节中介绍这类基于像素分类的图像语义分割方法.基于这些改进, 我们将ISSbDL的处理流程概括为特征提取、语义分割和后期处理这3个核心步骤, 如图 2所示, 其中, 实线表示一般处理步骤, 虚线表示选择使用环节.

|

Fig. 2 Workflow for ISSbDL 图 2 基于深度学习的图像语义分割方法的一般处理流程 |

2 基于区域分类的图像语义分割方法

在ISSbDL方法中, 基于区域分类的图像语义分割方法把传统图像处理算法与DNN相结合, 先将原始图像划分成不同的目标候选区域, 得到一系列图像块(image patch), 再利用DNN对图像块或图像块中的每个像素进行语义分类, 最后根据分类结果对原始图像进行标注, 得到最终分割结果.因为图像块的质量直接决定分割结果的好坏, ISSbRC方法的关键在于如何从原始图像产生不同目标区域的图像块.根据区域生成算法和图像块划分标准不同, 下面将ISSbRC方法划分为两类:基于候选区域的方法和基于分割掩膜的方法.表 1对这两类方法从方法特点、优缺点和处理流程等几个方面进行了分析与比较.下面对其进行详细介绍.

| Table 1 Comparison of ISSbRC 表 1 基于区域分类的图像语义分割方法对比 |

2.1 基于候选区域的方法

该类方法首先利用相应的算法生成大量候选区域并筛选出合理的候选区域, 再运用CNN对每个候选区域提取图像特征和语义信息, 接着利用分类器对候选区域中的图像块或像素进行分类, 最后输出分割结果.因为每个候选区域都有可能包含图像中潜在的目标物体, 候选区域的质量不但影响CNN捕获图像特征的能力, 而且影响分类器对候选区域进行分类的精度.

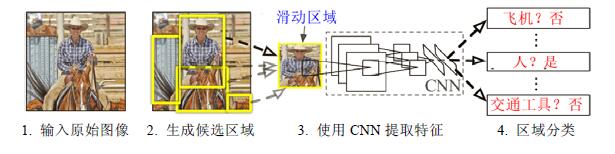

2014年, 文献[12]在CNN的基础上提出了区域卷积神经网络(regions with CNN features, 简称RCNN). RCNN将选择搜索(selective search, 简称SS)算法产生的候选区域与CNN产生的视觉特征相结合, 可同时完成目标检测和ISS两项任务.RCNN的处理流程如图 3所示, 首先, 使用SS算法抽取约2 000个候选区域; 再用CNN提取每个候选区域的特征; 最后, 根据捕获的特征, 使用SVM(support vector machine)对每个候选区域中的目标物体分类.但RCNN也存在严重依赖候选区域、产生图像变形、分割精确度不够高和速度不够快等缺点, 其综合性能仍有待提高.

文献[13]在RCNN的基础上提出了SDS(simultaneous detection and segmentation)方法.与RCNN方法相比, SDS方法使用MCG(multi-scale combinatorial grouping)[19]算法在CNN中独立地从候选区域和区域前景中提取特征, 再将这两部分特征进行联合训练, 然后使用非极大值抑制(non-maximum suppression, 简称NMS)算法进行区域增强, 分割性能有显著提升.

由于RCNN存在着生成的候选区域数量过多、网络运算量大且候选区域形状不规则等局限性, 一些研究者开始探索产生高质量候选区域的方法.文献[20]中的SPPNet网络将空间金字塔池化层(spatial pyramid pooling player, 简称SPP player)插入到RCNN卷积层的后面, 减少了特征提取过程中的重复计算.文献[21]中的Fast-RCNN网络将候选区域映射到CNN的卷积特征图上, 通过ROI Pooling层, 将每个候选区域生成固定尺寸的特征图, 提升了生成候选区域的速度.文献[22]中的Faster-RCNN网络在Fast-RCNN网络的基础上加入区域建议网络(region proposal network, 简称RPN), 能够快速生成高质量的候选区域.

2016年, 文献[14]以SDS方法为基础, 使用不同大小的滑动窗口对原图进行卷积、池化等操作, 得到多尺度特征图, 再通过尺度对齐将不同尺度的特征图归一化到同样大小, 并将其做并行处理, 提出了能够完成定位、分类和分割这3个任务的MPA(multi-scale path aggregation)方法[14].MPA方法通过组合不同尺度的特征图, 能够综合图像中多个不同部位的局部信息, 有效地避免了物体理解的歧义, 使分割结果更具鲁棒性.

2017年, 文献[15]在Faster-RCNN基础网络中加入ROI Align层和分割子网, 提出了能够实现目标检测和实例级图像语义分割(即实例分割)两个任务的Mask-RCNN网络.Mask-RCNN由两个分支子网组成:第1个分支子网继承自Faster-RCNN, 用于对候选区域进行分类和回归, 可有效地检测出图像中的目标物体; 第2个分支子网使用一个微型全卷积网络进行高质量的实例分割.Mask-RCNN能够完成分类、回归和分割这3项任务, 并保留目标对象的空间结构信息, 促进了ISS的发展.

2.2 基于分割掩膜的方法基于分割掩膜(segmentation mask)的方法重点关注如何有效生成与目标候选区域相对应的分割掩膜, 大致可分为两个核心步骤.

(1) 首先, 在图像中检测出所有潜在的目标候选对象, 将原图像划分为一系列大小不等的图像块, 每个图像块包含一个潜在的目标候选对象.

(2) 将产生的图像块送入CNN进行处理, 其每个像素经过“是否属于该目标候选对象”的二分类判断后得到分割掩膜, 再将多张分割掩膜进行优化处理得到最终分割结果.

文献[16]基于CNN提出用于生成目标建议(object proposal)的DeepMask模型.该模型直接从原始图像中生成与目标候选对象对应的图像块, 再根据这些图像块为每个目标候选对象生成分割掩膜.DeepMask模型使用前馈网络在整张图像中生成目标对象的分割掩膜, 所产生的掩膜边界粗糙, 不能精准对齐.文献[17]在DeepMask的基础上将浅层网络中的低级特征与深层网络中的高级特征相结合, 并且自下而上进行图像处理, 提出了SharpMask模型.SharpMask模型先通过DeepMask模型对每个输入产生一个粗糙的分割掩膜, 再将该粗糙分割掩膜传入不同的精炼模块, 然后结合不同尺寸的特征图, 以自下而上的方式重新生成精细化的分割掩膜.文献[18]以Fast-RCNN为基础, 提出了MultiPath模型.该模型使用跳跃连接(skip connection)、中心凹区域(foveal region)和一个积分损失函数(integral loss function)对分割掩膜中的对象再次识别并分类, 能够解决物体检测过程中尺度、遮挡和集群等问题, 分割掩膜生成过程中的定位精度有显著提升.

3 基于像素分类的图像语义分割方法ISSbRC方法取得了一定的分割效果, 但也存在图像分割精度不高和分割速度不够快等问题, 因此, 一些研究者提出直接在像素级别上进行图像语义分割, 产生了基于像素分类的图像语义分割方法.ISSbPC方法利用DNN从带有大量标注的图像数据中提取出图像特征和语义信息, 再根据这些信息来学习、推理原始图像中像素的类别, 通过端到端训练的方式对每个像素进行分类, 以像素分类的方式达到语义分割的目标.ISSbPC方法无需产生目标候选区域, 直接为图像中的每个像素进行分类, 原始图像经过一个端到端模型后直接输出分割结果, 是一种从训练数据出发, 贯穿整个模型后直接输出结果的新模式.ISSbPC方法将原始图像、标注图像以及弱标注(weak label)图像等海量数据作为训练样本, 可以捕获更丰富的图像特征, 不仅增加了模型的整体契合度, 而且提高了学习效率, 有效提升了分割准确率.

根据标注类型和学习方式不同, 我们将ISSbPC方法主要分为两类:全监督学习图像语义分割方法(ISS based on fully supervised learning, 简称ISSbFSL)和弱监督学习图像语义分割方法(ISS based on weakly supervised learning, 简称ISSbWSL).ISSbFSL方法使用经过人工精确加工的像素级标注作为训练样本, 其分割流程为:先对图像中的每个像素预先给定一个语义标签得到标注数据, 然后利用标注数据对DNN进行训练, 再将训练好的DNN用于图像语义分割.ISSbWSL方法则使用弱标注数据作为样本对DNN进行训练, 再用训练后的DNN对图像进行语义分割.这两类方法按照改进特点不同又可分为若干类子方法, 其分类示意如图 4所示.下面进行具体介绍和分析.

|

Fig. 4 A taxonomy of ISSbPC 图 4 基于像素分类的图像语义分割方法分类 |

3.1 全监督学习图像语义分割方法

经过人工精确标注的图像样本能够提供大量细节信息和局部特征, 有利于提高网络训练效率和分割精确度, 因此, 目前的ISSbDL方法大多是全监督学习类型.ISSbFSL方法在训练阶段会利用DNN从大量带有像素级标注的图像中提取丰富的视觉特征和语义信息, 再利用这些特征和信息对图像像素进行分类.

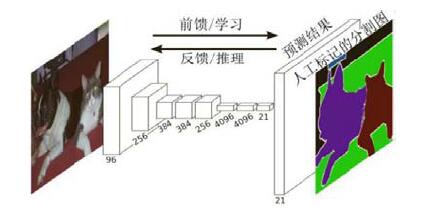

针对早期ISSbRC方法存在的存储开销大、计算效率低等问题, Long等人[23]于2014年设计了一种兼容任意尺寸图像、以全监督学习方式进行图像语义分割的全卷积网络(fully convolutional network, 简称FCN).如图 5所示, FCN在VGG-16网络[24]基础上进行改进, 使用卷积层替换传统CNN中的全连接层, 使用跨层(skip layer)方法组合中间卷积层产生的特征图, 再通过双线性插值(bilinear interpolation, 简称BI)算法进行上采样(upSample), 将粗糙的分割结果转换为细密的分割结果.FCN采用跨层方法, 既同时兼顾全局语义信息和局部位置信息, 又能从抽象特征中恢复出像素所属的类别, 把图像级别的分类进一步延伸到了像素级别的分类, 成功地将原本用于图像分类的网络转变为用于图像分割的网络.

FCN在分割过程中能够恢复像素所属的类别, 极大地推动了ISS的发展.然而该领域仍然存在两个问题:一是图像经过池化操作后, 特征图的分辨率不断降低, 部分像素的空间位置信息丢失; 二是分割过程未能有效地考虑图像上下文(image context)信息, 无法充分利用丰富的空间位置信息, 导致局部特征和全局特征的利用率失衡.FCN未能有效地解决这两个问题, 致使分割结果粗糙、分割边界不连续.针对这两个问题, 在FCN的基础上, 研究者又提出了一系列新方法, 根据这些方法的改进特点不同, 我们将其划分为7类:基于FCN的方法、基于优化卷积结构的方法、基于编码器-解码器的方法、基于概率图模型的方法、基于特征融合的方法、基于RNN的方法和基于GAN的方法.表 2从方法特点、优缺点、关键技术和主要功能这几个方面对这7种方法进行了归纳总结.下面将详细介绍这7类方法.

| Table 2 Comparison of fully-supervised image semantic segmentation algorithm based on pixel classification 表 2 基于像素分类的全监督学习图像语义分割方法对比 |

3.1.1 基于FCN的方法

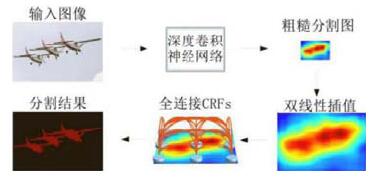

FCN在进行图像语义分割时没有充分考虑像素与像素之间的关系, 缺乏空间一致性, 对图像中的细节不够敏感, 导致分割结果不够精细.文献[25]在FCN的末端增加全连接条件随机场(fully connected conditional random field, 简称FCCRF), 对粗糙分割图进行边界优化, 并使用带孔卷积(atrous convolution)扩大特征图的感受野(receptive field, 简称RF), 提出了DeepLab网络.DeepLab的处理流程如图 6所示, 首先, 将图像送入到结合了Hole算法的FCN中进行处理, 得到粗略的特征图, 再使用BI算法对FCN的输出结果进行上采样操作得到粗糙分割图像; 然后, 使用FCCRF对粗糙分割图像进行结构化预测, 并对图像中的像素点进行建模、求解, 平滑处理粗糙分割图像的边缘; 最后得到一个完整的图像语义分割结果.

2016年, 文献[26]在DeepLab网络的基础上提出了DeepLab-V2网络, 对特征图分辨率变小、定位精度过低等问题进行改进.与DeepLab网络相比, DeepLab-V2网络不仅使用带孔卷积作为上采样滤波器进行稠密特征提取, 而且将带孔卷积与空间金字塔池化方法(spatial pyramid pooling method)[20]相结合后, 提出带孔空间金字塔池化(atrous spatial pyramid pooling, 简称ASPP), 并利用ASPP整合多尺度特征, 最后, 再用FCCRF优化分割图像, 在不增加过多参数的情况下, 增大了感受野、提高了分割精度.

2017年, 文献[27]基于上述两种方法[25, 26]级联多个带孔卷积模块, 并在空间维度上对ASPP进行改进, 提出了Deeplab-V3网络.Deeplab-V3网络以并行方式将4个不同孔洞率(atrous rate)的带孔卷积并联, 组成一个改进版的ASPP, 再以串行方式将多个带孔卷积模块与改进后的ASPP串联在一起, 构成一个端到端处理图像的网络. Deeplab-V3结合串行方式与并行方式的带孔卷积后, 能够多尺度(multiple scale)地分割物体, 获取多尺度的图像信息.实验结果表明, Deeplab-V3在无需加入FCCRF的情况下, 分割准确率仍然优于文献[25, 26]中的方法.

由于文献[25, 26]只是简单地把FCCRF加在FCN的末尾, 需要分别训练FCN和FCCRF, 导致FCN的粗分割操作与FCCRF的精分割操作没有过多的交互联系.文献[28]在文献[25]的基础上提出了CRFasRNN网络, 训练时, 运用BP(back propagation)算法将CRFasRNN网络放在FCN的末尾, 进行端到端处理.CRFasRNN网络的基本思路是:把条件随机场(conditional random field, 简称CRF)的学习、推理、求解等过程迭代建模为RNN的相关运算, 通过迭代mean field算法把该过程嵌入到CNN中, 从而将CNN与CRF的学习过程统一在一个完整的网络中, 提升了分割效果.

3.1.2 基于优化卷积结构的方法在使用CNN进行图像语义分割过程中, 池化操作能够增大特征图的感受野, 并汇合图像的背景信息, 但也带来了特征图分辨率不断降低、部分像素的空间位置信息丢失等问题.一个解决该问题的思路是对神经网络中的卷积结构进行优化, 使用经过优化的卷积结构来代替传统的卷积、池化等操作.

文献[29]对普通的卷积操作进行优化, 从中引入不同的扩张率(dilation rate), 提出了扩张卷积(dilated convolution).扩张卷积是在正常连续的卷积操作中加入不同的间隔, 间隔大小由扩张率决定, 可以在不损失分辨率、不增加计算量的情况下使感受野呈指数增长, 并可捕获图像的多尺度局部特征和保留大部分像素的空间位置信息, 提升了分割准确率.事实上, 这里的扩张卷积也是一种带孔卷积[23], 两类卷积操作的具体结构和计算方式基本一致, 只是名称略有不同.

在ISS过程中, 使用扩张卷积能够更有效地提取图像特征、增加感受野, 并保留一部分像素的空间位置信息.但扩张卷积在操作过程中易产生空间间隙, 会出现信息丢失、信息不相关和局部信息之间的连续性被打断等问题.2017年, 文献[30]使用混合扩张卷积(hybrid dilated convolution, 简称HDC)代替扩张卷积, 并使用稠密上采样卷积(dense upsampling convolution, 简称DUC)替换BI算法.HDC由一系列不同扩张率的扩张卷积模块组成, 既能增加感受野, 又能保持局部信息的相关性, 有效地避免了上述问题.

虽然上述方法[29, 30]可以增加感受野的大小, 但其固定形状的卷积核对几何变换的模拟能力不强, 对图像中一些未知形变的适应性较差, 不利于提取形状不规则物体的特征.文献[31]将带有偏移量的采样操作代替原来位置固定的采样操作, 在卷积处理的作用区域上加入一个可学习的偏移量, 使卷积操作的卷积核具有可变的形状, 提出了可变形卷积(deformable convolution).可变形卷积既能增大感受野的范围, 又有利于DNN学习图像中的感兴趣区域, 增强了ISS过程中对几何变换的适应性, 提高了分割准确率.

3.1.3 基于编码器-解码器的方法在ISS领域, 要解决“池化操作后特征图分辨率不断降低、部分像素空间位置信息丢失”等问题, 除了对卷积结构进行优化外, 另一类方法是使用编码器-解码器(encoder-decoder)结构.该类方法是一种利用对称网络结构进行图像语义解析的机制, 其本质是利用DL技术中的卷积、池化等操作所构成的编码器来编码被捕获的像素位置信息和图像特征, 再利用反卷积(deconvolution)或上池化(unpooling)等操作所构成的解码器来对其进行解析, 还原图像的空间维度和像素的位置信息.

2015年, 文献[59]利用编码器-解码器结构在编码过程中进行下采样(subsampled)操作, 逐步减少特征图的分辨率, 在解码过程则进行上采样(upsampled)操作, 逐步恢复物体细节和图像分辨率, 提出一种对生物医学图像进行语义分割的U-net网络.文献[60]以解决自动驾驶汽车和智能机器人的ISS问题为目标, 提出了SegNet- Basic网络.SegNet-Basic网络基于先验概率计算每个像素点的分类, 是一个类似编码解码过程的对称结构网络, 其基本结构如图 7所示.该网络的左边是一个由全卷积网络构成的编码器, 通过卷积、池化等操作进行下采样处理; 右边是一个由反卷积网络构成的解码器, 利用转置卷积和上池化操作进行上采样处理.针对先验概率无法给出分类结果置信度的问题, 文献[32]基于SegNet-Basic网提出了Bayesian SegNet网络.Bayesian SegNet在每个卷积层后面增加了一个DropOut层, 可有效防止权重过度拟合并增强网络的学习能力; 同时, 还引入贝叶斯网络(Bayesian network)和高斯过程, 基于后验概率计算像素类别, 使网络在ISS过程中能更合理地模拟事件概率.

文献[33]在FCN的基础上提出一个完全对称的DeconvNet网络.该网络用反卷积替换BI算法, 建立了一种完全对称机制; 同时, 将反卷积操作与上池化操作结合起来, 在一定程度上避免了细节丢失和边界模糊等现象, 更好地反映了物体的细节, 提高了分割效果.

文献[32, 33, 60]虽然能够取得较好的分割结果, 但在网络训练中也存在参数权重过多、计算量过大等问题, 导致分割速度难以达到实时处理的要求.2016年, 文献[34]基于编码器-解码器结构提出一种高效神经网络Enet (efficient neural network).ENet在执行分割任务时采用分解滤波器策略, 使用低阶近似(low-rank approximation)将卷积操作分解为更简单的操作, 在保证分割精度的同时, 显著降低了计算量, 是一种可完成像素标注、场景解析等任务的实时分割网络.ENet中编码部分的网络比解码部分复杂很多, 是一种不对称的编码器-解码器结构.

文献[35]使用带有大型卷积核(large kernel)的卷积层代替CNN中的全连接层, 提出了全局卷积网络(global convolution network, 简称GCN).该方法使用ResNet构建编码器, 使用GCN和反卷积构建解码器, 并且网络中加入了用于边界优化的简单残差块, 能够在像素相对集中的小面积区域捕获图像信息, 使得物体的分割边界更清晰、分割准确率更高.

3.1.4 基于概率图模型的方法“未能充分考虑图像的上下文信息, 以及局部特征和全局特征的利用率失衡”是ISS在发展过程中所面临的另一个问题, 而将概率图模型(probabilistic graphical model, 简称PGM)[61]用于CNN的后期处理, 则能有效地捕获图像上下文信息, 并且平衡局部特征与全局特征的利用率.PGM建模时以像素点作为节点, 像素点与像素点之间的概率相关关系作为边.PGM可有效地获取各像素点之间的依赖关系, 捕捉图像全局信息和像素级语义信息, 进而为语义分割过程提供丰富的图像上下文信息.该类方法的处理流程如图 8所示, 先用CNN对原始图像进行特征提取, 得到粗糙分割结果; 再将其送入PGM中用于捕获语义信息和像素依赖关系, 对粗糙分割结果进行边缘细化、精度加工等优化, 从而得到精细化的分割结果.图 8虚线框的内容是使用PGM对图像进行建模的过程.常用的PGM包括马尔可夫随机场(Markov random field, 简称MRF)、条件随机场、贝叶斯网络等.

|

Fig. 8 Workflow for ISS based on PGM 图 8 基于概率图模型的图像语义分割方法的处理流程 |

基于上述思想, 文献[38]引入MRF来捕捉ISS中复杂的上下文信息, 将CNN与MRF结合, 提出一种端到端训练的深度解析网络(deep parsing network, 简称DPN).DPN将高阶关系(highorder relation)、标签信息和语义信息结合在MRF中, 通过CNN中的基础网络层来近似模拟MRF的一元项(unary term), 通过MRF的额外层来近似估计MRF的成对项(pairwise term), 其反向传播过程不需要额外的迭代计算便能够在GPU(graphics processing unit)中进行并行加速处理, 从而减少了计算量, 提高了分割效率.

文献[62]以CRF为基础设计了一个目标团势函数(object clique potential), 提出一个能够有效地检测并分割物体的新模型.文献[36]则综合利用CNN与CRF的优势来探索图像中复杂的上下文信息, 提出一种深度结构化模型(deep structured model, 简称DSM).DSM在建模CRF后, 利用相邻图像块之间的语义关系来捕获“区域-区域上下文(path-path context)”; 通过滑动金字塔池化技术连接由CNN输出的多尺度特征图, 以此来捕获“区域-背景上下文(path-background context)”; 最后, 综合利用两种不同的图像上下文信息进行语义分割, 提高了分割准确率.文献[63]基于上述思想[36], 将CNN与CRF组合在一起用于结构化预测, 直接在消息的传递推理过程中预测消息, 避免了大量计算梯度, 是一种运行速度更快、运算量更小的DSM.文献[37]对传统的CRF改进后将其嵌入到CNN中, 提出一个从粗糙分割到精细分割逐步转变的网络模型.该网络[37]在粗糙分割阶段, 使用FCN提取图像的空间特征后进行特征组合, 再用“语境CRF(context CRF)”重构经过组合的特征; 在精细分割阶段, 用“指导CRF(guidance CRF)”根据输入图像的边界来描绘物体轮廓, 精细化分割对象的边界.

文献[36, 37, 63]在进行图像语义分割后续优化处理时, 只将粗糙分割图像输入CRF的一元项和成对项进行结构化预测, 忽略了对CRF中高阶势能项(higher order potential, 简称HOP)[64]的有效利用, 在捕获全局特征和图像上下文信息时存在一定的不确定性和误差.文献[42]将两种不同的HOP加入到CRF后, 将其与CNN结合, 提出一种新的ISS模型, 避免了上述缺陷.文献[40]设计了一个基于目标检测的HOP和一个基于超像素[65]的HOP, 并将这两种HOP嵌入到CNN中进行端到端训练, 提高了ISS的分割准确率.

文献[41]尝试用高斯条件随机场(Gaussian conditional random field, 简称GCRF)代替传统CRF执行对分割结果的后续优化任务, 通过固定次数的迭代高斯平均场(Gaussian mean field, 简称GMF)提出高斯平均场网络(Gaussian mean fieldnetwork, 简称GMF network), 再将GCRF、GMF network与CNN结合在一起, 共同处理ISS问题, 得到一种端到端语义分割的高斯条件随机场网络(Gaussian conditional random fields network, 简称GCRF network).文献[39]使用CNN分别学习GCRF的一元势函数和二元势函数, 提出一种端到端训练参数的二次优化(quadratic optimization, 简称QO)模型, 提高了ISS后续优化处理的效率.

3.1.5 基于特征融合的方法“利用CRF等概率图模型作为CNN的后期处理”能够有效地捕获图像上下文信息, 提高全局特征的利用率, 但概率图模型方法在学习、推理过程中仍存在计算量过大、训练时间较长、严重消耗内存等缺点.特征融合是整合图像上下文信息并提高全局特征利用率的另一种策略, 基于特征融合的方法主张兼顾图像的全局特征、局部特征以及高、中、底等各层次特征, 通过融合不同层次特征、不同区域特征来捕获图像中隐含的上下文信息, 可有效地避免使用概率图模型导致的问题.

文献[66]将提取的全局特征经过上池化处理后加入到局部特征中, 两种特征融合后获得图像的上下文信息, 再将上下文信息与融合后的特征一起用于下一层网络的处理.文献[43]通过拉普拉斯金字塔(Laplacian pyramid)算法[67]将不同卷积层提取的低层特征进行重构, 提出了LRR(Laplacian pyramid reconstruction and refinement model)模型.LRR模型把特征图表示为一组基函数的线性组合, 使用跨层方法[23]引入边界信息后, 将低层特征与高层特征进行融合, 可有效地捕获图像的上下文信息, 并对粗糙分割结果求精.

文献[48]将原始图像进行尺度变换后并行输入FCN, 并引入注意力模型(attention model)[68], 对不同尺度的目标物体赋予不同的权重, 再分别学习其对应的特征图, 最后, 融合多尺度特征进行像素分类.文献[44]提出一种能够进行多级并行处理的级联式RefineNet网络, 其框架结构如图 9所示.在该网络中, 原始图像首先经过CNN处理得到1/4、1/8、1/16和1/32尺度的4种不同分辨率特征图, 这些特征图再送入与之对应的精细模块(RefineNet block)融合.如此迭代数次, 通过多路径优化处理, 不同层次、不同分辨率的特征图融合得到优化的分割结果.RefineNet中的精细模块由一系列经过残差连接的组件构成, 每个组件对低分辨率特征图进行上采样处理后再融合高分辨率特征图, 可有效整合不同尺度、不同层次的特征, 对图像上下文信息的利用更充分、合理.

文献[45]使用卷积核大小不同的4种CNN来捕捉局部特征和全局特征, 对图像特征进行级联处理, 将多个同一层次的图像特征进行融合, 提出了PSPNet网络.PSPNet的处理流程如图 10所示:图像经过CNN处理后获得粗糙特征图, 然后再通过空间金字塔池化(spatial pyramid pooling)[20]模块对特征图进行级联处理, 将4种不同尺度的特征图进行融合, 得到完整的特征表达, 能够分别获取不同区域的上下文信息, 进一步提升了分割精度.文献[46]基于PSPNet网络, 在兼顾分割精度的同时, 为保证实时性, 提出了能够实时分割的图像级联网络(image cascade network, 简称ICNet).ICNet对不同尺寸的输入图像进行下采样操作, 将低分辨率图片通过整个CNN网络后得到粗糙分割图, 然后利用级联特征融合单元(cascade feature fusion unit, 简称CFF)来融合高分辨率图片的特征, 从而提高分割速度.

|

Fig. 10 Workflow for PSPNet 图 10 PSPNet网络的处理流程 |

文献[47]借鉴文献[69-71]的思想, 使用区域卷积(region convolution)对每个阶段的感兴趣区域进行处理, 而默认忽略其他不感兴趣的区域, 提出了端到端训练的深层级联(deep layer cascade, 简称LC)方法.LC方法具有一定的自适应能力和自主学习能力, 能够将不同复杂度的图像区域分别放在不同深度的网络层进行处理, 可以有针对性地处理不同难易程度的像素.

除上述图像特征融合方式外, 一些学者主张将上一阶段卷积网络提取的图像特征融入到下一阶段卷积网络提取的特征中, 将不同卷积网络提取的不同图像特征进行融合.基于这种思想, 文献[72]在VGG-16网络中加入一系列不同尺度的卷积操作, 从图像中提取出不同尺度的特征信息后, 将上一阶段特征融入下一阶段的特征中进行卷积处理, 设计出一种能够捕获高层和低层特征的多尺度深度卷积神经网络(multi-scale deep convolutional neural network).文献[49]在文献[50]的基础上增加了3个不同尺度的子网络, 采用“先进行联合训练、后进行阶段训练”的策略, 可独立完成深度估计、法向量估计和ISS这3个任务.文献[73]从结构上对上面的多尺度CNN[49, 50]进行改进, 将其扩展为4个子网, 并利用其中一个子网进行粗糙分割, 其余3个子网进行精细分割.文献[74]则在FCN的基础上增加多个不同尺度的卷积层, 提出了多尺度全卷积网络(multi-scale fully convolutional network).

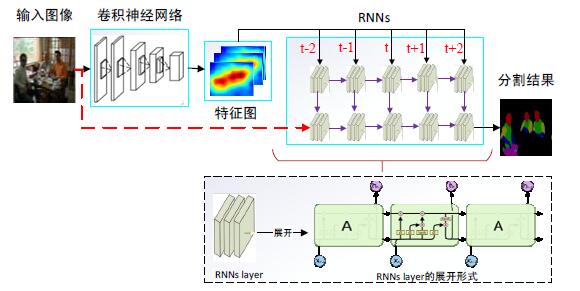

3.1.6 基于RNN的方法针对“无法充分利用图像上下文信息、局部特征和全局特征的利用率失衡”等问题, 另一种解决思路是:利用RNN可递归处理历史信息和建模历史记忆的特点, 在分割图像过程中使用RNN来捕获图像上下文信息和全局特征.RNN不仅可以学习当前时刻的信息, 还可以依赖之前的序列信息, 有利于建模全局内容和保存历史信息, 促进了图像上下文信息的利用.基于RNN的方法进行图像语义分割时, 将RNN layer嵌入到CNN中, 在卷积层提取图像的局部空间特征, 在RNN layer提取像素序列特征.其一般处理流程如图 11所示, 首先, 输入图像经过CNN处理后得到特征图; 然后, 将特征图输入RNN中获取图像上下文信息, 用RNN layer序列化像素、分析各像素的依赖关系后得到全局语义特征, 再使用反卷积层进行上采样处理; 最后, 得到分割结果.

|

Fig. 11 Workflow for ISS based on RNN 图 11 基于循环神经网络的图像语义分割方法处理流程 |

文献[51]借鉴RNN的循环思想, 将泛化后的RNN应用于ISS领域.文献[53]利用DAG(directed acyclic graph)的特性来弥补分割过程中“RNN无法直接应用于UCG(undirected cyclic graph)结构图像”的缺陷, 使RNN能够直接对图像中的每个像素进行分类.文献[52]综合利用CNN与RNN的优点, 使用RNN的衍生网络ReNet处理图片数据, 提出了ReSeg网络.ReSeg使用4个传统的RNN序列模型替代CNN中卷积层的卷积和池化操作, 在水平与垂直两个方向分别切割图像并对其空间依赖关系建模, 其框架结构如图 12所示, 输入图像经过VGG-16网络后得到图像的局部特征, 然后将特征图送入ReNet网络逐步提取出图像的全局特征和上下文信息, 最后使用由反卷积网络组成的上采样层逐步恢复特征图的分辨率, 输出分割结果.同时, ReSeg还使用GRU来平衡内存占用率和计算负载能力, 具有很高的灵活性和适应性.文献[54]用4个不同方向的RNN子网来完成图像标注任务:输入图像被划分为多个非重叠窗口送入4个独立且不同方向的LSTM记忆块, 在没有其他附加条件的情况下, 捕获局部特征和全局特征.文献[75]则利用光度和深度2种不同类型的数据来建模全局特征, 使用LSTM从多种途径获取上下文信息再将其整合到CNN中, 增强了语义特征的表达效果.

传统的RNN序列模型在训练过程中容易出现梯度爆炸或梯度消失等问题, 使用其衍生网络LSTM或GRU配合梯度截断(gradient clipping)、批标准化(batch normalization)等策略则可避免该问题[76, 77].LSTM和GRU利用某些特定的方法来规则遍历二维图像, 图像上下文的关联性可转化为结构化的循环依赖关系, 易于建模像素序列以及图像空间域的依赖关系[52].在利用LSTM或GRU对图像进行建模并将其平滑为像素序列的过程中, 需尽量保存图像的时间序列特征, 并尽量避免丢失其高级语义信息和像素依赖关系, 以提升分割效果[78, 79].

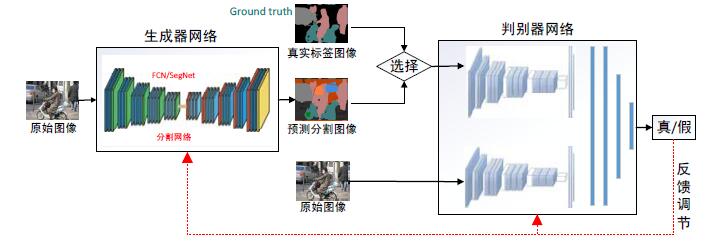

3.1.7 基于GAN的方法“使用带有高阶势能项的CRF进行结构化预测”存在着模型复杂、计算量大、训练时间长、内存占用率高等问题, 此外, HOP也需要预先人工设置, 不易实现.在ISS过程中, 使用GAN代替CRF捕获图像上下文信息, 不但能够避免上述问题, 还可在不增加模型复杂度和训练时间的情况下增加长距离空间标签的连续性, 具有较强的空间一致性.

基于GAN的方法进行图像语义分割时, 基本框架结构如图 13所示.该类方法一般使用FCN, SegNet或PSPNet等分割网络作为生成器网络, 输入图像经过生成器网络处理后得到预测分割图像, 将预测分割图像作为人造样本、真实标签图像(ground truth)作为真实样本输入判别器网络, 判别器网络学习真实样本和人造样本的区别, 并基于博弈思想进行对抗训练.待输出样本数据的真假后, 其内部的反馈机制会对生成器网络与判别器网络进行调节, 经过数次迭代训练后, 生成器网络的分割准确率和判别器网络的鉴别能力不断提高.图 13中, 虚线表示GAN利用判断结果进行反馈微调; 菱形标志表示选择“真实标签图像”或“预测分割图像”两者中的一种作为判别器网络的输入.当判别器网络的输入组合为“原始图像”与“预测分割图像”时, 输出“假”代表正确结果; 当输入组合为“原始图像”与“真实标签图像”时, 输出“真”代表正确结果.

|

Fig. 13 Framework for ISS based on GAN 图 13 基于GAN的图像语义分割方法的基本框架 |

2016年, 文献[55]首次将GAN引入ISS领域, 提出一种图像分割的新方法, 原始图像在由CNN构成的分割网络中转变为分割结果, 分割结果输入对抗网络后被判断出真假, 两组网络进行对抗学习、彼此竞争, 经过迭代训练后, 逐步提高分割网络的分割准确率.文献[56]基于FCN, 将GAN与领域适应性(domain adaptation)思想结合, 将源域与目标域共享标记空间, 并通过最优化目标损失函数来减少全局偏移和特定偏移的影响, 提出用于ISS的领域适应性框架.文献[57]通过GAN来实现分割网络的参数规则化, 使用未进行标注的图像训练分割网络(生成器网络).文献[58]则利用条件生成对抗网络(conditional generative adversarial network, 简称CGAN)[80]产生人造样本进行对抗训练.

GAN模型拥有不断生成数据和辨别数据真假的能力, 在一定程度上可减少CNN、FCN等网络在图像语义分割过程中带来的问题.同时, GAN引入判别器来解决数据域分布不一致问题, 通过对抗学习来近似不可解的损失函数, 具有较好的分割效果[81].但GAN模型的优化过程不稳定, 训练时容易坍缩到一个鞍点上, 在处理大规模图像数据时, 其可解释性和延展性有待提高[82].

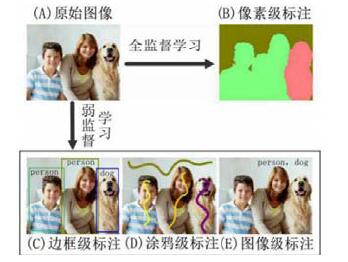

3.2 弱监督学习图像语义分割方法利用CNN、FCN等神经网络进行全监督学习的分割方法在ISS领域获得了较好的效果, 但ISSbFSL方法在训练阶段所需要的像素级精确标注图像制作过程费时、费力, 难以大批量获取.因此, 一些学者开始研究以弱监督学习的方式进行图像语义分割, 形成了一系列的ISSbWSL方法.ISSbWSL方法使用经过粗略标记的弱标注图像进行训练, 减少了标注时间和标注成本.在ISS领域, 目前常见的弱标注数据大致有图像级标注、边框级标注和涂鸦级标注.如图 14所示, 边框级标注泛指一些人工标记的边界框(bounding box), 涂鸦级标注泛指一些人工随机涂鸦的点或线条, 图像级标注则把图像中的物体种类标签作为标注.

|

Fig. 14 Examples of different image labeling 图 14 不同类型的图像标注示例 |

与像素级标注数据相比, 弱标注数据无需过多人工操作, 更容易获取.根据弱标注数据的不同类型, 我们将ISSbWSL方法分为4类:基于边框级标注的方法、基于涂鸦级标注的方法、基于图像级标注的方法和多种弱标注数据混合的方法.下面进行详细介绍.

3.2.1 基于边框级标注的方法在ISSbWSL领域, 基于边框级标注的方法使用边框级标注图像作为训练样本.与ISSbFSL方法相比, 该类方法在标注边界框过程中时间成本较低, 可节省大量人力物力; 同时, 其分割性能与同等条件下的全监督学习方法近似.

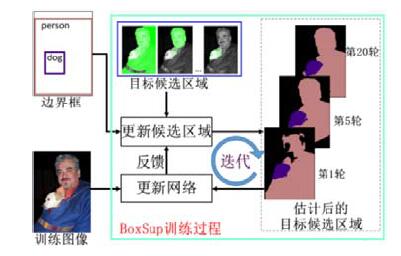

文献[83]以FCN为基础网络, 用边框级标注的图像作为训练样本, 通过循环迭代方式不断提高分割准确率, 提出了BoxSup网络.BoxSup的框架结构如图 15所示, 首先, 用MCG算法[19]得到初步的目标候选区域; 然后, 将该目标候选区域作为已知的监督信息输入到FCN中进行优化和更新; 待FCN输出具有更高精度的候选区域后, 再将输出的目标候选区域又重新输入FCN中进行训练.如此重复迭代, 直到准确率收敛.文献[84]在GrabCut算法[85]的基础上加入CRF和CNN, 提出了DeepCut方法.DeepCut使用边框级标注的图像作为训练样本, 通过在CNN中进行迭代训练, 逐步提高图像的分割精度.

|

Fig. 15 Framework for BoxSup 图 15 BoxSup网络的框架结构 |

3.2.2 基于涂鸦级标注的方法

基于涂鸦级标注的方法使用涂鸦级标注的图像作为训练样本, 分割过程较为简单, 训练样本易于获取, 降低了人工标注的工作量.

文献[86]用多个像素标注图像中的物体, 提出了用随机涂鸦的点作为监督信息的点监督(point supervision)方法.该方法将监督信息与CNN模型中的损失函数相结合, 取得了较好的分割效果.文献[87]使用涂鸦方式进行图像标注, 将带有涂鸦线条的图像作为训练样本, 提出了ScribbleSup方法.ScribbleSup方法分为自动标记阶段和图像训练阶段:自动标记阶段首先根据涂鸦线条对图像生成像素块, 然后将每个像素块作为图模型中的一个节点, 再用GraphCut算法建模自动完成对所有训练图像的标注; 图像训练阶段则是将上一阶段完成的标注图像送入FCN中训练, 得到分割结果.

3.2.3 基于图像级标注的方法与其他类型的标注相比, 图像级标注使用类别标签作为训练标注, 不需要进行像素标注, 制作更简单、工作量更小, 因而受到研究者更多的关注, 成为ISSbWSL方法的主流.但是图像级标注只提供了物体种类信息, 缺少位置、形状等信息, 在分割过程中也面临诸多挑战.

文献[88]将多示例学习(multiple instance learning, 简称MIL)[89]应用在ISSbWSL, 以构建图像标注与像素语义之间的关联; 同时, 还使用超像素、候选框和MCG算法等技术作为后续处理, 取得了一定的分割效果.文献[90]使用约束卷积神经网络(constrained convolutional neural network, 简称CCNN)进行图像语义分割, CCNN将图像级标注作为限制条件, 通过内部的损失函数来预测像素类别, 把训练过程看作是限制条件的最优化过程.文献[91]使用复合形式的损失函数进行图像语义分割, 提出了SEC(seed, expand and constrain)方法.SEC方法中的复合损失函数由3个不同的目标损失函数组成, 训练CNN时, 3个不同的目标损失函数分别完成不同的分割任务.

文献[92]提出一种可将分割结果由简单到复杂逐步转变的STC(simple to complex)方法.该方法首先利用显著性目标检测(salient object detection)算法检测出显著性区域, 进行区域特征融合和构建像素间的语义关系后, 由CNN产生一组显著性区域图.接着, 再由一套迭代机制从简单到复杂地重复数次该过程, 逐步提升分割精度.文献[93]在循环迭代的训练过程中引入增强反馈(augmented feedback)思想, 先使用选择搜索算法和MCG算法进行目标定位, 再根据反馈信息逐步提升分割能力, 可在一定程度上避免ISSbWSL存在的误差累积问题.文献[94]基于CNN和期望值最大化(expectation maximization, 简称EM)算法, 使用显著性目标检测算法和注意力图(attention maps)对图像进行分割, 分割效果较好.文献[95]基于FCN, 采用弱监督学习方式识别出图像中多个不同的显著性区域(discriminative localization)后, 捕获不同区域的局部特征, 再利用局部特征对图像中的物体进行定位和分割.文献[96]采用图像级标注图像对分类网络进行训练, 使用分类网络按照主次顺序逐步获取目标对象的显著性区域, 并利用一种逐步擦除显著性区域、不断提高像素分类精度的方法来处理图像的显著性区域, 使得分割精度迅速提升.

3.2.4 多种弱标注数据混合的方法以上3种使用弱标注图像进行训练的分割方法极大地推动了ISSbWSL的发展, 但由于弱标注图像的局限性, 单纯使用某种图像级标注的训练效果较差, 如果混合多种弱标注图像则可能取得较好的效果.多种弱标注数据混合的方法将多种弱标注图像与像素级标注图像相互混合, 通过混合训练的方式进行半监督学习.

文献[97]引入半监督学习思想, 将分类和分割相结合, 提出了由分类网络和分割网络组合而成的DecoupledNet网络.训练时, DecoupledNet先用大量的图像级标注训练分类网络, 再用少量的像素级标注训练分割网络.这种方法没有循环迭代过程, 不必考虑迭代收敛, 因而具有较好的扩展性.文献[98]在DeepLab网络的基础上, 将边框级标注与图像级标注一起用于训练, 对于给定的边框级标注图像, 先使用CRF对其做自动分割, 再在分割结果上做全监督学习.同时, 该方法[98]还尝试将少量的像素级标注图像和大量的弱标注图像结合训练, 并使用EM算法来预测未标记像素的类别, 其分割结果与进行全监督学习的DeepLab网络十分接近.

总的来说, ISSbWSL方法尝试在大量弱标注数据中找到图像的高级特征, 允许计算机在无人指导的情况下进行学习, 可使ISS摆脱对大量像素级标签数据的依赖.但目前大部分ISSbWSL方法没有充分考虑噪声干扰下弱标注图像分布的不确定性和复杂性, 其分割性能与ISSbFSL方法相比仍有较大差距.如何灵活运用弱标注图像数据来提高分割准确率和抗干扰性, 并减少大量弱标注图像所带来的计算复杂性, 是该类方法目前亟需解决的问题.

4 图像语义分割实验分析与对比在进行图像语义分割实验时, 要对每种方法进行公平、客观的评价, 就必须使用权威的数据集和统一的评价指标.本节将介绍一些在ISS实验中常用的公共数据集以及衡量算法性能的指标, 并对前文中一些经典方法的实验结果进行系统的分析和对比.表 3总结了图像语义分割的常用公共数据集.

| Table 3 Common datasets for image semantic segmentation 表 3 常用的图像语义分割数据集 |

4.1 常用公共数据集

(1) PASCAL Visual Object Classes(简称PASCAL VOC)[99].PASCAL VOC是一个国际计算机视觉挑战赛, 该组织提供了领域内知名度最高的图像测试数据集和计算机视觉领域的基准测试.2005年~2012年间, 该组织每年都发布带标签的图像数据库并开展算法竞赛, 由此产生了一系列数据集.目前, 该系列最常用的数据集是PASCAL VOC 2012.该数据集涉及物体共21种, 包括人类、动物、交通工具和室内物品等, 图片大小不固定, 背景复杂多变.

(2) PASCAL-CONTEXT[100].PASCAL-CONTEXT数据集由PASCAL VOC 2010数据集改进和扩展而来, 里面增加了更多的物体标注和场景信息, 总共包含540个语义类别的图像标注.在算法评估时, 一般选取前59类作为分割评判标准.

(3) PASCAL-PART[101].PASCAL-PART数据集中的图片大都出自PASCAL VOC 2010, 分为训练集、验证集和测试集这3个部分, 每部分中的图像都含有像素级标注, 能够提供丰富的细节信息. PASCAL-PART每张图像中, 目标物体的不同部位都有精确标注, 可为物体解析和ISS任务提供详细标注的样本.

(4) Microsoft Common Objects in Context(简称MS COCO)[102].MS COCO数据集早先是微软公司进行图像测试的一个大型数据库, 后来, 微软公司将其开源和推广.MS COCO数据集总共包含81种类别(包括背景)、328 000张图像、2 500 000个物体实例和100 000个人体关键部位标注, 大部分图片从复杂的日常场景中获取, 图中的物体具有精确的位置标注.

(5) ImageNet Large Scale Visual Recognition Challenge(简称ILSVRC)[103]).ILSVRC也是一个著名的国际计算机视觉挑战比赛, 提供的ImageNet数据集有1 400多万幅图片, 涵盖2万多个类别, 其中, 超过百万的图片有明确的类别标注和物体位置标注.数据集文档详细, 有团队维护, 使用方便, 在图像研究领域应用广泛, 被称为图像算法性能检验的另一标准数据集.

(6) Karlsruhe Institute of Technology and Toyota Technological Institute(KITTI)[104].KITTI是目前国际上用于自动驾驶场景检测的最大评测数据集, 主要用于评测车载环境下路面分割、目标检测、目标跟踪等技术.KITTI数据集包含市区、乡村和高速公路等真实场景图像, 每张图像中含有不同程度的遮挡现象.

(7) Cityscapes Dataset(简称Cityscapes)[105].Cityscapes主要提供无人驾驶环境下的图像分割数据, 用于评估算法在城区场景语义理解方面的性能.Cityscapes包含50个城市不同环境、不同背景、不同季节的街道场景, 提供5 000张精细标注的图片、20 000张粗略标注的图片和30种标注物体.

(8) Sift Flow[106].该数据集以户外场景解析类的图片为主, 包含街道、山脉、城市、海滩和建筑等8种户外类型场景, 共有2 688张图片、33种语义类目标和3种地理类目标.图片都具有像素级标注, 分辨率为256×256.

(9) Stanford background dataset(简称SBD)[107].SBD由斯坦福大学建立, 用于衡量语义级场景解析算法的性能.该数据集包含725张图片, 分别从LabelMe、PASCAL VOC等数据集中抽取而来.图片大多为户外场景类型, 大小较为规整, 每张图片至少包含1个前景对象.

(10) NYU Depth Dataset V2(简称NYUDv2)[108].NYUDv2中的图片大都出自微软Kinect数据库, 分为RGB图像、深度图像和RDB-D图像这3个子数据集.该数据集由一系列表示各种室内场景的视频序列组成, 总共包含1 449张RDB-D图像、26种场景类型、464种室内场景和407 024帧经过标记的图像数据.

(11) SUN-RGBD[109].SUN-RGBD中的图像大多由4个不同的RGB-D图像传感器捕获而得, 共包含10 000张RGB-D图像、146 617个多边形标注、58 657个边界框标注以及大量的空间布局信息和种类信息.

4.2 实验性能评价指标在ISS领域, 常用的性能评价指标主要包括平均召回率(average recall, 简称AR)[110]、平均精度(average precision, 简称AP)[110]、平均精度均值(mean average precision, 简称mAP)[110]、像素准确率(pixel accuracy, 简称PA)[23]、平均准确率(mean accuracy, 简称MA)[23]、平均交并比(mean intersection over union, 简称mIoU)[23]和带权交并比(frequency weighted intersection over union, 简称FWIoU)[23].在结果评价时, 一般选取PA、MA和mIoU这3种评价指标综合分析.其中, mIoU表示分割结果与其真值的重合度, 是目前ISS领域使用频率最高和最常见的评价指标.PA、MA和mIoU的具体定义及计算公式如公式(1)~公式(3)所示.

(1) PA用于计算正确分割的像素数量与图像像素总量的比例, 其具体计算方法如公式(1)所示.

| $PA = {{\left( {\sum\limits_{i = 1}^N {{X_{ii}}} } \right)} \mathord{\left/ {\vphantom {{\left( {\sum\limits_{i = 1}^N {{X_{ii}}} } \right)} {\left( {\sum\limits_{i = 1}^N {{T_i}} } \right)}}} \right. } {\left( {\sum\limits_{i = 1}^N {{T_i}} } \right)}}$ | (1) |

(2) MA表示所有类别物体像素准确率的平均值, 其具体计算方法如公式(2)所示.

| $MA = {{\left( {\sum\limits_{i = 1}^N {\frac{{{X_{ii}}}}{{{T_i}}}} } \right)} \mathord{\left/ {\vphantom {{\left( {\sum\limits_{i = 1}^N {\frac{{{X_{ii}}}}{{{T_i}}}} } \right)} N}} \right. } N}$ | (2) |

(3) mIoU表示分割结果与原始图像真值的重合程度, 其具体计算方法如公式(3)所示.

| $mIoU = {{\left( {\sum\limits_{i = 1}^N {\frac{{{X_{ii}}}}{{{T_i} + \sum\limits_{j = 1}^N {({X_{ji}} - {X_{ii}})} }}} } \right)} \mathord{\left/ {\vphantom {{\left( {\sum\limits_{i = 1}^N {\frac{{{X_{ii}}}}{{{T_i} + \sum\limits_{j = 1}^N {({X_{ji}} - {X_{ii}})} }}} } \right)} N}} \right. } N}$ | (3) |

其中, N代表图像像素的类别数量; Ti代表第i类的像素总数; Xii代表实际类型为i、预测类型为i的像素总数; Xji代表实际类型为i、预测类型为j的像素总数.

4.3 实验结果分析与对比为便于说明算法效果, 本节将按照图 1中的分类对ISSbRC、ISSbFSL和ISSbWSL这3类方法的实验结果分别进行分析对比.事实上, 随着计算机硬件技术的发展和数据处理能力的提高, 当前ISSbDL领域中, 大多数研究都以提升算法的“分割准确率”为研究重点, 而对“计算性能”关注不多.特别是上述3类方法中的ISSbRC方法和ISSbWSL方法, 由于其功能侧重点、应用场景和改进方式等原因, 相关研究大都忽略了对算法“计算性能”的实验考察.因此, 本节对这两类方法的效果仅从算法“分割准确率”方面进行分析对比.部分ISSbFSL方法因涉及到动态场景解析或实时图像语义分割等研究领域, 比较重视算法的“计算性能”指标.因此, 针对ISSbFSL方法, 本节将从算法“分割准确率”与“计算性能”两个方面进行实验结果分析.

4.3.1 ISSbRC方法的实验对比分析ISSbRC方法的实验对比见表 4, 主要比较因素有关键技术、实验数据集和评价指标等.

| Table 4 Experimental comparison of ISSbRC 表 4 基于区域分类的图像语义分割方法实验对比 |

从表 4中可以看到, ISSbRC方法大多选用PASCAL VOC和MS COCO数据集作测试数据集, 因为这两种数据集更有权威性和说服力.在基于候选区域的方法中, RCNN[12]的mIoU虽然不高, 但因其提出时间最早、性能平稳、代码开源, 已被实用化.其他算法, 如SDS[13]、MPA[14]、Mask-RCNN[15]等, 其框架结构都是在RCNN的基础上改进而来, 因此分割准确率逐步提升.基于分割掩膜的方法使用RCNN中的技术得到候选区域后, 再对像素进行二分类处理生成分割掩膜, 分割效果较好.在该类方法中, SharpMask[17]和MultiPath[18]分别对DeepMask[16]进行改进, 分割性能有较大的提升.其中, SharpMask将DeepMask生成的粗略分割掩膜输入精细模块, 进行逐步优化后最终生成精细的分割掩膜, 其平均召回率比DeepMask提高了近1倍.

4.3.2 ISSbFSL方法的实验对比分析(1) 针对ISSbFSL方法分割准确率的实验结果对比见表 5, 主要比较因素有基于的基础网络、关键技术、是否使用PGM方法、实验数据集和评价指标等.

| Table 5 Experimental comparison of segmentation accuracy for ISSbFSL 表 5 基于像素分类的全监督学习图像语义分割方法的分割准确率实验对比 |

从表 5中可以看到, 根据算法的应用场景和分割特色不同, 选用的数据集也不同.当对常规静态图像进行图像语义分割时, 大多选用PASCAL VOC 2012作为测试数据集; 当进行动态场景解析或实时图像语义分割时, 大多选用CityScapes作为测试数据集.

该类方法中, DeepLab-V3[27]、PSPNet[45]、RefineNet[44]、DUC+HDC[30]、LC[47]、GCN+[35]和QO[39]等算法在PASCAL VOC 2012数据集上的mIoU都超过了80%, 对图像中不同尺度的物体有较好的识别效果, 分割结果的边界比较接近真实分割边界, 是最具代表性的图像语义分割算法.其中, DeepLab-V3算法因为集成了FCN[23]、PSPNet和DeepLab-V2等众多网络的优点, 其mIoU指标目前排名最高.而PSPNet与RefineNet通过多路径、多尺度方式对图像特征进行融合, 可有效捕捉图像中丰富的上下文信息, 在mIoU指标上分别排名第二和第三.

CRFasRNN[28]、Dilation10[29]、DeepLab-V1[25]和DeepLab-V2[26]等算法则是基于FCN进行改进, 在PASCAL VOC 2012数据集上的mIoU都超过70%, 在分割准确率方面与FCN相比有较大提升.其中, DeepLab-V2由于具有代码开源时间早、性能稳定和分割准确率高等优点, 在工业界备受青睐, 被广泛用于分割静态图像, 其mIoU达到了79.7%.

其中, SegNet[32]、ENet[34]和ICNet[46]这3种算法由于主要用于无人自动驾驶、在线视频处理等领域, 故而选择在满足实时图像语义分割性能测试的CityScapes数据集进行实验.实验结果表明, 这3种算法的mIoU都超过了50%, 分割精度基本满足对街道场景图像进行语义分割的要求.其中, ICNet将不同尺度的图像放在不同深度的神经网络中处理, 并使用级联特征融合单元融合不同分辨率的特征图, 在CityScapes上的mIoU为69.5%, 分割准确率相对于SegNet和ENet有明显提升, 分割性能突出.

(2) 针对算法的计算性能, 基于Cityscapes基准测试和PASCAL VOC基准测试中的有关内容[99, 105]以及相关参考文献[23, 46], 我们从ISSbFS方法中选择了代表性较强、相关度较高的几种经典算法进行分析对比.各算法计算性能的实验测试均在Cityscapes数据集中进行, 其测试结果见表 6, 主要比较因素有算法名称、发表年份、运行时间和每秒帧数等, 其中, “运行时间”代表分割一张图像所消耗的时间, “每秒帧数”代表每秒能够分割的图像总数量.

| Table 6 Experimental comparison of computational performance for ISSbFSL 表 6 基于像素分类的全监督学习图像语义分割方法的计算性能实验对比 |

从表 6中可以看到, 各类具体算法的分割速度有较大差异.其中, ENet[34]、ICNet[46]和SegNet[32]这3种算法的运行时间分别为0.013s、0.033s和0.06s, 分割速度较快, 实时性强, 适用于实时图像分割; 而FCN[23]由于在使用双线性插值算法进行上采样过程中耗时较长, 导致分割速度不高, 其运行时间为0.5s, 无法满足实时图像分割的需求; DeepLab-V1[25]和DeepLab-V2[26]由于在利用PGM对图像进行结构化预测过程中计算较为复杂、耗时较长, 导致其分割速度较低, 也无法满足实时图像分割的需求; 其他算法的分割速度都比FCN要低, 也同样无法满足实时图像分割的需求, 不适用于在线视频处理和动态场景解析等任务.

4.3.3 ISSbWSL方法的实验对比分析ISSbWSL方法的实验结果对比见表 7, 主要比较因素有关键技术、监督信息、是否使用CRF方法、实验数据集和评价指标等.在这些方法中, BoxSup[83]、ScribbleSup[87]和WeaklySemi[98]这3种方法在PASCAL VOC 2012数据集上的mIoU都超过了70%, 分割准确率较高, 是以弱监督学习方式进行图像语义分割的典型算法.而基于图像级标注的方法因为仅仅使用带有种类标注的弱标注数据进行弱监督训练, 分割效果不明显, 分割边界粗糙且不连续, mIoU都普遍较低.

| Table 7 Experimental comparison of ISSbWSL 表 7 基于像素分类的弱监督学习图像语义分割方法实验对比 |

5 总结与展望

如今, 深度学习技术已经广泛应用到图像语义分割领域.本文主要对基于深度学习的图像语义分割的经典方法与研究现状进行了较为细致的分类、梳理与总结.根据分割特点和处理粒度不同, 将基于深度学习的图像语义分割方法分为基于区域分类的图像语义分割方法和基于像素分类的图像语义分割方法, 把基于像素分类的图像语义分割方法进一步细分为全监督学习图像语义分割方法和弱监督学习图像语义分割方法.对每类方法的代表性算法进行了研究、分析和对比, 并概括总结了每类方法的技术特点和优缺点.在现有研究成果的基础上, 我们总结ISS研究领域的重点问题和发展趋势, 认为该领域还存在如下一些具有挑战性的研究方向.

(1) 应用于场景解析任务的图像语义分割

场景解析任务处理的图像背景复杂、环境多变, 现有ISSbDL方法无法有效地捕获图像的上下文信息和深度语义信息, 在识别和分割图像中目标物体时仍存在较大的困难.文献[111]把迁移学习的思想引入场景解析任务, 将图像像素特征与词汇概念相结合, 提出一个开放式词汇解析网络(the open vocabulary parsing network, 简称OVPN).文献[112]提出一个针对该任务的语境循环残差网络(contextual recurrent residual network, 简称CRRN), 通过继承序列模型和残差学习, 建模远程语境依赖、学习视觉特征.这些方法目前都存在难以选择标注基元量化级别、未充分利用场景几何深度等问题, 如何解决这些场景解析中的问题并实现有效分割是一个挑战.

(2) 实例级图像语义分割

实例级图像语义分割, 有时也称为实例分割(instance segmentation, 简称IS), 融合了分割与检测两个功能, 可以分割出图像中同类物体的不同实例.文献[113]将多任务学习(multi-task learning)[114]引入分割领域实现实例分割, 其分割过程分为3个能够共享卷积特征的子任务, 将上一任务的输出作为下一任务的输入, 分割时, 能够区分出不同的实例对象.文献[13, 15]对RCNN进行改进后, 既能用于ISS, 又能用于IS.文献[115, 116]对FCN进行改进, 使用滑动窗口或物体框将不同的位置信息编码到特征图中, 对每个实例进行语义分割.文献[117]在图像中使用聚类的方法构建分割树, 并探索不同的实例.文献[118]使用多示例学习方法结合弱监督学习进行IS.文献[119]使用一个可逆的RNN处理IS问题.这些方法在分割准确率和算法综合性能上都有很大的提升空间, 如何平衡分割效果与时间复杂度, 也是目前亟需解决的问题.

(3) 实时图像语义分割

实时图像语义分割以极高的分割速率处理图像或视频数据, 并分析利用各图像(帧)之间的时空关系, 是一种以高分割速率运行的ISS机制.文献[34]基于编码器-解码器结构, 采用分解滤波器策略, 使用低阶近似将卷积操作分解为更简单的操作, 降低了计算量, 初步实现了实时分割.文献[46]采用逐步提高分割精度的策略, 逐渐减少图像经过的网络层数, 利用级联特征融合单元来融合高分辨率与低分辨率图像的特征, 提高了分割速度, 基本达到了实时分割.实时图像语义分割常被应用于视频跟踪和多目标定位等任务, 有巨大的商业价值, 但目前的ISS方法大多无法满足实时分割的速度要求.探索如何进一步提高实时图像语义分割的速度与精度, 是该领域的一个研究热点.

(4) 应用于三维数据的语义分割

目前, 大多数ISS算法以处理静态图片数据为主, 而针对点云、多边形网格等三维数据的分割方法却较少.文献[120-122]尝试使用三维卷积神经网络(3D convolutional neural network, 简称3D-CNN)对三维数据进行处理.文献[123]则对3D-CNN进行改进, 设计了一个能够标注点云数据并进行语义分割的3D-CNN.文献[124]直接以未排序的点云作为输入数据, 提出一个能够直接对点云数据进行语义分割的PointNet网络.三维数据语义分割技术是近年来兴起的一项热门研究, 由于三维数据的无序性和非结构化本质, 如何合理离散化和结构化这些数据并有效地保留其空间位置信息, 仍是一个有待解决的问题.而且, 由于三维数据语义分割任务严重依赖大量数据集, 如何大规模地获取三维数据并建立相关公共数据集, 也是研究者们要努力的一个方向.

(5) 应用于视频数据的语义分割

视频语义分割是一种基于三维空间的ISS问题.目前, 针对视频数据的语义分割方法较少.带有时间序列的视频数据在语义分割过程中能充分利用二维图像中的隐含信息, 可更好地显示二维图像无法展现的时空特征.文献[125]基于FCN提出一种有效利用时空信息进行视频语义分割的循环全卷积网络(recurrent fully convolutional network, 简称RFCN).文献[126]将视频数据中的空间特征融入FCN, 提出一种融合时空特征的时空全卷积网络(spatio-temporal fully convolutional network, 简称STFCN).文献[127]则设计了一个定时全卷积网络(clockwork FCN), 使用自适应时钟信号操纵定时卷积驱动进行视频分割.未来, 研究如何充分利用视频丰富的时空序列特征具有重要意义; 同时, 如何从视频高效抽取高层语义信息也是一个难点.

致谢 在此, 我们向对本文提出宝贵修改意见的各位同行及评审专家表示感谢.| [1] |

Csurka G, Perronnin F. An efficient approach to semantic segmentation. Int'l Journal of Computer Vision, 2011, 95(2): 198-212.

[doi:10.1007/s11263-010-0344-8] |

| [2] |

Hinton GE, Salakhutdinov RR. Reducing the dimensionality of data with neural networks. Science, 2006, 313(5786): 504-507.

[doi:10.1126/science.1127647] |

| [3] |

Jiang F, Gu Q, Hao HZ, Li N, Guo YW, Chen DX. Survey on content-based image segmentation methods. Ruan Jian Xue Bao/Journal of Software, 2017, 28(1): 160-183(in Chinese with English abstract). http://www.jos.org.cn/1000-9825/5136.htm[doi: 10.13328/j.cnki.jos.005136]

|

| [4] |

Wei YC, Zhao Y. A review on image semantic segmentation based on DCNN. Journal of Beijing Jiaotong University, 2016, 40(4): 82-91(in Chinese with English abstract).

[doi:10.11860/j.issn.1673-0291.2016.04.013] |

| [5] |

Lecun Y, Bottou L, Bengio Y, Haffner P. Gradient-based learning applied to document recognition. Proc. of the IEEE, 1998, 86(11): 2278-2324.

[doi:10.1109/5.726791] |

| [6] |

Pearlmutter BA. Gradient calculations for dynamic recurrent neural networks: A survey. IEEE Trans. on Neural Networks, 1995, 6(5): 1212-1228.[doi: 10.1109/72.410363]

|

| [7] |

Goodfellow IJ, Pougetabadie J, Mirza M, Xu B, Wardefarley D, Ozair S, Courville A, Bengio Y. Generative adversarial networks. In: Advances in Neural Information Processing Systems. 2014. 2672-2680.

|

| [8] |

Hochreiter S, Schmidhuber J. Long short-term memory. Neural Computation, 1997, 9(8): 1735-1780.

[doi:10.1162/neco.1997.9.8.1735] |

| [9] |

Cho K, Merrienboer BV, Gulcehre C, Bahdanau D, Bougares F, Schwenk H, Bengio Y. Learning phrase representations using RNN encoder-decoder for statistical machine translation. arXiv preprint arXiv: 1406.1078, 2014. http://www.oalib.com/paper/4082023

|

| [10] |

Couprie C, Farabet C, Najman L, Lecun Y. Indoor semantic segmentation using depth information. arXiv preprint arXiv: 1301. 3572, 2013. http://www.oalib.com/paper/4057403

|

| [11] |

Farabet C, Couprie C, Najman L, Lecun Y. Learning hierarchical features for scene labeling. IEEE Trans. on Pattern Analysis and Machine Intelligence, 2013, 35(8): 1915-1929.[doi: 10.1109/TPAMI.2012.231] http://med.wanfangdata.com.cn/Paper/Detail/PeriodicalPaper_PM23787344

|

| [12] |

Girshick R, Donahue J, Darrell T, Malik J. Rich feature hierarchies for accurate object detection and semantic segmentation. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2014. 580-587.[doi: 10.1109/CVPR.2014.81]

|

| [13] |

Hariharan B, Arbeláez P, Girshick R, Malik J. Simultaneous detection and segmentation. In: Proc. of the European Conf. on Computer Vision. Springer-Verlag, 2014. 297-312.

|

| [14] |

Liu S, Qi X, Shi J, Zhang H, Jia J. Multi-scale patch aggregation (MPA) for simultaneous detection and segmentation. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2016. 3141-3149.[doi: 10.1109/CVPR.2016.342]

|

| [15] |

He K, Gkioxari G, Dollár P, Girshick R. Mask R-CNN. In: Proc. of the IEEE Int'l Conf. on Computer Vision. 2017. 2980-2988.[doi: 10.1109/ICCV.2017.322]

|

| [16] |

Pinheiro PO, Collobert R, Dollar P. Learning to segment object candidates. In: Proc. of the Advances in Neural Information Processing Systems. 2015. 1990-1998. http://dl.acm.org/citation.cfm?id=2969442.2969462

|

| [17] |

Pinheiro PO, Lin TY, Collobert R, Dollár P. Learning to refine object segments. In: Proc. of the European Conf. on Computer Vision. Springer-Verlag, 2016. 75-91.

|

| [18] |

Zagoruyko S, Lerer A, Lin TY, Pinheiro PO, Gross S, Chintala S, Dollár P. A multipath network for object detection. arXiv preprint arXiv: 1604.02135, 2016.

|

| [19] |

Arbeláez P, Pont-Tuset J, Barron JT, Marques F, Malik J. Multiscale combinatorial grouping. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2014. 328-335.[doi: 10.1109/CVPR.2014.49]

|

| [20] |

He K, Zhang X, Ren S, Sun J. Spatial pyramid pooling in deep convolutional networks for visual recognition. IEEE Trans. on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1904-1916.[doi: 10.1109/TPAMI.2015.2389824] http://ieeexplore.ieee.org/document/7005506

|

| [21] |

Girshick R. Fast R-CNN. In: Proc. of the IEEE Int'l Conf. on Computer Vision. 2015. 1440-1448.[doi: 10.1109/ICCV.2015.169]

|

| [22] |

Ren S, He K, Girshick R, Sun J. Faster R-CNN: Towards real-time object detection with region proposal networks. In: Proc. of the Advances in Neural Information Processing Systems. 2015. 91-99.[doi: 10.1109/TPAMI.2016.2577031]

|

| [23] |

Shelhamer E, Long J, Darrell T. Fully convolutional networks for semantic segmentation. IEEE Trans. on Pattern Analysis & Machine Intelligence, 2014, 39(4): 640-651.[doi: 10.1109/TPAMI.2016.2572683] http://www.ncbi.nlm.nih.gov/pubmed/27244717/

|

| [24] |

Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition. arXiv preprint arXiv: 1409.1556, 2014.

|

| [25] |

Chen LC, Papandreou G, Kokkinos I, Murphy K, Yuille AL. Semantic image segmentation with deep convolutional nets and fully connected CRFs. arXiv preprint arXiv: 1412.7062, 2014. http://www.oalib.com/paper/4067607

|

| [26] |

Chen LC, Papandreou G, Kokkinos I, Murphy K, Yuille AL. Deeplab: Semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected CRFs. IEEE Trans. on Pattern Analysis & Machine Intelligence, 2018, 40(4): 834-848.[doi: 10.1109/TPAMI.2017.2699184]

|

| [27] |

Chen LC, Papandreou G, Schroff F, Adam H. Rethinking atrous convolution for semantic image segmentation. arXiv preprint arXiv: 1706.05587, 2017.

|

| [28] |

Zheng S, Jayasumana S, Romera-Paredes B, Vineet V, Su Z, Du D, Huang C, Torr PH. Conditional random fields as recurrent neural networks. In: Proc. of the IEEE Int'l Conf. on Computer Vision. 2015. 1529-1537.[doi: 10.1109/ICCV.2015.179]

|

| [29] |

Yu F, Koltun V. Multi-scale context aggregation by dilated convolutions. arXiv preprint arXiv: 1511.07122, 2015.

|

| [30] |

Wang P, Chen P, Yuan Y, Liu D, Huang Z, Hou X, Cottrell G. Understanding convolution for semantic segmentation. In: Proc. of the IEEE Winter Conf. on Applications of Computer Vision. 2018. 1451-1460.[doi: 10.1109/WACV.2018.00163]

|

| [31] |

Dai J, Qi H, Xiong Y, Li Y, Zhang G, Hu H, Wei Y. Deformable convolutional networks. In: Proc. of the IEEE Int'l Conf. on Computer Vision. 2017. 764-773.

|

| [32] |

Badrinarayanan V, Kendall A, Cipolla R. Segnet: A deep convolutional encoder-decoder architecture for image segmentation. IEEE Trans. on Pattern Analysis and Machine Intelligence, 2015, 39(12): 2481-2495.[doi: 10.1109/TPAMI.2016.2644615]

|

| [33] |

Noh H, Hong S, Han B. Learning deconvolution network for semantic segmentation. In: Proc. of the IEEE Int'l Conf. on Computer Vision. 2015. 1520-1528.[doi: 10.1109/ICCV.2015.178] http://dl.acm.org/citation.cfm?id=2919658

|

| [34] |

Paszke A, Chaurasia A, Kim S, Culurciello E. Enet: A deep neural network architecture for real-time semantic segmentation. arXiv preprint arXiv: 1606.02147, 2016.

|

| [35] |

Peng C, Zhang X, Yu G, Luo G, Sun J. Large kernel matters-Improve semantic segmentation by global convolutional network. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2017. 1743-1751.[doi: 10.1109/CVPR.2017.189]

|

| [36] |

Lin G, Shen C, Van Den Hengel A, Reid I. Efficient piecewise training of deep structured models for semantic segmentation. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2016. 3194-3203.[doi: 10.1109/CVPR.2016.348] http://www.oalib.com/paper/4074201

|

| [37] |

Shen F, Zeng G. Fast semantic image segmentation with high order context and guided filtering. arXiv preprint arXiv: 1605.04068, 2016.

|

| [38] |

Liu Z, Li X, Luo P, Loy CC, Tang X. Semantic image segmentation via deep parsing network. In: Proc. of the IEEE Int'l Conf. on Computer Vision. 2015. 1377-1385.[doi: 10.1109/ICCV.2015.162] http://dl.acm.org/citation.cfm?id=2920082

|

| [39] |

Chandra S, Kokkinos I. Fast, exact and multi-scale inference for semantic image segmentation with deep gaussian CRFs. In: Proc. of the European Conf. on Computer Vision. Springer-Verlag, 2016. 402-418.

|

| [40] |

Arnab A, Jayasumana S, Zheng S, Torr PH. Higher order conditional random fields in deep neural networks. In: Proc. of the European Conf. on Computer Vision: Springer-Verlag, 2016. 524-540.[doi: 10.1007/978-3-319-46475-6_33] http://link.springer.com/content/pdf/10.1007/978-3-319-46475-6_33.pdf

|

| [41] |

Vemulapalli R, Tuzel O, Liu MY, Chellapa R. Gaussian conditional random field network for semantic segmentation. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2016. 3224-3233.[doi: 10.1109/CVPR.2016.351] http://ieeexplore.ieee.org/document/7780720/

|

| [42] |

Arnab A, Jayasumana S, Zheng S, Torr PH. Higher order potentials in end-to-end trainable conditional random fields. Computer Science, 2015.

http://www.wanfangdata.com.cn/details/detail.do?_type=perio&id=Arxiv000001353889 |

| [43] |

Ghiasi G, Fowlkes CC. Laplacian reconstruction and refinement for semantic segmentation. arXiv preprint arXiv: 1605.02264, 2016.[doi: 10.1007/978-3-319-46487-9_32]

|

| [44] |

Lin G, Milan A, Shen C, Reid I. RefineNet: Multi-path refinement networks with identity mappings for high-resolution semantic segmentation. arXiv preprint arXiv: 1611.06612, 2016.

|

| [45] |

Zhao H, Shi J, Qi X, Wang X, Jia J. Pyramid scene parsing network. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2017. 6230-6239.[doi: 10.1109/CVPR.2017.660]

|

| [46] |

Zhao H, Qi X, Shen X, Shi J, Jia J. ICNet for real-time semantic segmentation on high-resolution images. arXiv preprint arXiv: 1704.08545, 2017.

|

| [47] |

Li X, Liu Z, Luo P, Loy CC, Tang X. Not all pixels are equal: Difficulty-aware semantic segmentation via deep layer cascade. arXiv preprint arXiv: 1704.01344, 2017.

|

| [48] |

Chen LC, Yang Y, Wang J, Xu W, Yuille AL. Attention to scale: Scale-aware semantic image segmentation. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2016. 3640-3649.[doi: 10.1109/CVPR.2016.396] http://www.oalib.com/paper/4055008

|

| [49] |

Eigen D, Fergus R. Predicting depth, surface normals and semantic labels with a common multi-scale convolutional architecture. In: Proc. of the IEEE Int'l Conf. on Computer Vision. 2015. 2380-7504.[doi: 10.1109/ICCV.2015.304] http://www.oalib.com/paper/4066459

|

| [50] |

Eigen D, Puhrsch C, Fergus R. Depth map prediction from a single image using a multi-scale deep network. In: Proc. of the Int'l Conf. on Neural Information Processing Systems. 2014. 2366-2374.

|

| [51] |

Pinheiro P, Collobert R. Recurrent convolutional neural networks for scene labeling. In: Proc. of the Int'l Conf. on Machine Learning. 2014. 82-90.

|

| [52] |

Visin F, Ciccone M, Romero A, Kastner K, Cho K, Bengio Y, Matteucci M, Courville A. Reseg: A recurrent neural networkbased model for semantic segmentation. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition Workshops. 2016. 41-48.[doi: 10.1109/CVPRW.2016.60]

|

| [53] |

Shuai B, Zuo Z, Wang B, Wang G. DAG-recurrent neural networks for scene labeling. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2016. 3620-3629.[doi: 10.1109/CVPR.2016.394]

|

| [54] |

Byeon W, Breuel TM, Raue F, Liwicki M. Scene labeling with LSTM recurrent neural networks. In: Proc. of the Computer Vision and Pattern Recognition. 2015. 3547-3555.[doi: 10.1109/CVPR.2015.7298977] http://ieeexplore.ieee.org/xpls/icp.jsp?arnumber=7298977

|

| [55] |

Luc P, Couprie C, Chintala S, Verbeek J. Semantic segmentation using adversarial networks. arXiv preprint arXiv: 1611.08408, 2016.

|

| [56] |

Hoffman J, Wang D, Yu F, Darrell T. FCNs in the wild: Pixel-level adversarial and constraint-based adaptation. arXiv preprint arXiv: 1612.02649, 2016.

|

| [57] |

Koziński M, Simon L, Jurie F. An adversarial regularisation for semi-supervised training of structured output neural networks. arXiv preprint arXiv: 1702.02382, 2017.

|

| [58] |

Souly N, Spampinato C, Shah M. Semi and weakly supervised semantic segmentation using generative adversarial network. arXiv preprint arXiv: 1703.09695, 2017.

|

| [59] |

Ronneberger O, Fischer P, Brox T. U-Net: Convolutional networks for biomedical image segmentation. In: Proc. of the Int'l Conf. on Medical Image Computing and Computer-assisted Intervention. 2015. 234-241.

|

| [60] |

Badrinarayanan V, Handa A, Cipolla R. Segnet: A deep convolutional encoder-decoder architecture for robust semantic pixelwise labelling. arXiv preprint arXiv: 1505.07293, 2015.

|

| [61] |

Liu JW, Li HE, Luo XL. Learning technique of probabilistic graphical models:A review. Acta Automatica Sinica, 2014, 40(6): 1025-1044(in Chinese with English abstract).

[doi:10.3724/SP.J.1004.2014.01025] |

| [62] |

Qi X, Shi J, Liu S, Liao R. Semantic segmentation with object clique potential. In: Proc. of the IEEE Int'l Conf. on Computer Vision. 2015. 2587-2595.[doi: 10.1109/ICCV.2015.297] http://ieeexplore.ieee.org/xpl/articleDetails.jsp?arnumber=7410654

|

| [63] |

Lin G, Shen C, Reid I, Van Den Hengel A. Deeply learning the messages in message passing inference. Computer Science, 2015, 71(5): 866-872.

http://arxiv.org/abs/1506.02108 |

| [64] |

Kohli P, Ladicky LU, Torr PH. Robust higher order potentials for enforcing label consistency. Int'l Journal of Computer Vision, 2009, 82(3): 302-324.

[doi:10.1007/s11263-008-0202-0] |

| [65] |

Song XY, Zhou LL, Li ZG, Chen J, Zeng L, Yan B. Review on superpixel methods in image segmentation. Journal of Image and Graphics, 2015, 20(5): 599-608(in Chinese with English abstract).

[doi:10.11834/jig.20150502] |

| [66] |

Liu W, Rabinovich A, Berg AC. Parsenet: Looking wider to see better. arXiv preprint arXiv: 1506.04579, 2015.

|

| [67] |

Burt P, Adelson E. The Laplacian pyramid as a compact image code. IEEE Trans. on Communications, 1983, 31(4): 532-540.[doi: 10.1109/TCOM.1983.1095851]

|

| [68] |

Mnih V, Heess N, Graves A. Recurrent models of visual attention. In: Proc. of the Advances in Neural Information Processing Systems. 2014. 2204-2212.

|

| [69] |

Li H, Lin Z, Shen X, Brandt J, Hua G. A convolutional neural network cascade for face detection. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2015. 5325-5334.[doi: 10.1109/CVPR.2015.7299170]

|

| [70] |

Viola P, Jones M. Rapid object detection using a boosted cascade of simple features. In: Proc. of the 2001 IEEE Computer Society Conf. on Computer Vision and Pattern Recognition. 2001. 511-518.[doi: 10.1109/CVPR.2001.990517]

|

| [71] |

Szegedy C, Ioffe S, Vanhoucke V, Alemi A. Inception-v4, inception-resnet and the impact of residual connections on learning. arXiv preprint arXiv: 1602.07261, 2016.

|

| [72] |

Raj A, Maturana D, Scherer S. Multi-scale convolutional architecture for semantic segmentation. Technical Report, CMU-RI-TR-15-21, Pittsburgh: Robotics Institute, Carnegie Mellon University, 2015.

|

| [73] |

Roy A, Todorovic S. A multi-scale CNN for affordance segmentation in RGB images. In: Proc. of the European Conf. on Computer Vision. Springer Int'l Publishing, 2016. 186-201.[doi: 10.1007/978-3-319-46493-0_12] http://link.springer.com/10.1007/978-3-319-46493-0_12

|

| [74] |

Bian X, Lim SN, Zhou N. Multiscale fully convolutional network with application to industrial inspection. In: Proc. of the IEEE Winter Conf. on Applications of Computer Vision. IEEE Computer Society, 2016. 1-8.[doi: 10.1109/WACV.2016.7477595] http://ieeexplore.ieee.org/document/7477595/

|

| [75] |

Li Z, Gan Y, Liang X, Yu Y, Cheng H, Lin L. LSTM-CF: Unifying context modeling and fusion with LSTMs for RGB-D scene labeling. In: Proc. of the European Conf. on Computer Vision. Springer-Verlag, 2016. 541-557.

|

| [76] |

Jozefowicz R, Zaremba W, Sutskever I. An empirical exploration of recurrent network architectures. In: Proc. of the Int'l Conf. on Machine Learning. 2015. 2342-2350. http://dl.acm.org/citation.cfm?id=3045367

|

| [77] |

Chung J, Gulcehre C, Cho K, Bengio Y. Empirical evaluation of gated recurrent neural networks on sequence modeling. arXiv preprint arXiv: 1412.3555, 2014. http://www.oalib.com/paper/4068125

|

| [78] |

Mclaughlin N, Rincon JMD, Miller P. Recurrent convolutional network for video-based person re-identification. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. IEEE, 2016. 1325-1334.[doi: 10.1109/CVPR.2016.148] http://ieeexplore.ieee.org/document/7780517/

|

| [79] |

Lei T, Zhang Y. Training RNNs as fast as CNNs. arXiv preprint arXiv: 1709.02755, 2017.

|

| [80] |

Mirza M, Osindero S. Conditional generative adversarial nets. arXiv preprint arXiv: 1411.1784, 2014.

|

| [81] |

Im DJ, Kim CD, Jiang H, Memisevic R. Generating images with recurrent adversarial networks. arXiv preprint arXiv: 1602.05110, 2016.

|

| [82] |

Denton EL, Chintala S, Fergus R. Deep generative image models using a Laplacian pyramid of adversarial networks. In: Proc. of the Int'l Conf. on Neural Information Processing Systems. 2015. 1486-1494. http://www.oalib.com/paper/4084178

|

| [83] |

Dai J, He K, Sun J. BoxSup: Exploiting bounding boxes to supervise convolutional networks for semantic segmentation. In: Proc. of the IEEE Int'l Conf. on Computer Vision. 2015. 1635-1643.[doi: 10.1109/ICCV.2015.191] http://www.oalib.com/paper/4072190

|

| [84] |

Rajchl M, Lee M, Oktay O, Kamnitsas K, Passerat-Palmbach J, Bai W, Rutherford M, Hajnal J, Kainz B, Rueckert D. DeepCut: Object segmentation from bounding box annotations using convolutional neural networks. IEEE Trans. on Medical Imaging, 2016, 36(2): 674-683.[doi: 10.1109/TMI.2016.2621185]

|

| [85] |

Boykov YY, Jolly MP. Interactive graph cuts for optimal boundary & region segmentation of objects in N-D images. In: Proc. of the IEEE Int'l Conf. on Computer Vision. 2001. 105-112.[doi: 10.1109/ICCV.2001.10011]

|

| [86] |

Bearman A, Russakovsky O, Ferrari V, Li FF. What's the point: Semantic segmentation with point supervision. In: Proc. of the European Conf. on Computer Vision. Springer-Verlag, 2016. 549-565. http://link.springer.com/chapter/10.1007/978-3-319-46478-7_34?no-access=true

|

| [87] |

Lin D, Dai J, Jia J, He K, Sun J. ScribbleSup: Scribble-supervised convolutional networks for semantic segmentation. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. IEEE, 2016. 3159-3167.[doi: 10.1109/CVPR.2016.344]

|

| [88] |

Pinheiro PO, Collobert R. From image-level to pixel-level labeling with convolutional networks. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2015. 1713-1721.[doi: 10.1109/CVPR.2015.7298780] http://www.oalib.com/paper/4066468

|

| [89] |

Dietterich TG, Lathrop RH, Lozano-Pérez T. Solving the multiple instance problem with axis-parallel rectangles. Artificial Intelligence, 1997, 89(1-2): 31-71.

[doi:10.1016/S0004-3702(96)00034-3] |

| [90] |

Pathak D, Krahenbuhl P, Darrell T. Constrained convolutional neural networks for weakly supervised segmentation. In: Proc. of the IEEE Int'l Conf. on Computer Vision. 2015. 1796-1804.[doi: 10.1109/ICCV.2015.209] http://www.oalib.com/paper/4083663

|

| [91] |

Kolesnikov A, Lampert CH. Seed, expand and constrain: Three principles for weakly-supervised image segmentation. In: Proc. of the European Conf. on Computer Vision. Springer-Verlag, 2016. 695-711.[doi: 10.1007/978-3-319-46493-0_42] http://link.springer.com/chapter/10.1007/978-3-319-46493-0_42

|

| [92] |

Wei Y, Liang X, Chen Y, Shen X, Cheng MM, Feng J, Zhao Y, Yan S. STC: A simple to complex framework for weaklysupervised semantic segmentation. IEEE Trans. on Pattern Analysis & Machine Intelligence, 2017, 39(11): 2314-2320.[doi: 10.1109/TPAMI.2016.2636150]

|

| [93] |

Qi X, Liu Z, Shi J, Zhao H, Jia J. Augmented feedback in semantic segmentation under image level supervision. In: Proc. of the European Conf. on Computer Vision. Springer-Verlag, 2016. 90-105. http://link.springer.com/10.1007/978-3-319-46484-8_6

|

| [94] |

Hou Q, Dokania PK, Massiceti D, Wei Y, Cheng M, Torr P. Bottom-up top-down cues for weakly-supervised semantic segmentation. In: Proc. of the Int'l Workshop on Energy Minimization Methods in Computer Vision and Pattern Recognition. Springer-Verlag, 2017. 263-277.

|

| [95] |

Durand T, Mordan T, Thome N, Cord M. WILDCAT: Weakly supervised learning of deep ConvNets for image classification, pointwise localization and segmentation. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2017. 5957-5966.[doi: 10.1109/CVPR.2017.631]

|

| [96] |

Wei Y, Feng J, Liang X, Cheng MM, Zhao Y, Yan S. Object region mining with adversarial erasing: A simple classification to semantic segmentation approach. In: Proc. of the Computer Vision and Pattern Recognition. IEEE, 2017. 6488-6496.[doi: 10.1109/CVPR.2017.687] http://ieeexplore.ieee.org/document/8100170

|

| [97] |

Hong S, Noh H, Han B. Decoupled deep neural network for semi-supervised semantic segmentation. In: Proc. of the Advances in Neural Information Processing Systems. 2015. 1495-1503.

|

| [98] |

Papandreou G, Chen LC, Murphy K, Yuille AL. Weakly-and semi-supervised learning of a DCNN for semantic image segmentation. arXiv preprint arXiv: 1502.02734, 2015.

|

| [99] |

Everingham M, Eslami SA, Van Gool L, Williams CK, Winn J, Zisserman A. The pascal visual object classes challenge:A retrospective. Int'l Journal of Computer Vision, 2015, 111(1): 98-136.

[doi:10.1007/s11263-014-0733-5] |

| [100] |

Mottaghi R, Chen X, Liu X, Cho NG, Lee SW, Fidler S, Urtasun R, Yuille A. The role of context for object detection and semantic segmentation in the wild. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2014. 891-898.[doi: 10.1109/CVPR.2014.119]

|

| [101] |

Chen X, Mottaghi R, Liu X, Fidler S, Urtasun R, Yuille A. Detect what you can: Detecting and representing objects using holistic models and body parts. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2014. 1979-1986.[doi: 10.1109/CVPR.2014.254]

|

| [102] |

Lin TY, Maire M, Belongie S, Hays J, Perona P, Ramanan D, Dollár P, Zitnick CL. Microsoft coco: Common objects in context. In: Proc. of the European Conf. on Computer Vision. Springer-Verlag, 2014. 740-755.

|

| [103] |

Russakovsky O, Deng J, Su H, Krause J, Satheesh S, Ma S, Huang Z, Karpathy A, Khosla A, Bernstein M. Imagenet large scale visual recognition challenge. Int'l Journal of Computer Vision, 2015, 115(3): 211-252.

[doi:10.1007/s11263-015-0816-y] |

| [104] |

Geiger A, Lenz P, Stiller C, Urtasun R. Vision meets robotics:The KITTI dataset. The Int'l Journal of Robotics Research, 2013, 32(11): 1231-1237.

[doi:10.1177/0278364913491297] |

| [105] |

Cordts M, Omran M, Ramos S, Rehfeld T, Enzweiler M, Benenson R, Franke U, Roth S, Schiele B. The cityscapes dataset for semantic urban scene understanding. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2016. 3213-3223.

|

| [106] |

Liu C, Yuen J, Torralba A. Nonparametric scene parsing: Label transfer via dense scene alignment. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition (CVPR 2009). IEEE, 2009. 1972-1979.[doi: 10.1109/CVPRW.2009.5206536] http://ieeexplore.ieee.org/xpls/icp.jsp?arnumber=5206536

|

| [107] |

Gould S, Fulton R, Koller D. Decomposing a scene into geometric and semantically consistent regions. In: Proc. of the 2009 IEEE 12th Int'l Conf. on Computer Vision. IEEE, 2009. 1-8.[doi: 10.1109/ICCV.2009.5459211] http://ieeexplore.ieee.org/xpls/icp.jsp?arnumber=5459211

|

| [108] |

Silberman N, Hoiem D, Kohli P, Fergus R. Indoor segmentation and support inference from RGBD images. In: Proc. of the European Conf. on Computer Vision. Springer-Verlag, 2012. 746-760.

|

| [109] |

Song S, Lichtenberg SP, Xiao J. Sun RGB-D: A RGB-D scene understanding benchmark suite. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2015. 567-576.[doi: 10.1109/CVPR.2015.7298655]

|

| [110] |

Turpin A, Scholer F. User performance versus precision measures for simple search tasks. In: Proc. of the 29th Annual Int'l ACM SIGIR Conf. on Research and Development in Information Retrieval. ACM Press, 2006. 11-18.[doi: 10.1145/1148170.1148176] http://dl.acm.org/citation.cfm?id=1148176

|

| [111] |

Zhao H, Puig X, Zhou B, Fidler S, Torralba A. Open vocabulary scene parsing. In: Proc. of the IEEE Int'l Conf. on Computer Vision. 2018. 2021-2029.[doi: 10.1109/ICCV.2017.221]

|

| [112] |

Le T, Duong CN, Han L, Luu K, Savvides M, Pal D. Deep contextual recurrent residual networks for scene labeling. Pattern Recognition, 2018, 80: 32-41.

[doi:10.1016/j.patcog.2018.01.005] |

| [113] |

Dai J, He K, Sun J. Instance-aware semantic segmentation via multi-task network cascades. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2016. 3150-3158.[doi: 10.1109/CVPR.2016.343]

|

| [114] |

Caruana R. Multitask learning. Machine Learning, 1997, 28(1): 41-75.

[doi:10.1023/A:1007379606734] |

| [115] |

Li Y, Qi H, Dai J, Ji X, Wei Y. Fully convolutional instance-aware semantic segmentation. In: Proc. of the Computer Vision and Pattern Recognition. 2017. 4438-4446.[doi: 10.1109/CVPR.2017.472] http://ieeexplore.ieee.org/document/8099955/

|

| [116] |

Dai J, He K, Li Y, Ren S, Sun J. Instance-sensitive fully convolutional networks. In: Proc. of the European Conf. on Computer Vision. Springer-Verlag, 2016. 534-549. http://link.springer.com/chapter/10.1007/978-3-319-46466-4_32

|

| [117] |

Silberman N, Sontag D, Fergus R. Instance segmentation of indoor scenes using a coverage loss. In: Proc. of the European Conf. on Computer Vision. Springer-Verlag, 2014. 616-631.

|

| [118] |

Chen YT, Liu X, Yang MH. Multi-instance object segmentation with occlusion handling. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2015. 3470-3478.[doi: 10.1109/CVPR.2015.7298969] http://ieeexplore.ieee.org/document/7298969/

|

| [119] |

Liang X, Wei Y, Shen X, Jie Z, Feng J, Lin L, Yan S. Reversible recursive instance-level object segmentation. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2016. 633-641.[doi: 10.1109/CVPR.2016.75] http://www.oalib.com/paper/4055027

|

| [120] |

Wu Z, Song S, Khosla A, Yu F, Zhang L, Tang X, Xiao J. 3D shapenets: A deep representation for volumetric shapes. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2015. 1912-1920.[doi: 10.1109/CVPR.2015.7298801] http://www.oalib.com/paper/4081952

|

| [121] |

Prokhorov D. A convolutional learning system for object classification in 3-D LIDAR data. IEEE Trans. on Neural Networks, 2010, 21(5): 858-863.[doi: 10.1109/TNN.2010.2044802] http://med.wanfangdata.com.cn/Paper/Detail/PeriodicalPaper_PM20350849

|

| [122] |

Su H, Maji S, Kalogerakis E, Learned-Miller E. Multi-view convolutional neural networks for 3D shape recognition. In: Proc. of the IEEE Int'l Conf. on Computer Vision. 2015. 945-953.[doi: 10.1109/ICCV.2015.114] http://www.oalib.com/paper/4075030

|

| [123] |

Huang J, You S. Point cloud labeling using 3D convolutional neural network. In: Proc. of the Int'l Conf. on Pattern Recognition (ICPR). IEEE, 2016.[doi: 10.1109/ICPR.2016.7900038] http://ieeexplore.ieee.org/document/7900038/

|

| [124] |

Qi CR, Su H, Mo K, Guibas LJ. PointNet: Deep learning on point sets for 3D classification and segmentation. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2017. 77-85.[doi: 10.1109/CVPR.2017.16] http://ieeexplore.ieee.org/document/8099499/

|

| [125] |

Valipour S, Siam M, Jagersand M, Ray N. Recurrent fully convolutional networks for video segmentation. In: Proc. of the Applications of Computer Vision. 2017. 29-36.[doi: 10.1109/WACV.2017.11] http://ieeexplore.ieee.org/document/7926594/

|

| [126] |

Fayyaz M, Saffar MH, Sabokrou M, Fathy M, Klette R, Huang F. STFCN: Spatio-temporal FCN for semantic video segmentation. arXiv preprint arXiv: 1608.05971, 2016.

|

| [127] |

Shelhamer E, Rakelly K, Hoffman J, Darrell T. Clockwork convnets for video semantic segmentation. In: Proc. of the European Conf. on Computer Vision. Springer-Verlag, 2016. 852-868.[doi: 10.1007/978-3-319-49409-8_69] http://link.springer.com/chapter/10.1007/978-3-319-49409-8_69

|

| [3] |

姜枫, 顾庆, 郝慧珍, 李娜, 郭延文, 陈道蓄.基于内容的图像分割方法综述.软件学报, 2017, 28(1): 160-183. http://www.jos.org.cn/1000-9825/5136.htm[doi: 10.13328/j.cnki.jos.005136]

|

| [4] |

魏云超, 赵耀. 基于DCNN的图像语义分割综述. 北京交通大学学报, 2016, 40(4): 82-91.

[doi:10.11860/j.issn.1673-0291.2016.04.013] |

| [61] |

刘建伟, 黎海恩, 罗雄麟. 概率图模型学习技术研究进展. 自动化学报, 2014, 40(6): 1025-1044.

[doi:10.3724/SP.J.1004.2014.01025] |

| [65] |

宋熙煜, 周利莉, 李中国, 陈健, 曾磊, 闫镔. 图像分割中的超像素方法研究综述. 中国图像图形学报, 2015, 20(5): 599-608.

[doi:10.11834/jig.20150502] |

2019, Vol. 30

2019, Vol. 30