2. 智能信息处理与实时工业系统湖北省重点实验室(武汉科技大学), 湖北 武汉 430065

2. Hubei Province Key Laboratory of Intelligent Information Processing and Real-time Industrial System(Wuhan University of Science and Technology), Wuhan 430065, China

随着多媒体技术和互联网通信的飞速发展, 多媒体数据已经广泛应用于我们日常生活中的各个角落.例如在监控应用中, 2009年公安部启动的平安城市工程项目, 已于2015年实现全国公安机关多媒体数据的大规模联网调度和资源共享.同时, 近年来兴起的智慧城市建设项目, 也进一步推动了多媒体数据的集中云存储和各系统之间的整合协同.安防监控具有7×24全天候不间断作业的特点, 特别是在夜间时段, 不仅事件多发而且容易造成严重后果.采用传统的人工监控方式不仅工作劳动强度大而且抽检率低, 因此, 探索具备主动环境感知能力的夜间场景显著性对象检测模型具有重要意义.

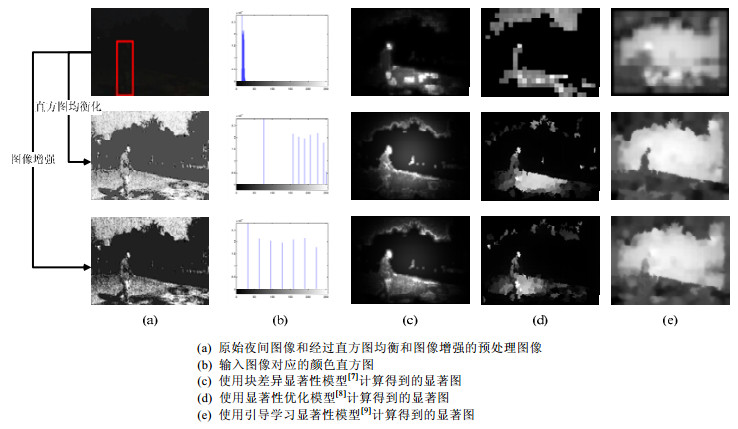

根据视觉注意机制, 人类能从夜间图像等复杂场景中迅速感知视觉显著性目标[1].借助这种选择性视觉注意机制, 在实际应用中, 可以将有限的计算资源优先用于处理场景中的显著性信息, 进而选择性地忽略场景中的非显著性信息.目前, 视觉显著性对象检测模型已被广泛应用于图像分割[2, 3]、对象识别[4, 5]、图像检索[6]等.然而现有的大多数视觉显著性对象检测模型仅适用于可见光环境, 其在夜间图像环境中会遇到极大的挑战.夜间图像的低信噪比和低对比度特性, 会导致特征对比度测度容易受到噪声干扰、弱纹理模糊、场景背景变化、摄像头运动等多方面因素的影响, 给夜间图像的显著性对象检测带来困难.如图 1所示, 近年来提出的视觉显著性模型难以准确描述夜间图像中的显著性信息[7-9].利用直方图变换等预处理方法来增强图像对比度, 从而获得灰度值丰富的图像能取得一定的效果, 然而直方图均衡是对图像中的所有像素点进行变换, 包括图像中的边缘像素点、平滑非噪声像素点、噪声像素点等, 这样容易导致伪边缘和过曝光等问题[10].

|

Fig. 1 Results of the state-of-the-art saliency models 图 1 夜间图像中显著性对象检测模型的结果对比 |

考虑到图像特征对比度对于夜间场景中的显著性对象检测有着重要的作用[11], 我们在前期工作中探索了能有效表示夜间图像显著性的特征对比度[12].为了能更好地抑制背景噪声, 并突出显著性对象的细节信息, 本文提出了一种基于区域协方差和全局搜索算法的夜间图像显著性对象检测模型.该模型的主要贡献包括:为了有效表示场景中的显著性信息, 我们引入超像素协方差来整合不同的图像特征; 与基于学习的方法相比, 我们提出的模型不需要任何训练过程; 结合全局搜索算法能够有效抑制夜间图像中的背景噪声干扰; 为了验证提出模型的有效性, 我们专门构建了一个夜间图像数据集; 通过在6个数据集上的实验测试, 我们从主观和客观两方面综合比较了提出模型与11种目前的主流模型的性能.

本文提出的模型主要包括4个步骤.

(1) 将输入图像进行超像素分割, 保留内部结构信息;

(2) 构建图像特征(亮度、方向、锐度和光谱)的协方差矩阵, 通过非线性融合这些特征来表示夜间图像的显著性信息;

(3) 测度超像素块与其邻接超像素块之间的区域协方差来计算局部显著性, 然后使用全局搜索算法来优化超像素块的显著值结果.结合局部和全局方法能有效抑制背景噪声干扰, 从而突出显著性对象的细节信息;

(4) 通过图扩散过程来精炼各个超像素的显著值.

本文提出的夜间图像显著性对象检测模型的框架如图 2所示.

|

Fig. 2 Overview of the proposed model for salient object detection for nighttime images 图 2 本文提出的夜间图像显著性对象检测模型的框架 |

本文第1节介绍相关工作.第2节描述提出的夜间图像显著性对象检测模型.第3节展示提出的模型与现有主流的显著性对象检测模型在6个数据集上的实验结果.第4节总结本文工作.

1 相关工作视觉显著性检测可以直观地定义为一种过滤工作, 其目的是检测图像中的感兴趣区域(regions of interest, 简称ROI), 而过滤掉不相关的背景区域.图像中的显著性区域相比其邻域会更加吸引人类视觉注意, 因此, 现有研究通常将图像对比度作为检测视觉显著性的首选特征, 并将其作为反映人类视觉注意的最重要的因素之一[13].根据计算方式的区别, 现有的显著性对象检测模型可以分为两类:局部对比度和全局对比度.

Itti等人提出了一种经典的局部对比度显著性对象检测模型, 该模型通过结合强度、颜色和方向这3个特征的对比度来生成显著图[14].在Itti模型的启发下, 近年来出现了各种各样的基于局部对比度的显著性对象检测模型.例如:Ma和Zhang提出了通过局部对比度的分析框架来生成显著图, 并利用模糊增长模型来检测显著性对象[15]; Harel等人提出了一种基于图论的方法, 其首先利用Itti的模型来创建特征图, 然后通过对激活图的归一化来生成最终显著图[16]; Zhang等人则使用了具有空间色彩过滤特性的局部颜色描述符来构建显著性模型[17].基于局部对比度的显著模型能较好地检测图像显著性对象, 然而这类模型的主要问题在于:其通常会在显著性对象的边缘附近产生较高的显著值, 难以突出整个对象区域, 因而在夜间图像上容易受到噪声干扰.

基于全局对比度的显著性对象检测模型则是对整个图像进行处理, 因此能够被均匀地突出整个显著性对象区域.例如:Xia等人将Itti的中心周边对比模型扩展到了非局部区域, 并提出了一种基于非局部重构的显著性模型来突出全局对比度和独特性[18]; Lin等人则通过计算像素和超像素级的对比度来构建显著区域检测模型, 该模型整合了独特性和空间分布特性的全局特征[19]; 我们在前期工作中也以全局特征的独特性为出发点, 利用图像对比度特征和颜色分布特性来检测显著性对象[20].基于全局对比度的显著性模型能均匀地突出整个显著性对象区域, 然而这类模型在低信噪比的夜间图像上面临着极大的挑战.

考虑到基于局部对比度的方法和基于全局对比度的方法各有优劣, 近年来涌现了一些结合局部对比度和全局对比度的显著性对象检测模型.例如:Zhang等人构建了一种显著性区域学习模式, 从而整合了全局稀有性、局部对比度和中心优先规则[21]; 类似的, Liu等人也提出了一种基于局部和全局对比度表示的图像显著性对象检测模型[22]; Tong等人[23]则提出了一种基于线性编码的显著性检测模型, 以此来融合局部和全局对比度信息.这些模型在可见光场景中取得好的检测效果, 然而它们在夜间图像上会遇到极大的挑战.夜间图像的低信噪比和低对比度特性, 会导致特征对比度测度容易受到噪声干扰、弱纹理模糊、场景背景变化、摄像头运动等多方面因素的影响, 给夜间图像的显著性对象检测带来困难.

现有的面向夜间图像的显著性对象检测研究相对较少, 近年来出现的模型(例如文献[24, 25])能在低信噪比和低对比度环境下取得一定的效果.然而这些模型仅考虑了夜间图像的局部对比度, 容易受到伪边缘等因素的影响.有鉴于此, 本文提出在使用区域协方差的局部对比度计算方法的基础上, 结合全局搜索方法来优化模型的性能:一方面, 基于区域协方差的局部对比度对旋转、尺度缩放以及亮度变化具有很强的适应性, 从而能够有效地将显著性对象从夜间图像中检测出来; 另一方面, 使用全局搜索算法来优化局部对比度的显著性计算结果, 能够均匀地突出整个显著性对象区域, 从而提高模型对于背景噪声的鲁棒性.

2 夜间图像的显著性对象检测模型本文所提出的模型结合了局部和全局显著性, 主要思想是基于中心-周边规则[14]来计算一个区域相对于其周边区域的差异性.本文提出的模型主要包括4个步骤:(1)将图像分割成超像素块, 并构建图模型; (2)计算图像特征的协方差矩阵, 并通过非线性融合这些特征来表示夜间图像的显著性信息; (3)通过协方差描述符来估计每个超像素的局部显著性, 并结合全局搜索算法来优化超像素块的显著值结果; (4)通过图扩散过程来优化生成最终的显著图.

2.1 基于超像素的图模型对于超像素块来说, 其包含的像素在纹理和颜色上都有相似性.因此, 超像素分割可以很好地保留内部像素的形状信息, 这些信息大都属于同一对象.此外, 将图像分割为超像素可以有效减少计算量, 从而缩短计算所需的时间.本文使用了简单线性迭代聚类算法来将输入图像分割为超像素块[26].输入图像首先被分割为多个超像素, 记为SP(i), 其中, i=1, …, N.

将图像分割成N个超像素后, 我们以这N个节点构造图模型G=(V, E), 其中:V代表节点集合, 对应于每个超像素; E代表边集合, 其权值的设置是依据关联矩阵A=[aij]N×N.给出了图模型G和显著性种子s=[s1, s2, …, sN]T, 扩散过程就是基于最优关联矩阵将种子s在图G上扩散显著性种子.其中, 显著性扩散

| $ S' = d \times s $ | (1) |

其中, d表示扩散矩阵, 计算方法如公式(3)中的(I-βL)-1.S'表示每个节点的显著性.

2.2 基于图模型的流行排序流行排序的目标是计算图中每个节点的排名.通过对图的流行排序, 可以更准确地描述超像素之间的相似性.给定图G, 最优排名可以通过最小化能量函数来计算[27]:

| $ S' = \mathop {\arg \min }\limits_S \frac{1}{2}\left( {\sum\nolimits_{i, j = 1}^N {{a_{ij}}{{\left( {\frac{{{S_i}}}{{\sqrt {{d_{ii}}} }}-\frac{{{S_j}}}{{\sqrt {{d_{jj}}} }}} \right)}^2} + \mu \sum\nolimits_{i = 1}^N {{{({S_i}-{s_i})}^2}} } } \right) $ | (2) |

其中, μ用于平衡光滑度和拟合约束,

| $ S' = {(I-\beta \mathit{\Lambda} )^{-1}}s $ | (3) |

其中, I是图G的单位矩阵, 参数β=1/(1+μ)用来控制流行排序中的一元和二元电位的平衡, Λ=D-1/2AD-1/2代表归一化的拉普拉斯矩阵.

2.3 基于协方差的显著性计算本文提出的模型主要使用图像超像素的协方差矩阵来描述局部显著性信息.通过区域协方差来非线性融合图像特征, 可以有效表达图像的结构信息.由于夜间图像具有低信噪比和低对比度特性, 我们在前期工作中探索了能有效表示夜间图像显著性的特征[12], 包括亮度、方向、锐度和频谱.基于这些特征, 输入图像就被转换成了五维特征向量如下所示:

| $ F(x, y) = \left[{Ligh(x, y)\left| {\frac{{\partial I(x, y)}}{{\partial x}}} \right|\left| {\frac{{\partial I(x, y)}}{{\partial y}}} \right|Shar(x, y)Spec(x, y)} \right] $ | (4) |

其中, Ligh(x, y)表示LAB颜色空间中的亮度分量, 该特征在夜间图像中是衡量对象显著性的一个重要指标; |∂I/∂x|和|∂I/∂y|代表图像强度一阶导数的范数, 其可以用来表示边缘方向信息; 锐度特征Shar(x, y)可以通过灰度图像和高斯一阶导在垂直和水平方向上的卷积来计算[12]; 频谱特征Spec(x, y)则可以通过计算对数光谱和幅度谱之间的差异来测度[28], 该特征受图像对比度的影响较小, 并且对噪声更加鲁棒.

基于F的计算结果, 每个超像素区域SP(i)可以表示为一个5×5的协方差矩阵[29]:

| $ {C_i} = \frac{1}{{n-1}}\sum\limits_{k = 1}^n {({f_k}-{\mu ^*}){{({f_k}-{\mu ^*})}^T}} $ | (5) |

其中, {fk}k=1, …, n表示SP(i)内部的五维特征点, μ*代表这些点的平均值.

由于夜间图像的对比度和信噪比较低, 现有的低层图像特征难以充分表达场景中的显著性信息.而基于区域协方差的局部对比度则对旋转、尺度缩放以及亮度变化都有很强的适应性, 因此, 本文使用基于区域协方差的局部对比度方法检测夜间图像中的显著性对象, 主要原因包括:

(1) 首先, 协方差矩阵Ci是一个5×5的实对称正定矩阵, 其对角线上的值表示每个独立的特征量, 非对角线上的值表示特征之间的相关量.其大小仅仅取决于的特征向量的维数, 也即:所选取选图像特征的个数, 与显著性对象区域的大小无关, 因此, 用协方差描述符检测显著性对象的计算复杂度较小;

(2) 其次, 区域协方差描述符不仅能表征各个特征自身的统计特性, 而且能反映特征之间的相关性.协方差矩阵的非线性融合特性能有效保留夜间图像的特征信息, 从而有效提高显著性对象检测的准确性;

(3) 由于协方差矩阵Ci不再表征区域SP(i)中特征数据的顺序与个数(破坏了像素间的结构特征信息), 因此当显著性对象发生形变、旋转等情况下, 算法也有较好的鲁棒性.因此, 基于协方差特征的局部对比度可以克服夜间图像中显著对象的轮廓信息不完整、内部结构信息不明显等问题;

(4) 同时, 由于计算协方差时减去了特征数据的均值, 所以协方差特征矩阵对光照的变化也具有不敏感的特性.

因此, 本研究选取区域协方差来处理夜间图像.通过协方差矩阵就可以将那些可能相关的特征相互融合.两个协方差矩阵Ci和Cj之间的相似性可以通过公式(6)来定义[30]:

| $ \rho ({C_i}, {C_j}) = \sqrt {\sum\nolimits_{k = 1}^5 {{{\ln }^2}{E_k}({C_i}, {C_j})} } $ | (6) |

其中, {Ek(Ci, Cj)}k=1, …, 5代表Ci和Cj的广义特征值.ρ(Ci, Cj)描述了两个协方差矩阵之间的相似性, 数值越小, 表示两个协方差矩阵越相似; 反之, 则表示其相似度越小.

2.4 基于全局搜索的显著性估计为了提高模型对于背景噪声的鲁棒性, 我们这里使用了全局搜索算法来优化局部对比度的显著性计算结果.考虑到Yang和Deb提出的布谷鸟搜索(cuckoo search, 简称CS)[31]具有控制参数少、搜索路径优、全局优化能力强等优点, 并且已成功用于图像分割[32]和边缘检测[33]等应用, 因此, 我们使用CS算法来对显著值进行优化, 以此来全局搜索超像素块中差异最大的区域, 从而得到最优显著值.

2.4.1 基于CS算法的显著性估计这里, 我们将测度图像中两个区域的差异性问题转化为了比较这两个区域协方差矩阵之间的相似度大小.基于中心-周边规则[14], 在显著性对象检测的计算中, 一个区域相对于其周边区域的差异性越大, 则其显著性越明显, 该区域也就越可能在显著性对象中.这里, 我们将SP(i)的显著性定义为该超像素块与其相邻超像素块的协方差矩阵差异性.由于每个对称的正定矩阵(协方差矩阵)具有唯一因式分解的属性, 其元素可以在欧几里德空间中构造成一组点, 称为Sigma点.这样就可以直接并入特征的平均向量, 整合一阶和二阶的统计编码, 得到一个丰富的特征表示[34].对于SP(i)的协方差矩阵Ci, 利用Cholesky分解可得到Ci=LLT, 其对应的Sigma点记为Sig={pk}, 计算如下:

| $ {p_k} = \left\{ {\begin{array}{*{20}{l}} {a\sqrt 5 {L_k}, {\rm{ if }}\;\;1 \le k \le 5}\\ {-a\sqrt 5 {L_k}, {\rm{ if }}\;\;5 + 1 \le k \le 2 \times 5} \end{array}} \right. $ | (7) |

其中, Lk代表下三角矩阵L的第k列, a通常设置为

| $ \mathit{\Psi} \left( {{C_i}} \right) = {({\mu ^*}, {p_1}, \ldots, {p_5}, {p_6}, \ldots, {p_{10}})^T} $ | (8) |

接下来我们计算SP(i)的显著性, 将SP(i)与其相邻的区域进行相似性度量.对于SP(i), 将其超像素区域记为Ri, 根据图模型中Ri的邻接矩阵, 得到与其相邻的超像素区域, 记为{Rj}j=1, …, num(i), num(i)为Ri的邻接超像素区域的个数, Ri的显著性可以由其与邻接区域之间的协方差相似度的加权平均值来计算:

| $ s({R_i}) = \frac{1}{{num(i)}}\sum\nolimits_{j = 1}^{num(i)} {d({R_i}, {R_j})} $ | (9) |

其中, d(Ri, Rj)为超像素区域Ri和Rj的差异性, 计算如下:

| $ d({R_i}, {R_j}) = \frac{{||\mathit{\Psi} ({C_i})-\mathit{\Psi} ({C_j})||}}{{1 + ||{c^*}(i)-{c^*}(j)||}} $ | (10) |

其中, Ψ(Ci)和Ψ(Cj)代表协方差矩阵的向量表示, c*(i)和c*(j)分别代表超像素区域Ri和Rj的中心像素点坐标.

为了优化显著值结果, 我们需要对Ri的邻接超像素区域{Rj}j=1, …, num(i)进行搜索, 选出其中最相似的区域.如果Ri与其最相似的区域都具有较高的差异性, 那么与其他相邻的超像素区域会有更高的差异性.因此, 我们的任务就是找到与Ri最相似的最优邻接区域.由于CS算法具有控制参数少、搜索路径优、全局优化能力强等优点, 在解决许多优化问题中表现出了更高效的搜索效果[35], 为了获得更加理想的超像素块显著值, 我们利用基于CS算法来搜索和产生{Rj}j=1, …, num(i)中与Ri最相似的区域, 从而计算Ri的最优显著值.CS算法的主要步骤如下.

步骤1:鸟窝初始化.对于Ri, 我们将其邻接矩阵中的相邻区域{Rj}j=1, …, num(i)协方差矩阵的向量表示{Ψ(Cj)}j=1, …, num(i)作为鸟窝, 邻接超像素的个数num(i)即为鸟窝数目, 将Ψ(Cj)包含元素的个数55作为鸟蛋的个数, 即解空间的维度.

步骤2:根据适应度函数初始化每个鸟窝的质量, 也即估计{Ψ(Cj)}j=1, …, num(i)的初始值, 由公式(8)求得.

步骤3:每个鸟窝主人通过Levy flight飞行模式来改进自己的鸟窝.我们通过改进后的邻接超像素区域, 并与改进前的邻接超像素区域进行比较, 按照贪婪法则保留与Ri最相似的区域, Ψ(Cj)的更新方式如下:

| $ \mathit{\Psi} {\left( {{C_j}} \right)^{(t + 1)}} = \mathit{\Psi} {\left( {{C_j}} \right)^{(t)}} + a \oplus S $ | (11) |

其中, t表示当前迭代次数; α为步长控制参数, 其值服从标准正态分布; ⊕表示点对点乘法; S为Levy flight搜索路径, 即飞行时的步长:

| $ S = 0.01 \times \frac{u}{{|v{|^{1/\beta }}}} \times ({g_{best}}-\mathit{\Psi} {({C_j})^{(t)}}) $ | (12) |

其中, 系数0.01是Levy flight中典型的飞行尺度; u和v服从均匀分布, 即

| $ {\sigma _u} = {\left\{ {\frac{{\mathit{\Gamma} (1 + \beta )\sin (\pi \beta /2)}}{{\mathit{\Gamma} [(1 + \beta )/2 \times \beta \times {2^{(\beta-1)/2}}]}}} \right\}^{1/\beta }} $ | (13) |

其中, Γ表示标准伽玛函数, σv=1, 本文取β=3/2, gbest表示当前质量最好的鸟窝(最优的邻接超像素区域).

步骤4:以概率P来用下式改进邻接超像素区域中不理想的超像素块:

| $ \mathit{\Psi} {\left( {{C_j}} \right)^{(t + 1)}} = \mathit{\Psi} {\left( {{C_j}} \right)^{(t)}} + rand'(\mathit{\Psi} {\left( {{C_k}} \right)^{(t)}}-\mathit{\Psi} {\left( {{C_j}} \right)^{(t)}}) $ | (14) |

其中, rand是[0, 1]之间的一个随机数, Ψ(Ck)(t)是Ψ(Cj)(t)是超像素区域Rj附近的超像素区域Rk的协方差矩阵的向量表示.

步骤5:改进后的{Ψ'(Cj)}j=1, …, num(i)与当前最优的{Ψ(Cj)}j=1, …, num(i)进行比较, 并保留与Ψ(Ci)相似度高的值.

步骤6:执行步骤2至步骤5, 直到达到预先设定的搜索次数为止, 输出最优的邻接超像素区域协方差矩阵向量.

步骤7:得到Ψ(Ci)的最优邻接区域的协方差矩阵向量, 记为Ψ'(Cj), 我们由公式(9)和公式(10)计算Ri的最优显著值.

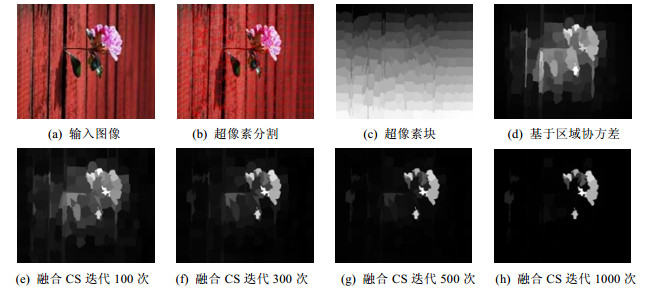

利用CS算法可以全局优化超像素块的显著值.如下图所示, 图 3(d)是未全局优化的基于区域协方差的局部对比度显著图, 图 3(e)~图 3(h)是融合CS全局优化策略得到的显著图, 显著图结果与进行的迭代次数有关.迭代次数越多, 显著图结果就越准确, 相应的算法时间复杂度也会越高.

|

Fig. 3 Results of the cuckoo search based salient object detection model 图 3 基于CS搜索的显著性对象检测模型的结果 |

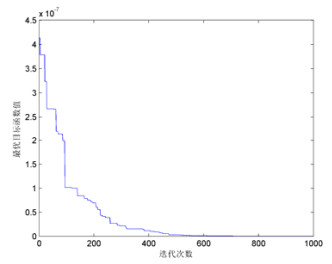

迭代次数与最优目标函数值的相关性如图 4所示.通过迭代, 目标函数值收敛的过程也即求Ψ(Ci)最优相似协方差矩阵向量Y'(Cj)的过程.

|

Fig. 4 Relationship between number of iterations and optimal objective function 图 4 迭代次数与最优目标函数值的关联性 |

2.4.2 CS算法与其他群智能搜索算法的性能对比

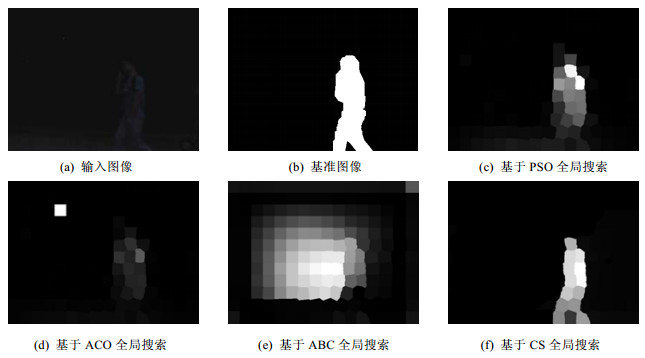

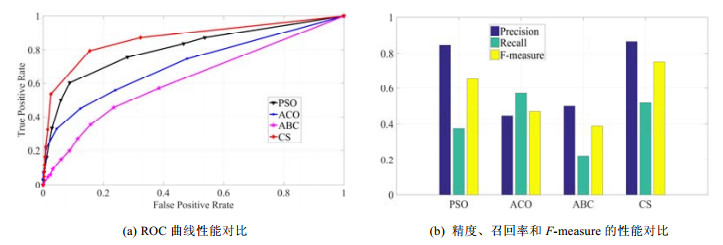

为了验证CS算法的全局显著性对象搜索性能, 本文将其与另外3种群智能搜索算法进行了实验对比, 包括Kennedy和Eberhart提出的粒子群优化算法(particle swarm optimization, 简称PSO)[36]、Dorigo等人提出的蚁群优化算法(ant colony optimization, 简称ACO)[37]以及Karaboga提出的蜂群算法(artificial bee colony, 简称ABC)[38].

PSO, ACO, ABC以及CS算法等都是基于仿生群智能的优化算法, 这些算法在种群进化过程中, 主要通过迭代来进行搜索寻优.我们分别基于CS, PSO, ACO和ABC算法来对显著值进行优化, 以此来全局搜索超像素块中差异最大的区域, 实验得到的显著图如图 5所示.

|

Fig. 5 Subjective comparison of PSO, ACO, ABC and CS based global search algorithm in nighttime images 图 5 基于PSO, ACO, ABC和CS的全局搜索算法在夜间图像数据集上的的主观性能对比 |

如图 5所示, 对比CS算法和其他群智能搜索算法的实验测试结果, CS算法得到的显著图与基准图像具有更高的相似度.此外, 实验还采用了精度、召回率、F-measure和ROC曲线等客观评价指标(计算公式见下节说明)进一步验证了CS算法的全局显著性对象搜索性能, 如图 6所示.

|

Fig. 6 Objective performance comparison of saliency maps based on the global research of PSO, ACO, ABC and CS algorithm 图 6 分别基于PSO, ACO, ABC和CS全局搜索得到显著图的客观性能对比 |

从图 5和图 6中可以看出, CS算法的主观和客观评价指标均优于PSO, ACO和ABC算法.主要原因在于:CS算法具有参数少、收敛速度对参数变化不敏感等特性, 这些特性使得CS算法在面向低信噪比和低对比度的夜间图像时, 能对噪声干扰下的弱光照变化具有较好的鲁棒性, 从而均匀地突出整个显著性对象区域.此外, CS算法使用的大步长和小步长交替方式, 能有效避免全局搜索陷入局部最优解.因此, 本文选用CS算法来进行全局显著性对象搜索.

2.5 基于图扩散的显著值结果优化在计算完所有超像素区域的显著性后, 我们就获得了显著性种子s, 其表示每个图节点的显著值.然后, 通过公式(1)的扩散过程来优化超像素之间的显著值.最终的结果显著图S*被归一化到[0, 1]之间, 归一化计算过程如公式(15):

| $ {S^ * } = \frac{{{S^ * }-\min ({S^ * })}}{{\max ({S^ * })-\min ({S^ * })}} $ | (15) |

归一化后生成的显著图在6个数据集上都表现出了良好性能, 具体的实验结果见下节.

3 实验结果为了综合评估所提出模型的性能, 我们分别在可见光和夜间图像的数据集上进行测试, 实验数据包括:

(1) MSRA数据集[39], 其中的显著性对象是由不同的人类测试者所标记;

(2) SOD数据集[40], 其中的图像包含低对比度的多显著性对象, 每个图像分割工作由3个测试者完成;

(3) CSSD数据集[41], 该数据集具有一定的挑战性, 其中包括了各种复杂场景;

(4) DUT-OMRON数据集[42], 其包括了具有挑战性的图像和对应的基准数据集;

(5) PASCAL-S数据集[43], 其包含具有嘈杂背景的自然图像;

(6) 我们课题组创建的夜间图像数据集(NI), 其包含了大量夜间图像数据, 这些图像的分辨率是640×480.实验选择了200个典型的夜间图像进行测试, 每个图像的基准显著性对象是由3位测试者手工来进行矩形标记, 超像素数目设置为N=200以保证较好的边界召回率.

实验选取了11个目前主流的显著性对象检测模型来与本文所提出的模型进行性能对比, 包括非参数(NP)模型[44]、图像签名(IS)模型[45]、低秩矩阵恢复(LR)模型[46]、上下文感知(CA)模型[47]、块差异性(PD)模型[7]、基于图的流行排序(GBMR)模型[42]、显著性优化(SO)模型[8]、引导学习(BL)模型[9]、细胞自动机(BSCA)模型[48]、全局和局部线索(GL)模型[23]和通用推广(GP)模型[49].我们将这些模型在上述6个数据集上分别进行测试, 实验结果采用这些不同数据集上所有测试图像的平均值.

为了进行客观比较, 我们首先计算真阳率(TPR)和假阳性(FPR)来评估各模型的准确性.给出计算所得的显著图SI(x, y)(0≤SI(x, y)≤1)和对应的基准数据集GT(x, y), 用固定阈值t(0≤t≤1)来生成显著性二值图, 其中, 0表示背景区域, 1表示显著性对象.TPR和FPR可以通过以下方式计算:

| $ TPR = E\left( {\prod\limits_t {{B_t}(x, y) \cdot {G_T}(x, y)} } \right) $ | (16) |

| $ FPR = E\left( {\prod\limits_t {(1-{B_t}(x, y))} \cdot {G_T}(x, y)} \right) $ | (17) |

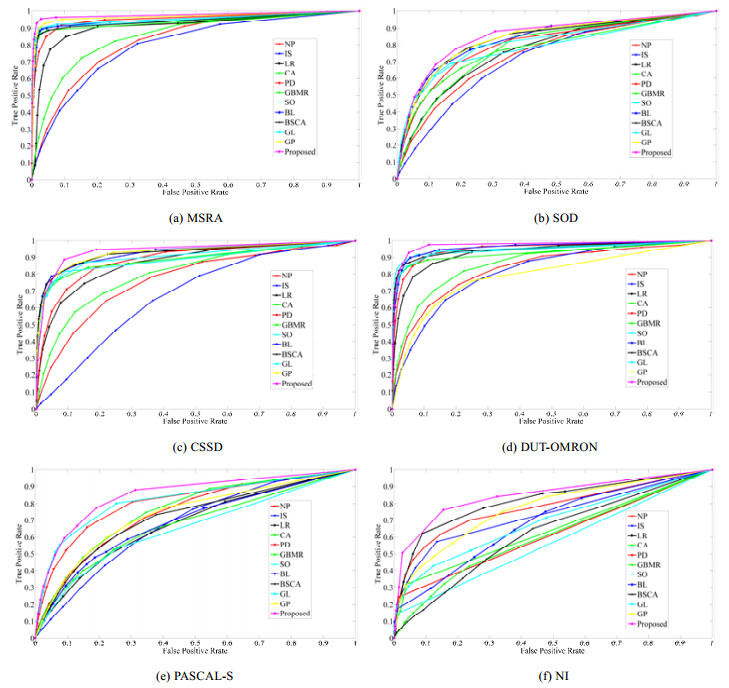

这些显著性对象检测模型在上述6个数据集上的TPR和FPR测试结果见图 7.如图 7所示, 我们提出的模型相比其他11个模型取得了更好的性能.

|

Fig. 7 TPR and FPR performance of the proposed model and eleven saliency models on the six datasets 图 7 本文提出的模型与其他11个显著性模型在6个数据集上的TPR和FPR测试结果 |

曲线面积(AUC)性能评价结果见表 1, 性能最佳的两个模型分别以红色和蓝色字体标注.从表 1中可以看出, 本文所提出的模型在6个数据集上取得了最好的效果.

| Table 1 AUC performance of the proposed model and eleven saliency models on the six datasets 表 1 本文提出的模型与其他11个显著性模型在6个数据集上的AUC测试结果 |

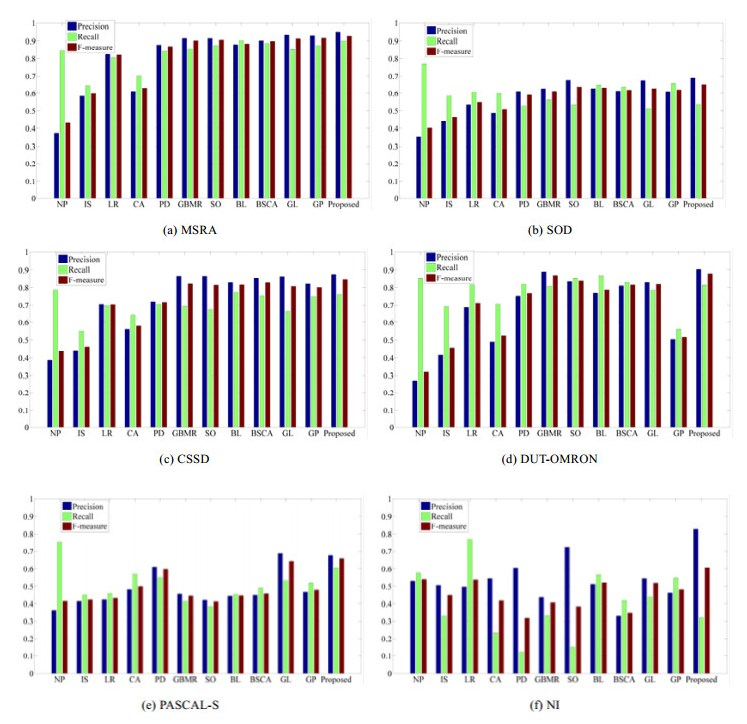

此外, 我们还采用了精度、召回率和F-measure标准来进行性能评估.

● 精度和召回率可以通过以下公式计算:

| $ Precision = \frac{{R({B_m} \cap {G_T})}}{{R({B_m})}} $ | (18) |

| $ Recall = \frac{{R({B_m} \cap {G_T})}}{{R({G_T})}} $ | (19) |

其中, R(·)表示显著区域, 图像对应的基准图像记为GT, 对应的显著图的二值图记为Bm;

● F-measure指标的计算如下:

| $ F-measure = \frac{{(1 + {\beta ^2})precision \cdot recall}}{{{\beta ^2} \cdot precision + recall}} $ | (20) |

这里, 设置β2=0.3作为衡量精度和召回率的参数.

上述显著性模型的精度、召回率和F-measure的性能比较如图 8所示.

|

Fig. 8 Precision, recall, and F-measure performance of the proposed model and eleven saliency models on the six datasets 图 8 本文提出的模型与其他11个显著性模型在6个数据集上的精度、召回率和F-measure测试结果 |

从图 8中可以看出, 本文提出的模型相比其他11个模型取得了更好的精度、召回率和F-measure测试结果.

此外, 实验还采用了平均绝对误差(MAE)来作为评价标准.MAE可以用来反映生成的显著图SI(x, y)与基准数据GT(x, y)之间的相似度, 这里, 相似度可以通过像素平均差来测度:

| $ MAE = \frac{1}{{Width \times Height}}\sum\limits_1^{Width} {\sum\limits_1^{Height} {|{S_I}(x, y)-{G_T}(x, y)|} } $ | (21) |

上述显著性模型的MAE性能比较见表 2.结果表明, 本文提出模型所生成的显著图与基准数据之间具有更高的相似度.

| Table 2 MAE performance of the proposed model and eleven saliency models on the six datasets 表 2 本文提出的模型与其他11个显著性模型在6个数据集上的MAE测试结果 |

实验测试在MATLAB运行环境下, 使用的是配备12GB内存和G2020 CPU的个人台式机电脑.表 3给出了本文提出模型和其他11个模型的运行时间.

| Table 3 Run-time performance of the proposed model and eleven saliency models on the six datasets (s) 表 3 本文提出的模型与其他11个显著性模型在6个数据集上的运行时间(秒) |

从表 3可以看出:IS模型的运行时间最短, 然而其生成的显著图的分辨率较低.而LR, CA和BL模型的运行时间较长, 单幅显著图的平均生成时间超过了40s.对于基于学习的显著性检测算法在构造过程中需要训练和测试模型, 例如BL模型使用了SVM方法来训练模型, 在NI数据库上的单幅显著图的平均生成时间为156.30, 难以满足显著性检测对于实时性的要求.本文提出的模型的运行时间略多于GBMR、SO、BSCA和GP模型, 在个人台式机电脑的MATLAB环境下的平均运行时间也仅在3s左右.主要原因在于:全局搜索耗费了额外的时间, 然而同时也有效提高了模型对于背景噪声的鲁棒性.

最后图 9中显示了上述显著性模型在6个数据集上的主观性能对比.

|

Fig. 9 Subjective comparison of saliency maps using the proposed model and eleven saliency models on the six dataset 图 9 本文提出的模型与其他11个显著模型在6个数据集上的主观性能对比 |

从图 9中可以看出, 基于超像素的GBMR, SO, BSCA, GL, GP模型和我们提出模型所生成的显著图可以均匀突出显著性对象区域, 显著性对象与基准图像的相似度更高; 对于NP模型, 显著图中显著性对象区域和周围环境的区分度较小; 而IS模型生成的显著图包含了太多的背景信息; CA和PD模型生成的显著图能够良好地检测出显著性对象区域, 然而, 其难以反映显著性对象的内部信息; 如图 9中夜间图像数据集的测试结果所示, 我们提出的模型在夜间图像上获得了更好的效果.

4 总结本文提出了一种基于区域协方差和全局搜索的夜间图像显著性对象检测模型, 该模型通过结合局部对比度和全局对比度两方面的信息, 能更好地抑制背景噪声, 并突出显著性对象的细节信息.一方面, 基于区域协方差的局部对比度对旋转、尺度缩放以及亮度变化具有很强的适应性, 从而能够有效地将显著性对象从夜间图像中检测出来; 另一方面, 使用全局搜索算法来优化局部对比度的显著性计算结果, 能够均匀地突出整个显著性对象区域, 从而提高模型对于背景噪声的鲁棒性.

该模型在公开数据集MSRA, SOD, CSSD, DUT-OMRON, PASCAL-S和课题组实际采集的夜间图像数据集NI上进行了测试.实验结果表明:对比目前11种主流的显著性对象检测模型, 我们所提出的模型在可见光图像上取得了较好测试结果的同时, 在夜间图像显著性对象检测中取得了最佳的测试结果.

| [1] |

Najemnik J, Geisler WS. Optimal eye movement strategies in visual search. Nature, 2005, 434(3): 387–391.

[doi:10.1038/nature03390] |

| [2] |

Li Z, Liu G, Zhang D, Xu Y. Robust single-object image segmentation based on salient transition region. Pattern Recognition, 2016, 52: 317–331.

[doi:10.1016/j.patcog.2015.10.009] |

| [3] |

Xu Y, Geraud T, Najman L. Hierarchical image simplification and segmentation based on Mumford-Shah-Salient level line selection. Pattern Recognition Letters, 2016, 83: 278–286.

[doi:10.1016/j.patrec.2016.05.006] |

| [4] |

Tsai YH. Hierarchical salient point selection for image retrieval. Pattern Recognition Letters, 2012, 33(12): 1587–1593.

[doi:10.1016/j.patrec.2012.04.019] |

| [5] |

Yang X, Qian X, Mei T. Learning salient visual word for scalable mobile image retrieval. Pattern Recognition, 2015, 48(10): 3093–3101.

[doi:10.1016/j.patcog.2014.12.017] |

| [6] |

Chen YC, Patel VM, Chellappa R, Phillips PJ. Salient views and view-dependent dictionaries for object recognition. Pattern Recognition, 2015, 48(10): 3053–3066.

[doi:10.1016/j.patcog.2015.01.013] |

| [7] |

Margolin R, Tal A, Zelnik-Manor L. What makes a patch distinct? In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2013. 1139-1146. [doi: 10.1109/CVPR.2013.151] |

| [8] |

Zhu W, Liang S, Wei Y, Sun J. Saliency optimization from robust background detection. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2014. 2814-2821. [doi: 10.1109/CVPR.2014.360] |

| [9] |

Tong N, Lu H, Yang M. Salient object detection via bootstrap learning. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2015. 1884-1892. [doi: 10.1109/CVPR.2015.7298798] |

| [10] |

Kim JY, Kim LS, Hwang SH. An advanced contrast enhancement using partially overlapped sub-block histogram equalization. IEEE Trans. on Circuits and Systems for Video Technology, 2001, 11(4): 475–484.

[doi:10.1109/76.915354] |

| [11] |

Koch C, Ullman S. Shifts in selective visual attention:towards the underlying neural circuitry. Human Neurobiology, 1985, 4(4): 219–227.

[doi:10.1007/978-94-009-3833-5_5] |

| [12] |

Xu X, Mu N, Zhang H, Fu X. Salient object detection from distinctive features in low contrast images. In: Proc. of the IEEE Int'l Conf. on Image Processing. 2015. 3126-3130. [doi: 10.1109/ICIP.2015.7351379] |

| [13] |

Shi K, Wang K, Lu J, Lin L. PISA: Pixelwise image saliency by aggregating complementary appearance contrast measures with spatial priors. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2013. 2115-2122. [doi: 10.1109/CVPR.2013.275] |

| [14] |

Itti L, Koch C, Niebur E. A model of saliency-based visual attention for rapid scene analysis. IEEE Trans. on Pattern Analysis and Machine Intelligence, 1998, 20(11): 1254–1259.

[doi:10.1109/34.730558] |

| [15] |

Ma Y, Zhang H. Contrast-Based image attention analysis by using fuzzy growing. In: Proc. of the 11th ACM Int'l Conf. on Multimedia. 2003. 374-381. [doi: 10.1145/957013.957094] |

| [16] |

Harel J, Koch C, Perona P. Graph-Based visual saliency. In: Proc. of the Annual Conf. on Neural Information Processing Systems. 2006. 545-552. [doi: papers.nips.cc/paper/3095-graph-based-visual-saliency] |

| [17] |

Zhang J, Wang M, Zhang S, Li X, Wu X, Spatiochromatic context modeling for color saliency analysis. IEEE Trans. on Neural Networks and Learning Systems, 2016, 27(6): 1177–1189.

[doi:10.1109/TNNLS.2015.2464316] |

| [18] |

Xia C, Qi F, Shi G, Wang P. Nonlocal center-surround reconstruction-based bottom-up saliency estimation. Pattern Recognition, 2015, 48(4): 1337–1348.

[doi:10.1016/j.patcog.2014.10.007] |

| [19] |

Lin M, Zhang C, Chen Z. Global feature integration based salient region detection. Neurocomputing, 2015, 159: 1–8.

[doi:10.1016/j.neucom.2015.02.050] |

| [20] |

Xu X, Mu N, Chen L, Zhang X. Hierarchical salient object detection model using contrast based saliency and color spatial distribution. Multimedia Tools and Applications, 2016, 75(5): 2667–2679.

[doi:10.1007/s11042-015-2570-0] |

| [21] |

Zhang J, Ding J, Yang J. Exploiting global rarity, local contrast and central bias for salient region learning. Neurocomputing, 2014, 144: 569–580.

[doi:10.1016/j.neucom.2014.04.003] |

| [22] |

Liu J, Wang S. Salient region detection via simple local and global contrast representation. Neurocomputing, 2015, 147: 435–443.

[doi:10.1016/j.neucom.2014.06.041] |

| [23] |

Tong N, Lu H, Zhang Y, Ruan X. Salient object detection via global and local cues. Pattern Recognition, 2015, 48(10): 3258–3267.

[doi:10.1016/j.patcog.2014.12.005] |

| [24] |

Huang K, Wang L, Tan T, Maybank S. A real-time object detecting and tracking system for outdoor night surveillance. Pattern Recognition, 2008, 41(1): 432–444.

[doi:10.1016/j.patcog.2007.05.017] |

| [25] |

Han J, Yue J, Zhang Y, Bai Lf. Salient contour extraction from complex natural scene in night vision image. Infrared Physics & Technology, 2014, 63: 165–177.

[doi:10.1016/j.infrared.2013.12.021] |

| [26] |

Achanta R, Shaji A, Smith K, Lucchi A, Fua P, Susstrunk S. SLIC superpixels compared to state-of-the-art superpixel methods. IEEE Trans. on Pattern Analysis and Machine Intelligence, 2012, 34(11): 2274–2282.

[doi:10.1109/TPAMI.2012.120] |

| [27] |

Zhou D, Weston J, Gretton A, Bousquet O, Scholkopf B. Ranking on data manifolds. In: Proc. of the Neural Information Processing Systems. 2003. 169-176. [doi: papers.nips.cc/paper/2538-pairwise-clustering-and-graphical-models] |

| [28] |

Hou X, Zhang L. Saliency detection: A spectral residual approach. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2007. 1-8. [doi: 10.1109/CVPR.2007.383267] |

| [29] |

Tuzel O, Porikli F, Meer P. Region covariance: A fast descriptor for detection and classification. In: Proc. of the 9th European Conf. on Computer Vision. 2006. 589-600. [doi: 10.1007/11744047_45] |

| [30] |

Forstner W, Moonen B. A metric for covariance matrices. In: Proc. of the Geodesy-The Challenge of the 3rd Millennium. 2003. 299-309. [doi: 10.1007/978-3-662-05296-9_31] |

| [31] |

Yang XS, Deb S. Cuckoo search via levy flights. In: Proc. of the World Congress on Nature and Biologically Inspired Computing. 2009. 210-214. [doi: 10.1109/NABIC.2009.5393690] |

| [32] |

Pare S, Kumar A, Bajaj V, Singh GK. A multilevel color image segmentation technique based on cuckoo search algorithm and energy curve. Applied Soft Computing, 2016, 47: 76–102.

[doi:10.1016/j.asoc.2016.05.040] |

| [33] |

Gonzalez CI, Castro JR, Melin P, Castillo O. Cuckoo search algorithm for the optimization of type-2 fuzzy image edge detection systems. In: Proc. of the IEEE Congress on Evolutionary Computation. 2015. 449-455. [doi: 10.1109/CEC.2015.7256924] |

| [34] |

Erdem E, Erdem A. Visual saliency estimation by nonlinearly integrating features using region covariances. Journal of Vision, 2013, 13(4): 1–20.

[doi:10.1167/13.4.11] |

| [35] |

Cuevas E, Gálvez J, Hinojosa S, Avalos O, Zaldívar DM. Pérez-Cisneros. A comparison of evolutionary computation techniques for ⅡR model identification. Journal of Applied Mathematics, 2014, 2014: 1-15. [doi: 10.1155/2014/827206] |

| [36] |

Kennedy J, Eberhart RC. Particle swarm optimization, In: Proc. of the IEEE Int'l Conf. on Neural Networks. 1995. 1942-1948. [doi: 10.1109/ICNN.1995.488968] |

| [37] |

Dorigo M, Birattari M, Thomas S. Ant colony optimization. IEEE Computational Intelligence Magazine, 2006, 1(4): 28–39.

[doi:10.1109/MCI.2006.329691] |

| [38] |

Karaboga D. An idea based on honey bee swarm for numerical optimization. Tech. Rep. TR06, Vol. 200, Erciyes University, Engineering Faculty, Computer Engineering Department, 2005. [doi: citeulike-article-id:6592152] |

| [39] |

Liu T, Sun J, Zheng NN, Tang X, Shum HY. Learning to detect a salient object. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2007. 1-8. [doi: 10.1109/CVPR.2007.383047] |

| [40] |

Movahedi V, Elder JH. Design and perceptual validation of performance measures for salient object segmentation. In: Proc. of the IEEE Computer Society Conf. on Computer Vision and Pattern Recognition Workshops. 2010. 49-56. [doi: 10.1109/CVPRW.2010.5543739] |

| [41] |

Yan Q, Xu L, Shi J, Jia J. Hierarchical saliency detection. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2013. 1155-1162. [doi: 10.1109/CVPR.2013.153] |

| [42] |

Yang C, Zhang L, Lu H, Ruan X, Yang MH. Saliency detection via graph-based manifold ranking. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2013. 3166-3137. [doi: 10.1109/CVPR.2013.407] |

| [43] |

Li Y, Hou X, Koch C, Rehg J, Yuille A. The secrets of salient object segmentation. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2014. 280-287. [doi: 10.1109/CVPR.2014.43] |

| [44] |

Murray N, Vanrell M, Otazu X, Parraga CA. Saliency estimation using a non-parametric low-level vision model. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2011. 433-440. [doi: 10.1109/CVPR.2011.5995506] |

| [45] |

Hou X, Harel J, Koch C. Image signature:Highlighting sparse salient regions. IEEE Trans. on Pattern Analysis and Machine Intelligence, 2012, 34(1): 194–201.

[doi:10.1109/TPAMI.2011.146] |

| [46] |

Shen X, Wu Y. A unified approach to salient object detection via low rank matrix recovery. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2012. 853-860. [doi: 10.1109/CVPR.2012.6247758] |

| [47] |

Goferman S, Zelnik-Manor L, Tal A. Context-Aware saliency detection. IEEE Trans. on Pattern Analysis and Machine Intelligence, 2012, 34(10): 1915–1926.

[doi:10.1109/TPAMI.2011.272] |

| [48] |

Qin Y, Lu H, Xu Y, Wang H. Saliency detection via cellular automata. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2015. 110-119. [doi: 10.1109/CVPR.2015.7298606] |

| [49] |

Jiang P, Vasconcelos N, Peng J. Generic promotion of diffusion-based salient object detection. In: Proc. of the IEEE Int'l Conf. on Computer Vision. 2015. 217-225. [doi: 10.1109/ICCV.2015.33] |

2018, Vol. 29

2018, Vol. 29