自然语言文本中的信息除了确定的表达以外, 还包含否定、推测等非确定类型的信息.不确定和否定信息抽取任务即负责从自然语言文本中识别不确定、否定等非事实信息, 以区别事实信息.其中, 不确定信息的整体或部分具有或然性, 在认知程度上介于否定和肯定之间[1]; 否定信息包括否定运算符和受其影响且语义反转的文本元素[2].不确定和否定信息抽取研究是自然语言处理领域很多任务的基础, 例如, 问答系统[3, 4]、观点检测[5]、文本蕴含[6-8]、情感分析[9]、事件可信度识别[10, 11]等都需要区别事实信息、不确定信息和否定信息.

不确定和否定信息识别主要包含两个子任务.

1) 线索词识别(cue detection).线索词是指具有不确定或者否定语义的词语或者短语.例如, 例句1中的不确定线索词may和例句2中的否定线索词not.本文中, 线索词用粗体字表示.

2) 作用范围识别(scope detection).作用范围是线索词在语义上管辖或者作用的文本范围, 通常情况下是句子中连续的文本片段.例如, 例句1中不确定线索词may的作用范围“may rain any time”以及例句2中否定线索词not的作用范围“not cause chronic liver disease”.本文中, 作用范围用下划线表示.

例句1: It may rain any time due to the dark clouds in the sky. (天随时都可能下雨, 因为乌云已布满天空.)

例句2: This virus infection does not cause chronic liver disease and is rarely fatal. (这种病毒感染不会引起慢性肝病且很少致命.)

目前, 在线索词识别方面, 相关工作已经取得了较好的性能.例如, Tang等人[12]使用基于条件随机场(conditional random field, 简称CRF)模型和大规模基于边界(large margin-based model)模型的级联系统, 考虑的特征包括词性、命名实体、语义组块等, 在CoNLL2010-Task1B中, 基于BioScope语料[13]的不确定线索词识别任务上获得了最好性能, 其F1值为86.36.

传统的不确定和否定作用范围的识别方法主要可分为基于规则的方法[14, 15]、基于统计的方法[12, 16, 17]以及规则和统计相结合的方法[18].其中, 在不确定作用范围识别方面, Zou等人[16]采用基于树核的方法, 在BioScope的Abstracts子语料上取得的精确率PCS为84.21%, 但是在Full Papers子语料上的识别精确率PCS仅为67.24%;Velldal等人[18]使用了规则和统计结合的模型, 在Full Papers上获得PCS值为75.15%, 然而在Abstracts上PCS为79.56%.相对于线索词识别任务, 作用范围识别性能有待提高.因此, 本文致力于作用范围识别任务.

近年来, 神经网络模型已经应用于自然语言处理领域中的各种任务, 并且取得了较好的成果, 例如语义角色标注[19, 20]、情感分析[21, 22]、事件抽取[23, 24]、关系识别[25-27]、机器翻译[28, 29]等.其中, 基于长短时记忆(long short- term memory, 简称LSTM)单元的神经网络[30]是循环神经网络(recurrent neural network, 简称RNN)的一种.LSTM神经网络模型不仅能从句子中学习到有效的特征[20, 21], 也可以从句法树路径中获得有用的信息[25, 26].

目前, 神经网络模型在不确定和否定作用范围识别任务上的应用还较少[31, 32].本文提出了一种基于两层双向LSTM神经网络的不确定和否定作用范围识别方法.首先, 对于从线索词到词语的句法路径, 使用第1层双向LSTM神经网络从句法路径中学习到有用特征; 接着, 将基本词法特征与句法路径特征一起组成当前词语的特征表示; 最后, 将作用范围识别问题看作序列标注任务, 利用第2层双向LSTM神经网络标注句子中的词语, 界定当前线索词的作用范围.实验结果表明, 本文提出的模型优于其他神经网络模型, 并在BioScope生物医学语料上取得了良好性能.

本文第1节介绍不确定和否定作用范围以及神经网络模型的相关工作.第2节详细阐述本文提出的用于识别不确定和否定作用范围的两层双向LSTM神经网络模型.第3节介绍BioScope语料库和实验设置, 并对实验结果进行详细分析.最后, 第4节给出本文的结论并展望未来的工作.

1 相关工作本节首先介绍不确定和否定作用范围的相关研究, 然后给出神经网络模型的有关成果, 最后给出基于神经网络的不确定和否定作用范围识别方法的相关工作.

1.1 传统的不确定和否定作用范围识别方法早期的不确定和否定作用范围识别工作主要使用规则方法.Chapman等人[33]研发了基于正则表达式的系统NegEx, 总结了一张否定线索词表, 并认为作用范围由距离线索词6个词以内的词语组成.类似的作用范围识别系统还包括健康记录分类系统NegExpander[34]、基于电子病历记录的Maintaining Electronically Health Records系统[35]等.接着出现了基于启发式规则的方法, 该方法通过提取线索词和作用范围中词语的实体关系、句法关系、语义关系等信息, 总结规则或模板, 界定作用范围.Huang等人[36]提出了基于句法树的启发式规则模型, 判断句法树的词语节点是否属于当前否定线索词的作用范围.Rokach等人[37]构建了一种可以自动学习和获取模板的作用范围识别系统.Özgür等人[14]使用基于句法特征的启发式规则识别作用范围, 在BioScope的Abstracts和Full Papers子语料上达到了79.98%和61.13%的准确率.Øvrelid等人[15]考虑了基于依存句法树结构的启发式规则, 在2010 CoNLL Shared Task的训练语料(BSP)和验证语料(BSE)上分别获得了72.31和66.73的F1值(线索词已知).基于启发式规则的方法能够取得较好的性能, 但是对于具体的任务和不同的语料, 需要人工制定模板和规则, 鲁棒性(robustness)欠佳.

BioScope生物医学文献语料库[13]发布之后, 基于机器学习的不确定和否定作用范围识别方法逐渐占据主流地位.Morante等人[38]将否定作用范围的识别看作词语分类问题, 即判断词语是否位于否定线索词的作用范围之内, 主要考虑了词法特征, 并提出了一种合适的后处理算法, 以确保作用范围是连续的文本.Morante等人[39, 40]进一步利用浅层句法特征对句中词语进行序列标注, 结合了3个分类器, 并使用投票机制判断词语是否属于不确定[39]和否定[40]作用范围.Tang等人[12]使用CRF模型标注作用范围, 考虑的特征包括词语原型、词性、命名实体、语义组块、依存关系等.Zhu等人[41]和Li等人[17]认为, 线索词的作用范围类似于语义角色标注任务中谓词的覆盖域, 可以将线索词看作谓词, 将作用范围的识别看作谓词的论元标注问题, 提出了一种基于浅层语义分析的作用范围识别模型.Zou等人[16]利用基于树核模型提取词语的句法特征, 并针对不同词性的线索词构建各自的分类器, 在BioScope的Abstracts子语料上, 不确定和否定作用范围识别的精确率分别为84.21%和76.90%.Velldal等人[18]提出了一种规则和统计结合的方法, 综合考虑了基于依存结构的规则模型和基于SVM短语排序器(SVM constituent ranker)的统计模型, 在BioScope的Full Papers子语料上, 将不确定和否定作用范围的识别精确率分别提高到75.15%和70.21%.Zou等人[42]构建了汉语语料库, 方法上, 基于序列标注和卷积树核模型, 提出了依存特征和依存结构树特征, 并用剪枝方法简化结构树, 保留有效信息, 过滤无用信息, 最后用元决策树模型对两模型进行融合.该方法在不确定和否定作用范围识别任务上的精确率分别达到58.57%和68.84%.

1.2 循环神经网络循环神经网络能够很好地处理序列信息并从中学习有效特征, 早期应用于图像[43]、语音识别等领域[44].近年来, RNN在自然语言处理领域的任务上也取得了良好性能.Lin等人[45]使用层次结构的RNN对文档建模, 并提出了一种两步训练方法, 在句子调序任务和口语翻译任务上取得了较好的结果.Liu等人[46]提出了一种多时间标度(multi time-scale)的LSTM神经网络模型提取句子和文档表示, 在4个数据集上的实验结果表明, 该模型优于其他神经网络模型.Zhou等人[47]构建了基于注意力(attention)机制的双向LSTM网络, 从句子中学习特征用于关系分类, 仅考虑句子的词向量, 而不考虑其他由NLP工具产生的词法或者句法特征.在文档级情感分类任务方面, 研究人员一般构造层次结构的神经网络模型用于学习文档的特征表示.例如:Tang等人[48]先用LSTM网络从词向量中学习句子的向量表示, 然后用双向的门限RNN(gated RNN)从句子向量中学习文档的向量表示; Chen等人[49]则构造了两层LSTM网络, 并考虑了用户和产品的注意力机制.

RNN不仅能够学习到句子中的信息, 还可以从句法树路径中学习到有用的特征表示.Roth等人[19]利用LSTM网络抽取依存路径的特征, 用于语义角色标注.在关系分类任务方面:Xu等人[25]采用多通道(multichannel)的LSTM网络, 考虑了实体之间词语、词性、依存关系、上位词(hypernym)这4种依存路径; Cai等人[26]提出了一种循环-卷积神经网络(recurrent convolutional neural network), 该网络中包含有双向的二通道(two-channel) LSTM网络, 学习词语路径、依存关系路径两种依存路径的特征表示.类似地, 本文提出的模型中包含一个双向LSTM网络用于从句法路径中学习到有效特征.

1.3 基于神经网络的不确定和否定作用范围识别方法近年来, 研究人员开始将神经网络模型应用于作用范围识别任务.Fancellu等人[31]将作用范围识别问题看作是词序列标注问题, 考虑了词语本身、线索词、词性等词法特征, 利用双向LSTM模型识别作用范围.Qian等人[32]则提出了一种卷积神经网络模型, 针对从线索词到当前词的句法路径, 在进行卷积操作时考虑了路径中的每个语法单位(包括句中的词语、短语标记、依存关系等)的上下文, 提取每个维度的最大值、最小值、加权平均值作为句法路径的特征表示, 并结合线索词与当前词位置之差的特征, 判断当前词是否位于线索词的作用范围之内.该模型在BioScope语料上取得了较好的性能.其中, 在Abstracts和Clinical Reports子语料上, 不确定作用范围识别精确率分别为85.75%和73.92%, 否定作用范围识别则分别为77.14%和89.66%.

本文是Qian[32]工作的扩展, 提出了一种两层的双向LSTM模型用于识别不确定和否定作用范围.本文方法和Fancellu等人[31]、Qian等人[32]、Zou等人[42]的工作的主要区别如下.

1) Fancellu等人[31]基于词法特征, 构建了一个基于双向LSTM的否定作用范围识别模型.本文在特征和模型结构两方面不同于该系统:首先, 除了Fancellu等人[31]使用词语的上下文信息, 本文还加入了词语与线索词之间的句法信息, 用于获得句子内在的句法结构信息; 其次, 不同于Fancellu等人[31]使用的单层双向LSTM模型仅用于识别否定作用范围, 本文提出了一种两层的双向LSTM模型用于识别不确定和否定作用范围.该模型先使用一个双向LSTM神经网络从句法路径中学习有效的句法路径特征; 接着, 将词法特征与句法路径特征组成当前词语的特征表示, 利用另一个双向LSTM神经网络识别当前线索词的作用范围.

2) Qian等人[32]使用CNN从线索词与词语之间的句法路径中学习到了有效信息, 从而识别不确定和否定作用范围.本文在采用的特征和神经网络模型上不同于该文:首先, 本文在Qian等人[32]使用的句法特征的基础上, 把当前词语的上下文信息和句法特征进行和有效的融合, 用于识别不确定和否定作用范围; 其次, 不同于Qian等人[32]使用的CNN, 本文引入了两层的双向LSTM模型, 实验结果表明, 更加有利于作用范围识别任务.

3) 语言上, Zou等人[42]面向汉语, 本文面向英语; 模型上, Zou等人[42]使用了卷积树核模型和元决策树模型, 而本文采用了神经网络模型; 特征上, 与本文类似, Zou等人[42]考虑了基于依存句法树的特征.具体来说, Zou等人[42]不仅考虑了包括依存句法路径在内的基本依存特征, 还从依存句法树中抽取了词原型树、词性树和依存关系树等3类特征树结构, 并提出了最小完全树、路径树、上下文相关路径树等3种剪枝方法简化树结构; 而本文从依存句法树中抽取词语到达线索词的最短路径.与Zou等人[42]相比, 本文的特征较少且更容易获得.实验结果表明, 本文的神经网络模型能够在生物医学语料上取得较好的性能.

2 基于两层双向LSTM神经网络的不确定和否定作用范围识别模型本节详细阐述基于两层双向LSTM(bidirectional LSTM, 简称BiLSTM)神经网络的不确定和否定作用范围识别模型.首先介绍用于区分词语是否位于作用范围之内的标签框架; 接着介绍本文使用的特征, 其中, 线索词和当前词之间的句法路径特征用一个双向LSTM学习得到; 最后, 使用另一个双向LSTM产生句子中各个词语的标签, 从而识别当前线索词的作用范围.

2.1 标签框架本文采用以下CIO标签框架.对于每一个词语, 为其指定一个标签, 用以表示该词是否位于作用范围之内:

1) 如果一个词语是线索词(Cue), 那么, 该词的标签为C.根据BioScope对作用范围的定义, 线索词一定位于作用范围之内.因此, 本文对线索词单独指定标签, 和其他词语加以区分.

2) 如果一个词语不是线索词, 且位于作用范围之内(In the scope), 那么, 该词的标签为I.

3) 如果一个词语位于作用范围之外(Out of the scope), 那么该词的标签为O.

例句3显示了句中每一个词语的标签(当前线索词是may):

例句3: The/O researchers/O claimed/O that/O animals/I may/C be/I affected/I by/I the/I bisphenol/I in/I clinical/I studies/I, /O while/O these/O levels/O were/O not/O enough/O to/O cause/O harm/O to/O humans/O./O

由于线索词一定位于作用范围之内, 因此本文使用的标签框架类似于其他工作使用的二类标签框架[16, 31].一些研究人员使用了3类标签框架[12, 39, 50], 将作用范围的第1个单词或者最后一个单词单独予以标记.由于作用范围首尾词与其余单词相比属于绝对少数, 因此, 这类标签框架有可能导致标签分布不平衡的问题.本文使用的标签框架则可以避免这类问题.

2.2 输入表示对于每一个词语, 本文考虑的特征表示包括与线索词的相对位置特征、线索词特征信息、句法路径特征信息.其中, 线索词的相对位置、线索词特征信息为基本特征.句法路径特征由一个双向LSTM神经网络学习得到.获得句子中的每一个词语的特征表示之后, 整个句子进入另一个双向LSTM神经网络, 最后交给softmax分类器, 获得输出结果, 即每个词语的每个标签的概率.下面介绍这3个特征表示.

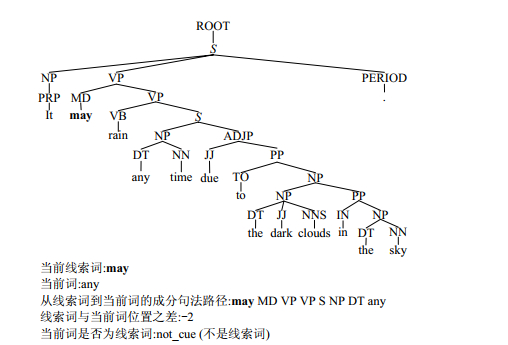

● 相对位置(relative position)已被证明在作用范围识别[32]以及关系分类[51]、事件抽取[23]等其他自然语言处理任务中是一个很有用的特征.本文中, 每个词语的相对位置被定义为线索词位置与当前词语位置之差.例如, 在例句1中, 线索词may和当前词语any的位置之差为-2, 如图 1所示.相对位置特征被映射为一个drp维的向量frp.

|

Fig. 1 Constituency parse tree of the example sentence 1 and all the features of the current word 图 1 例句1的成分句法树和当前词的所有特征 |

● 线索词信息用以表示当前词是否为线索词.Fancellu等人[31]仅将当前词区分为线索词和非线索词.考虑到每个线索词的作用范围可能有不同的语法结构, 我们认为有必要区分不同的线索词.因此, 本文的线索词信息定义为:若当前词是线索词, 则该特征的取值为词语本身; 反之, 若当前词不是线索词, 则该特征的取值为一个特殊的词语“not_cue”.线索词信息被映射为一个d0维的向量fcue, 其维度与词向量维度相同.

● 句法路径特征由双向LSTM神经网络学习得到.相关工作[25, 26, 32]表明, 句法路径可以为自然语言处理相关任务提供有效的特征信息.本文的句法路径定义为:在成分句法树或者依存句法树中, 从线索词到达当前词的路径.图 1和图 2分别显示了例句1中从线索词到当前词的成分句法路径、例句2中从线索词到当前词的依存句法路径以及线索词与当前词的相对位置、线索词信息等特征.其中, 成分句法路径包括词语和成分句法树节点标记, 依存句法路径包括词语和依存关系.句法路径可被看成是一个特殊的“句子”, S=(t0, t1, …, tn-1), 其中的“词语”可以是原句中的词语、成分句法树节点标记、依存关系.根据一个词向量表

|

Fig. 2 Dependency parse tree of the example sentence 2 and all the features of the current word 图 2 例句2的依存句法树和当前词的所有特征 |

2.3 利用双向LSTM神经网络学习句法路径的特征表示

传统的RNN在梯度反向传播阶段存在梯度消失(或称梯度爆炸)和历史信息损失的问题, 因此, 当传播序列过长、层数过多时, 传统RNN无法学习到足够的信息.

Hochreiter等人[30]提出了LSTM单元用以解决传统RNN的梯度消失问题.LSTM专门设计了记忆单元(memory cell)保存历史信息.LSTM单元包含以下4个组成部分:输入门(input gate)it、遗忘门(forget gate)ft、输出门(output gate)ot和带有自递归连接的神经元ct.设x为LSTM单元的输入, h为LSTM单元隐藏状态的输出. LSTM单元的状态不仅取决于当前输入xt, 还受到上一时刻的输出值ht-1的影响.LSTM单元计算步骤如下:

1) 计算输入门的值it、遗忘门的值ft、输出门的值ot.

| $ {\mathit{\boldsymbol{i}}_t}{\rm{ = }}\sigma \left( {{\mathit{\boldsymbol{W}}_i}{\mathit{\boldsymbol{x}}_t} + {\mathit{\boldsymbol{U}}_i}{\mathit{\boldsymbol{h}}_{t - 1}} + {\mathit{\boldsymbol{b}}_i}} \right) $ | (1) |

| $ {\mathit{\boldsymbol{f}}_t}{\rm{ = }}\sigma \left( {{\mathit{\boldsymbol{W}}_f}{\mathit{\boldsymbol{x}}_t} + {\mathit{\boldsymbol{U}}_f}{\mathit{\boldsymbol{h}}_{t - 1}} + {\mathit{\boldsymbol{b}}_f}} \right) $ | (2) |

| $ {\mathit{\boldsymbol{o}}_t}{\rm{ = }}\sigma \left( {{\mathit{\boldsymbol{W}}_o}{\mathit{\boldsymbol{x}}_t} + {\mathit{\boldsymbol{U}}_o}{\mathit{\boldsymbol{h}}_{t - 1}} + {\mathit{\boldsymbol{b}}_o}} \right) $ | (3) |

2) 计算记忆单元当前状态的候选值

| ${\mathit{\boldsymbol{\tilde c}}_t} = \tanh ({\mathit{\boldsymbol{W}}_c}{\mathit{\boldsymbol{x}}_t} + {\mathit{\boldsymbol{U}}_c}{\mathit{\boldsymbol{h}}_{t - 1}} + {\mathit{\boldsymbol{b}}_c})$ | (4) |

3) 根据输入门it、遗忘门ft、记忆单元上一时刻状态值ct-1和当前状态的候选值

| ${\mathit{\boldsymbol{c}}_t} = {\mathit{\boldsymbol{f}}_t} \odot {\mathit{\boldsymbol{c}}_{t - 1}} + {\mathit{\boldsymbol{i}}_t} \odot {\mathit{\boldsymbol{\tilde c}}_t}$ | (5) |

4) LSTM单元的输出, 即单元的隐藏状态ht, 取决于输出门ot和记忆单元当前状态值ct:

| $ {\mathit{\boldsymbol{h}}_t} = {\mathit{\boldsymbol{o}}_t} \odot \tanh \left( {{\mathit{\boldsymbol{c}}_t}} \right) $ | (6) |

其中, 参数Wi, Wf, Wo, Wc, Ui, Uf, Uo, Uc

然而, 标准的LSTM以时序顺序处理序列, 只考虑了历史信息, 忽略了未来信息.许多相关研究[26, 31, 47]表明, 同时考虑序列的历史信息和未来信息有助于序列建模任务.因此, 本文使用双向LSTM网络抽取得到正向和反向句法路径的特征表示, 其神经网络结构如图 3所示.双向LSTM使用正向、反向两个LSTM网络, 分别从正反两个方向处理句法路径序列, 产生正向句法路径表示

| ${H_p} = {\vec H_p} + {\overset{\lower0.5em\hbox{$\smash{\scriptscriptstyle\leftarrow}$}}{H} _p}$ | (7) |

|

Fig. 3 Architecture of the bidirectional LSTM neural network for extracting features from syntactic paths 图 3 用于抽取句法路径特征表示的双向LSTM神经网络的结构 |

为了从Hp中获得足够的信息, 本文对Hp进行最大池化、平均池化和最小池化, 即获得Hp(r, ·)的最大值、平均值和最小值:

| $ \mathit{\boldsymbol{h}}\_{\bf{max}}\left( r \right) = \max \left[ {{\mathit{\boldsymbol{H}}_p}\left( {r, 0} \right){\mathit{\boldsymbol{H}}_p}\left( {r, 1} \right), \cdots , {\mathit{\boldsymbol{H}}_p}\left( {r, n - 1} \right)} \right] $ | (8) |

| $\mathit{\boldsymbol{h}}\_\mathit{\boldsymbol{avg}}(r) = \frac{1}{n}\sum\limits_{j = 0}^{n - 1} {{\mathit{\boldsymbol{H}}_p}(r, j)} $ | (9) |

| $ \mathit{\boldsymbol{h}}\_{\bf{min}}\left( r \right) = \min \left[ {{\mathit{\boldsymbol{H}}_p}\left( {r, 0} \right){\mathit{\boldsymbol{H}}_p}\left( {r, 1} \right), \cdots , {\mathit{\boldsymbol{H}}_p}\left( {r, n - 1} \right)} \right] $ | (10) |

其中, 0≤r≤d0-1.句法路径的特征表示hp由h_max, h_avg, h_min这3个特征组成, 并选择tanh作为激活函数:

| $\mathit{\boldsymbol{h}}_p^* = {[\mathit{\boldsymbol{h}}\_{\bf max}^{T}, \mathit{\boldsymbol{h}}\_\mathit{\boldsymbol{avg}}^{T}, \mathit{\boldsymbol{h}}\_{\bf min}^{T}]^T}$ | (11) |

| ${\mathit{\boldsymbol{h}}_p} = {\rm{tanh}}(\mathit{\boldsymbol{h}}_p^*)$ | (12) |

本文将作用范围识别问题看作是序列标注问题, 并使用双向LSTM网络学习整个句子的特征, 如图 4所示.

|

Fig. 4 Architecture of bidirectional LSTM neural network for scope detection 图 4 用于识别作用范围的双向LSTM神经网络的结构 |

上文已经提到, 对于每一个词语, 本文考虑其3个特征:与线索词的相对位置frp、线索词信息fcue和句法路径特征hp.因此, 词语的特征f0可以表示为

| ${\mathit{\boldsymbol{f}}_0} = {[\mathit{\boldsymbol{f}}_{rp}^T, \mathit{\boldsymbol{f}}_{cue}^T, \mathit{\boldsymbol{f}}_p^T]^T}$ | (13) |

为了减少神经网络模型发生过拟合的可能性, 对于词语的特征表示, 本文考虑了dropout操作[52], 即在模型训练时随机使一定比例的隐藏节点不工作, 其输出置0:

| $ {\mathit{\boldsymbol{f}}_1} = {\mathit{\boldsymbol{f}}_0} \odot {\mathit{\boldsymbol{m}}_0} $ | (14) |

f0, f1的维度dim(f0)=dim(f1)=drp+d0+3d0=drp+4d0.

| $ \mathit{\boldsymbol{H}}_{s}^{*}={{\overrightarrow{\mathit{\boldsymbol{H}}}}_{s}}+{{\overleftarrow{\mathit{\boldsymbol{H}}}}_{s}} $ | (15) |

| ${\mathit{\boldsymbol{H}}_s} = \tanh (\mathit{\boldsymbol{H}}_s^*)$ | (16) |

最后, Hs进入softmax层, 计算得到句子中每个词语的输出, 即每个词语的每个标签(C、I、O)的概率值:

| $ \mathit{\boldsymbol{O}} = soft\mathit{max}\left( {{\mathit{\boldsymbol{W}}_s}{\mathit{\boldsymbol{H}}_s} + {\mathit{\boldsymbol{b}}_s}} \right) $ | (17) |

其中,

对于任意向量a, softmax函数定义为

| $p(y = i|x, \theta ) = \frac{{\exp ({\mathit{\boldsymbol{a}}_i})}}{{\sum\limits_{j = 0}^{c - 1} {\exp ({\mathit{\boldsymbol{a}}_j})} }}$ | (18) |

公式(18)中, p(y=i|x, θ)表示样本x属于i类的概率.

句子中第t个词语的向量表示为

本文采用以下目标函数训练神经网络模型:

| $J(\theta ) = - \frac{1}{m}\sum\limits_{i = 0}^{m - 1} {\log p({y_i}|{x_i}, \theta )} + \frac{\lambda }{2}||\theta |{|^2}$ | (19) |

其中, p(yi|xi, θ)表示训练样本xi的标注标签yi的概率, m为训练样本个数, λ为正则化系数, θ为模型中所有需要学习的参数的集合.

根据BioScope的定义, 作用范围是连续的文本.而本文将作用范围识别任务看作是词语的序列标注问题, 则可能导致识别得到若干不连续的作用范围片段.例如, 在BioScope的Abstracts子语料上的实验结果表明, 当使用成分句法路径时, 不确定和否定作用范围识别结果中, 不连续的作用范围分别占5.30%和5.47%.因此, 与Zou等人[16]、Qian等人[32]类似, 本文采用Morante等人[38]提出的后处理算法, 以确保所识别的作用范围的连续性.

3 实验本节首先介绍BioScope语料库的概况, 然后给出实验设置, 包括衡量性能的指标、使用的工具、神经网络模型中超参数的设置等.接着介绍基准系统, 用于和本文的两层双向LSTM模型进行对比实验.最后, 给出本文提出的模型在BioScope语料库上的性能和分析, 并与前人的一系列先进系统进行比较.

3.1 BioScope语料库本文选择BioScope生物医学语料库[13]验证文中提出的基于两层双向LSTM网络的作用范围识别方法.该语料库标注了不确定和否定线索词及其作用范围.为了较为全面地反映生物医学领域的语言现象, BioScope包含了以下3个子语料库:生物医学领域的论文摘要(以下简称Abstracts子语料)、临床医学领域的放射性报告(Clinical Radiology Reports, 以下简称Clinical子语料)、生物医学领域的论文全文(以下简称Full Papers子语料).其中, Full Papers子语料包含9篇文章, 5篇来自FlyBase数据库, 4篇来自公开的BMC Bioinformatics期刊论文网站.Abstracts来自GENIA语料库.科技文献摘要是各种文本挖掘任务的主要目标语料.因此, Abstracts子语料是BioScope中规模最大的子语料库.

表 1显示了BioScope的相关统计数据, 其中, 文本长度以1个单词为1个单位.Abstracts和Full Papers子语料均来自于生物医学领域的论文, 在句子结构和语言风格上类似, 所以这两个子语料库的句子长度和作用范围的长度也相近.分不同类型的作用范围来看, Abstracts和Full Papers的否定作用范围的平均长度(分别为8.60和8.35)均小于不确定作用范围(分别为16.10和14.38).Clinical语料来自于临床诊断, 句式相对随意, 句子和作用范围长度比Abstracts和Full Papers都要短.Clinical子语料中不确定句子和作用范围的平均长度分别为11.96和5.92, 而Abstracts分别为29.77和16.10, Full Papers则分别为30.76和14.38.Clinical子语料的否定句子和作用范围的平均长度分别为8.53和4.87, 而Abstracts分别为29.28和8.60, Full Papers语料则分别为30.55和8.35.此外, 从表 1中可知, BioScope语料中, 线索词与作用范围左边界的距离远远小于其与右边界的距离, 说明大多数线索词靠近作用范围的左端.

| Table 1 Statistics of BioScope corpus 表 1 BioScope语料库的统计数据 |

3.2 实验设置和基准系统

为了能够与已有工作进行公平的比较, 本文在Abstracts子语料上进行10倍交叉验证, 而Clinical和Full Papers子语料上的结果由Abstracts上训练得到的模型产生, 从而检验本文提出的模型在生物医学领域内不同文本类型之间的鲁棒性.因此, Abstracts子语料上的结果是域内(in-domain)检验, 而Clinical和Full Papers子语料的结果是跨域(cross-domain)检验.

传统的准确率(precision)、召回率(recall)和F1值(F1-measure)用于反映作用范围识别任务中词语的性能.为了能够更加准确地描述作用范围识别性能, 本文采用被正确识别的作用范围的百分比(percentage of correct scopes, 简称PCS)作为衡量指标.此外, 本文还采用被正确识别的作用范围左边界百分比(percentage of correct left boundaries, 简称PCLB)和右边界百分比(percentage of correct right boundaries, 简称PCRB), 用于进一步描述作用范围识别性能.

本文使用斯坦福句法分析工具(Stanford Parser, http://nlp.stanford.edu/software/lex-parser.shtml)生成成分句法树和依存句法树, 并使用GENIA Treebank 1.0语料库[53]作为训练语料生成句法分析模型, 在GENIA Treebank 1.0上, 10倍交叉验证的结果为F1=87.12.GENIA Treebank 1.0语料库对GENIA语料库进行了基于Penn Treebank Ⅱ格式的短语结构的句法标注.而BioScope中规模最大的Abstracts子语料来自于GENIA语料.因此, 本文使用的句法分析模型在BioScope上会取得令人满意的性能.

对于本文提出的两层双向LSTM模型, 其中的超参数设置为d0=100, drp=10.本文选择带冲量(momentum)的随机梯度下降(stochastic gradient descent)算法训练神经网络模型.

为了比较不同模型的性能, 本文采用以下模型作为基准系统(baseline).

1) 基于规则的模型(简称Rules):该规则模型基于句子的成分句法树.设P为当前线索词的祖父节点(即短语标记节点, chunk node), 若P管辖的叶子节点只有当前线索词, 则将P的父节点作为新的P; 否则, 作用范围是P管辖的叶子节点的集合.

2) 最大熵分类模型(简称MaxEnt):采用Zou等人[16]使用的平面句法特征(flat syntactic features)判断词语是否属于当前线索词的作用范围, 其中包括6个基本特征、10个成分句法特征、5个依存句法特征.本文使用的最大熵分类器工具是Mallet(http://mallet.cs.umass.edu/).

3) 简单的卷积神经网络模型(简称CNN+CNN):该模型使用CNN抽取句法路径特征表示, 其卷积层单元数与词向量维度相同, 即取d0=100;同时, 采用另一个CNN隐藏层学习句子中每个词的特征表示, 其输入单元数与每个词的特征表示向量的维度相同, 取dim(f0)=drp+d0+3d0=drp+4d0=410.

4) 看见单向LSTM(unidirectional LSTM)神经网络模型(简称UniLSTM+UniLSTM):该神经网络结构与本文使用的双向神经网络模型基本相同, 唯一的区别在于LSTM网络是单向的.

类似地, 本文的双向LSTM神经网络模型则记为BiLSTM+BiLSTM.

3.3 实验性能和分析(Abstracts子语料)表 2显示了本文提出的模型在Abstracts子语料上的性能, 其中, Cpath表示采用的结构化特征是成分句法树中从线索词到词语的最短路径, 即成分句法路径; Dpath表示采用的结构化特征是依存句法树中从线索词到词语的最短路径, 即依存句法路径; Cpath+Dpath表示采用的结构化特征为成分句法路径+依存句法路径.

| Table 2 Performances of various models on Abstracts subcorpus 表 2 Abstracts子语料上各种模型的性能 |

从表 2中可以看出:

1) 在Abstracts上统计模型(包括最大熵模型和神经网络模型)取得的不确定作用范围识别性能高于否定作用范围识别性能.在句子长度接近的情况下(Abstracts子语料中, 包含不确定信息的句子和包含否定信息的句子, 其平均长度分别为29.77和29.28), 否定作用范围的平均长度(8.60)远小于不确定作用范围的平均长度(16.10).因此, 相对于不确定作用范围, 属于否定作用范围的词语较少, 即正例较少.词语的正负例不平衡导致否定作用范围识别的性能低于不确定作用范围.

2) 在不确定作用范围识别任务方面, 简单的规则模型所达到的性能接近于最大熵模型和CNN+CNN模型.这是由于许多不确定线索词(例如suggest、may、indicate等, 这3个词在Abstracts子语料中占不确定线索词的53.70%)用于表达观点.因此, 这些不确定线索词的作用范围位于该线索词所在的短语结构之内, 易用规则模型识别.而该规则模型在否定作用范围识别任务上的性能很低(PCS=18.44%), 且其PCLB(33.10%)远远低于PCRB(51.13%), 即作用范围左边界识别性能较差, 说明否定作用范围不能简单地用线索词所在的短语结构进行识别.而最大熵模型识别否定作用范围的性能也低于神经网络模型, 主要是最大熵模型不能很好地识别否定作用范围的右边界, 其PCRB(58.29%)远低于PCLB (84.00%).

3) 相对于传统的规则模型和最大熵模型, 本文的BiLSTM+BiLSTM模型对性能的提升较为明显.其中, 在否定作用范围识别任务上, PCS值的提升分别为61.84%和33.86%;而在不确定作用范围识别任务上, PCS值的提升分别为18.24%和13.73%.由此可见, BiLSTM+BiLSTM模型更有助于提升否定作用范围识别性能.特别地, 相对于最大熵模型, BiLSTM+BiLSTM模型有效地提高了否定作用范围的PCRB值, 在使用成分句法路径和依存句法路径时, PCRB均提高了28.16%.

4) 在不确定和否定作用范围识别任务上, BiLSTM+BiLSTM模型均明显优于CNN+CNN模型和UniLSTM+UniLSTM模型.这说明相对于不考虑路径中词语上下文的CNN模型和只考虑上文的UniLSTM模型, BiLSTM同时考虑了词语的上下文环境.因此, BiLSTM可以从句法路径和句子中学习到更加有效的特征表示.

5) BiLSTM+BiLSTM模型同时考虑成分句法路径和依存句法路径并不能提高作用范围识别的性能.我们认为, 这是由于BiLSTM已经能够从成分句法路径或者依存句法路径中学习到足够的特征信息.同时从成分句法路径和依存句法路径学习特征信息反而可能会造成过拟合.

为了进一步探究Abstracts子语料上不确定和否定作用范围识别任务的性能, 下面, 本文列举Abstracts中出现次数占据前10位的不确定和否定线索词的作用范围识别性能, 并进行分析.

图 5显示了本文的神经网络模型在使用成分句法路径时, Abstracts中出现次数前10位的不确定线索词的作用范围识别性能(图中, 每个线索词的作用范围识别性能有3个, 其对应的模型从左到右分别为CNN+CNN, UniLSTM+UniLSTM, BiLSTM+BiLSTM, 下同; 对于Abstracts子语料中的各线索词, 本文取其10倍交叉验证的平均PCS值, 下同).出现次数最多的3个线索词, 即suggest, may和indicate, 占据了Abstracts中不确定线索词的53.70%.其中, suggest和indicate通常用于表达一定的观点或者阐述某些情况, may、might、whether、possible则通常用于引导具有不确定语义的子句或者短语.因此, 这些线索词的作用范围往往是具有完整语义的文本片段.在成分句法树中, 这些线索词的作用范围一般位于该词的短语句法标记节点管辖的子树之内.因此, 在使用成分句法路径时, 这些线索词的作用范围识别性能较好.

|

Fig. 5 PCS of scopes of the most frequent ten speculative cues on Abstracts subcorpus (with constituency syntactic path/Cpath) 图 5 Abstracts子语料中频数前10位的不确定线索词的作用范围PCS值(使用成分句法路径) |

然而, or的PCS值远低于其他不确定线索词.其中, CNN+CNN模型在or的作用范围识别方面的性能较差, PCS值小于10%.我们认为, 这是由于or的运用比较灵活, 可以用于连接两个概念相近的语义成分, 例如, 连接名词、动词、形容词、短语或者是子句.因此, 判断or的作用范围较困难.此外, CNN+CNN模型对appear, could, likely的作用范围识别性能也低于其他高频线索词, 在使用成分句法路径时, PCS值分别只有39.95%, 44.63%, 51.55%, 且其PCLB值(分别为58.90%, 57.26%, 56.13%)远低于PCRB值(分别为75.02%, 80.52%, 93.42%).UniLSTM+ UniLSTM对于could, likely的作用范围性能的提升也不是很明显.这些线索词的PCS值高低取决于其PCLB值, 识别其作用范围的左边界是一个难点.经过对语料的分析, 我们认为, 是由于Abstracts子语料中, appear, could, likely等词用法灵活, 存在于作用范围的不同位置, 如以下例句所示.其中, 尖括号“ < > ”代表BiLSTM+BiLSTM模型识别的作用范围.例句4中, appear位于作用范围的左边界并引导从句; 而例句5中, appear出现在appear to be done结构中, 其作用范围包含了该子句的主语.

例句4: It also < appears that NF-kappaB suppression by RCC-S may contribute to the immunosuppression of host immunity > .

例句5: We furthermore demonstrate that this process involves activation of the transcription factor NF-chi B and, to a lesser extent, of NF-IL6, while the activity of the transcription factor AP-1, < shown to otherwise confer IL-6 inducibility, appeared to be unaffected by LTB4 > .

本文的BiLSTM+BiLSTM模型对or的PCS值提高明显, 但是仍然远低于其他不确定线索词.而BiLSTM+ BiLSTM模型将appear, could, likely的PCS值分别提高到88.13%, 78.22%, 73.85%, 其PCLB值则分别提高到92.40%, 84.52%, 82.59%, 说明BiLSTM+BiLSTM模型能够很好地识别位于这些线索词左边的词语是否在其作用范围之内, 即能有效地界定其作用范围的左边界.

图 6显示了本文的神经s网络模型在使用依存句法路径时, Abstracts子语料中出现次数前10位的否定线索词的作用范围识别性能.其中, not和no占据了否定线索词的73.07%.因此, not和no的作用范围识别性能在很大程度上决定了Abstracts上否定作用范围的性能.一方面, 不少否定线索词的用法相对固定.例如, CNN+CNN模型已经可以在识别without的作用范围上获得较高的性能, BiLSTM+BiLSTM模型对其提升不是很明显.这是因为without后面通常接名词或者名词性短语, 其作用范围的识别相对容易.另一方面, 否定线索词通常用于否定短语或者长度较短的子句.相对于不确定线索词, 否定线索词的作用范围长度较短(Abstracts子语料上否定作用范围平均长度为8.60, not和no的作用范围平均长度分别为8.31和9.31), 其句法结构相对简单, 且作用范围之内的词语与线索词之间存在着较紧密的依存关系.所以, 大部分否定线索词的作用范围识别取得了较好的性能.

|

Fig. 6 PCS of scopes of the most frequent ten negative cues on Abstracts subcorpus (with dependency syntactic path/Dpath) 图 6 Abstracts子语料中频数前10位的否定线索词的作用范围PCS值(使用依存句法路径) |

然而, 否定线索词unable和cannot的作用范围识别性能较低, BiLSTM+BiLSTM模型取得的PCS值分别为23.33%和55.56%, 其PCLB值则分别为38.33%和63.89%, 远低于其PCRB值76.67%和91.67%.与上文分析的不确定线索词appear, could, likely类似, 正确识别unable和cannot的作用范围, 重点在于正确判断这两个否定线索词左边的文本片段是否属于其作用范围.

3.4 实验性能和分析(Clinical子语料)根据上文的分析, Abstracts和Full Papers子语料分别来自生物医学领域论文的摘要和全文部分, 因此, 这两个子语料的句子和作用范围都较长.而Clinical子语料的语言风格区别于Abstracts和Full Papers, 其句子和作用范围均较短.表 3展示了Clinical上作用范围识别任务的性能.

| Table 3 Performances of various models on Clinical subcorpus 表 3 Clinical子语料上各种模型的性能 |

上文已经提到, 以Abstracts为训练集生成模型, 并将Clinical作为测试集, 得到Clinical上的作用范围识别结果.实验结果同样表明, BiLSTM+BiLSTM在PCS值上优于其他方法.

本文的BiLSTM+BiLSTM在使用成分句法路径时, 在Clinical子语料上不确定作用范围的PCS值达到最好的73.11%, 远远低于其在Abstracts上的性能(PCS=86.20%).为了进一步分析实验结果, 与Abstracts子语料类似, 本文探索了Clinical子语料上若干高频线索词的作用范围性能.

图 7左图显示了在使用成分句法路径的情况下, Clinical子语料中出现频数前5位的不确定线索词的作用范围识别性能.这5个词共占据总的不确定线索词的52.88%.可以看到, 其不确定线索词分布与Abstracts子语料大不相同:Clinical子语料中出现最频繁的不确定线索词为or, 占所有不确定线索词的23.29%;BiLSTM+ BiLSTM模型取得PCS值只有57.14%, 远低于大部分其他不确定线索词(may、evaluate、consistent、suggest等).这是由于在作为训练集的Abstracts子语料中, or仅占不确定线索词的3.42%, 模型很难从训练集中学习到关于or的作用范围的足够的特征信息.此外, 正如上文的分析, or的运用比较灵活, 可以连接各类语法元素.

|

Fig. 7 PCS of scopes of the most frequent 5 speculative (left part) and negative (right part) cues on Clinical subcorpus (with constituency syntactic path/Cpath and dependency syntactic path/Dpath, respectively) 图 7 Clinical子语料中频数前5位的不确定(左)和否定(右)线索词的作用范围PCS值(分别使用成分句法路径和依存句法路径 |

此外, 图 7右图显示了在使用依存句法路径的情况下, Clinical子语料中出现频数前5位的否定线索词其作用范围的性能.Clinical中的否定线索词中no最多, 占据了77.59%, not、without、no、negative是出现频度前4位的否定线索词, 占98.05%, 其余否定线索词的出现频度均小于5次.由于Clinical中否定线索词分布类似于作为训练语料的Abstracts子语料, 主要的高频否定线索词no、, without、not在Abstracts中也属于出现次数前5位的否定线索词, 且Clinical中句子和作用范围均较短, 句法结构并不复杂, 因此, 本文的BiLSTM+BiLSTM模型在识别Clinical子语料的否定作用范围任务上表现得很好, 其PCS值为92.30%.

3.5 实验性能和分析(Full Papers子语料)表 4是Full Papers子语料的作用范围识别性能.实验结果表明, BiLSTM+BiLSTM取得的F1和PCS值优于本文的其他方法, 除了在否定作用范围识别任务上F1值(86.06)略低于UniLSTM+UniLSTM(86.16).其中, 使用成分句法路径时, 本文的BiLSTM+BiLSTM模型在该子语料的不确定作用范围识别任务上达到最好的PCS= 63.10%;使用依存句法路径时, BiLSTM+BiLSTM模型在否定作用范围识别任务上达到最好的PCS=62.50%.相对于Abstracts和Clinical子语料, Full Papers子语料上的不确定作用范围和否定作用范围性能均较低.Full Papers子语料中含有不确定和否定信息的句子长度分别为30.76和30.55, 均大于Abstracts(分别为29.77, 29.28)和Clinical子语料(分别为11.96, 8.53).因此, Full Papers子语料中的句子具有较为复杂的句法结构, 识别句子中线索词的作用范围难度更大.

| Table 4 Performances of various models on Full Papers subcorpus 表 4 Full Papers子语料上各种模型的性能 |

从表 4中可知, 在不确定作用范围识别任务方面, BiLSTM+BiLSTM模型取得的PCLB=86.76%, 远远高于其PCRB=70.83%;而在否定作用范围识别任务方面, BiLSTM+BiLSTM模型达到的PCLB=87.23%, 也高于其PCRB=71.28%.因此, Full Papers子语料上的作用范围识别任务性能较低, 主要是由于本文的模型在识别作用范围右边界方面表现得不太好.主要原因是Full Papers子语料的句子中, 不少句子末尾有带括号的词或词组, 代表图例和引用文献.根据BioScope所采取的标注规则, 这类带括号的词或词组不包含在作用范围之内.本文BiLSTM+BiLSTM模型错误地将部分句子末尾带括号的词识别为作用范围的一部分.在不确定和否定作用范围识别任务上, 这类错误分别占13.73%和12.50%.

3.6 实验性能和分析(输入)表 5反映了不同输入对于作用范围识别性能的影响.

| Table 5 Performances of various types of input on BioScope 表 5 BioScope上不同输入的性能 |

第2.2节中已经提到, 本文将特征分为基本特征和句法路径特征.其中, 基本特征包括了词语与线索词的相对位置、当前词是否为线索词.在不确定作用范围识别任务上, 相对于其他句法路径, 使用成分句法路径Cpath能够在各子语料上取得最好的性能, 因此, 表 5中本文选择成分句法路径.类似地, 在否定作用范围识别任务上, 使用依存句法路径Dpath能在各子语料上取得最好的性能, 表 5中选择依存句法路径.

表 5显示, 如果仅考虑基本特征而忽略句法路径, 作用范围识别性能远远低于考虑句法路径的情况.这说明作用范围识别性能主要取决于词语与线索词之间的句法信息, 不同线索词的作用范围, 其句法结构也不同.如果仅考虑句法路径特征, 性能略低于同时考虑基本特征和句法路径, 但高于仅考虑基本特征.这表明基本特征有助于提升作用范围识别性能.基本特征可以将线索词与非线索词加以区分, 并描述词语与线索词之间的距离.不同线索词的作用范围平均长度也不同.例如, 在Abstracts子语料的不确定线索词中, 用于表达观点和论述事实的suggest, 经常用于引导从句, 其作用范围平均长度为19.62;而通常用于修饰名词性词组或者短语的possible, 其作用范围平均长度仅有12.96.

3.7 与领域内先进系统的比较表 6显示了本文的BiLSTM+BiLSTM模型与近几年领域内性能最优的若干作用范围识别系统在BioScope上性能的比较.其中, 由于Velldal等人[18]在其基于SVM短语排序器的统计模型的基础上引入了大量规则, 为了公平比较, 本文仅例举他们的统计模型的性能.另外, Fancellu等人[31]使用的基于词法特征的双向BiLSTM模型, 针对的是柯南道尔的夏洛克·福尔摩斯(Conan Doyle’s Sherlock Holmes)语料.本文重新实现了他们的系统, 并应用到BioScope语料库上.

| Table 6 Performance comparison of our system with the state-of-the-art ones in PCS (%) on BioScope 表 6 本文系统与领域内先进系统在BioScope上的PCS值(%)的性能比较 |

可以看到, 本文的BiLSTM+BiLSTM模型在BioScope否定作用范围识别任务上均高于其他系统, 说明明本文模型更适合识别BioScope上的否定作用范围.对于不确定作用范围, 在BioScope的Abstracts子语料上, 本文取得了最好的性能, 即PCS=86.20%, 比Qian等人[32]高出0.45%.

在Clinical子语料的不确定作用范围识别任务上, 本文模型达到PCS=73.11%, 比Qian等人[32]的PCS= 73.92%低了0.81%.Velldal等人[18]的统计模型取得的PCS为73.61%, 如果结合规则模型, 则PCS可以达到78.69%.如第3.5节中的分析, 主要原因是BiLSTM+BiLSTM模型在识别线索词or的作用范围上表现得不好.而在否定作用范围识别方面, 本文的PCS值为92.30%, 优于其他所有模型.即使是Velldal等人[18]的统计与规则结合的模型, 其PCS值也只达到90.74%, 其简单规则模型却可以达到91.43%, 但均低于本文模型.

本文在Full Papers子语料上取得的不确定和否定作用范围的PCS性能分别为63.10%和62.50%, 远远低于Abstracts和Clinical子语料.其他系统所取得的PCS也均低于70%.说明识别Full Papers子语料上的作用范围是一个相对困难的任务.Zou等人[16]和Velldal等人[18]均考虑了以当前词语为根的子树结构, 在该子语料上的不确定作用范围识别性能方面优于本文模型.

为了进一步验证本文提出的神经网络模型的通用性, 本文选择CoNLL-2010 Shared Task[54]中任务2所使用的Evaluation语料库.与Full Papers类似, 该语料库同样来自生物医学领域论文, 其中仅标注了不确定信息.根据CoNLL-2010 Shared Task的规定, Evaluation语料的结果由Abstracts和Full Papers上训练得到的模型产生.此外, 本文将Qian等人[32]的系统应用于该语料, 获得其不确定作用范围识别性能; 与表 6类似, 为了与本文模型进行公平比较, 本文例举了Velldal等人[18]的统计模型的性能.

表 7显示了基于Evaluation语料的不确定作用范围识别任务上本文模型和领域内先进系统性能的比较.在选择成分句法路径Cpath时, 本文的神经网络模型能够取得最好的性能.Evaluation语料上含有不确定信息的句子和作用范围长度分别为34.41和16.75, 均大于Full Papers子语料(分别为30.76和14.38).因此, 与Full Papers类似, Evaluation语料上句子较长, 句法结构复杂, 作用范围也较难识别.本文模型在Evaluation语料上的不确定作用范围识别的PCS值为65.34%, 优于领域内其他系统.Velldal等人[18]的统计模型获得的PCS为58.37%, 若结合规则模型, 则PCS可以达到69.60%.可见, 相对于Abstracts和Clinical子语料, 各模型在Evaluation上的性能也很低.类似于Full Papers, Evaluation中也含有很多带括号的名词性词组或短语, 表示引用文献、图例、公式、缩写等.这些词组既可能出现在句子末尾, 也可能出现在句子中间, 导致句子结构更加复杂.根据标注规则, 这些词组或者位于作用范围之内, 或者不属于作用范围.而本文模型得到的错例中, 将带括号词组中部分词语识别为属于作用范围, 这类错误占22.35%.

| Table 7 Performance comparison of our system with the state-of-the-art ones in PCS (%) on Evaluation corpus 表 7 本文系统与领域内先进系统在Evaluation语料上的PCS值(%)的性能比较 |

4 结论与未来的工作

本文针对自然语言文本中线索词的作用范围识别这一自然语言处理领域内的重要任务, 提出了一种基于两层双向LSTM神经网络的模型.首先, 本文利用一个双向LSTM神经网络模型从线索词与词语之间的句法路径中学习到有效的特征表示; 然后, 综合考虑句法路径特征和其他词法特征, 组成各个词语的特征表示; 最后, 将作用范围识别问题转化为序列标注问题, 利用另一个双向LSTM神经网络的模型处理整个句子, 标注各个词语, 识别当前线索词的作用范围, 并采用适当的后处理算法确保作用范围是连续的文本.与其他基于神经网络模型的作用范围识别方法(Fancellu等人[31]和Qian等人[32])相比, 本文的模型既考虑了线索词与词语之间的句法结构特征信息, 又考虑了词语的上下文信息.实验结果表明, 本文提出的基于两层双向LSTM神经网络的模型在BioScope语料上能够取得良好的性能.其中, 在不确定作用范围识别方面, 本文在Abstracts和Clinical子语料上能取得的PCS值分别为86.20%和73.11%;在否定作用范围识别方面, 本文模型优于领域内所有其他先进系统, Abstracts和Clinical上的PCS值则分别为80.28%和92.30%.在句子结构较为复杂的Full Papers子语料上, 本文的模型也能取得良好的性能, 其不确定和否定作用范围PCS值分别为63.10%和62.50%.在语言风格类似Full Papers的Evaluation子语料上, 本文模型取得的PCS值分别为65.34%, 高于领域内其他先进系统.本文还将双向LSTM模型与CNN模型、单向LSTM模型进行了实验对比.由于双向LSTM模型同时考虑了序列的上下文, 能够从序列中学习到足够的有效信息, 因此实验结果显示, 双向LSTM模型优于CNN模型和单向LSTM模型.

然而, 本文仍然使用基于单词的识别模型.其他基于短语结构的模型(例如Velldal等人[18])在识别作用范围时同样能够取得较好的性能.此外, 本文的神经网络模型在生物医学领域内跨不同风格文本的实验中, 其鲁棒性不足, 在Full Papers子语料上取得的性能与前人的最优系统类似, 效果提升不明显.因此, 未来本文将尝试构建基于短语的作用范围识别系统, 以识别结构复杂、语义完整的句子中的作用范围.本文还将构建更加有效的神经网络模型, 提高作用范围识别系统的性能.

| [1] |

Lakoff G. Hedges:A study in meaning criteria and the logic of fuzzy concepts. Journal of Philosophical Logic, 1973, 2(4): 458–508.

[doi:10.1007/BF00262952] |

| [2] |

Morante R, Sporleder C. Modality and negation:An introduction to the special issue. Computational Linguistics, 2012, 38(2): 223–260.

[doi:10.1162/COLI_a_00095] |

| [3] |

Pustejovsky J, Knippen B, Littman J, Saurí R. Temporal and event information in natural language text. Language Resources and Evaluation, 2005, 39(2): 123–164.

[doi:10.1145/1314493.1314495] |

| [4] |

Angeli G, Nayak N, Manning CD. Combining natural logic and shallow reasoning for question answering. In: Erk K, Smith NA, eds. Proc. of the 2016 Conf. on the 54th Annual Meeting of the Association for Computational Linguistics (Vol. 1: Long Papers). Stroudsburg: Association for Computational Linguistics, 2016. 442-452. Combining natural logic and shallow reasoning for question answering. |

| [5] |

Wiebe J, Wilson T, Cardie C. Annotating expressions of opinions and emotions in language. Language Resources & Evaluation, 2005, 39(2-3): 165–210.

[doi:10.1007/s10579-005-7880-9] |

| [6] |

de Marneffe MC, Maccartney B, Grenager T, Cer D, Rafferty A, Manning CD. Learning to distinguish valid textual entailments. In Proc. of the 2nd Pascal Challenges Workshop on Recognising Textual Entailment (RTE-2). 2006.https://www.researchgate.net/publication/228907970_Learning_to_distinguish_valid_textual_entailments |

| [7] |

Hickl A, Bensley J. A discourse commitment-based framework for recognizing textual entailment. In: Dagan I, Dolan B, Giampiccolo D, Magnini B, eds. Proc. of the Workshop on Textual Entailment and Paraphrasing. Stroudsburg: Association for Computational Linguistics, 2007. 171-176.http://dl.acm.org/citation.cfm?id=1654571 |

| [8] |

Saurí R, Pustejovsky J. Determining modality and factuality for text entailment. In: Proc. of the 1st IEEE Int'l Conf. on Semantic Computing (ICSC 2007). 2007. 509-516. [doi: 10.1109/ICSC.2007.80] |

| [9] |

Councill IG, McDonald R, Velikovich L. What's great and what's not: Learning to classify the scope of negation for improved sentiment analysis. In: Morante R, Sporleder C, eds. Proc. of the Workshop on Negation and Speculation in Natural Language Processing. Stroudsburg: Association for Computational Linguistics, 2010. 51-59.http://dl.acm.org/citation.cfm?id=1858969 |

| [10] |

Saurí R. A factuality profiler for eventualities in text. [Ph. D. Thesis]. Waltham: Brandeis University, 2008. |

| [11] |

Saurí R, Pustejovsky J. Are you sure that this happened? Assessing the factuality degree of events in text. Computational Linguistics, 2012, 38(2): 261–299.

[doi:10.1162/COLI_a_00096] |

| [12] |

Tang BZ, Wang XL, Wang X, Yuan B, Fan FX. A cascade method for detecting hedges and their scope in natural language text. In: Farkas R, Vincze V, Szarvas G, Móra G, Csirik J, eds. Proc. of the 14th Conf. on Computational Natural Language Learning-Shared Task. Stroudsburg: Association for Computational Linguistics, 2010. 13-17.http://dl.acm.org/citation.cfm?id=1870537 |

| [13] |

Vincze V, Szarvas G, Farkas R, Móra G, Csirik J. The BioScope corpus:Biomedical texts annotated for uncertainty, negation and their scopes. BMC Bioinformatics, 2008, 9(Suppl.11): 1–9.

[doi:10.1186/1471-2105-9-S11-S9] |

| [14] |

Özgür A, Radev DR. Detecting speculations and their scopes in scientific text. In: Koehn P, Mihalcea R, eds. Proc. of the 2009 Conf. on Empirical Methods in Natural Language Processing. Stroudsburg: Association for Computational Linguistics, 2009. 1398-1407.Detecting speculations and their scopes in scientific text |

| [15] |

Øvrelid L, Velldal E, Oepen S. Syntactic scope resolution in uncertainty analysis. In:Huang CR, Jurafsky D, eds. Proc. of the 23rd Int'l Conf. on Computational Linguistics. Stroudsburg:Association for Computational Linguistics, 2010. 1379-1387.http://dl.acm.org/citation.cfm?id=1873936 |

| [16] |

Zou BW, Zhou GD, Zhu QM. Tree kernel-based negation and speculation scope detection with structured syntactic parse features. In: Baldwin T, Korhonen A, eds. Proc. of the 2013 Conf. on Empirical Methods in Natural Language Processing. Stroudsburg: Association for Computational Linguistics, 2013. 968-976.https://www.researchgate.net/publication/289481922_Tree_kernel-based_negation_and_speculation_scope_detection_with_structured_syntactic_parse_features |

| [17] |

Li JH, Zhou GD, Wang HL, Zhu QM. Learning the scope of negation via shallow semantic parsing. In: Huang CR, Jurafsky D, eds. Proc. of the 23rd Int'l Conf. on Computational Linguistics. Stroudsburg: Association for Computational Linguistics, 2010. 671-679.http://cpfd.cnki.com.cn/Article/CPFDTOTAL-ZGZR201008002080.htm |

| [18] |

Velldal E, Øvrelid L, Read J, Oepen S. Speculation and negation:Rules, rankers, and the role of syntax. Computational Linguistics, 2010, 38(2): 369–410.

[doi:10.1162/COLI_a_00126] |

| [19] |

Roth M, Lapata M. Neural semantic role labeling with dependency path embeddings. In: Erk K, Smith NA, eds. Proc. of the 54th Annual Meeting of the Association for Computational Linguistics (Vol. 1: Long Papers). Stroudsburg: Association for Computational Linguistics, 2016. 1192-1202.http://arxiv.org/abs/1605.07515 |

| [20] |

Zhou J, Xu W. End-to-End learning of semantic role labeling using recurrent neural networks. In: Zong CQ, Strube M, eds. Proc. of the 53rd Annual Meeting of the Association for Computational Linguistics and the 7th Int'l Joint Conf. on Natural Language Processing (Vol. 1: Long Papers). Stroudsburg: Association for Computational Linguistics, 2015. 1127-1137.https://www.researchgate.net/publication/283806596_End-To-end_learning_of_semantic_role_labeling_using_recurrent_neural_networks |

| [21] |

Xu JC, Chen DL, Qiu XP, Huang XJ. Cached long short-term memory neural networks for document-level sentiment classification. In: Duh K, Carreras X, eds. Proc. of the 2016 Conf. on Empirical Methods in Natural Language Processing. Stroudsburg: Association for Computational Linguistics, 2016. 1660-1669.http://arxiv.org/abs/1610.04989 |

| [22] |

Wang XY, Jiang WJ, Luo ZY. Combination of convolutional and recurrent neural network for sentiment analysis of short texts. In: Matsumoto Y, Prasad R, eds. Proc. of the 26th Int'l Conf. on Computational Linguistics: Technical Papers (COLING 2016). Stroudsburg: Association for Computational Linguistics, 2016. 2428-2437. |

| [23] |

Chen YB, Xu LH, Liu K, Zeng DJ, Zhao J. Event extraction via dynamic multi-pooling convolutional neural networks. In: Zong CQ, Strube M, eds. Proc. of the 53rd Annual Meeting of the Association for Computational Linguistics and the 7th Int'l Joint Conf. on Natural Language Processing (Vol. 1: Long Papers). Stroudsburg: Association for Computational Linguistics, 2015. 167-176.https://www.researchgate.net/publication/281581378_Event_Extraction_via_Dynamic_Multi-Pooling_Convolutional_Neural_Networks |

| [24] |

Nguyen TH, Cho K, Grishman R. Joint event extraction via recurrent neural networks. In: Nenkova A, Rambow O, eds. Proc. of the 2016 Conf. of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies. Stroudsburg: Association for Computational Linguistics, 2016. 300-309.https://www.researchgate.net/publication/305334470_Joint_Event_Extraction_via_Recurrent_Neural_Networks |

| [25] |

Xu Y, Mou LL, Li G, Chen YC, Peng H, Jin Z. Classifying relations via long short term memory networks along shortest dependency paths. In: Callison-Burch C, Su J, eds. Proc. of the 2015 Conf. on Empirical Methods in Natural Language Processing. Stroudsburg: Association for Computational Linguistics, 2015. 1785-1794.http://arxiv.org/abs/1508.03720 |

| [26] |

Cai R, Zhang XD, Wang HF. Bidirectional recurrent convolutional neural network for relation classification. In: Erk K, Smith NA, eds. Proc. of the 54th Annual Meeting of the Association for Computational Linguistics. Stroudsburg: Association for Computational Linguistics, 2016. 756-765.https://www.researchgate.net/publication/306093683_Bidirectional_Recurrent_Convolutional_Neural_Network_for_Relation_Classification |

| [27] |

Yang YL, Tong YH, Ma SL Deng ZH. A position encoding convolutional neural network based on dependency tree for relation classification. In: Duh K, Carreras X, eds. Proc. of the 2016 Conf. on Empirical Methods in Natural Language Processing. Stroudsburg: Association for Computational Linguistics, 2016. 65-74. |

| [28] |

Zhou J, Cao Y, Wang XG, Li P, Xu W. Deep recurrent models with fast-forward connections for neural machine translation. Trans. of the Association for Computational Linguistics, 2016, 4: 371–383.

http://arxiv.org/abs/1606.04199 |

| [29] |

Wang MX, Lu ZD, Li H, Liu Q. Memory-Enhanced decoder for neural machine translation. In: Duh K, Carreras X, eds. Proc. of the 2016 Conf. on Empirical Methods in Natural Language Processing. Stroudsburg: Association for Computational Linguistics, 2016. 278-286.http://arxiv.org/abs/1606.02003 |

| [30] |

Hochreiter S, Schmidhuber J. Long short-term memory. Neural Computation, 1997, 9(8): 1735–1780.

[doi:10.1162/neco.1997.9.8.1735] |

| [31] |

Fancellu F, Lopez A, Webber B. Neural networks for negation scope detection. In: Erk K, Smith NA, eds. Proc. of the 54th Annual Meeting of the Association for Computational Linguistics. Stroudsburg: Association for Computational Linguistics, 2016. 495-504.https://www.researchgate.net/publication/306093395_Neural_Networks_For_Negation_Scope_Detection |

| [32] |

Qian Z, Li PF, Zhu QM, Zhou GD, Luo ZC, Luo W. Speculation and negation scope detection via convolutional neural networks. In: Duh K, Carreras X, eds. Proc. of the 2016 Conf. on Empirical Methods in Natural Language Processing. Stroudsburg: Association for Computational Linguistics, 2016. 815-825.https://www.researchgate.net/publication/309535768_Speculation_and_Negation_Scope_Detection_via_Convolutional_Neural_Networks |

| [33] |

Chapman WW, Bridewell W, Hanbury P, Cooper GF, Buchanan BG. A simple algorithm for identifying negated findings and diseases in discharge summaries. Journal of Biomedical Informatics, 2001, 34(5): 301–310.

[doi:10.1006/jbin.2001.1029] |

| [34] |

Aronow D, Feng FF, Croft WB. Research paper:Ad hoc classification of radiology reports. Journal of the American Medical Informatics Association, 1999, 6(5): 393–411.

[doi:10.1136/jamia.1999.0060393] |

| [35] |

Boytcheva S, Strupchanska A, Paskaleva E, Tcharaktchiev D. Some aspects of negation processing in electronic health records. In: Paskaleva E, Piperidis S, eds. Proc. of the Int'l Workshop Language and Speech Infrastructure for Information Access in the Balkan Countries Held in Conjunction with RANLP 2005. INCOMA, 2005. 1-8.https://www.researchgate.net/publication/242083085_Some_Aspects_of_Negation_Processing_in_Electronic_Health_Records |

| [36] |

Huang Y, Lowe HJ. Research paper:A novel hybrid approach to automated negation detection in clinical radiology reports. Journal of the American Medical Informatics Association, 2007, 14(3): 304–311.

[doi:10.1197/jamia.M2284] |

| [37] |

Rokach L, Romano R, Maimon O. Negation recognition in medical narrative reports. Information Retrieval Journal, 2008, 11(6): 499–538.

[doi:10.1007/s10791-008-9061-0] |

| [38] |

Morante R, Liekens A, Daelemans W. Learning the scope of negation in biomedical texts. In: Lapata M, Ng HT, eds. Proc. of the 2008 Conf. on Empirical Methods in Natural Language Processing. Stroudsburg: Association for Computational Linguistics, 2008. 715-724. |

| [39] |

Morante R, Daelemans W. Learning the scope of hedge cues in biomedical texts. In Proc. of the BioNLP 2009 Workshop. Stroudsburg: Association for Computational Linguistics, 2009. 28-36.http://dl.acm.org/citation.cfm?id=1572369 |

| [40] |

Morante R, Daelemans W. A metalearning approach to processing the scope of negation. In Proc. of the 13th Conf. on Computational Natural Language Learning (CoNLL 2009). Stroudsburg: Association for Computational Linguistics, 2009. 21-29.http://dl.acm.org/citation.cfm?id=1596381 |

| [41] |

Zhu QM, Li JH, Wang HL, Zhou GD. A unified framework for scope learning via simplified shallow semantic parsing. In: Li H, Màrquez L, eds. Proc. of the 2010 Conf. on Empirical Methods in Natural Language Processing. Stroudsburg: Association for Computational Linguistics, 2010. 714-724.http://dl.acm.org/citation.cfm?id=1870728 |

| [42] |

Zou BW, Qian Z, Chen ZC, Zhu QM, Zhou GD. Negation and uncertainty information extraction oriented to natural language text. Ruan Jian Xue Bao/Journal of Software, 2016, 27(2): 309–328(in Chinese with English abstract).

http://www.jos.org.cn/jos/ch/reader/view_abstract.aspx?flag=1&file_no=4860&journal_id=jos [doi:10.13328/j.cnki.jos.004860] |

| [43] |

Cierniak R. A new approach to image reconstruction from projections using a recurrent neural network. Applied Mathematics and Computer Science, 2008, 18(2): 147–157.

[doi:10.2478/v10006-008-0014-y] |

| [44] |

Juang CF, Chiou CT, Huang HJ. Noisy speech recognition by hierarchical recurrent neural fuzzy networks. In: Proc. of Int'l Symp. on Circuits and Systems (ISCAS 2005). IEEE, 2005. 5122-5125. [doi: http://dx.doi.org/10.1109/ISCAS.2005.1465787]http://ieeexplore.ieee.org/document/1465787/ |

| [45] |

Lin R, Liu SJ, Yang MY, Li M, Zhou M, Li S. Hierarchical recurrent neural network for document modeling. In: Callison-Burch C, Su J, eds. Proc. of the 2015 Conf. on Empirical Methods in Natural Language Processing. Stroudsburg: Association for Computational Linguistics, 2015. 899-907.https://www.researchgate.net/publication/301445948_Hierarchical_Recurrent_Neural_Network_for_Document_Modeling |

| [46] |

Liu PF, Qiu XP, Chen XC, Wu SY, Huang XJ. Multi-Timescale long short-term memory neural network for modelling sentences and documents. In: Callison-Burch C, Su J, eds. Proc. of the 2015 Conf. on Empirical Methods in Natural Language Processing. Stroudsburg: Association for Computational Linguistics, 2015. 2326-2335.https://www.researchgate.net/publication/301445897_Multi-Timescale_Long_Short-Term_Memory_Neural_Network_for_Modelling_Sentences_and_Documents |

| [47] |

Zhou P, Shi W, Tian J, Qi ZY, Li BC, Hao HW, Xu B. Attention-Based bidirectional long short-term memory networks for relation classification. In: Erk K, Smith NA, eds. Proc. of the 54th Annual Meeting of the Association for Computational Linguistics (Vol. 2: Short Papers). Stroudsburg: Association for Computational Linguistics, 2016. 207-212.https://www.researchgate.net/publication/306093736_Attention-Based_Bidirectional_Long_Short-Term_Memory_Networks_for_Relation_Classification |

| [48] |

Tang DY, Qin B, Liu T. Document modeling with gated recurrent neural network for sentiment classification. In: Callison-Burch C, Su J, eds. Proc. of the 2015 Conf. on Empirical Methods in Natural Language Processing. Stroudsburg: Association for Computational Linguistics, 2015. 1422-1432.https://www.researchgate.net/publication/301446024_Document_Modeling_with_Gated_Recurrent_Neural_Network_for_Sentiment_Classification |

| [49] |

Chen HM, Sun MS, Tu CC, Lin YK, Liu ZY. Neural sentiment classification with user and product attention. In: Carreras X, Duh K, eds. Proc. of the 2016 Conf. on Empirical Methods in Natural Language Processing. Stroudsburg: Association for Computational Linguistics, 2016. 1650-1659.https://www.researchgate.net/publication/311990867_Neural_Sentiment_Classification_with_User_and_Product_Attention |

| [50] |

Lapponi E, Velldal E, Øvrelid L, Read J. UiO2: Sequence-labeling negation using dependency features. In: Agirre E, Bos J, Diab M, eds. Proc. of the 1st Joint Conf. on Lexical and Computational Semantics-Vol. 1: Proc. of the Main Conf. and the Shared Task, and Vol. 2: Proc. of the 6th Int'l Workshop on Semantic Evaluation. Stroudsburg: Association for Computational Linguistics, 2012. 319-327.http://dl.acm.org/citation.cfm?id=2387687 |

| [51] |

Zeng DJ, Liu K, Lai SW, Zhou GY, Zhao J. Relation classification via convolutional deep neural network. In: Tsujii J, Hajic J, eds. Proc. of the 25th Int'l Conf. on Computational Linguistics: Technical Papers (COLING 2014). Stroudsburg: Association for Computational Linguistics, 2014. 2335-2344.https://www.researchgate.net/publication/302880860_Relation_classification_via_convolutional_deep_neural_network |

| [52] |

Hinton GE, Srivastava N, Krizhevsky A, Sutskever I, Salakhutdinov R. Improving neural networks by preventing co-adaptation of feature detectors. CoRR, abs/1207. 0580, 2012.http://www.oalib.com/paper/4059375 |

| [53] |

Tateisi Y, Yakushiji A, Ohta T, Tsujii J. Syntax annotation for the GENIA corpus. In: Dale R, Wong KF, Su J, Kwong YO, eds. Proc. of 2nd Int'l Joint Conf. on Natural Language Processing (IJCNLP 2005). Stroudsburg: Association for Computational Linguistics, 2005. 220-225.https://www.researchgate.net/publication/238626641_Syntax_annotation_for_the_GENIA_corpus |

| [54] |

Farkas R, Vincze V, Móra G, Csirik J, Szarvas G. The conll-2010 shared task: learning to detect hedges and their scope in natural language text. In Farkas R, Vincze V, Szarvas G, Móra G, Csirik J, eds. Proc. of the 14th Conf. on Computational Natural Language Learning-Shared Task. Stroudsburg: Association for Computational Linguistics, 2010. 1-12. |

| [42] |

邹博伟, 钱忠, 陈站成, 朱巧明, 周国栋. 面向自然语言文本的否定性与不确定性信息抽取. 软件学报, 2016, 27(2): 309–328.

http://www.jos.org.cn/jos/ch/reader/view_abstract.aspx?flag=1&file_no=4860&journal_id=jos [doi:10.13328/j.cnki.jos.004860]

|

2018, Vol. 29

2018, Vol. 29