随着互联网和多媒体技术的飞速发展, 数字图像、视频等多媒体信息的数量呈爆炸式增长.为了准确、高效地组织、管理和检索图像, 需要计算机准确地理解图像内容.图像分类是解决图像理解问题的重要途径, 对多媒体检索技术的发展有重要的推动作用.作为图像处理的基础, 图像特征表示是该领域的重要研究内容, 其性能直接关系到图像分类、对象识别等问题的处理结果.

Sivic等人[1]提出的视觉词袋模型广泛应用于物体和场景分类中, 并且展现出优秀的性能.该模型借鉴了文本分析领域中的相关概念和思想, 将词袋模型(bag of words, 简称BoW)引入到了计算机视觉领域, 取得了巨大成功.它无需分析图像中的具体目标组成, 而是应用图像的整体统计信息, 将量化后的图像底层特征视为视觉单词, 通过图像的视觉单词分布来表达图像内容.

传统的BoW模型在图像分类与检索等领域都取得了较好的效果, 但该方法假设视觉单词之间相互独立, 使用的视觉单词统计方法忽略了视觉单词的空间位置关系和形状等信息, 在表示图像信息方面还存在局限性.近年来以BoW为基础产生了多种改进的图像特征表示方法.Lazebnik等人[2]提出空间金字塔匹配方法(spatial pyramid matching, 简称SPM), 该方法将图像均匀划分成不同粒度的网格形成图像层次, 并计算各网格内视觉单词出现频率的直方图统计, 将不同层次中各个网格的统计向量进行叠加形成高维特征表示.SPM方法在直方图相交函数的基础上使用了Grauman等人[3]提出的金字塔匹配核函数进行图像分类, 即对不同层次中匹配的视觉单词进行加权.Lu等人[4]使用马尔可夫网络模型捕捉视觉单词之间的垂直和水平空间关系, 形成表示图像的二阶马尔可夫模型, 利用图像上下文、一致性和多样性, 并使用标签传播方法, 建立了基于图的半监督交互式图像分类构架.江悦等人[5]引入图像上下文信息, 通过统计图像中的相异词对和视觉词群形成图像特征.刘硕研等人[6]通过计算视觉单词之间的语义共生概率, 同时引入马尔可夫随机场理论, 提高了视觉单词的语义准确性.近年来, 除了上述图像表示方法外, 还有众多加入视觉短语的图像特征表示方法.Li等人[7]基于BoW模型提出了上下文词袋(contextual bag-of-word, 简称CBoW)模型, 通过计算视觉单词在图像类别上分布的KL分布距离形成视觉词组, 并加入视觉单词之间的语义关系, 同时也应用N-gram方法将视觉单词组成视觉短语进行图像表示.Zhang等人[8]提出了描述性视觉单词(descriptive visual word, 简称DVW)和描述性视觉短语(descriptive visual phrase, 简称DVP)方法, 该方法以某个视觉单词为中心取相应半径范围内的视觉单词组成视觉短语. Zheng等人[9]通过统计近邻视觉单词共同出现的频率来提取视觉短语, 并将其应用于图像检索.Sivic等人[10]使用k近邻方法(k-nearest neighbor, 简称k-NN)形成视觉短语用于图像检索.Wang等人[11]使用meanshift方法聚类视觉单词, 并通过FP-Growth算法挖掘有意义的空间视觉单词组合, 用于图像分类.Zhou等人[12]研究部分重复的网络图像检索, 利用空间编码方法对图像中局部特征的空间关系进行编码, 有效地发现并解决了图像之间局部特征的错误匹配问题.Tian等人[13]结合用户定义的感兴趣区域和特征空间分布来进行基于内容的图像检索, 通过相关性反馈结合了更多的图像空间信息.虽然当前的方法取得了较好的效果, 但容易受到图像特征多变的位置和背景信息的干扰, 且在结合视觉单词空间信息方面, 所生成的视觉单词特征表达能力和区分度不足.因此, 本文通过结合显著区域提取和视觉单词的空间位置关系以及形状信息, 可以使图像特征表示更有区分性和代表性, 从而提高分类性能.

研究发现, 人眼视觉在对物体进行识别时, 往往只对某一显著区域感兴趣[14], 可以通过提取图像的显著区域并且只对显著区域进行处理来避免多余的计算, 避免了背景中杂乱信息的干扰.显著性区域是图像中最能引起用户注意、最能表现图像内容的区域.由于人类视觉系统和注意机制的共性, 使得图像中某些区域总能显著地吸引人视觉的注意, 这些区域往往含有丰富的信息.通过图像的某些底层特征提取图像中的显著性区域, 符合人的主观评价, 是视觉上重要的区域.近年来出现了多种显著性区域提取方法, Itti等人[15]在快速场景分析工作中提出了基于显著性的视觉注意模型, 其主要受早期灵长类动物视觉系统行为和神经元结构的启发, 利用多尺度图像特征组合成单一的视觉显著图.Harel等人[14]提出一种自底向上的视觉显著性模型, 利用生物启发的过滤器提取图像的特征向量, 不同尺度的特征图生成激活图, 基于生物模型和计算能力实现归一化以突出图像显著性区域.Hou等人[16]通过分析输入图像的对数谱, 在谱域中提取图像的谱残差, 提出一种快速的方法在空间域中构建对应的显著性图.Ma等人[17]提出一种图像注意力分析框架, 利用模糊增长算法来模拟人的感知过程, 通过研究人类感知的对比过程, 得到一种基于对比的显著图.由于当前的显著性区域提取方法具有低分辨率、边界模糊和计算复杂度高等问题, 一些方法在目标对象边界处产生较高的显著值而不是均匀地覆盖整个对象.本文中我们使用显著性区域提取方法[18]来估计像素中央-周围颜色与亮度的对比度, 具有均匀突出显著性区域、边界轮廓分明、分辨率高和计算效率高等优点.

本文在视觉词袋模型的基础上, 结合视觉显著度, 引入图像视觉单词拓扑结构相似性约束[19-21]进行图像分类.基于图像显著区域, 首先, 对视觉单词的位置关系进行全局约束, 通过近似最近邻搜索可以得到匹配的视觉单词集[22-24].其次, 采用Delaunay三角剖分方法, 构建DT三角网络, 对视觉单词局部位置关系进一步约束, 应用于图像分类中.通过引入全局位置信息和局部关系信息改进传统的视觉词袋模型, 可以提高图像分类的效率.

本文第1节介绍相关的准备工作, 包括图像分类的基本方法以及显著性区域的提取.第2节详细描述融合空间信息的改进BoW方法, 包括全局限制与局部约束.第3节主要在Caltech101、COIL_100和Caltech256这3个公开的图像集中对本文方法进行验证, 并与其他方法进行比较, 该方法能够有效地提高图像分类效果.最后总结全文, 并对未来值得关注的改进方向进行初步探讨.

1 相关工作 1.1 基于BoW的图像分类方法词袋模型最初应用于文本处理领域, 用来对文档进行分类和识别.词袋模型因为其简单、有效的优点而得到了广泛的应用.其基本原理为将文档看作是无序的关键词的集合, 通过统计每个关键词在单个文档中出现的频率来对文档进行向量表示, 从而进行分类.对应到图像分类技术中, 应用词袋模型进行图像分类包括以下3个步骤:特征提取和描述, 视觉词典构造, 训练分类器进行分类和识别.

应用词袋模型进行图像分类的实现过程可以描述如下.

步骤1.特征提取和描述.给定一幅图像, 特征提取和描述环节的主要任务是从图像中抽取具有代表性的全局和局部特征作为对该图像的描述.传统方法中大多数采用SIFT描述子来实现这一过程, 每一个特征用128维的向量来加以表示.

步骤2.生成视觉词典.采用k-means聚类方法对由步骤1得到的大量特征点进行聚类, 将聚类的中心定义为视觉单词, 所有的视觉单词进行组合则构成视觉词典, 视觉词典的大小即为视觉单词的个数.传统方法中一般采用直接表示的方法, 将图像表示成基于视觉单词的统计直方图.

步骤3.训练分类器进行分类.SVM是较常用且实现较为简单的分类器之一.其核心思想是通过寻找最优超平面对空间中的不同特征集进行划分.该分类器最初只应用于两类的分类问题中, 现在已逐渐应用于解决多类高维分类问题, 并取得了良好的效果.它可以描述为如下优化问题:

| $\mathop {\min }\limits_{\omega ,\xi } \left\{ {\frac{1}{2}{{\left\| \omega \right\|}^2} + c\sum\limits_{i - 1}^n {{\xi _i}} } \right\}.$ |

约束条件为yi(ω·xi-b)≥1-ξi, ξi≥0, i-1, ..., n.其中, ω为与超平面垂直的向量, c为惩罚因子, ξi为稀疏变量, yi的值为1或者-1, 表示数据点所属类别.

本文主要引入显著性区域, 结合视觉单词的空间位置信息来改进传统视觉词袋模型, 并采用SVM分类器实现图像的分类.

1.2 显著区域提取本文选择高斯差分滤波器作为带通滤波器[18].由于该滤波器能够有效地逼近拉普拉斯高斯滤波器, 因此被广泛应用于边缘检测、感兴趣点检测和显著性区域检测.式(1) 给出高斯差分滤波器, 其中, σ1, σ2(σ1 > σ2)是高斯滤波器的标准方差:

| $DoG(x,y) = \frac{1}{{2\pi }}\left[ {\frac{1}{{\sigma _1^2}}{{\text{e}}^{ - \frac{{({x^2} + {y^2})}}{{2\sigma _1^2}}}} - \frac{1}{{\sigma _2^2}}{{\text{e}}^{ - \frac{{({x^2} + {y^2})}}{{2\sigma _2^2}}}}} \right] = G(x,y,{\sigma _1}) - G(x,y,{\sigma _2})$ | (1) |

一个高斯差分滤波器是简单的带通滤波器, 它的通频带宽度由σ1:σ2控制.如果定义σ1=ρσ和σ2=σ, 那么ρ=σ1/σ2, 若将多个高斯差分滤波组合, 那么这些具有标准方差的高斯差分滤波器的总和表述如下:

| $\sum\limits_{n = 0}^{N - 1} {G(x,y,{\rho ^{n + 1}}\sigma ) - G(x,y,{\rho ^n}\sigma ) = G(x,y,\sigma {\rho ^N}) - G(x,y,\sigma } )$ | (2) |

其中, N为正整数, 上式的结果实质上就是两个高斯值的差, 它们的标准方差的比例是R=ρN.如果假设通过σ1和σ2的变化来确保ρ为常数1.6(为了检测边缘的需要), 那么需要增加一些边缘检测算子在不同的图像尺度上的输出, 这样就保证了整个显著性区域都可以得到突出, 而不只是显著性区域的边缘或者其中心部分得到突出.

在计算显著图时, 需要选择适当的σ1和σ2来确保带通滤波器保留所需要的原始图像空间频率.给定足够长的滤波器和σ1与σ2之间足够大的差分, 带通滤波器通频带就可以近似看成来自两个连续的高斯滤波器.由于σ1 > σ2, 那么, ωlc的大小由σ1控制, ωwc的大小由σ2控制.在实际应用中, 这些滤波器的长度不可能足够长, 虽然实现很简单, 但是近似就不够精确.

为了在标准方差下实现大的比例值, σ1被设置成无穷大, 为了消除噪声和纹理的高频信息以及计算上方便, 使用小的高斯核, 这些小的高斯核的二项式滤波器能够很好地拟合离散的高斯值.

对于W×H大小的图像I, 如下式来计算其显著图S:

| $S(x,y) = \left| {{I_u} - {I_{{\omega _{hc}}}}(x,y)} \right|$ | (3) |

其中, Iu是图像I的算术平均灰度值, Iωhc是为了消除纹理细节和噪声将该图像经过高斯模糊后的值.因为对这两者之间的差值大小感兴趣, 因此就用绝对值这个范数来表示, 这样计算较为方便.由于对图像不需要下采样, 所以可以直接得到完整分辨率的显著图.

本文采用自适应阈值Th, 该值设定为图像平均显著值的两倍, 如下式所示:

| $Th = \frac{2}{{W \times H}}\sum\limits_{x = 0}^{W - 1} {\sum\limits_{y = 0}^{H - 1} {S(x,y)} } $ | (4) |

其中, W和H分别是显著图的宽和高, S(x, y)是坐标为(x, y)的像素点对应的显著值.

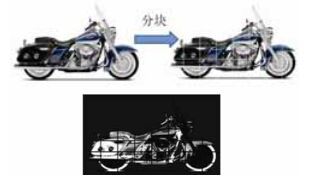

2 改进的视觉词袋模型 2.1 定位图像显著区域将图像分成m×n块, 使用上节的显著区域提取方法

|

Fig. 1 Salient region extraction based on image blocks 图 1 基于图像分块的显著区域提取 |

2.2 特征提取与图像表示

在底层特征提取阶段, 通过提取大量的SIFT特征, 最大限度地对图像进行底层描述, 防止丢失过多的有用信息, 这些底层描述中的信息主要靠后面的特征编码和特征汇聚得到抽象和简并.通过观察图像的SIFT特征可以看到, 虽然提取的SIFT特征并不完全相同, 但在相同姿态下, 所提取的大部分特征的相对位置是大体一样的, 相同姿态下不同物体的SIFT特征维持了很好的几何结构.采用K-means聚类算法, 对图像的局部特征进行聚类, 所有视觉单词形成一个视觉词典, 每个聚类中心被看作是词典中的一个视觉单词, 聚类中心个数即为词典大小.本文中一幅图像I表示为视觉单词w的集合, 每个单词对应的有其在图像中的位置r·I{(w1, r1), (w2, r2), …, (wm, rm))}.其中, 位置r可以由兴趣点和区域检测子检测到, 单词通过局部特征聚类得到.

2.3 高层特征的核函数我们定义单个单词所表示的特征为一阶特征, 两个单词、3个单词表示的特征分别为二阶特征和三阶特征[25, 26], 依次类推.视觉单词的不同空间分布代表不同的特征, 这里采用Σ为视觉单词词汇表, n阶特征fn为从Σ中选取的n个具有特定空间分布的单词.核函数可表示为

| $K(x,y) = \sum\limits_{n = 1}^\infty {{w_n}{K_n}(x,y)} $ | (5) |

其中, 权值wn=u1-n, u在0和1之间.当u接近0时, 我们将更大的权重赋予高阶特征.

| ${K_n}(x,y) = \langle {\phi _n}(x),{\phi _n}(y)\rangle = \sum\nolimits_{{f_n}} {\langle {\phi _{{f_n}}}(x),{\phi _{{f_n}}}(y)\rangle } $ | (6) |

接下来我们引入图像拓扑结构[20]这一概念, 所谓图像的拓扑结构, 是指组成图像的基本要素及其相互关系, 基本要素主要包括图像中的顶点、边界线、区域及其灰度等.

图像分类过程中视觉单词在两幅相似图像之间的分布具有拓扑结构的稳定性, 满足如下拓扑相似性约束条件.

1) 角度顺序约束.任意单词邻域各单词与其连线所形成夹角的顺序基本相同.

2) 邻域约束.若参考图像中单词

3) 三角形位置约束.三角形与点的位置关系不变, 参考图像中点

一幅图像由n个视觉单词组成, 即n个局部区域特征.我们可以获取到所有视觉单词的空间位置和视觉单词种类.这些信息可以被记录为一个配置矩阵:

| ${M_{ij}} = \left( {1 + \frac{{{\text{d}}w_{ij}^2}}{{\sigma _{{\text{d}}w}^2}}} \right)\frac{{{\text{d}}_{ij}^2}}{{\sigma _d^2}},i,j = 1,...,n$ | (7) |

其中,

特征分解揭示了矩阵的子空间结构, 矩阵M的特征分解如下:

| $M = Q\Lambda {Q^{ - 1}},$ |

其中, Q是包含特征向量的标准正交矩阵, Λ是对角矩阵, 对角元素值为降序的特征值.M-1=M×Q=Q×Λ×Q-1×Q, 特征向量可表示为

| $Q = \left( {\begin{array}{*{20}{c}} {{{\vec r}_1}} \\ {{{\vec r}_2}} \\ \vdots \\ {{{\vec r}_n}} \end{array}} \right).$ |

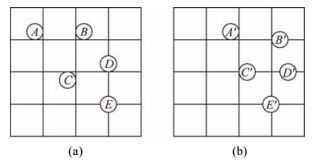

在图像分类中, 两幅相似的图像, 它们的特征空间表示应该是相似的, 如图 2所示, 全局的限制要求特征空间的配置矩阵相似.图像之间的相似性匹配就是要找到一个有序的配置向量使得特征配置矩阵的相似度最大化.

|

Fig. 2 Spatial distribution of visual words between similar images 图 2 相似图像的视觉单词空间分布 |

2.4.2 相似度计算

假设有两幅图像I1和I2, I1中有m个视觉单词, I2中有n个视觉单词.通过特征分解, 我们可以得到每个视觉单词的子空间表示

为了进行匹配, 需要找到两个视觉单词

| ${D_{ij}} = \left\| {{{\vec r}_i}^{(1)} - {{\vec r}_j}^{(2)}} \right\|$ | (8) |

图像I1中的视觉单词i和图像I2中的视觉单词j只有当Dij最小时才匹配.经过全局拓扑约束后, 可以得到匹配的视觉单词集.

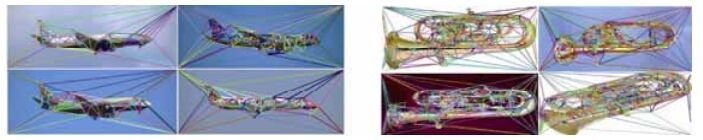

如图 3(a)和图 3(b)所示, 从(a)到(b), 经过了平移、旋转、尺度变换和变形.区域(B, C, D)和(B', C', D')的形状相似, E和E'是一样的.对于图 3(a)和图 3(b), 我们可以得到归一化的特征空间配置矩阵, 进行相似度的计算.

|

Fig. 3 Similar images with similar global topological constraints 图 3 相似图像具有相似的全局拓扑约束 |

2.5 局部位置约束 2.5.1 局部位置描述

在计算几何中, 对于一个散射点模型, 其相似关系可以通过Voronoi图表达.实际上, 一个Voronoi图记录了所有邻近点集的信息.因为Delaunay三角剖分和Voronoi图互为偶图, 也就是一一对应的, 因此也包含了相同的信息.本文将Delaunay三角剖分[27-29]引入视觉词袋模型, 以此来结合视觉单词之间的局部空间位置关系.

在视觉单词构建完成的基础上, 对一幅图像的视觉单词集S进行三角剖分, 端点在S中, 而且只相交于端点, 将S的凸包分割成多个三角形.要满足Delaunay三角剖分的定义, 必须符合两个重要的准则.

(1) 空圆特性:Delaunay三角网是唯一的(任意4点不能共圆), 在Delaunay三角形网中任一三角形的外接圆范围内不会有其他点存在.

(2) 最大化最小角特性:在散点集可能形成的三角剖分中, Delaunay三角剖分所形成的三角形的最小角最大.

Delaulay三角剖分具备如下优异特性.

(1) 最接近:以最近邻的3点形成三角形, 且各线段(三角形的边)皆不相交.

(2) 唯一性:不论从区域何处开始构建, 最终都将得到一致的结果.

(3) 最优性:任意两个相邻三角形形成的凸四边形的对角线如果可以互换的话, 那么两个三角形6个内角中最小的角度不会变大.

(4) 最规则:若将三角网中的每个三角形的最小角进行升序排列, 则Delaunay三角网的排列得到的数值最大.

(5) 区域性:新增、删除、移动某一个顶点时只会影响临近的三角形.

(6) 具有凸多边形的外壳:三角网最外层的边界形成一个凸多边形的外壳.

鉴于上述优点, Delaunay三角剖分很适合描述点集的局部位置关系, 对于n个点, 计算时间复杂度为O(nlogn).通过全局的位置限制, 得到匹配的视觉单词集, 基于这些视觉单词, 我们可以完成Delaunay三角剖分.通过三角剖分来匹配邻近的点, 所有三角形内未匹配的点只能在其他图像的三角形内寻求匹配.只要有新的匹配区域, 就可以继续进行Delaunay三角剖分, 在这一步, 其他的局部限制方法也可以加进来.

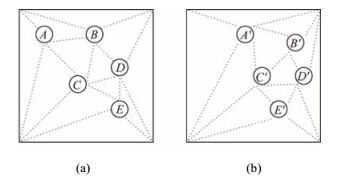

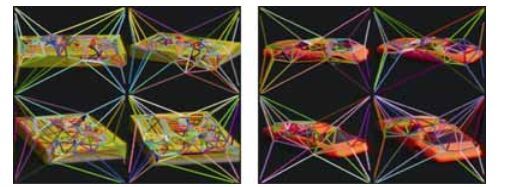

将计算几何的三角剖分方法引入视觉词袋模型, 通过对视觉单词集进行Delaunay三角剖分, 把图像空间上位置相近的视觉单词按照一定规则相连, 得到三角形网络.如图 4所示, 对视觉单词进行Delaunay三角剖分(包括图像的4个顶点), 将图像分成了多个三角形区域.然后基于该网络寻找若干参考单词对, 进行匹配.DT网络最大限度地避免了出现狭长、尖锐的三角形连接, 并具有唯一性.当图像视觉单词表示给定时, 用Delaunay三角剖分对该点进行三角剖分时, 所产生的三角形网格是唯一的, 与视觉单词的排序无关, 只是与视觉单词的拓扑结构有关.可以使得少数视觉单词的缺失、个别干扰视觉单词的出现和视觉单词定位偏差等因素对划分结果的影响尽量限定在一个小的局部范围内.图 4(a)中如果视觉单词A在图 4(b)中没有对应点, 这表明单词A要么对于图 4(b)来说是一种真正缺失的情况, 要么对于图 4(b)来说是一个伪点, 但这都不影响在相应位置右下方找到两对相似三角形.而对于图 4(a)和图 4(b)中对应的视觉单词B和视觉单词C, 虽然视觉单词位置有偏差, 而这也影响到它们与周围若干视觉单词之间的结构, 但并不影响在视觉单词周围找到若干匹配的三角形对.在视觉单词集中插入一个单词, 它仅仅影响到外接圆包含该插入点的三角形, 对Delaunay三角形网格只造成局部影响.只要图像的一些区域没有严重损坏, 都可以进行准确定位, 从而有可能得以正确地识别.

|

Fig. 4 Delaunay triangle subdivision on visual word sets 图 4 视觉单词集进行Delaunay三角剖分 |

Delaunay三角剖分还可以避免产生不稳定和瘦小的三角形.DT网络具有极好的结构稳定性, 它保证了Delaunay三角剖分得到的三角形不是狭长的, 狭长的三角形会导致不稳定性甚至产生错误结果.对几种我们熟知的拓扑结构进行比较后发现, Delaunay三角剖分对于随机的位置扰动具有最好的结构稳定性.

2.5.2 基于三角形限制的图像匹配两幅待匹配图像之间具有几何相似性约束, 且Delaunay三角形网络可以唯一地表示其特征, 所以可以利用两幅图像Delaunay三角网中三角形之间的相似度进行匹配.

三角形相似性匹配包括以下步骤.

1) 相似边

在两幅图像的Delaunay三角网络中, 任意选择一个三角形的边, 分别为L1和L2, 边长为l1l2.边L1连接视觉单词w11和w12, 边L2连接视觉单词w21和w22.

判断两条边是否相似, 需满足以下条件.

(1)

(2)

其中, 阈值T1根据实验情况设定, 若以上条件满足, 则L1和L2为相似边.如果不满足则从参考图像的DT网络中找下一条边和L1进行匹配, 直到图中所有三角边和L1都比对过.如果所有边都比较过, 且没有找到一对相似边, 则表示两幅图像不匹配.

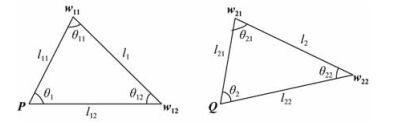

2) 相似三角形

在三角网络中, 边的结构包含4个标志位w1, w2, l, r.w1和w2为两端的顶点单词, l和r对应边的左右是否有三角形.根据一条边的左右标志, 可以找到这条边的左右邻接三角形.现有如图 5所示的Tri1(l11, l12, θ11, θ12, w1)和Tri2(l21, l22, θ21, θ22, w2)两个三角形, l11和l12分别为视觉单词P与w11和w22的距离, l21和l22分别为视觉单词Q与w21和w22的距离.θ1, θ11, θ12为Tri1对应的3个夹角, θ2, θ21, θ22为Tri2对应的3个夹角, w1和w2为视觉单词类型.另外, 基于三角形内角相似即可判断三角形相似的原理, 可以引入三角形的模糊相似度判断[29].三角形Tri1的一个内角为θ1, 那么在另一个三角形Tri2的对应角与该角的差异性变化应该遵循下式的高斯分布:

| ${\text{d}}({\theta _2}) = {{\text{e}}^{ - k{{({\theta _2} - {\theta _1})}^2}}}$ | (9) |

这里, θ2表示另外一个三角形的对应角, d(θ2)表示这两个角的差异值.其中大于0的系数k可以由下式计算:

| $\left\{ {\begin{array}{*{20}{c}} {k = \frac{1}{{2 \times {\sigma ^2}}}} \\ {\sigma = \frac{{{\theta _1} \times {P_{{\theta _1}}}}}{3}} \end{array}} \right.$ | (10) |

|

Fig. 5 The comparison of similar triangle model 图 5 相似三角形的比较模型 |

式(10) 是指

| ${S_{{\theta _1}}} = {\cos ^{{n_s}}}({k_s}(1 - {\text{d}}({\theta _2})))$ | (11) |

基于余弦曲线的特征, 我们可以定义

| ${S_t} = {k_1}{S_1} + {k_2}{S_2} + {k_3}{S_3}$ | (12) |

这里, ki(i=1, 2, 3) 表示两个三角形相应内角的相似度权值, 我们取

判断两个三角形是否相似, 需要验证以下条件.

(1)

(2)

(3)

(4)

其中, T1, T2和TS均是根据实验选取的阈值, 相似三角形比较步骤如下.

Step 1.选取一条相似边, 如果有左右邻接三角形, 则对其进行判断, 若满足以上4个条件, 则认为这两个三角形相似.

Step 2.若不满足以上条件, 则返回上一步骤, 处理下一对相似边.

Step 3.当所有的相似边处理完成, 算法结束, 统计得到的相似三角形并记录其对应的顶点单词.

3) 三角形内点的匹配

在全局拓扑限制下, 还存在一些未匹配的视觉单词, 这些视觉单词位于三角形内部.对于三角形内部点, 只能在其他图像的对应三角形内部寻找匹配点[27].

视觉单词限制在Δabc和Δa'b'c'中, 对于视觉单词Pi在Δabc中, 它和Δabc三条边之间的关系为

| ${P_i} = \alpha {\text{ + }}\beta (b - a){\text{ + }}\gamma (c - a)$ | (13) |

β, γ分别是(b-a)和(c-a)的尺度系数, 已知Δabc的3条边

| $K = \left[ {\begin{array}{*{20}{c}} \alpha \\ \beta \\ \gamma \end{array}} \right] = {\left[ {\begin{array}{*{20}{c}} {{x_a}}&{{x_b}}&{{x_c}} \\ {{y_a}}&{{y_b}}&{{y_c}} \\ 1&1&1 \end{array}} \right]^{ - 1}}\left[ {\begin{array}{*{20}{c}} {{x_i}} \\ {{y_i}} \\ 1 \end{array}} \right]$ | (14) |

其中, Pi=[xi, yi, 1]T, α=1-β-γ.如果Δabc和Δa'b'c'相似, Pi和Δa'b'c'中的单词Pj相匹配, 则Δa'b'c'的3条边也与参数K相关.经过平移、尺度、旋转或者仿射变换后, 估计的匹配单词Pj可以通过Pi的相关计算得到:

| ${P_j} = \left[ {\begin{array}{*{20}{c}} {{x_j}} \\ {{y_j}} \\ 1 \end{array}} \right] = \left[ {\begin{array}{*{20}{c}} {{{x'}_a}}&{{{x'}_b}}&{{{x'}_c}} \\ {{{y'}_a}}&{{{y'}_b}}&{{{y'}_c}} \\ 1&1&1 \end{array}} \right]\left[ {\begin{array}{*{20}{c}} \alpha \\ \beta \\ \gamma \end{array}} \right]$ | (15) |

假定Δabc的3条边[xa, ya, 1]T, [xb, yb, 1]T和[xc, yc, 1]T通过矩阵H变换为对应参照图像中Δa'b'c'的3条边

| ${K_H} = \left[ {\begin{array}{*{20}{c}} {\alpha '} \\ {\beta '} \\ {\gamma '} \end{array}} \right] = {\left[ {\begin{array}{*{20}{c}} {{{x'}_a}}&{{{x'}_b}}&{{{x'}_c}} \\ {{{y'}_a}}&{{{y'}_b}}&{{{y'}_c}} \\ 1&1&1 \end{array}} \right]^{ - 1}}\left[ {\begin{array}{*{20}{c}} {{{x'}_i}} \\ {{{y'}_i}} \\ 1 \end{array}} \right] = {\left( {H\left[ {\begin{array}{*{20}{c}} {{x_a}}&{{x_b}}&{{x_c}} \\ {{y_a}}&{{y_b}}&{{y_c}} \\ 1&1&1 \end{array}} \right]} \right)^{ - 1}}\left( {H\left[ {\begin{array}{*{20}{c}} {{x_i}} \\ {{y_i}} \\ 1 \end{array}} \right]} \right)$ | (16) |

可以证明KH=K.由于点的齐次坐标第3个维度保持为1, 不需要进行归一化, 三角形约束具有平移、旋转、尺度和仿射变换不变性.由于三角剖分将图像平面划分为很小的块, 所以对于噪声和扭曲更加鲁棒.

三角形内的视觉单词可能不止一个, 因此假设视觉单词集为w={wj}, Pj位于单词集w中, Pi和待匹配单词wj的相似性得分由下式计算:

| ${{S}_{i,j}}={{1.5}^{-{{({dis{{t}_{i,j}}}/{R}\;)}^{2}}}}\times {{D}_{i}}^{T}{{D}_{{{w}_{j}}}},\ \ j=1,2,\ldots ,\left| w \right|$ | (17) |

disti, j表示Pi和ωj的欧氏距离, Di和Dw, j分别表示Pi和wj的视觉单词特征向量.其中,

通过对待匹配图像PA的所有视觉单词进行处理后, 将会得到一个与PB的匹配集合T.

最终计算不同阶特征的核函数K(x, y), 用于SVM训练.

3 实验结果与分析实验在Windows 7操作系统(CPU双核2.60GHz, 内存4G), Visual Studio 2010开发工具上由C++语言实现.实验采用Caltech101, COIL_100和Caltech256这3个数据库验证本文算法.Caltech101数据库包含102类共9 145幅图片, 涵盖了由人到物的多种物体种类, 每一类包含40~800张图片.COIL_100数据库包含100种物体类别, 每类物体包含72幅图片, 类内图像具有复杂几何变换和仿射变换等特点.Caltech256数据集包括257类共30 607幅图片, 每个类别至少包含80张图片, 相较于Caltech101数据集, 物体种类更多, 多样性增加.

我们采用的实验框架如下, 首先进行图像分块与显著性区域提取, 提取128维的SIFT特征描述子, 使用标准的K-means聚类算法生成视觉单词表, 其中, 视觉单词容量参数K会在实验中讨论, 然后结合单词的空间位置信息, 构建视觉单词的空间几何模型, 最后应用SVM进行图像分类.我们重复实验10次, 每次随机选择训练图像集和测试图像集, 获得平均准确率和偏差.每个类别随机选择多幅图像作为训练样本, 剩下的用于测试.

在实验中, 我们主要考虑影响分类性能的几个因素, 包括显著区域的提取、分块数、视觉词典个数以及SVM核函数等.

首先, 本文算法在提取特征之前进行显著性区域提取.应用显著区域提取方法, 可以在训练集较小的情况下达到较好的分类性能, 通过对图像进行显著区域提取, 然后根据该区域进行特征提取和聚类, 由此产生的视觉单词更具有代表性, 能更精确地描述图像, 而且能在一定程度上避免复杂背景信息和位置变化带来的干扰和影响.部分图像显著区域的提取效果如图 6所示.传统方法在训练图像较少的情况下性能不太稳定, 这是由于类内图像具有差异性所致.

|

Fig. 6 Extract the saliency region of image 图 6 图像显著区域提取 |

接下来我们对分块数大小的选取进行分析, 分块大小主要影响显著区域的大小和个数.选取分块大小为4×4、5×5、10×10, 分别计算不同分块大小对图像分类准确率的影响, 分块过大, 选取的显著性区域仍会包含大面积的背景区域.分块过小, 使得包含一些显著度不高的目标区域被排除在外.在Caltech101数据集中将所有图像归一化为200×200, 分块数为5×5较好.

分析了显著性区域和分块数之后, 我们将开始在Caltech101数据集上进行实验.在Caltech101数据集上选择5类物体, 包括airplane、euphonium、motorbike、camera、watch.训练集每类随机选择30张图像, 测试集中每类随机选择50张图像.视觉词典大小为500, 实验重复10次, 得到平均分类精确度, 如图 7所示.

|

Fig. 7 Spatial geometry information modeling 图 7 空间几何信息建模 |

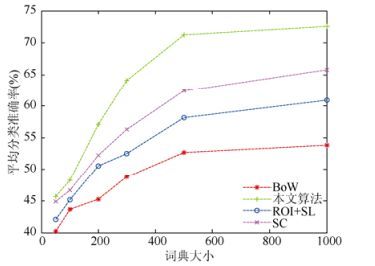

本文工作的主要目的是结合视觉单词的空间位置信息, 以改进视觉词袋模型应用于图像分类中的性能.空间信息编码方法(SC)[12]以及用户自定义感兴趣区域与空间分布相结合的方法(ROI+SL)[13]均利用了图像特征的空间信息, 因此, 我们运用SC算法以及ROI+SL算法改进BoW用于图像分类实验中, 并和本文算法进行比较, 分析本文算法的有效性.

这部分我们针对视觉词典大小对分类性能的影响进行分析, 这里采用不同大小的视觉词典{50, 100, 200, 300, 500, 1000}.如图 8所示, x轴表示词典大小, y轴表示分类准确率, 采用不同数目的视觉单词对分类性能产生一定的影响.根据分类准确率曲线, 我们可以得出使用本文算法、SC算法和ROI+SL算法的分类性能均有所提升, 而且性能均好于传统的BoW模型.当视觉单词数目过小时, 由于不同语义的图像块可能被标记为相似的视觉单词, 使得无论是应用传统BoW模型还是改进的方法, 它们的分类性能都相对较低.随着视觉单词数目的逐步增加, 图像分类性能有所提升, 由于传统BoW模型仅仅应用视觉单词的统计信息, 忽略了视觉单词的空间信息, 其分类准确率明显低于改进的方法, 这说明, 结合视觉单词的空间信息取得了效果.当视觉单词数目为500时, 传统的BoW方法得到的分类准确率仅为52.7%, SC算法得到的分类准确率为62.4%, ROI+SL算法得到的分类准确率为58.2%, 而本文算法得到的分类准确率为71.2%, 加入空间信息后, 分类准确率有很大的提升.

|

Fig. 8 Dictionary capacity's impact on the average classification performance 图 8 词典容量对平均分类性能的影响 |

通过和SC算法以及ROI+SL算法的实验对比, 可以看出本文算法在结合视觉单词空间位置信息上的优越性.SC方法有效地编码了图像特征的空间位置关系, 通过二进制的空间图描述特征对的相对空间位置, 对局部特征施加几何限制.这种方法潜在要求待匹配图像具有重复的图像块, 也就是说, 具有相同或非常相似的匹配特征点的空间构型.由于存在无法避免的量化误差, 该方法使用空间验证来消除错误的匹配.ROI+SL算法结合用户自定义的感兴趣区域和空间分布进行特征匹配, 基于用户定义感兴趣区域和图像分块的重叠百分比赋予图像特征不同的权重, 图像的相似性计算通过单个图像块的相似性距离的线性组合计算得出.以上两种方法的分类准确率均低于本文算法, 其中, SC算法对于具有相同或非常相似的重复图像块的图像均有良好的分类效果, 但是对于Caltech101数据库内类内差别较大的图像类别, 分类效果提升得不会很明显, 图像的仿射变换以及局部特征描述子的偏移也会对实验效果产生影响.ROI+SL算法具有空间依赖性, 用户选取的感兴趣区域对于算法效果影响显著, 人工选取感兴趣区域虽然可靠性高, 但是选取效率低, 依赖于人机交互, 过高的空间依赖导致图像分类效果提升有限.例如, 一幅左下角有车的图像可能很难与右下角有车的图像分为同一类别.本文算法首先运用自适应的方法提取显著性区域, 基于视觉单词拓扑结合策略, 利用矩阵的特征分解有效地提取了关于视觉单词位置的全局信息.引入Delauany三角剖分方法进行局部空间位置约束, 图像空间上位置相近的视觉单词按照一定规则相连, 得到DT网络, DT网络具有良好的结构稳定性, 可以使得少数视觉单词的缺失、个别干扰视觉单词的出现和视觉单词定位偏差等因素对分类结果的影响尽量限定在一个小的局部范围内.本文算法结合了一阶、二阶和三阶单词特征, 将视觉单词的空间几何信息融入传统的视觉词袋模型, 这里提到的n阶特征(n=1, 2, 3), 我们将在下文进行讨论.

本文算法不仅与SC算法和ROI+SL算法进行了比较, 还与文献[30, 31]中的图像分类实验结果进行了对比.文献[30]中主要通过对视觉单词的全局空间分布进行建模, 并利用图像中相同视觉单词对的方向信息, 改进传统BoW模型.文献[31]中提出空间金字塔匹配的改进方法, 捕获更精确的图像特征空间信息.从实验结果可以看出, 加入空间信息的图像特征表示方法具有较好的分类性能, 其中, 文献[30]的分类准确率为67.1%, 文献[31]的分类准确率为65.93%, SC算法的分类准确率为62.4%, ROI+SL算法的分类准确率为58.2%.对比BoW的实验结果分别提升14.4%, 13.23%, 9.7%和5.5%.本文算法的分类准确率相比BoW提升了18.5%, 分类准确率高于以上其他方法, 见表 1.

| Table 1 Classification results for the Caltech101 dataset 表 1 Caltech101图像库上的实验结果 |

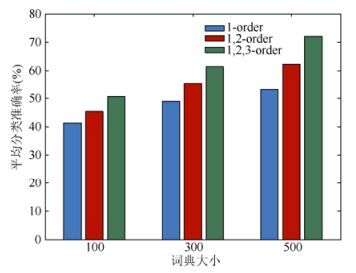

在本文算法中, 我们使用Delaunay三角剖分对单词的空间几何信息进行建模, 几何信息建模的效果如图 7所示.第2.3节已经介绍了高阶特征的定义, 实验中, 我们不仅单独使用n阶特征的核函数Kn(n=1, 2, 3) 进行分类实验, 还使用1到n阶核函数的加权和去验证算法, 其中, u=0.02.我们发现, 无论是单独使用n阶特征的核函数还是进行加权和, 从一阶(视觉单词)到二阶或三阶特征, 效果都获得了提升.这表明, 对视觉单词的空间几何信息建模起到了重要作用.然而随着阶数的增加, 一些图像将不会出现共现的特征.分类效果的精确度将会随着我们提升阶数而有所提高(尽管会在某一阶数停止), 我们发现虽然高阶核函数的精确度会有所下降, 将它和其他阶特征结合在一起, 但高阶特征仍能在一定程度上提升分类性能, 事实上, 高阶特征更具区分能力.

另外, 随着阶数的上升, 某些类别的图像类内相似性降低, 原因在于某些类内图像具有更多变的目标结构、尺度和旋转, 导致共现的高阶特征会减少, 影响了分类性能.

在分类过程中, 我们应用SVM核函数, 对于不同的核赋予不同的权重.如图 9所示, 增加特征阶数后, 可以看到性能的提升.实验中, 我们采用的词典大小为500.我们尝试将词典大小降到100进行图像分类, 在这种情况下, 某些单个的视觉单词将可能变得无意义, 在使用低阶特征进行分类时准确率很低.然而对于SVM, 当提高特征的阶数后, 得到的性能非常接近我们使用500个视觉单词时所获得的性能.这表明, 即使局部特征本身的区分能力不足, 通过提高阶数也能够创造具有区别能力的特征.当将一阶、二阶和三阶特征结合时, 可以达到最好的分类性能.

|

Fig. 9 The influence of different order number for the average classification performance 图 9 不同阶数对于平均分类性能的影响 |

接下来将在COIL_100数据集上进行分类实验, 在COIL_100数据集上随机选择6类物体, 训练集中每类随机选择20张图像, 测试集中每类随机选择50张图像.视觉词典大小为500, 实验重复10次, 得到平均分类精确度.如图 10所示, 为COIL_100数据集上图像视觉单词空间几何信息建模结果.

|

Fig. 10 The spatial geometry information model of visual words 图 10 视觉单词空间几何信息建模 |

本文实验还应用于Caltech256数据集上, 我们在Caltech256数据集中选择10类物体, 包括butterfly、calculator、camel、necktie、elephant等类别.训练集每类随机选择30张图像, 测试集中每类随机选择50张图像.视觉词典大小为1 000, 实验重复10次, 得到平均分类精确度.

表 2为COIL_100图像库中使用不同的方法进行图像分类的实验结果.将本文算法与传统的BoW模型以及SC算法[12]、ROI+SL算法[13]和文献[32]中的方法进行了实验对比, 可以看出, 加入空间信息的特征表示显示了良好的分类性能, SC算法编码了图像特征的空间位置关系, ROI+SL算法基于用户自定义感兴趣区域, 结合了图像特征进行了空间分布, 均在一定程度上提升了图像特征的区分力和表达能力, 提高了分类准确率.本文算法较传统BoW模型的分类准确率提升5.3%, 效果最佳.表 3为在Caltech256图像库中使用不同的特征表示方法进行图像分类的实验结果, Caltech256图像库中类内变化更多样, 分类难度有所增加.表中结果显示本文方法取得了较好的实验结果, 与传统的BoW方法和空间金字塔匹配(SPM)方法[2]、SC算法、ROI+SL算法相比, 分类性能分别提高了10.3%、7.4%、5.3%和13%.文献[33]所采用的卷积神经网络方法效果最佳, 平均准确率为70.6%.然而, 基于卷积神经网络的方法需要大量的样本和时间来学习特征, 因此针对一些小的数据集, 由于不需要预先的监督学习这一步骤, 本文算法仍然能够起到重要的作用, 效果更好.

| Table 2 Classification results for the COIL_100 dataset 表 2 COIL_100图像库上的实验结果 |

| Table 3 Classification results for the Caltech256 dataset 表 3 Caltech256图像库上的实验结果 |

本文算法主要针对传统视觉词袋模型进行改进, 结合视觉单词的空间位置信息, 提高图像特征表示的区分能力, 并应用于图像分类.在采用词袋模型之前, 使用显著性区域检测进行筛选, 分类器是改进的SVM.从表 1~表 3中均可以看出本文算法取得了良好的效果, 克服了图像的几何、旋转和仿射变换的影响, 排除了复杂背景区域的干扰, 对于类内差别较大的数据集, 仍然能够避免背景干扰, 有效应对类内变化, 取得良好的分类效果.

4 总结视觉词袋模型广泛地应用于图像分类领域.在传统词袋模型中, 视觉单词统计方法忽略了视觉词之间的空间信息以及分类对象的形状信息, 导致图像特征表示区分能力不强.本文提出了一种改进的视觉词袋方法, 结合显著区域提取和视觉单词空间位置结构, 采用视觉单词拓扑结构策略和三角剖分方法, 融入全局信息和局部信息, 不仅能够产生更具代表性的视觉单词, 而且能够在一定程度上避免复杂背景信息和位置变化带来的干扰.实验结果表明, 本文算法将空间信息加入视觉词袋模型, 并结合高阶特征, 能够提高图像分类的精确度, 而且与现有方法相比具有优越性.

我们还可以看到本文方法的改进之处, 包括结合其他的核函数来改进视觉单词空间位置模型, 一些其他的编码方法也可以引入, 例如局部软分配方法[34]可以用于软相似度加权.最后, 空间信息还可以由多样的信息提供, 例如颜色和纹理等, 这是一个值得研究的方向.

| [1] | Sivic J, Zisserman A. Video Google:A text retrieval approach to object matching in videos. In:Proc. of the 9th IEEE Int'l Conf. on Computer Vision. IEEE, 2003. 1470-1477.[doi:10.1109/ICCV.2003.1238663] |

| [2] | Lazebnik S, Schmid C, Ponce J. Beyond bags of features:Spatial pyramid matching for recognizing natural scene categories. In:Proc. of the 2006 IEEE Conf. on Computer Vision and Pattern Recognition. IEEE Computer Society, 2006, 2:2169-2178.[doi:10.1109/CVPR.2006.68] |

| [3] | Grauman K, Darrell T. The pyramid match kernel:Discriminative classification with sets of image features. In:Proc. of the 10th IEEE Int'l Conf. on Computer Vision, ICCV 2005. IEEE, 2005, 2:1458-1465.[doi:10.1109/ICCV.2005.239] |

| [4] | Lu ZW, Ip H. Combining context, consistency, and diversity cues for interactive image categorization.IEEE Trans. on Multimedia, 2010, 12(3): 194–203. [doi:10.1109/TMM.2010.2041100] |

| [5] | Jiang Y, Wang RS, Wang C. Scene classification with context pyramid features.Journal of Computer-Aided Design and Computer Graphics, 2010, 22(8): 1366–1373(in Chinese with English abstract). http://www.cnki.com.cn/Article/CJFDTOTAL-JSJF201008020.htm |

| [6] | Liu SY, Xu D, Feng SH, Liu D, Qiu ZD. A novel visual words definition algorithm of image patch based on contextual semantic information.Dianzi Xuebao, 2010, 38(5): 1156–1161(in Chinese with English abstract). http://www.cnki.com.cn/Article/CJFDTOTAL-DZXU201005029.htm |

| [7] | Li T, Mei T, Kweon IS, Hua XS. Contextual bag-of-words for visual categorization.IEEE Trans. on Circuits and Systems for Video Technology, 2011, 21(4): 381–392. [doi:10.1109/TCSVT.2010.2041828] |

| [8] | Zhang SL, Tian Q, Hua G, Huang QM, Li SP. Descriptive visual words and visual phrases for image applications. In:Proc. of the 17th ACM Int'l Conf. on Multimedia. ACM, 2009. 75-84.[doi:10.1145/1631272.1631285] |

| [9] | Zheng QF, Wang WQ, Gao W. Effective and efficient object-based image retrieval using visual phrases. In:Proc. of the 14th Annual ACM Int'l Conf. on Multimedia. ACM, 2006. 77-80.[doi:10.1145/1180639.1180664] |

| [10] | Sivic J, Zisserman A. Efficient visual search of videos cast as text retrieval.IEEE Trans. on Pattern Analysis and Machine Intelligence, 2009, 31(4): 591–606. [doi:10.1109/TPAMI.2008.111] |

| [11] | Wang MY, Zhang CL, Song Y. Extraction of image semantic features with spatial-range mean shift clustering algorithm. In:Proc. of the 10th IEEE Int'l Conf. on Signal Processing (ICSP). IEEE, 2010. 906-909.[doi:10.1109/ICOSP.2010.5655732] |

| [12] | Zhou WG, Lu YJ, Li HQ, Song YB, Tian Q. Spatial coding for large scale partial-duplicate web image search. In:Proc. of the 18th ACM Int'l Conf. on Multimedia. ACM, 2010. 511-520.[doi:10.1145/1873951.1874019] |

| [13] | Tian Q, Wu Y, Huang TS. Combine user defined region-of-interest and spatial layout for image retrieval. In:Proc. of the 2000 Int'l Conf. on Image. IEEE, 2000, 3:746-749.[doi:10.1109/ICIP.2000.899562] |

| [14] | Harel J, Koch C, Perona P. Graph-Based visual saliency. In:Advances in Neural Information Processing Systems. 2006. 545-552. https://nips.cc/Conferences/2007 |

| [15] | Itti L, Koch C, Niebur E. A model of saliency-based visual attention for rapid scene analysis.IEEE Trans. on Pattern Analysis & Machine Intelligence, 1998(11): 1254–1259. [doi:10.1109/34.730558] |

| [16] | Hou XD, Zhang LQ. Saliency detection:A spectral residual approach. In:Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition, CVPR 2007. IEEE, 2007. 1-8.[doi:10.1109/CVPR.2007.383267] |

| [17] | Ma YF, Zhang HJ. Contrast-Based image attention analysis by using fuzzy growing. In:Proc. of the 11th ACM Int'l Conf. on Multimedia. ACM, 2003. 374-381.[doi:10.1145/957013.957094] |

| [18] | Achanta R, Hemami S, Estrada F, Susstrunk S. Frequency-Tuned salient region detection. In:Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition, CVPR 2009. IEEE, 2009. 1597-1604.[doi:10.1109/CVPR.2009.5206596] |

| [19] | Li Y, Tsin YH, Genc Y, Kanade T. Object detection using 2D spatial ordering constraints. In:Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition, CVPR 2005. IEEE Computer Society, 2005, 2:711-718.[doi:10.1109/CVPR.2005.253] |

| [20] | Ma J, Ahuja N. Region correspondence by global configuration matching and progressive Delaunay triangulation. In:Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. IEEE, 2000, 2:637-642.[doi:10.1109/CVPR.2000.854932] |

| [21] | Zeng D, Shi H, Zhang Q. Feature matching between images with multiple similar contents.Journal of Computer-Aided Design & Computer Graphics, 2011, 23(10): 1725–1733(in Chinese with English abstract). http://www.cnki.com.cn/Article/CJFDTOTAL-JSJF201110013.htm |

| [22] | Jegou H, Douze M, Schmid C. Product quantization for nearest neighbor search.IEEE Trans. on Pattern Analysis and Machine Intelligence, 2011, 33(1): 117–128. [doi:10.1109/TPAMI.2010.57] |

| [23] | Kalantidis Y, Avrithis Y. Locally optimized product quantization for approximate nearest neighbor search. In:Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2014. 2321-2328.[doi:10.1109/CVPR.2014.298] |

| [24] | Wei SK, Xu D, Li XL, Zhao Y. Joint optimization toward effective and efficient image search.IEEE Trans. on Cybernetics, 2013, 43(6): 2216–2227. [doi:10.1109/TCYB.2013.2245890] |

| [25] | Zhang YM, Jia ZY, Chen T. Image retrieval with geometry-preserving visual phrases. In:Proc. of the 2011 IEEE Conf. on Computer Vision and Pattern Recognition (CVPR). IEEE, 2011. 809-816.[doi:10.1109/CVPR.2011.5995528] |

| [26] | Zhang YM, Chen T. Efficient kernels for identifying unbounded-order spatial features. In:Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition, CVPR 2009. IEEE, 2009. 1762-1769.[doi:10.1109/CVPR.2009.5206791] |

| [27] | Guo XJ, Cao XC. Good match exploration using triangle constraint.Pattern Recognition Letters, 2012, 33(7): 872–881. [doi:10.1016/j.patrec.2011.08.021] |

| [28] | Tang G. Study on improved fingerprint identification algorithm based on Delaunay triangulation[Ph.D. Thesis]. Shenyang:Northeastern University, 2008(in Chinese with English abstract).[doi:10.7666/d.y1842528] |

| [29] | Li GH, Zhou DX, Dong L, Liu YH, Cai XP. Effective corner matching based on Delaunay triangulation.Signal Processing, 2007, 23(5): 695–698(in Chinese with English abstract). [doi:10.3969/j.issn.1003-0530.2007.05.012] |

| [30] | Khan R, Barat C, Muselet D, Ducottet C. Spatial orientations of visual word pairs to improve bag-of-visual-words model. In:Proc. of the British Machine Vision Conf. BMVA Press, 2012. 89.1-89.11. http://bmvc2012.surrey.ac.uk/ |

| [31] | Zhang E, Mayo M. Improving bag-of-words model with spatial information. In:Proc. of the 25th Int’l Conf. of Image and Vision Computing, IVCNZ. IEEE, 2010. 1-8.[doi:10.1109/IVCNZ.2010.6148795] |

| [32] | Han XH, Chen YW, Ruan X. Multilinear supervised neighborhood embedding of a local descriptor tensor for scene/object recognition.IEEE Trans. on Image Processing, 2012, 21(3): 1314–1326. [doi:10.1109/TIP.2011.2168417] |

| [33] | Zeiler MD, Fergus R. Visualizing and understanding convolutional networks. In:Proc. of the Computer Vision, ECCV 2014. Springer Int'l Publishing, 2014. 818-833.[doi:10.1007/978-3-319-10590-1_53] |

| [34] | Liu LQ, Wang L, Liu XW. In defense of soft-assignment coding. In:Proc. of the 2011 IEEE Int'l Conf. on Computer Vision (ICCV). IEEE, 2011. 2486-2493.[doi:10.1109/ICCV.2011.6126534] |

| [5] | 江悦, 王润生, 王程. 采用上下文金字塔特征的场景分类. 计算机辅助设计与图形学学报, 2010, 22(8): 1366–1373. http://www.cnki.com.cn/Article/CJFDTOTAL-JSJF201008020.htm |

| [6] | 刘硕研, 须德, 冯松鹤, 刘镝, 裘正定. 一种基于上下文语义信息的图像块视觉单词生成算法. 电子学报, 2010, 38(5): 1156–1161. http://www.cnki.com.cn/Article/CJFDTOTAL-DZXU201005029.htm |

| [21] | 曾丹, 史浩, 张琦. 多相似内容图像的特征匹配. 计算机辅助设计与图形学学报, 2011, 23(10): 1725–1733. http://www.cnki.com.cn/Article/CJFDTOTAL-JSJF201110013.htm |

| [28] | 唐果. 基于Delaunay三角剖分的指纹识别改进算法的研究[博士学位论文]. 沈阳: 东北大学, 2008. [doi: 10.7666/d.y1842528] |

| [29] | 李赣华, 周东祥, 董黎, 刘云辉, 蔡宣平. 基于Delaunay三角化的有效角点匹配算法. 信号处理, 2007, 23(5): 695–698. [doi:10.3969/j.issn.1003-0530.2007.05.012] |

2017, Vol. 28

2017, Vol. 28