2. 人机交互北京市重点实验室(中国科学院软件研究所), 北京 100190;

3. 计算机科学国家重点实验室(中国科学院软件研究所), 北京 100190;

4. 国网山东省电科院, 山东济南 250002

2. Beijing Key Laboratory of Human Computer Interaction(Institute of Software, The Chinese Academy of Sciences), Beijing 100190, China;

3. State Key Laboratory of Computer Science(Institute of Software, The Chinese Academy of Science), Beijing 100190, China;

4. State Grid Electric Power Research Institute of Shandong Province, Ji'nan 250002, China

目前,治安监控系统越来越普及,在超市、医院、交通要道,大街小巷中遍布着监控摄像头,每天都产生大量的监控视频,而其中有问题的视频仅仅是少数,在如此多的视频中找到问题视频无异于大海捞针.目前的监控系统还是主要依靠人工观看的方式来排查问题,存在负载过大、人员容易疲惫和出错、报警准确度差、误报和漏报、报警反应时间长、录像数据分析困难的弊端[1].针对这些问题,国内外已经开展了大量的相关研究.目前,关于视频分析的研究主要在于:前、背景分割,运动物体跟踪,目标分类,行为理解等.Tian等人[2]使用3个混合高斯模型来进行背景建模,同时集成密度和纹理信息来移除阴影,使得算法能够适应快速的光线变化,在前景分析中使用同样的混合高斯模型来检测静态前景区域,然后,将这个静态区域反馈给背景模型以完善模型.Hofmann等人[3]采用非参数背景建模范式,用近期观察到的历史像素值来进行背景建模,前景的判断取决于一个判决阈值,通过一个学习参数来决定背景模型的更新.乔少杰等人[4]提出了基于高斯混合模型的轨迹预测方法GMTP,有效地对移动对象进行不确定性轨迹预测,在对监控分析和交通状况预测方面有很大的作用.Wang等人[5]提出通过学习层级性特征来对视觉目标进行跟踪,该方法能够很好地适应复杂的运动转换和追踪目标的外观变化.Yilmaz等人[6]提出一种跟踪完整对象区域的跟踪方法,能够适应不断变化的视觉特征有效地处理遮蔽问题.

现有的大部分工作主要以具体的算法或抽象的数据模型来实现对视频的处理,并且大多是对目标的行为理解和目标追踪方面进行研究,针对对象、场景和事件之间的关联关系等方面的相关研究较少.本文提出一种基于运动目标三维轨迹的关联视频可视分析方法,首先用对目标监控视频前、背景分割的方法获取感兴趣目标,再通过相似度匹配从视频集中筛选出相关的视频,获取各个视频场景内的运动对象的轨迹,由于二维的轨迹不能有效地表示运动物体的自遮蔽现象、循环运动和停留等状态,并且由于缺乏时间信息,难以对多条轨迹进行关联分析,因此,我们将时间维度加入运动轨迹中,通过将轨迹三维可视化显示,然后通过对比分析各个对象轨迹之间的空间关系和时间关系建立多种关联关系统计模型,从而实现对各个对象的关联分析,能够对治安行为进行过滤和预警,辅助人员对视频进行分析,通过在视频流中标定异常区,能够有效地减轻监控视频分析的工作量.

1. 相关工作目前,运动轨迹分析研究工作大多是利用二维轨迹对目标进行异常行为判断.比如,Wang等人[7]通过一个无监督学习框架将一个分割成多个语义区域,通过长期观察并结合聚类分析场景内运动物体的运动轨迹来学习场景内各种语义行为,建立语义场景模型来检测异常活动.Zhu等人[8]通过多目标检测和跟踪算法获取足球射门事件中球员和球的运动轨迹,构建了基于多轨迹的一种球员与足球之间的时空交互分析,将射门事件中球员使用的战术呈现给专业人士进行分析.Piciarelli等人[9]提出了一种实时的、适用于视频监控系统的动态轨迹聚类方法,能够实现低层次的目标跟踪并为高层次的事件分析收集有价值的信息.Bashir等人[10]提出了一种基于运动轨迹的、对视频序列的紧凑的索引和有效的检索机制.上述研究主要通过将轨迹聚类来分析行为模式、检测异常行为,大多数研究都是针对二维轨迹进行分析,没有涉及到多条轨迹之间的关联关系,没有将轨迹的时间属性有效地利用.

Nguyen等人[11]针对二维轨迹难以解决运动轨迹的自相交、重复和停留等时序模糊问题,提出了运动轨迹的三维化,并支持通过对轨迹进行操作来播放视频内容.Rajvi等人[12, 13]提出了一种以对象为中心的视频导航和操作方式,将物体的运动轨迹三维化显示,通过对物体的轨迹进行各种操作来对视频进行编辑.上述研究工作主要针对二维轨迹呈现形式上的一些缺陷,将二维轨迹扩展到三维空间,充分利用时间信息,但是他们的工作重点是通过操作轨迹实现对视频内容的浏览与编辑,并没有利用轨迹来进行目标对象之间的关联分析.Meghdadi等人[14]针对监控视频提出了一种基于三维轨迹的可视分析系统.该系统不仅展示三维轨迹,而且显示出目标对象所有时间的动作图像,三维轨迹不仅提供位置信息而且包含速度信息.但是该系统只针对单个对象进行行为异常判断,不能进行多个对象之间的关联分析.

本文将目标的运动轨迹进行三维化显示,支持对视频的导航和对运动对象的行为分析,通过联合场景与对象,并根据对象轨迹之间的时空关系建立关联模型,帮助用户对各对象之间及对象与场景之间进行关联分析,提高对视频的分析效率.并通过对场景相关信息的统计,结合预设定的规则,实现对异常行为的预警,辅助用户决策与分析.

2. 运动目标的三维轨迹生成 2.1 视频数据预处理为了有效地对大量治安监控视频进行分析,需要事先对视频内容进行处理.首先,为了提取嫌疑目标特征,我们对目标视频进行前景分离,前景分离主要是通过背景进行建模,再将新的视频帧与背景模型对比得出前景目标.目前,一些主流的背景建模方法有平均背景法、混合高斯模型、CodeBook[15]方法等.其中,平均背景法比较简单且易于实现,但是其分割效果不理想,而且不能处理动态背景;混合高斯模型能够处理动态模型,但是算法复杂,计算量大,且对大而慢的物体检测效果差;CodeBook方法在背景建模时允许运动物体的存在,算法简单,计算快,能够很好地处理时间起伏.

本文采用CodeBook方法来预处理视频提取感兴趣前景目标,Codebook采用量化/聚类的技术,从长时间的观测镜头序列中获得背景模型,能够感知像素剧烈变化,或者针对有移动物体或者更复杂的场景建立背景模型.Codebook算法为每个像素建立一个Codebook,每个Codebook含有一个或者多个码字,每个码字记录背景学习的亮度阈值、像素变化的更新时间以及对应像素的访问频率等,通过收集这些信息,可以了解每个像素的变化情况,从而获得视频中的背景模型.

CodeBook算法为当前图像的每一个像素建立一个含有n个RGB向量的色彩序列V={v1,v2,…,vn}和一个含有K个码字CodeWord(CW)的CodeBook(CB)结构C={c1,c2,…,cK},每个CodeBook结构又由多个CodeWord (CW)组成.CW的形式如下:

CW={Imax,Imin,Vmax,Vmin,Tlast,T}.

每个像素的CodeBook包含的码字数目不尽相同,取决于像素采样值的变化.在背景模型训练阶段,我们将t时刻采样所得的vt(R,G,B)与当前该像素的CodeBook比较,确定与之匹配的码字cm,然后更新信息,如果没有匹配的码字,则创建新的码字添加到该像素的码本中.

使用已建立好的码本对视频进行前景目标检测方法如下:设判断前景的范围像素边界上下界为Vmin和Vmax,对于当前待检测图像上的像素I(x,y),遍历该像素对应的像素背景模码本中的每一个码字,若存在一个码字使得I(x,y)在像素边界范围内,则I(x,y)被判断为背景,否则被判断为前景.

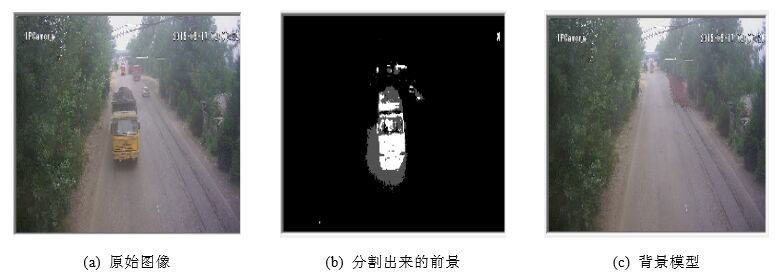

为了处理全局和局部的光照变化,如阴影和高亮区等,我们采用双模型方法,采用一个主模型M,用于正常的前、背景分割;用另一个重建模型R来承担替换工作.我们统计画面中前景数目的比例p,当由于光线变化导致原有的背景模型失效,导致大量前景目标的出现,从而p在短时间内大幅度变化时,我们尝试用重建模型R来替换主模型以适应光线的变化.图1为使用CodeBook方法进行前、背景分割的效果图.

|

图1 CodeBook方法进行前、背景分割 Fig.1 Foreground/Background segmentation using CodeBook |

在监控视频分析中,往往需要在大量的监控视频数据对目标对象进行排查,在目前的治安监控分析中,一般是采用人工观看的方式进行筛选,这种方式容易造成人员的疲劳,从而出现疏忽导致排查出现差错.本文采用SIFT (scale-invariant feature transform)特征[16]来进行目标的匹配检测.使用前、背景分割所得到的前景目标,在待筛选视频库中进行匹配筛选.图2给出了待检测图像、目标图像和使用SIFT特征进行目标识别的结果.

|

图2 使用SIFT特征匹配结果 Fig.2 Target matching using SIFT feature |

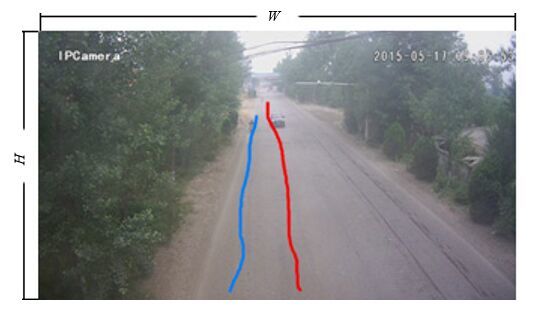

经过上述两步得到包含感兴趣目标的视频合集,采用光流算法来获取视频合集中运动物体的轨迹,如图3所示.轨迹数据为目标对象相对于当前图像背景的一系列二维坐标值(xt,yt)(0<x<w;0<y<h;w,h分别为图像帧的宽和高;t为该图像帧的时间序号).

|

图3 运动物体轨迹获取 Fig.3 Obtaining trajectory of moving object |

通过对视频资料的预处理,得到了我们需要的运动对象的二维轨迹数据.二维的轨迹由于缺少时间信息,难以处理运动物体的循环运动和停留现象,并且对于轨迹之间的相互遮蔽和自遮蔽也不能准确表示.因此,我们加入时间维度,将二维轨迹扩展到三维空间,如图4所示.

|

图4 用时间维度扩展轨迹 Fig.4 Extend trajectory using time dimension |

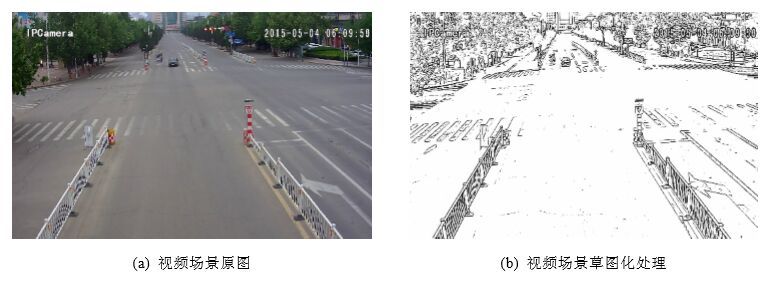

通过OPENGL三维建模的方式初始化三维空间坐标轴,以Z轴作为时间轴对二维轨迹数据进行扩展,将时间维度与二维轨迹(xt,yt)相结合得到目标对象的三维轨迹坐标(x,y,t),各个场景信息平铺在XOY平面上.我们提供两种方式对场景信息进行展示,一种是使用场景真是背景图片,另一种是将场景图片进行草图化再进行展示.使用场景原图片的好处是能够结合轨迹和真实场景快速地构建运动目标的实际运动状况,缺点是当多个场景拼合在一起时相互干扰,从而降低用户对对象关联性的判断.草图的形式仅保留有用信息,简洁抽象,用户所需处理的信息量少,能够快速地找到感兴趣的内容.场景图像经过草图化后去掉了冗余的信息,保留了场景主要的结构信息,便于多个场景进行融合拼接,有利于跨场景分析.我们使用文献[17]提出的一种改进的CLD算法将场景原图进行草图化处理,如图5所示.将草图化的场景平铺在XOY平面上,其相对位置参考监控场景的实际相对位置进行分布,由于(x,y)是相对于原监控场景的二维坐标,因此针对每个场景,需要添加场景在XOY平面上重新分布后的偏移值(offsetx,offsety),新的三维轨迹为(x+offsetx,y+offsety,t).

|

图5 视频场景背景模型草图化 Fig.5 Sketching of video scenes’ background model |

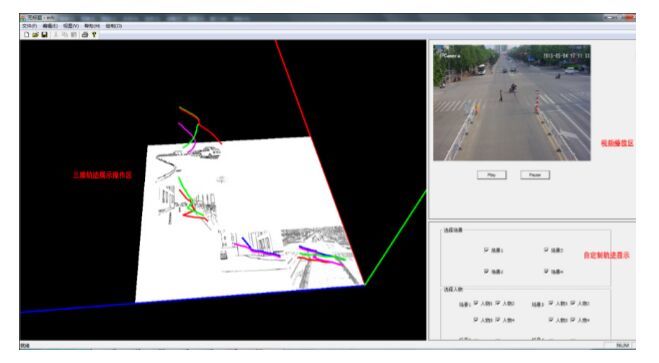

程序的用户界面如图6所示,界面左侧区域为三维轨迹显示区域,在这里可以对轨迹进行交互操作,包括平移、旋转、放大和缩小等功能.通过转换不同的视角,可以看到更多的信息.程序右上区为视频播放区域,可以通过对轨迹进行点击拖拉等操作来控制相应视频的播放.在右下区,用户可以根据实际的需求进行特定场景和特定人物的轨迹显示等操作.

|

图6 运动目标三维轨迹可视化 Fig.6 3D visualization of moving object’s trajectory |

程序可支持对轨迹进行直接操作(如图7所示).比如,通过点击轨迹上某一点,可以定位视频内容到相应的位置;通过拉选轨迹上的某一段,可以循环地播放这一段视频内容等.

|

图7 通过轨迹操作视频 Fig.7 Browsing video by manipulating trajectory |

使用草图交互的形式进行交流具有很强的表现力,能够更直接有效地表达自己的意图,而且草图的交互方式符合人们长久以来形成的书写习惯,可以快速、准确地表达抽象的概念和想法,因此,程序采用一些草图手势来帮助用户更好地对视频进行分析操作.如图8所示,草图手势支持对视频内容的浏览和编辑,选中特定轨迹段后,可进行快进播放(上拉手势)、慢速播放(下拉手势),或跳过该内容(打叉手势),也可以链接两段轨迹来选择不同场景内的关联视频进行拼接播放.采用草图手势对轨迹进行编辑后,可以让视频按照设定的方式进行播放,这样能够帮助用户集中主要精力观看感兴趣的内容,跳过无关信息.通过拼接不同轨迹的视频内容,便于对不同场景下对各对象进行对比分析.用户还可以在分析的过程中对重要的情节添加草图注释,以便于记录分析过程.

|

图8 通过草图手势编辑和浏览视频 Fig.8 Editing and viewing video by sketch gesture |

整个系统的模块组成如图9所示.我们首先将目标视频输入到预处理模块进行预处理,预处理模块中对目标视频进行前、背景分离,获取嫌疑目标特征信息,经过SIFT特征进行目标匹配,在视频资料库里筛选关联视频,使用光流算法在关联视频中提取运动目标的运动轨迹信息,将这些轨迹数据输入统计模块和三维可视化分析模块中,结合草图交互模块和用户预设规则对视频中的运动对象进行关联性分析,查找异常行为.

|

图9 系统模块图 Fig.9 System module diagram |

轨迹数据是一系列以时间为序号的二维空间坐标值,A={xi,yi,ti},其含义为t时刻目标在场景(x,y)处.现定义轨迹A与所在场景S之间在t1时刻与t2之间的关联性C(A,S): $$C(A,S) = \sum\limits_{i = {t_1}}^{{t_2}} {{{({x_i} - \bar x)}^2} + {{({y_i} - \bar y)}^2}} ,$$ 其中,$\bar x$为在t1时刻与t2内轨迹A的x坐标值的均值,$\bar y$为在t1与t2时刻内轨迹A的y坐标值的均值.如果关联性C(A,S)<阈值eS,则认为A与场景S强相关($\varepsilon = L \times \omega \times \frac{{{t_2} - {t_1}}}{T}$,T为轨迹的总时间;L为轨迹的长度;w为经验系数,与场景的大小相关).如图10所示,轨迹A在t1时刻与t2时刻一直在场景内徘徊逗留,经计算可得C(A,S)<eS,分析可知,对象A与场景S具有一定的关联.对象与场景间的关联性是通过计算对象是否在场景内逗留以及逗留的时间长短来决定二者之间的关联性大小,因此,若对象A与场景S相关联,对象B与场景S相关联,并不能由此推测出对象A与对象B相关联;若对象A与对象B相关联,且对象A与场景S相关联,则可以推出对象B与场景S相关联.

|

图10 多视角分析轨迹与场景关联性 Fig.10 Association analysis between trajectory and scene through multi-view |

假设在场景S内有轨迹$A = \{ x_i^A,y_i^A,{t_i}\} $和轨迹$B = \{ x_i^B,y_i^B,{t_i}\} $,现定义轨迹A与轨迹B在t1时刻与t2时刻之间的关联性C(A,B): $$C(A,B) = \sum\limits_{i = {t_1}}^{{t_2}} {{{(x_i^A - x_i^B)}^2} + {{(y_i^A - y_i^B)}^2}} $$

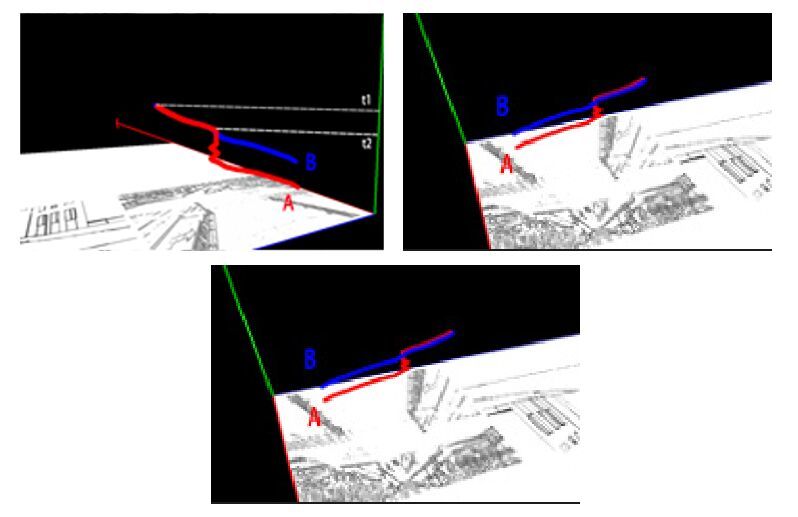

如果关联性C(A,B)<阈值eS,则认为目标A与目标B强相关($\varepsilon = L \times \omega \times \frac{{{t_2} - {t_1}}}{T}$,T为轨迹持续的总时间;L为轨迹A和轨迹B的平均长度;w经验系数,与场景的大小相关).如图11所示,红色轨迹A与蓝色轨迹B在t2开始交汇,然后一直并行到t1时刻.可以看出:在这段时间内,A与B有很强的关联.经计算,值C(A,B)<阈值eS.计算对象之间的关联性,是通过判断随着时间变化,二者轨迹的变化是否趋同,因此,若对象A与对象B相关联,对象C与对象B相关联,则可以判断出对象A与对象C相关联.

|

图11 多视角分析对象之间轨迹关联性 Fig.11 Association analysis between trajectory and object through multi-view |

通过对轨迹间和轨迹与场景间的关联性计算,我们大致定义6种关联模型,见表1和表2,目标对象之间的关联关系为相遇、同行、跟随、会面;对象与场景之间的关系为经过和逗留.举例说明如下:

| 表1 对象之间的关联关系 Table 1 Association between objects |

| 表2 对象与场景间的关联关系 Table 2 Association between object and scene |

· 设有对象A和对象B,当A和B的轨迹在某一短暂时刻内关联性强,而其他时刻关联性又较弱时,则认为A和B的关联关系为相交,即A和B仅仅在某一时刻遇到一起,没有发生任何交集;

· 当A和B的轨迹在很长一段时间内保持强关联系,并且A和B的轨迹在这一时刻与场景的关联性很强时,即A和B在这短时间内在场景内逗留,则表明A和B在该场景内会面;

· 当A和B的轨迹在很长一段时间内保持强关联系,但是A和B的轨迹与场景关联性不强时,即A和B只是经过该场景,则认为A和B的关联关系为同行;

· 若A和B同时出现在多个场景内,并且二者的轨迹形状相似但是关联性并不强,则认为A和B为跟随关系;

· 如果对象A与场景S在某段时间内的关联性强,则认为对象A在场景S逗留;

· 如果A在轨迹持续时间内与场景S的关联性都不强,则认为对象A只是经过场景S.

通过对运动目标的三维轨迹可视化关联分析,我们能够快速地找到与感兴趣目标相关联的对象和场景,能够直接定位到与目标有关的事件位置.如图12所示,程序可以通过轨迹数据给出各个运动目标相对于场景的出现时间和出现次数的统计图,并结合人工事先定义的规则定义查找一些异常现象,如,在某场景出现超过一定次数或在某时刻出现在场景内.通过该统计图,用户可以快速发现异常状况,从而进行针对性处理.

|

图12 对象与场景出现信息统计图示例 Fig.12 Statistical information of object appearance in scene |

本文针对人工对监控视频进行排查和分析的困难现状,提出了一种基于运动目标三维轨迹的关联视频可视分析方法来辅助人工分析视频.该方法首先提取目标对象的特征信息,在视频库内筛选关联视频,获取视频内运动对象的轨迹信息并进行三维可视化,通过结合场景和对象轨迹对运动目标进行行为和关联分析,支持用草图的交互方式在分析过程中进行操作和添加注释来辅助分析.通过对轨迹和场景进行关联性计算,建立关联模型,能够有效地帮助用户快速地分析视频内容,找出视频内的隐藏关联.在基于对视频内容的统计结果上结合人工规则,可以对视频内的异常行为进行预警.我们下一步的工作将重点研究提高对象关联的检测准确度,加强程序的自动化程度,减少人工干预,进一步减轻用户负担,并尝试使用卡尔曼滤波器的方式实现对运动轨迹的预测功能.在后续的研究工作中,会进一步结合实际案例加以调整,并针对系统的交互功能进行用户研究.结合更多的实验案例来验证程序的有效性.

| [1] | Ou W, Liu R, Jiang HM. Application of intelligent video surveillancetechnology in TV monitor system. Electrical Technology of Intelligent Buildings, 2007,5(1):3-5(in Chinese with English abstract). |

| [2] | Tian YL, Lu M, Hampapur A. Robust and efficient foreground analysis for real-time video surveillance. In:Proc. of the IEEE Computer Society Conf. on Computer Vision and Pattern Recognition (CVPR 2005). IEEE, 2005. 1182-1187.[doi:10.1109/CVPR. 2005.304] |

| [3] | Hofmann M, Tiefenbacher P, Rigoll G. Background segmentation with feedback:The pixel-based adaptive segmenter. In:Proc. of the IEEE Computer Society Conf. on Computer Vision and Pattern Recognition Workshops (CVPRW 2012). IEEE, 2012. 38-43.[doi:10.1109/CVPRW.2012.6238925] |

| [4] | Qiao SJ, Jin K, Han N, Tang CJ, Gesangduoji, Gutierrez LA. Trajectory prediction algorithm based on Gaussian mixture model. Ruan Jian Xue Bao/Journal of Software, 2015,26(5):1048-1063(in Chinese with English abstract). http://www.jos.org.cn/1000-9825/4796.htm[doi:10.13328/j.cnki.jos.004796] |

| [5] | Wang L, Liu T, Wang G, Chan KL, Yang Q. Video tracking using learned hierarchical features. IEEE Trans. on Image Processing, 2015,24(4):1424-1435.[doi:10.1109/TIP.2015.2403231] |

| [6] | Yilmaz A, Li X, Shah M. Contour-Based object tracking with occlusion handling in video acquired using mobile cameras. IEEE Trans. on Pattern Analysis and Machine Intelligence, 2004,26(11):1531-1536.[doi:10.1109/TPAMI.2004.96] |

| [7] | Wang X, Tieu K, Grimson E. Learning semantic scene models by trajectory analysis. In:Proc. of the Computer Vision (ECCV 2006). Berlin, Heidelberg:Springer-Verlag, 2006. 110-123.[doi:10.1007/11744078_9] |

| [8] | Zhu GY, Huang QM, Xu CS, Rui Y, Jiang SQ, Gao W, Yao HX. Trajectory based event tactics analysis in broadcast sports video. In:Proc. of the 15th Int'l Conf. on Multimedia. ACM Press, 2007. 58-67.[doi:10.1145/1291233.1291250] |

| [9] | Piciarelli C, Foresti GL, Snidaro L. Trajectory clustering and its applications for video surveillance. In:Proc. of the IEEE Conf. on Advanced Video and Signal Based Surveillance (AVSS 2005). IEEE, 2005. 40-45.[doi:10.1109/AVSS.2005.1577240] |

| [10] | Bashir F, Khokhar A, Schonfeld D. Real-Time motion trajectory-based indexing and retrieval of video sequences. IEEE Trans. on Multimedia, 2007,9(1):58-65.[doi:10.1109/TMM.2006.886346] |

| [11] | Nguyen C, Niu Y, Liu F. Direct manipulation video navigation in 3D. In:Proc. of the SIGCHI Conf. on Human Factors in Computing Systems. ACM Press, 2013. 1169-1172.[doi:10.1145/2470654.2466150] |

| [12] | Shah R, Narayanan PJ. Trajectory based video object manipulation. In:Proc. of the IEEE Int'l Conf. on Multimedia and Expo (ICME 2011). IEEE, 2011. 1-4.[doi:10.1109/ICME.2011.6012069] |

| [13] | Shah R, Narayanan PJ. Interactive video manipulation using object trajectories and scene backgrounds. IEEE Trans. on Circuits and Systems for Video Technology, 2013,23(9):1565-1576.[doi:10.1109/TCSVT.2013.2248972] |

| [14] | Meghdadi AH, Irani P. Interactive exploration of surveillance video through action shot summarization and trajectory visualization. IEEE Trans. on Visualization and Computer Graphics, 2013,19(12):2119-2128.[doi:10.1109/TVCG.2013.168] |

| [15] | Kim K, Chalidabhongse TH, Harwood D, Davis L. Real-Time foreground-background segmentation using codebook model. Real-Time Imaging, 2005,11(3):172-185.[doi:10.1016/j.rti.2004.12.004] |

| [16] | Lowe DG. Distinctive image features from scale-invariant keypoints. Int'l Journal of Computer Vision, 2004,60(2):91-110.[doi:10.1023/B:VISI.0000029664.99615.94] |

| [17] | Ma CX, Liu YJ, Fu QF, Liu Y, Fu XL, Dai GZ, Wang HA. Video sketch summarization, interaction and cognition analysis. Science China Information Sciences, 2013,43(8):1012-1023(in Chinese with English abstract).[doi:10.1360/112013-1] |

| [1] | 欧维,刘荣,蒋红梅.智能监控技术在电视监控系统中的应用.智能建筑电气技术,2007,5(1):3-5. |

| [4] | 乔少杰,金琨,韩楠,唐常杰,格桑多吉,Gutierrez LA.一种基于高斯混合模型的轨迹预测算法.软件学报,2015,26(5):1048-1063. http://www.jos.org.cn/1000-9825/4796.htm[doi:10.13328/j.cnki.jos.004796] |

| [17] | 马翠霞,刘永进,付秋芳,刘烨,傅小兰,戴国忠,王宏安.基于草图交互的视频摘要方法及认知分析.中国科学:信息科学,2013,43(8): 1012−1023. [doi: 10.1360/112013-1] |

2016, Vol. 27

2016, Vol. 27