2. 中国科学院大学, 北京 100190 ;

3. 国家体育总局 体育科学研究所, 北京 100061

2. University of Chinese Academy of Sciences, Beijing 100190, China ;

3. China Institute of Sport Science, General Administration of Sport, Beijing 100061, China

Kinect v2是微软第二代Kinect, 搭载于微软新一代游戏机Xbox one上, 用于感知3D图像和音频, Kinect v2的ToF处理器芯片是TSMC 0.13 1P5M[13, 14].Kinect v2, 如图 1所示, 包含一个彩色相机、深度相机、红外光发射器.通过Kinect v2可以获取场景的深度、彩色、红外图像信息.

|

Fig. 1 Hardware and raw data of Kinect v2 图 1 Kinect v2硬件结构图和原始数据 |

1.1 Kinectv2技术参数

表 1是两代Kinect的技术参数对比.相比于Kinect v1, Kinect v2拥有更出色的彩色相机, 彩色相机分辨率为1920x1080, 高于第一代的1280x960, 且色彩的保真度更高.Kinect v2视角更大, 其水平视角为70°, 垂直视角为60°; Kinect v2有更高的数据传输速度, 最大支持深度每秒60帧的深度数据获取.Kinect v2有3倍于Kinect v1的深度保真度, 使得Kinect v2能够更容易获取物体更多的细节, 如图 2所示, 可以看出, Kinect v2深度图更精细.Kinect v2深度数据还有运动模糊小、高动态范围等优点.但是, Kinect v2的深度分辨率为512x424, 小于Kinect v1的640x480, 且深度数据含有更多的噪声数据, 关于Kinect v2的噪声在下文中会有详细介绍.

|

Fig. 2 Depth images of two generation Kinect 图 2 两代Kinect深度图比较 |

| Table 1 Technology specification of Kinect v1 and v2 表 1 Kinect v1与Kinect v2的技术参数对比 |

1.2 Kinectv2测量原理

Kinect v2采用ToF测距, 利用方波调制相机光源, 光源的平均频率为80MHz.通过相位检测来得到发射光和经过物体反射后的光的相位偏移和衰减, 从而计算光从光源到物体表面然后再回到传感器的总的飞行时间, 根据光的往返飞行时间进而可以求得物体到传感器的距离.通过以下公式(1)计算深度.

| $ 2d = \frac{{phase}}{{2{\rm{\pi }}}} \cdot \frac{c}{f} $ | (1) |

d为深度, phase是调制信号相位偏移, c为光速, 光在空中的飞行速度约为c=3×108m/s, f为传感器的调制频率.

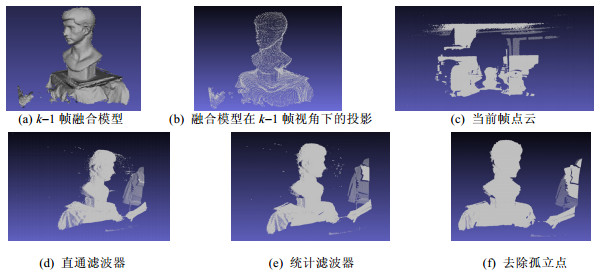

2 Kinectv2深度图去噪本文针对目标物体和大规模复杂场景进行三维建模.对于目标物体的重建, 我们利用直通滤波器选择出特定视场内的物体进行重建, 这样既可以避免不必要物体的干扰, 又能去除Kinect v2质量较差的视场边缘数据, 最后选择最为理想的深度数据进行特定物体三维重建.假设深度图表示为(u, v, d), 其中, u, v表示深度图的像素坐标, d表示深度.直通滤波器选择满足条件的深度值进行重建.假设深度图中心点的坐标为(u0, v0), 深度图的长为w, 宽为h, 则我们可以通过式(2)选择深度图像中心周围处的深度值.

| $ \left\{ {\begin{array}{*{20}{c}} {{u_0} - (w/2) \times r \le u \le {u_0} + (w/2) \times r}\\ {{v_0} - (h/2) \times r \le v \le {v_0} + (h/2) \times r} \end{array}} \right. $ | (8) |

其中, r表示保留的比率值, r=1表示保留整个深度值.还可以设置深度范围阈值, 假设用max表示允许的深度的最大值, min表示最小值, 则通过min < d < max可以选择有效的深度值范围.如图 3(c)所示, 即为原始深度图 3(d)经过直通滤波器处理后的结果.

|

Fig. 3 图 3 |

如图 3(c)、图 3(d)所示, Kinect v2包含较多的噪声数据, 尤其是在物体边缘处.类似于Rusu[15]利用物体表面具有平滑性特征, 我们可以通过统计物体表面的形状特征, 去除引起表面突变的噪声点.不同点在于, Rusu[15]只利用单一点云数据的统计特征处理自身噪声.我们在利用历史数据流进行统计物体表面特征后再对当前帧进行去噪声处理.本文基于KinectFusion算法加权融合数据流, 可以从多个噪声点云加权融合得到低噪声表面.虽然没有从根本上去除噪声误差累计的影响, 但是我们可以利用这个光滑表面作为物体表里平滑程度的先验知识, 从而修正后面数据流中的噪声, 从根本上解决误差累计的问题.假设当前输入为第k帧数据流, 我们统计利用前k-1帧重建的物体模型的表面光滑程度, 如图 3(a)所示.基于时间效率上的考虑, 我们不直接在重建表面上进行统计, 而是利用光线追踪算法将已经构建好的表面重新投影到k-1帧相机深度图上, 如图 3(b)所示, 利用深度图统计此时物体表面的光滑程度.显然, k-1帧融合的数据比当前帧数据更能表示物体表面.k-1帧和k帧之间只有细微的移动, 这样利用k-1帧摄像机位置获取的物体表面就能很好地代表k帧物体表面的光滑特征, 从而有效地去除噪声.

以重投影的深度图中每个深度值(ui, vi, di)为窗口中心, 选取窗口大小为winSize×winSize的窗口区域, 计算此窗口区域中所有深度d分布的方差σi.设n=winSize×winSize.

| $ {\sigma _i} = \frac{1}{{n - 1}}\sqrt {\sum\limits_{j = 0}^n {{{({d_{ij}} - \mu )}^2}} } $ | (3) |

dij表示以di为中心的窗口中的相邻元素的深度值.µi为窗口中深度值的平均值.将所有的方差组成方差集合s={σ1σ2, …, σk}, 此时, 每个深度值对应一个σi.计算此方差集合的平局值和方差μs, σs.保留满足公式(6)方差对应的深度值, 其中, t为一个浮点数阈值.如图 3(e)所示为滤波之后的效果.

| $ {\mu _s} = \frac{1}{n}\sum\limits_{l = 0}^k {{\sigma _l}} $ | (4) |

| $ {\sigma _s} = \frac{1}{{n - 1}}\sqrt {\sum\limits_{l = 0}^k {{{({\sigma _{\rm{l}}} - {\mu _s})}^2}} } $ | (5) |

| $ {\mu _s} - t \times {\sigma _s} < {\sigma _{\rm{i}}} < {\mu _s} + t \times {\sigma _s} $ | (6) |

在经过以上两种方法滤波之后, 可能还包含一些孤立的噪声点, 如图 3(e)所示.以深度图中每个深度值(ui, vi, di)为窗口中心, 选取窗口大小为winSize×winSize的窗口区域, 计数此窗口区域中有效的深度值数n, 当n小于某个阈值时, 我们认为这个点为孤立的一个点, 可以将此孤立点过滤, 如图 3(f)所示为我们最后得到的效果.

3 Kinectv2标定由于只用到了深度图重建物体的三维形状, 本系统可以在任意室内光照条件下工作.我们对Kinect v2的深度相机进行标定.针对Kinect v2的深度相机, 采用张正友[16]标定法, 并利用标定工具[17]进行标定.使用20个不同角度的深度相机获取的红外图片进行标定.表 2是标定得到的深度相机内参系数.

| Table 2 Intrinsic parameters of depth camera 表 2 深度相机内参数 |

4 Kinectv2三维重建

本文在构建基于Kinect v2的重建系统时, 整体的三维重建算法遵循了KinectFusion[4]的算法框架.在此基础上, 本系统的主要贡献是:第一, 利用Kinect v2 SDK提供的基本的API驱动, 构建了重建系统的深度数据获取模块.第二, 增加了深度数据噪声处理、深度摄像机标定模块.第三, 实现了一套完整的低成本实时精确三维扫描解决方案.

4.1 KinectFusion算法简介KinectFusion[4]基于Kinect v1, 能够实时地对任意复杂室内场景在变化的光照条件下进行精确重建.整个KinectFusion算法框架包含3个主要模块.首先, 物体表面测量.根据深度相机返回的深度图和深度传感器的内参得到物体表面顶点坐标和法线信息.第二, 相机姿态估计.整个姿态估计是一个点到平面(point-to-plane)的ICP算法框架[18].采用帧与模型(frame-to-model)的点云选取策略.将当前帧点云与整个融合模型在前一帧位置的光线投影侧面点云进行配准, 而不是将当前帧与前一帧点云进行配准.这种策略在一定程度上能够解决闭合环路(loop closure)问题.由于Kinect能够提供每秒30帧的深度数据, 那么相邻两帧之间运动很小, 在点与点匹配的选取上, 采用了投影数据结合(projective data association)[19]算法.第3个主要模块是场景表示.整个物理场景利用一个全局三维体[20]表示, 每个体素单元中包含一个距离值和一个权值.距离值采用截断符号距离函数(TSDF)表示空间某点与物体表面的距离, 当TSDF值为0时表示物体表面, TSDF值为负表示物体内部, TSDF值为正表示物体到传感器之间的可见空间.当新一帧的测量数据产生时, 根据姿态估计将当前帧的数据TSDF值和权值加权融合到全局三维体中, 最后利用移动立方体(marching cubes)算法得到最终的三维网格模型.

KinectFusion算法能够实时、精确地获得物体的三维模型, 这在业界引起了广泛的研究与应用.目前, KinectFusion算法集成到了微软Kinect的SDK中, 但是源代码并没有公开, PCL(Point Cloud Library)[21]提供了基于Kinect v1的KinectFusion算法开源实现, 但其目前并不支持Kinect v2的数据读取.据我们所知, 现在还没有看到基于Kinect v2的物体重建开源系统.

4.2 Kinectv2物体重建系统Kinect v2对平台硬件软件要求比较苛刻, 操作系统需Win 8/Win 8.1, 软件开发平台为Visual Studio 2012以上, 显卡支持DX11, 内置的USB 3.0, 内存最好在4G以上, CPU要求64位, 最好是i7 2.5GHz以上.本文系统构建的环境是, Win 8.1/Visual Studio 2012/GeForce GTX 660/USB3.0/8G/i7-4770k 3.5G.

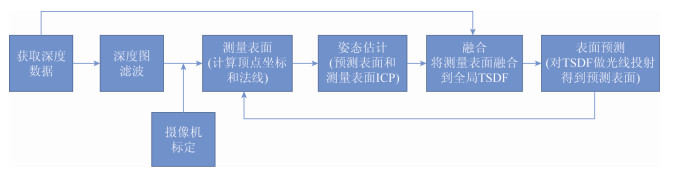

图 4是整个重建系统的算法框架.在PCL[21]开源KinectFusion算法的基础上修改构建而成, 修改了数据获取模块, 增加了深度图滤波和摄像机标定模块.PCL及其PCL依赖的开源库(vtk, boost, qull, flann, eigen)都要在Visual Studio 2012环境下编译使用.以下是各个步骤的详细介绍.

|

Fig. 4 The framework of Kinect v2 reconstruction system 图 4 基于Kinect v2的重建系统算法框图 |

1) 获取深度数据模块, PCL在实现KinectFusion算法数据获取时采用了OpenNI, OpenNI现在不支持Kinect v2, 且目前OpenNI网站已经关闭.我们使用Kinect for Windows SDK 2.0提供的接口函数来构建数据获取模块.将此模块替换原有的OpenNI深度数据获取模块.

2) 深度图滤波模块, 主要实现了本文设计的去噪算法.

3) 摄像机标定, 采用张正友标定算法对深度相机进行标定, 获得摄像机标定参数, 用于将深度图转化为点云.

4)测量表面获取, 根据深度数据和标定参数, 计算获取表面顶点和顶点的法线信息.

5) 姿态估计, 根据对全局模型做光线投射得到的预测表面与新输入的测量表面进行点到平面的ICP算法, 得到当前摄像机的位置.

6) 融合, 将当前帧的数据和摄像机的位置信息结合, 从而将当前数据帧融合到全局模型中.

7) 表面预测, 根据前一帧摄像机的位置, 投影全局的TSDF模型得到模型的前一帧位置的一个侧面.整个算法实时运行, 能够达到每秒25帧左右, 最后对全局模型使用移动立方体算法得到最终的三维网格模型.

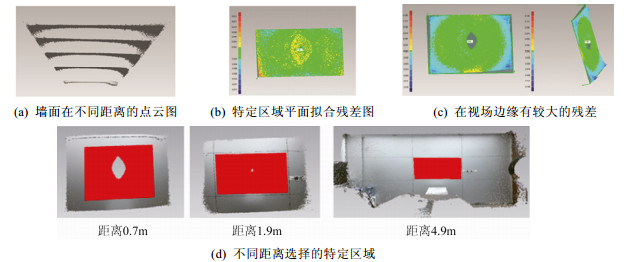

5 实验结果 5.1 Kinectv2深度测量精度分析为了确定Kinect v2的随机误差与距离的关系, 我们采用平面拟合[22, 23]来进行测试.选取办公室墙面作为被采集的平面, 将传感器垂直于墙面放置.虽然Kinect v2有效空间最小可以在0.5m以内, 但是这个距离拍摄的墙面含有较大的空洞(即没有深度数据), 实验从0.7m到4.9m向后移动Kinect v2深度传感器, 间隔0.6m获取一次墙面点云, 总共采集8次, 如图 5(a)所示.对于获取到的点云数据, 我们选取特定区域采用Geomagic进行平面最佳拟合, 得到点云到拟合平面距离分布的标准差, 也就是残差的分布情况, 如图 5(b)所示.

|

Fig. 5 图 5 |

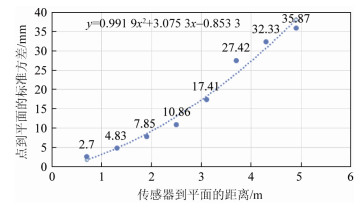

对于特定区域的选取, 前两次选择视角中间区域合适大小的区域, 后面6次选择墙面的同一个区域, 如图 5(d)所示.这样选择的原因是, 第一, 我们选取的墙面区域比较大, 这样就使得选取的墙面区域在传感器距离比较远时仍然能够占据视场较大的区域.第二, 实验发现, 在视场边缘处有较大的残差, 如图 5(c)所示, 这个残差由于在ToF发射的红外光在视场边缘位置反射回来的光振幅较小[24]和深度相机的畸变系数所致.选取视场中间部分可去除视场边缘点云的影响, 图 7是我们最后得到的Kinect v2标准差与距离的关系.

|

Fig. 7 Relationship between standard deviation and distance for Kinect v2 图 7 Kinect v2标准差与距离的关系 |

为了与第一代Kinect相对比, 我们采用相同的方式得到了Kinect v1平面标准差与距离的关系, 如图 6所示.实验结果表明, Kinect v2标准方差与距离基本呈线性变化, 而Kinect v1标准方差与距离呈二次多项式变化.这是由设计原理所致, Kinect v1原理本质上体现为立体视觉原理, 其深度分辨率与距离呈二次曲线变化关系.而Kinect v2采用的是ToF技术, 精度依赖于光源频率和信噪比.在更大深度范围内, Kinect v2的精度大大优于Kinect v1, 这表明, Kinect v2比第一代更适合远距离大场景重建, 如图 8所示, 将两代Kinect固定于同一位置, 对距离2m的人脸模型进行重建, Kinect v2重建出来的模型明显比Kinect v1重建出来的模型更为精细.

|

Fig. 6 Relationship between standard deivation and deviation for Kinect v1 图 6 Kinect v1标准差与距离的关系 |

|

Fig. 8 Reconstruct far away object, the left one is reconstructed by Kinect v2 and the right one is reconstructed by Kinect v1, the distance between object and sensor is 2m around 图 8 对远处物体的重建, 左图是Kinect v2, 右图是Kinect v1, 物体距离传感器为2m左右 |

5.2 物体重建

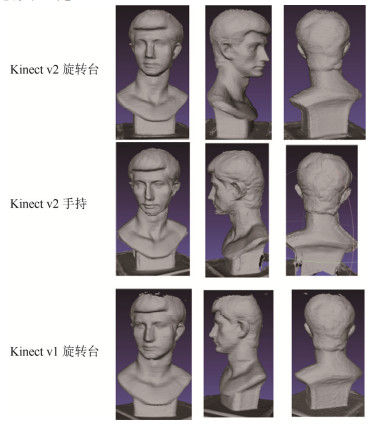

对特定物体实时高精度重建, 我们的这个系统支持两种方式, 一种是手持Kinect传感器绕着固定物体旋转, 另一种是将特定物体置于旋转平台上, 将Kinect传感器固定, 对旋转平台进行旋转.我们选择整个场景表示的三维体物理大小1×1×1m3, 体素分辨率为512×512×512, 将物体置于传感器1m左右的位置.图 9所示为实验结果.其结果表明, 对于第1种方式, 能够从更多的视角在不同的深度上扫描被重建的物体, 相较于第2种方法, 重建结果包含更多的细节信息.但是, 由于运动的不规则性, 鲁棒性不如第2种方法, 且在方便性上也不如第2种方法.Kinect v2与Kinect v1重建的结果相比较, 在这种近距离下没有明显的不同.

|

Fig. 9 Reconstrut object on rotating platform or by handheld Kinect 图 9 物体置于旋转台与手持Kinect重建 |

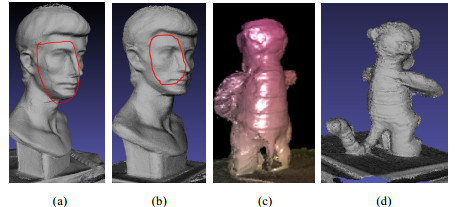

通过本系统可以方便地对物体进行快速、精确的三维重建, 选取了有代表性的常见物体进行重建, 包括:具有简单表面的抱枕和花盆, 具有复杂表面的玩具老虎, 还有具有现代设计感的电风扇, 以及应用广泛的人脸和人脚模型, 如图 12(a)所示为这些物体的彩色图片, 图 12(b)是这些物体重建后的结果.我们采用旋转台的方式, 手动驱动旋转台, 旋转一周所花时间大概在15~40s之间.本系统所有算法都采用GPU并行加速实现, 重建的速度能够达到每秒25帧左右, 能够做到实时重建.所以, 对于特定物体重建的时间也在15~40s这个区间内, 亦即旋转一周转台所花费的时间, 表 3统计了每个物体的实际物理尺寸、重建模型的点个数和重建时间.

|

Fig. 12 图 12 |

| Table 3 Object reconstruction 表 3 重建物体 |

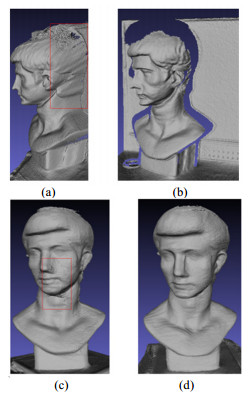

接下来的实验对比了增加去噪声算法后的结果.如图 10(a)、图 10(b)所示, 边缘噪声对场景重建结果有很大的影响, 在物体边缘部分明显有错误重建的地方.实验结果显示, 去噪算法能够有效地去除这种噪声.如图 10(c)、图 10(d)所示, 去噪算法能够有效地减少表面噪声.

|

Fig. 10 (a)(c) Reconstruction without denoise (b)(d) Reconstruction with denoise 图 10 去噪声后重建的效果, (a)和(c)是未经去噪处理的重建结果, (b)和(d)是经过去噪处理的结果 |

将本系统的重建结果与微软提供的Kinect v2 KinectFusion SDK算法进行比较.利用Kinect Studio采集数据, 以相同的数据流作为输入, 如图 11(a)、图 11(c)所示为微软KinectFusion SDK重建结果, 图 11(b)、图 11(d)是本系统的重建结果.由图 11(a)、图 11(b)对比可以看出, 在旋转一圈重建整个物体时, 微软SDK含有较为严重的误差累计.由图 11(c)、图 11(d)可以看出, 微软SDK不能重建较为精细、复杂的物体, 而本系统成功地对此物体进行了重建.

|

Fig. 11 (a)(c) Reconstruction by Microsoft KinectFusion SDK (b)(d) Reconstruction by our method 图 11 (a)和(c)为微软KinectFusion SDK重建结果, (b)和(d)是本系统的重建结果 |

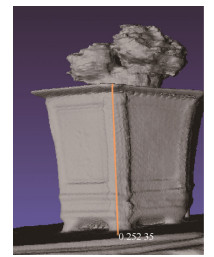

对于重建好的模型, 选取一些测量对象进行测量, 如图 13所示, 以花盆为例的测量过程, 将测量结果与真实测量值进行比较, 统计测量的相对误差见表 4.最后得到的平均相对误差为1.8%.

|

Fig. 13 Measure the high of flowerpot using 3D model 图 13 利用三维模型测量花盆的高度 |

| Table 4 Object measurement 表 4 物体测量 |

最后, 我们将本系统用于重建办公桌场景和人体, 如图 14所示.此时, 选择场景三维体的物理尺寸为3x3x3m3, 物体的体素分辨率为512×512×512.手持Kinect进行场景扫描.从实验结果可以看出, Kinect v2在某些区域有较大的误差, 分析发现, Kinect v2对于电脑屏幕、黑色物体, 平面法线与Kinect v2视线近垂直时有较大误差.Kinect v2应用于复杂场景的重建鲁棒性存在问题.我们还将本系统用于重建人体, 人坐在旋转椅子上, 对旋转椅子进行重建, 如图 14所示.

|

Fig. 14 Kinect v2 scene and human body reconstruction 图 14 Kinect v2场景与人体重建结果 |

6 结论

通过分析, Kinect v2深度精度随距离变化呈线性变化, 且在较大深度范围内具有较高的精度.本文实现的物体重建系统能够方便地对物体进行实时、精确的重建.针对Kinect v2深度图进行设计去噪流程提高了重建的鲁棒性和准确性.我们的系统利用单台Kinect v2对物体重建, 既支持使用简易旋转平台, 又支持手持Kinect v2重建物体, 且适用于对各种物体重建, 包括人体.下一步的工作将重点解决Kinect v2在重建复杂大场景时的鲁棒性问题.

| [1] | Berger K, Meister S, Nair R, Kondermann D.A state of the art report on Kinect sensor setups in computer vision.In:Time-of-Flight and Depth Imaging.Sensors, Algorithms, and Applications.Berlin, Heidelberg:Springer-Verlag, 2013.257-272.[doi:10.1007/978-3-642-44964-2_12] |

| [2] | Han J, Shao L, Xu D, Shotton J. Enhanced computer vision with microsoft Kinect sensor:A review. IEEE Trans.on Cybernetics, 2013, 43 (5) :1318–1334. [doi:10.1109/TCYB.2013.2265378] |

| [3] | Li SR, Tao KL, Wang SY, Li HY, Cao WG, Li H. 3D reconstruction by Kinect sensor a brief review. Computer Aided Drafiting, Design and Manufacturing, 2014, 24 (1) :1–11. http://www.doc88.com/p-9039398401507.html |

| [4] | Newcombe RA, Davison AJ, Izadi S, Molyneaux D.KinectFusion:Real-Time dense surface mapping and tracking.In:Proc.of the 10th IEEE Int'l Symp.on Mixed and Augmented Reality (ISMAR).IEEE, 2011.127-136.[doi:10.1109/ISMAR.2011.6092378] |

| [5] | Roth H, Vona M.Moving volume KinectFusion.In:Proc.of the BMVC.2012.1-11.http://bmvc2012.surrey.ac.uk/ |

| [6] | Whelan T, Kaess M, Fallon M, Johannsson H, Leonard J.Kintinuous:Spatially extended KinectFusion.2012.https://www.researchgate.net/publication/279843674_Kintinuous_Spatially_Extended_KinectFusion |

| [7] | Chen J, Bautembach D, Izadi S. Scalable real-time volumetric surface reconstruction. ACM Trans.on Graphics (TOG), 2013, 32 (4) :113. [doi:10.1145/2461912.2461940] |

| [8] | Henry P, Krainin M, Herbst E, Ren X, Fox D.RGB-D mapping:Using depth cameras for dense 3D modeling of indoor environments.In:Proc.of the 12th Int'l Symp.on Experimental Robotics ISER.2010.[doi:10.1007/978-3-642-28572-1_33] |

| [9] | Henry P, Krainin M, Herbst E, Ren X, Fox D. RGB-D mapping:Using Kinect-style depth cameras for dense 3D modeling of indoor environments. The Int'l Journal of Robotics Research, 2012, 31 (5) :647–663. [doi:10.1177/0278364911434148] |

| [10] | Liu X, Xu HR, Hu ZY. GPU based fast 3D-object modeling with Kinect. Acta Automatica Sinica, 2012, 38 (8) :1288–1297(in Chinese with English abstract). [doi:10.3724/SP.J.1004.2012.01288] |

| [11] | Zhou J, Pan JJ, Tong J, Liu LG, Pan ZG. Fast 3D human body reconstruction from Kinects. Journal of Computer-Aided Design & Computer Graphics, 2013, 25 (6) :873–879(in Chinese with English abstract). [doi:10.3969/j.issn.1003-9775.2013.06.015] |

| [12] | Tong J, Zhou J, Liu L, Pan Z, Yan H. Scanning 3D full human bodies using Kinects. IEEE Trans.on Visualization and Computer Graphics, 2013, 18 (4) :643–650. [doi:10.1109/TVCG.2012.56] |

| [13] | Payne A, Daniel A, Mehta A, Thompson B, Bamji CS.7.6 A 512×424 CMOS 3D time-of-flight image sensor with multi-frequency photo-demodulation up to 130MHz and 2GS/s ADC.In:Proc.of the 2014 IEEE Int'l Solid-State Circuits Conf.Digest of Technical Papers (ISSCC).IEEE, 2014.134-135.[doi:10.1109/ISSCC.2014.6757370] |

| [14] | Sell J, O'Connor P. The Xbox one system on a chip and Kinect sensor. Micro, 2014, 34 (2) :44–53. [doi:10.1109/MM.2014.9] |

| [15] | Rusu RB, Marton ZC, Blodow N, Dolha M, Beetz M. Towards 3D point cloud based object maps for household environments. Robotics and Autonomous Systems, 2008, 56 (11) :927–941. [doi:10.1016/j.robot.2008.08.005] |

| [16] | Zhang Z. A flexible new technique for camera calibration. IEEE Trans.on Pattern Analysis and Machine Intelligence, 2000, 22 (11) :1330–1334. [doi:10.1109/34.888718] |

| [17] | Bouguet JY.Camera calibration toolbox.2013.http://www.vision.caltech.edu/bouguetj/calib_doc/2013 |

| [18] | Chen Y, Medioni G. Object modelling by registration of multiple range images. Image and Vision Computing, 1992, 10 (3) :145–155. [doi:10.1016/0262-8856(92)90066-C] |

| [19] | Blais G, Levine MD. Registering multiview range data to create 3D computer objects. IEEE Trans.on Pattern Analysis and Machine Intelligence, 1995, 17 (8) :820–824. [doi:10.1109/34.400574] |

| [20] | Curless B, Levoy M.A volumetric method for building complex models from range images.In:Proc.of the 23rd Annual Conf.on Computer Graphics and Interactive Techniques.ACM, 1996.[doi:10.1145/237170.237269] |

| [21] | PCL.Point Cloud Library.2014.http://www.pointclouds.org/2014 |

| [22] | Khoshelham K.Accuracy analysis of Kinect depth data.In:Proc.of the ISPRS Workshop Laser Scanning, Vol.XXXVⅢ-5/W12.2011.133-138.[doi:10.5194/isprsarchives-XXXVⅢ-5-W12-133-2011] |

| [23] | Smisek J, Jancosek M, Pajdla T.3D with Kinect.In:Consumer Depth Cameras for Computer Vision.London:Springer-Verlag, 2013.3-25.[doi:10.1007/978-1-4471-4640-7_1] |

| [24] | Foix S, Alenya G, Torras C. Lock-In time-of-flight (ToF) cameras:A survey. Sensors Journal, 2011, 11 (9) :1917–1926. [doi:10.1109/JSEN.2010.2101060] |

| [10] | 刘鑫, 许华荣, 胡占义. 基于GPU和Kinect的快速物体重建. 自动化学报, 2012,38 (8) :1288–1297. [doi:10.3724/SP.J.1004.2012.01288] |

| [11] | 周瑾, 潘建江, 童晶, 刘利刚, 潘志庚. 使用Kinect快速重建三维人体. 计算机辅助设计与图形学学报, 2013,25 (6) :873–879. [doi:10.3969/j.issn.1003-9775.2013.06.015] |

2016, Vol. 27

2016, Vol. 27