2. 计算机软件新技术国家重点实验室(南京大学), 江苏 南京 210023

2. State Key Laboratory for Novel Software Technology (Nanjing University), Nanjing 210023, China

摄像机的广泛使用和网络社交的蓬勃兴起,使人们可以轻易地获取大量的视频段,这为基于视频的人脸识别技术的研究提供了便利.而在当今生活中,基于视频的人脸识别技术也起着越来越重要的作用,我们可以利用公共场所的视频段查询和确认犯罪份子的身份、帮助寻找走失和被拐儿童,还可以利用视频信息完成网上银行开户、在线支付等功能,保障和促进信息安全、互联网金融等领域的快速发展.因此,基于视频的人脸识别在近年来成为研究热点.相对于在受控环境下进行的传统人脸识别任务,来自不受控环境的视频人脸识别更具有挑战性,需要解决分辨率低、光照和姿态变化剧烈、遮挡等问题,如何充分利用视频中的人脸信息以解决这些问题,一直是本领域研究的核心内容[1].

1.1 研究现状在基于视频的人脸识别中,度量待识别的视频段与视频库中的各视频段之间的距离是核心问题,目前,解决该问题的方法主要分成3种,即,基于视频序列的(sequence-based)、基于图像集的(image set-based)、基于稀疏表示和字典学习的(sparse and dictionary-based).表 1中对各种方法的代表文献进行了总结.

| Table 1 Categorization of existing methods for VFR 表 1 基于视频的人脸识别现有方法分类 |

充分利用视频的空间时间序信息,通过训练模型将同一视频序列中不同表情或姿态的人脸组合在一起,能够很好地刻画人脸的动态变化[5],但识别效果易受视频序列长短或光照的影响.

• 基于图像集的方法

将每段视频都看成一个无序的图像集,待识别视频段的图像集称为疑问集(query set),视频库中的称为画廊集(gallery set),每个已知视频段都对应一个画廊集.先对每个图像集进行建模,再度量疑问集与每个画廊集之间的距离.从建模的角度讲,本方法可分为有参数[6, 7]和无参数[8, 9, 10, 11, 12, 13, 14, 15, 16, 17, 18]两种.有参数模型中,每个图像集都用一个带参数的分布函数来描述,一般用高斯模型,两个分布之间的KL距离(kullback-leibler divergence)代表了两个图像集的相似度,当相比较的图像集都服从同一分布而且是指定的模型时效果是好的;否则,识别的效果将变差.在无参数模型中,每个图像集被表示成一个线性子空间(linear subspace)或非线性流形(nonlinear manifold),用子空间之间的距离和流形到流形的距离(manifold-to-manifold distance,简称MMD)来度量两个图像集的相似度.子空间的方法易被噪声和遮挡干扰,而且当光照或表情姿态等变化时,即使属于同一段视频中的图像也会表现出明显的非线性[19, 20].基于MMD的方法在很多被广泛研究的人脸库中都取得了很好的效果,但在每个非线性流形中的子线性片聚类时,存在角度偏差现象[16].例如,在一个图像集的Manifold中,侧脸角度15o~30o的聚为一个线性片;但在另一个图像集中,有可能是25o~40o的聚在一起,因此影响了距离计算.为解决这个问题,Cui等人[16]提出了一个参照图像集(reference set),尽量涵盖所有的角度.每个画廊集和疑问集都按参照图像集的方式聚类产生子线性片,解决了角度偏差问题,但是一个“好”的参照图像集并不好设定.而且在基于MMD的方法中,当图像集中所包含的图像非常少,即,不充足采样时,不能很好地进行聚类,会影响识别的效果.

• 基于稀疏表示和字典学习的方法

近年来,越来越多的研究者通过稀疏表示和字典学习来解决基于图像集的人脸识别问题[21, 22, 23, 24, 25, 26, 27].Chen YC等人[22]和Chen SK等人[23]都是令疑问集与待比较画廊集做同样方式的分块,分别用重建误差和块之间的距离做相似性度量,都对灯光和姿态变化鲁棒.但前一方法中,子字典的寻找和图像重建较耗时;而后一方法中存在有些分块不被使用的情况,而且两者都存在角度偏差问题.Elhamifar等人[21]曾提出过一种类级稀疏(class-level sparsity),即把每个图像集都看成一个集成体,然后再在所有集成体上进行稀疏运算.Cui等人[24]采用了这种思想,同时提出了一种原子级稀疏(atom-level sparsity),通过两层稀疏,在若干个与疑问集相似的画廊集中重建疑问集中的每个图像,取得了很好的效果,而且对噪声鲁棒.但对两个参数的设置比较敏感,而且没有给定可以满足大多需求的参数的通用取值,在某种程度上成为用户的一种负担.Bhatt等人[25]首次提出融合同一视频中的多个帧的有序列表来形成该视频的可判别签名的方法,充分利用了空间时间序和人脸的局部信息.但正由于需要利用这些大量的信息,所以计算量很大,尤其是视频较长时.Patel等人[26]提出了一种同时学习特征矩阵和字典的方法,解决了分开学习时产生的判别信息减损问题.但所得到的特征矩阵和字典不是在全局最优下求得,因此当人数较多时,识别效果会变差.

1.2 相关工作分析本文的工作是基于图像集的.上述的每种方法都有自己的优势,适用于不同的场合,Hadid等人[27]曾指出,从同一段视频中获取的人脸图像会位于一个光顺(smooth)的流形中.因此,非线性流形的方法适用于基于图像集的视频人脸识别.在现有的基于MMD的非线性流形方法中,其投影策略是每个图像集对应一个非线性流形,其中的每幅图像对应流形中的一个点.受困于角度偏差和不充足采样,而且包括上述的其他方法在内,MMD方法在对来自现实不受控环境中的视频片段(YTC库[28])识别的效果还有非常大的提升空间.那么,如果不采用这种投影策略呢?

Lu等人[29]曾用分片投影构造非线性流形的方法(discriminative multi-manifold analysis,简称DMMA)处理过单人脸识别问题,先将单人脸图像分成若干个互不重叠的子片(patch),再投影到低维流形空间,每张图像对应一个流形,每个子片对应流形中的一个点,取得了较好的识别效果.这说明利用分片思想将单个人脸图像投影成非线性流形是合理的,若将其用于基于图像集的人脸识别,首先可以避免角度偏差和不充足采样现象,后面的实验还将表明,尤其适用于来自不受控环境的视频和不充足采样识别.实施这种思想之前,我们先考虑两种关系:图像集与图像集之间以及图像集内部各个图像之间的关系.Cui等人[24]提出的类级和原子级稀疏给了本文工作一个很好的启发,我们提出两种流形:一种是把每个图像集看成一个集成体,各自形成一个流形,集成的形式是各自的平均脸(mean face),提取整体判别信息处理图像集之间的关系,称为类间流形(Inter-class manifold);另一种是兼顾图像集内部各个图像之间关系的类内流形(Intra-class manifold),仍是一个图像集对应一个流形,但却是直接利用每个原始图像的判别信息,由所有原始图像共同构成.给定疑问集后,先利用类间流形经过较少的计算找出与疑问集最相似的几个画廊集(称为候选图像集),再利用类内流形从几个候选图像集中找出最相似的一个,然后用分片的方式获取这两种流形.投影的指导思想与DMMA类似,即,来自同一张脸的子片尽可能地近,来自不同脸的尽量离得远.每个画廊集都有明确的类间和类内投影矩阵,在测试阶段,不必再重复计算.我们把新方法称为判别性联合多流形分析(discriminative joint multi-manifold analysis,简称DJMMA),实验结果表明,新方法在几个公开研究的视频库中,比现有的方法具有更高的识别正确率.

1.3 新方法的贡献• 每个分片都被投影成流形中的一个点,而且与来自不同图像的点彼此远离,充分利用了分片的几何信息,所学的局部特征强调了人脸的个性(person-specific)、抓住人脸的本质特性,这种特性不受分辨率、光照、姿态和年龄变化的影响,比其他方法中所学的通用特征更具有判别性[29, 30].

• 在类间流形阶段,仅仅依靠平均脸就可以找到与测试目标最为相似的几个候选集,此时,如果正确率足够高的话则可以省略类内流形阶段.事实上,平均脸阶段在大多数数据集上都表现良好,而类内流形则为我们提供了更高的精度保障.

• 由于在类间流形阶段每个图像集都被转换为一个平均脸,所以是将基于图像集的人脸识别问题转换成了单脸识别,即,DJMMA可以直接用于单脸识别.

• 新方法更适用于来自现实生活的视频识别,而且在视频过短时仍有很高的识别率.

本文第2节介绍DJMMA的基本思想、函数模型和优化细节.第3节是实验结果和分析.第4节是总结.

2 判别性联合多流形分析首先给出方法概述,然后给出数学公式、优化过程和相关实验,第2.3节是识别过程介绍,最后是算法分析.

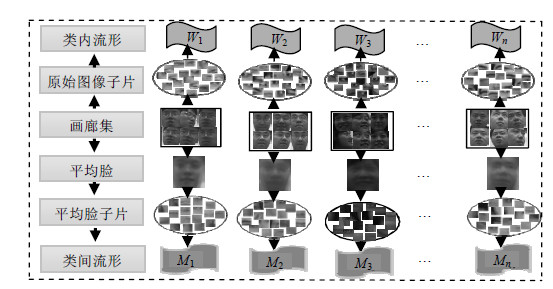

2.1 基本思想图 1显示了DJMMA的训练阶段,分成类间流形和类内流形两部分(Mi是类间流形,Wi是类内流形,i=1, 2,…,n,n是参与训练的人数).在类间流形部分,首先为每个画廊集计算平均脸,用相同的方式,以相同的尺寸将每个平均脸分成互不重合的若干个子片,然后将这些子片投影到同一个流形中,每个平均脸对应一个流形;在类内流形部分,每个画廊集的所有原始图像按照平均脸的方式分片,然后将其投影到同一个流形中,每个画廊集对应一个流形.

| Fig. 1 Training stage of DJMMA图 1 DJMMA的训练阶段 |

图 2显示了新方法的测试阶段(M2和Mn对应两个候选集,再通过W2和Wn找出与疑问集距离最近的一个):给定疑问集后,首先计算平均脸将之分片,然后将子片分别投影到各个已经计算好的画廊集流形上,计算投影后的疑问集与各个画廊集流形之间的距离,选出若干个最为相近的图像集,如图 3中的M2对应的Set 2和Mn对应的Set n.然后,将疑问集的各个原始图像的所有子片投影到所选出的候选集所对应的类内流形上,计算它们之间的距离,距离最近的即为识别结果.

| Fig. 2 Testing stage of DJMMA图 2 DJMMA的测试阶段 |

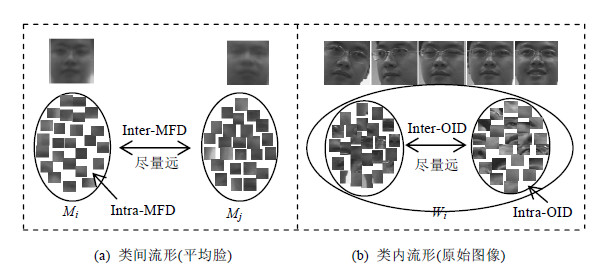

| Fig. 3 Desired distribution in low dimensional feature space图 3 子片在投影到低维空间后的理想分布 |

ki表示第i个画廊集所包含的原始图像个数,i=1,2,…n,n是画廊集总数.每个平均脸和原始图像都被分成t个子片,每个子片的尺寸是a×b(像素).令d=a×b,1≤i≤n,1≤r≤t,M=[M1,M2,...,Mn]表示n个画廊集的平均脸,Mi=[mi1,mi2,...,mit],mir是第i个平均脸的第r个子片,mir∈Rd;令$[{{X}_{i1}},{{X}_{i2}},...,{{X}_{i{{k}_{i}}}}]$表示第i个画廊集所包含的原始图像,Xis=[xis1,xis2,…,xist],1≤s≤ki,xisr是Seti的第s个原始图像的第r个子片.当i≠j并且p≠q时,称mir,mjr,xupr和xvqr为同位置子片,表示不同图像上的第r个子片,即,不同图像的同一处器官,每个子片在另一幅图像上只有一个同位置子片.用M1,M2,...,Mn表示类间流形的投影矩阵,统称M族矩阵(M_family);用W1,W2,...,Wn表示类内流形的投影矩阵,统称W族矩阵(W_family).其中,${{M}_{i}}\in {{R}^{d\times {{d}_{i}}}},{{W}_{i}}\in {{R}^{d\times {{d}_{i}}}}\text{,}$di表示每个子片在低维空间的维数,我们的目标是学习这两种矩阵.本文余下部分所用符号都与本节中的定义相一致.

2.2.2 目标函数DJMMA想要获取的是这样的一个低维特征空间:同一幅图像的子片在低维空间中尽量离得近,不同图像的子片尽量离得远.为了达到这样一个目标,根据最大化类间距离最小化类内距离的原则,所建的目标函数包含以下4个部分:(1) 来自不同平均脸的同位置子片之间的距离,称为Inter-Mean Face Distance(Inter- MFD);(2) 来自同一图像集但不同原始图像的同位置子片之间的距离,称为Inter-Original Image Distance(Inter- OID);(3) 来自同一平均脸的不同子片之间的距离,称为Intra-Mean Face Distance(Intra-MFD);(4) 来自同一原始图像的不同子片之间的距离,称为Intra-Original Image Distance(Intra-OID).投影原则如图 3所示(Inter-MFD, Inter-OID尽量大,Intra-MFD和Intra-OID尽量小.Mi和Mj分别是两个平均脸对应的类间流形,Wi是某图像集所对应的类内 流形).

我们通过最大化Inter-MFD和Inter-OID并且最小化Intra-MFD和Intra-OID来获取投影矩阵,所以目标函数定义如下:

| $\begin{align} & \underset{{{M}_{1}},...,{{M}_{n}},{{W}_{1}},...,{{W}_{n}}}{\mathop{\max }}\,J({{M}_{1}},...,{{M}_{n}},{{W}_{1}},...,{{W}_{n}})={{J}_{1}}({{M}_{1}},...,{{M}_{n}},{{W}_{1}},...,{{W}_{n}}) \\ & -{{J}_{2}}({{M}_{1}},...,{{M}_{n}},{{W}_{1}},...,{{W}_{n}}) \\ & \text{ }=\sum\limits_{i=1}^{n}{\left( \sum\limits_{r=1}^{t}{\sum\limits_{j\ne i}^{1:n}{||M_{i}^{T}{{m}_{ir}}-M_{i}^{T}{{m}_{jr}}|{{|}^{2}}{{A}_{ijr}}}}+\sum\limits_{s=1}^{{{k}_{i}}}{\sum\limits_{r=1}^{t}{\sum\limits_{j\ne s}^{1:{{k}_{i}}}{||W_{i}^{T}{{x}_{isr}}-W_{i}^{T}{{x}_{ijr}}|{{|}^{2}}{{B}_{isjr}}}}} \right)}- \\ & \text{ }\sum\limits_{i=1}^{n}{\left( \sum\limits_{r=1}^{t}{\sum\limits_{q\ne r}^{1:t}{||M_{i}^{T}{{m}_{ir}}-M_{i}^{T}{{m}_{iq}}|{{|}^{2}}{{C}_{irq}}}}+\sum\limits_{s=1}^{{{k}_{i}}}{\sum\limits_{r=1}^{t}{\sum\limits_{q\ne r}^{1:t}{||W_{i}^{T}{{x}_{isr}}-W_{i}^{T}{{x}_{isq}}|{{|}^{2}}{{D}_{isrq}}}}} \right)} \\ \end{align}$ | (1) |

• J1的前一项表示若mir和mjr是来自不同平均脸同位置子片,则它们在低维空间应该尽量离得远;后一项表示如果xisr和xijr是来自同一图像集的不同原始图像的同位置子片,则它们在低维空间中尽量分开.

• J2的前一项表示若mir和mjq来自同一平均脸,则它们在低维空间应该尽量离得近;后一项表示如果xisr和xisq是来自同一图像集的同一原始图像,则它们在低维空间中应该尽量离得近.

• Aijr,Bisjr,Cirq和Disrq是亲合矩阵,表示的是不同图像中同位置子片之间、同一图像中所有不同子片之间的相似性,来自不同图像的语义上属于同一器官的子片相似性高,但在低维空间上却需要最大化它们之间的距离;反之亦然.公式定义如下:

${{A}_{ijr}}=exp(-||{{m}_{ir}}-{{m}_{jr}}|{{|}^{2}}/{{s}^{2}}),$表示不同平均脸中同位置子片间的相似性;

${{A}_{ijr}}=exp(-||{{m}_{ir}}-{{m}_{jr}}|{{|}^{2}}/{{s}^{2}}),$表示不同平均脸中同位置子片间的相似性;

${{B}_{isjr}}=exp(-||{{x}_{isr}}-{{x}_{ijr}}|{{|}^{2}}/{{s}^{2}}),$表示同一图像集的不同原始图像的同位置子片间的相似性;

${{B}_{isjr}}=exp(-||{{x}_{isr}}-{{x}_{ijr}}|{{|}^{2}}/{{s}^{2}}),$表示同一图像集的不同原始图像的同位置子片间的相似性;

${{C}_{irq}}=exp(-||{{m}_{ir}}-{{m}_{iq}}|{{|}^{2}}/{{s}^{2}}),$表示同一平均脸中不同分片间的相似性;

${{C}_{irq}}=exp(-||{{m}_{ir}}-{{m}_{iq}}|{{|}^{2}}/{{s}^{2}}),$表示同一平均脸中不同分片间的相似性;

${{D}_{isrq}}=exp(-||{{x}_{isr}}-{{x}_{isq}}|{{|}^{2}}/{{s}^{2}}),$表示同一原始图像中不同分片间的相似性.

${{D}_{isrq}}=exp(-||{{x}_{isr}}-{{x}_{isq}}|{{|}^{2}}/{{s}^{2}}),$表示同一原始图像中不同分片间的相似性.

仅有一个参数需要设定,通常令σ=100.下一节将优化M_family和W_family.

2.2.3 优化我们将分别优化M_family和W_family.当优化M1,M2,...,Mn时,W_family成为不影响优化结果的常量,公式(1)可写成如下形式:

| $\begin{align} & \underset{{{M}_{1}},...,{{M}_{n}}}{\mathop{\max }}\,{{J}_{1}}({{M}_{1}},...,{{M}_{n}})=\sum\limits_{i=1}^{n}{\sum\limits_{r=1}^{t}{\sum\limits_{j\ne i}^{1:n}{||M_{i}^{T}{{m}_{ir}}-M_{i}^{T}{{m}_{jr}}|{{|}^{2}}{{A}_{ijr}}}}}- \\ & \sum\limits_{i=1}^{n}{\sum\limits_{r=1}^{t}{\sum\limits_{q\ne r}^{1:t}{||M_{i}^{T}{{m}_{ir}}-M_{i}^{T}{{m}_{iq}}|{{|}^{2}}{{C}_{irq}}}}} \\ \end{align}$ | (2) |

从上式中我们可以获取类间流形,它保证了所有来自不同平均脸的子片在低维空间中远远分开,而来自同一平均脸的则聚在一起.同理,当优化W1,W2,...,Wn时,M_family成为常量,公式(1)可写成如下形式:

| $\underset{{{W}_{1}},...,{{W}_{n}}}{\mathop{\max }}\,J({{W}_{1}},...,{{W}_{n}})=\sum\limits_{i=1}^{n}{\left( \begin{align} & \sum\limits_{s=1}^{{{k}_{i}}}{\sum\limits_{r=1}^{t}{\sum\limits_{j\ne s}^{1:{{k}_{i}}}{||W_{i}^{T}{{x}_{isr}}-W_{i}^{T}{{x}_{ijr}}|{{|}^{2}}{{B}_{isjr}}}}} \\ & -\sum\limits_{s=1}^{{{k}_{i}}}{\sum\limits_{r=1}^{t}{\sum\limits_{q\ne r}^{1:t}{||W_{i}^{T}{{x}_{isr}}-W_{i}^{T}{{x}_{isq}}|{{|}^{2}}{{D}_{isrq}}}}} \\ \end{align} \right)}$ | (3) |

公式(3)确定的是类内流形,参与运算的是来自每个图像集的所有原始图像的子片.公式中的第1项保证了同一图像集中来自不同原始图像的子片在低维空间中被分开,第2项则来自相同图像的则聚在一起,所有子片共同构成该图像集的低维流形.

显然,公式(2)和公式(3)都没有封闭的解,和DMMA一样,我们将采用迭代的方法来解这两个公式.首先为所有的Mi和Wi赋一个合理的初始解,1≤i≤n,本文采用单位阵,然后依次求解Mj和Wj,j≠i.细节如下:

当给定M1,M2,...,Mi-1,Mi+1,...,Mn时,Mi可以这样解得:

| $\begin{align} & \underset{{{M}_{i}}}{\mathop{\max }}\,{{J}_{1}}({{M}_{i}})=\left( \sum\limits_{r=1}^{t}{\sum\limits_{j\ne i}^{1:n}{||M_{i}^{T}{{m}_{ir}}-M_{i}^{T}{{m}_{jr}}|{{|}^{2}}{{A}_{ijr}}}}+{{F}_{1}} \right) \\ & -\left( \sum\limits_{r=1}^{t}{\sum\limits_{q\ne r}^{1:t}{||M_{i}^{T}{{m}_{ir}}-M_{i}^{T}{{m}_{iq}}|{{|}^{2}}{{C}_{irq}}}}+{{F}_{2}} \right) \\ \end{align}$ | (4) |

${{F}_{1}}=\sum\limits_{u\ne i}^{1:n}{\sum\limits_{r=1}^{t}{\sum\limits_{j\ne u}^{1:n}{||M_{u}^{T}{{m}_{ur}}-M_{u}^{T}{{m}_{jr}}|{{|}^{2}}{{A}_{ujr}}}}},{{F}_{2}}=\sum\limits_{u\ne i}^{1:n}{\sum\limits_{r=1}^{t}{\sum\limits_{q\ne r}^{1:t}{||M_{u}^{T}{{m}_{ur}}-M_{u}^{T}{{m}_{uq}}|{{|}^{2}}{{C}_{urq}}}}}\text{.}$

F1和F2是与Mi无关的常量,所以可以被忽略.这样,公式(4)变为

| $\begin{align} & \underset{{{M}_{i}}}{\mathop{\max }}\,{{J}_{1}}({{M}_{i}})\approx \sum\limits_{r=1}^{t}{\sum\limits_{j\ne i}^{1:n}{||M_{i}^{T}{{m}_{ir}}-M_{i}^{T}{{m}_{jr}}|{{|}^{2}}{{A}_{ijr}}}}-\sum\limits_{r=1}^{t}{\sum\limits_{q\ne r}^{1:t}{||M_{i}^{T}{{m}_{ir}}-M_{i}^{T}{{m}_{iq}}|{{|}^{2}}{{C}_{irq}}}} \\ & \text{ }=tr\left( M_{i}^{T}\left[ \sum\limits_{r=1}^{t}{\sum\limits_{j\ne i}^{1:n}{({{m}_{ir}}-{{m}_{jr}}){{({{m}_{ir}}-{{m}_{jr}})}^{T}}{{A}_{ijr}}}} \right]{{M}_{i}} \right)- \\ & tr\left( M_{i}^{T}\left[ \sum\limits_{r=1}^{t}{\sum\limits_{q\ne r}^{1:t}{({{m}_{ir}}-{{m}_{iq}}){{({{m}_{ir}}-{{m}_{iq}})}^{T}}{{C}_{irq}}}} \right]{{M}_{i}} \right) \\ & \text{ }=tr(M_{i}^{T}{{H}_{1}}{{M}_{i}})-tr(M_{i}^{T}{{H}_{2}}{{M}_{i}}) \\ \end{align}$ | (5) |

${{H}_{1}}=\sum\limits_{r=1}^{t}{\sum\limits_{j\ne i}^{1:n}{({{m}_{ir}}-{{m}_{jr}}){{({{m}_{ir}}-{{m}_{jr}})}^{T}}{{A}_{ijr}}}},{{H}_{2}}=\sum\limits_{r=1}^{t}{\sum\limits_{q\ne r}^{1:t}{({{m}_{ir}}-{{m}_{iq}}){{({{m}_{ir}}-{{m}_{iq}})}^{T}}{{C}_{irq}}}}.$

以同样的方式从公式(3)中优化Wi:

| $\begin{align} & \underset{{{W}_{i}}}{\mathop{\max }}\,{{J}_{2}}({{W}_{i}})=\sum\limits_{s=1}^{{{k}_{i}}}{\sum\limits_{r=1}^{t}{\sum\limits_{j\ne i}^{1:{{k}_{i}}}{||W_{i}^{T}{{x}_{isr}}-W_{i}^{T}{{x}_{ijr}}|{{|}^{2}}{{B}_{isjr}}}}}+{{F}_{3}}- \\ & \sum\limits_{s=1}^{{{k}_{i}}}{\sum\limits_{r=1}^{t}{\sum\limits_{q\ne r}^{1:t}{||W_{i}^{T}{{x}_{isr}}-W_{i}^{T}{{x}_{isq}}|{{|}^{2}}{{D}_{isrq}}}}}-{{F}_{4}} \\ & \text{ }\approx tr\left( W_{i}^{T}\left[ \sum\limits_{s=1}^{{{k}_{i}}}{\sum\limits_{r=1}^{t}{\sum\limits_{j\ne i}^{1:{{k}_{i}}}{({{x}_{isr}}-{{x}_{ijr}}){{({{x}_{isr}}-{{x}_{ijr}})}^{T}}{{B}_{isjr}}}}} \right]{{W}_{i}} \right) \\ & -tr\left( W_{i}^{T}\left[ \sum\limits_{s=1}^{{{k}_{i}}}{\sum\limits_{r=1}^{t}{\sum\limits_{q\ne s}^{1:t}{({{x}_{isr}}-{{x}_{isq}}){{({{x}_{isr}}-{{x}_{isq}})}^{T}}{{D}_{isrq}}}}} \right]{{W}_{i}} \right) \\ & \text{ }=tr(W_{i}^{T}{{H}_{3}}{{W}_{i}})-tr(W_{i}^{T}{{H}_{4}}{{W}_{i}}) \\ \end{align}$ | (6) |

${{F}_{3}}=\sum\limits_{u\ne i}^{1:n}{\sum\limits_{s=1}^{{{k}_{u}}}{\sum\limits_{r=1}^{t}{\sum\limits_{j\ne u}^{1:{{k}_{u}}}{||W_{u}^{T}{{x}_{usr}}-W_{u}^{T}{{x}_{ujr}}|{{|}^{2}}{{B}_{usjr}}}}}},{{F}_{4}}=\sum\limits_{u\ne i}^{1:n}{\sum\limits_{s=1}^{{{k}_{u}}}{\sum\limits_{r=1}^{t}{\sum\limits_{q\ne s}^{1:t}{||W_{u}^{T}{{x}_{usr}}-W_{u}^{T}{{x}_{usq}}|{{|}^{2}}{{D}_{usrq}}}}}}.$

F3和F4也是与优化无关的常量,所以被忽略,而

${{H}_{3}}=\sum\limits_{s=1}^{{{k}_{i}}}{\sum\limits_{r=1}^{t}{\sum\limits_{j\ne s}^{1:{{k}_{i}}}{({{x}_{isr}}-{{x}_{ijr}}){{({{x}_{isr}}-{{x}_{ijr}})}^{T}}{{B}_{isjr}}}}},{{H}_{4}}=\sum\limits_{s=1}^{{{k}_{i}}}{\sum\limits_{r=1}^{t}{\sum\limits_{q\ne r}^{1:t}{({{x}_{isr}}-{{x}_{isq}}){{({{x}_{isr}}-{{x}_{isq}})}^{T}}{{D}_{isrq}}}}}.$

最后,通过解下面的两个特征值等式分别得到Mi和Wi:

| $({{H}_{1}}-{{H}_{2}})\omega =\lambda \omega $ | (7) |

| $({{H}_{3}}-{{H}_{4}})\xi =\gamma \xi $ | (8) |

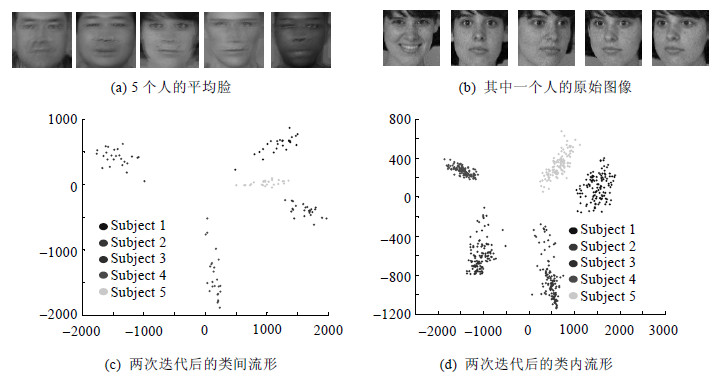

获取投影矩阵后,即可构建类间和类内流形.图 4是两种流形的可视化结果,数据集取自FERET库[31].图 4(a)显示的是尺寸为80ξ80的平均脸图像,每张图像被分成25块互不重叠的尺寸为16×16的子片.每个平均脸对应某个画廊集中的6幅原始图像,如图 4(b)中所示subject 1,所有原始图像也都与平均脸相同的方式分片.从图 4(c)和图 4(d)我们可以看出,人与人之间的类间和类内流形都被清楚地分开.

| Fig. 4 Manifolds of five subjects图 4 5个人的低维流形 |

最大化Inter_MFD,Inter_OID和最小化Intra_MFD,Intra_OID的目的是为了使流形之间的边距(margin)尽可能地大,这样,人与人之间在低维空间中才能被很好地分开.在优化过程中,我们将每个投影矩阵分开优化,这意味着不可能获得全局最优解,当画廊集过多时,识别效果可能会变差.如果我们在优化过程中像DMMA那样将每个子片的k近邻加入到运算中,那么新方法将饱尝非全局最优解的短处.因为不管选取多少个近邻,总会有一些图像集不会参与到运算中,那么有些流形之间的边界就不会很清晰.为了克服非全局最优的缺点,新方法中所有图像集的所有同位置子片都被包含在每个投影矩阵的优化计算中,确保了当人数众多时,识别效果也不会变差.同位置子片的设计,使得新方法不必在所有画廊集范围内进行大规模搜索,因此每次迭代的算法复杂度是O(n),而DMMA则是O(n2),n是参与训练的人数.

2.3 识别阶段第1步:利用类间流形来选取与疑问集最为相近的几个候选图像集.将计算所有画廊集的平均脸,所以宜采用相对简单、快速而又保持较高的识别正确率的度量算法.同时,每个子片在显示平均脸的特征时都很重要,为避免信息丢失,必须所有的子片都参与计算,因此,现有的MMD[14, 15, 32]方法不适用于本文,因为它们都是选取一部分采样来计算,本文将采用余弦距离(cosine distance)[33]来度量两个流形的相似度,进而选出候选图像集.

将疑问集的平均脸按照训练阶段的方法分片:

• 令Mtest=[m1,m2,...,mt]表示所得的子片集;

• 令${{M}_{gset}}=[M_{i}^{T}{{m}_{i1}},M_{i}^{T}{{m}_{i2}},...,M_{i}^{T}{{m}_{it}}]$表示第i个画廊集的平均脸在类间流形上的表示.

先将Mtest投影第i个流形上,记为$Te\_m=[M_{i}^{T}{{m}_{1}},M_{i}^{T}{{m}_{2}},...,M_{i}^{T}{{m}_{t}}]$;然后,分别把Mgset和Te_m转换为向量, 记为 ${{M}_{gset}}(:)\in {{R}^{t\times {{d}_{i}}}},Te\_m(:)\in {{R}^{t\times {{d}_{i}}}},$ 则疑问集和第i个画廊集在低维空间上的距离为cos(Mgset(:),Te_m(:)).找出最近的几个,设为K个.

第2步:利用类内流形,从上一步的K个候选图像集中找出最近的一个.先将疑问集的所有原始图像按训练阶段分片,再将这些分片投影到选出的K个类内流形上,分别计算它们在低维流形上的距离,即可找到最近的一个.本阶段主要考虑识别精度,不必再把运算速度考虑在内.DMMA提出了一种基于重建的度量算法,每个疑问子片投影到某个画廊集对应的低维空间后,在该图像集的所有子片中搜索它在低维空间中的若干个近邻,再由这些近邻重建它,所有子片的重建误差即为这两个图像集之间的距离.我们也采用重建的方法,但不会寻找近邻,原因有二:一是几近邻合适?二是如何确定哪种找近邻的方法在低维流形中是好的,是马氏距离还是欧氏距离?在高维空间中,若在所有子片范围内用这两种距离度量为某个子片寻找近邻,则很可能会使脸颊与下巴相近,我们不能确定在低维空间中不发生这样的情况.本文的方法是:每个疑问子片在每个候选图像集中都有该图像集所包含的所有原始图像上的同位置子片,若脸的角度相同,它们就是同一器官,投影到某个候选类内流形上之后,该疑问子片就可以由这些同位置子片在低维空间中重建,所有疑问子片的重建误差即为两图像集之间的距离.为防止因脸的角度不同而影响距离计算,可先在高维空间中算出疑问子片与其所有同位置子片之间的欧式距离,去掉其中若干个距离最大的,由剩下的同位置子片在低维空间中重建它.根据实验结果我们发现:当角度变化很大时,去掉总数的1/3个效果最好.重建细节具体如下:

令Y表示疑问集,Yl=[yl1,yl2,…,ylt]表示其中的第l幅图像,共ktest幅,ylr是第l幅图像的第r个子片.设要与Y度量距离的是第i个画廊集,令k'=2/3ki(ki与第2.2.2节相同,表示第i个画廊集所包含的原始图像个数),设ysr在该图像集上的欧式距离较小的k'个同位置子片为xi1r,xi2r,…,xik'r,投影到第i个类内流形上以后,它们分别被表示为$y{{T}_{lr}}=W_{i}^{T}{{y}_{lr}}$和$x{{T}_{lr}}=[W_{i}^{T}{{x}_{i1r}},W_{i}^{T}{{x}_{i2r}},...,W_{i}^{T}{{x}_{i{k}'r}}]\text{.}$

令$d(y{{T}_{lr}},x{{T}_{lr}})=\min {{\left\| y{{T}_{lr}}-\sum\limits_{s=1}^{{{k}'}}{{{c}_{s}}W_{i}^{T}{{x}_{isr}}} \right\|}^{2}}\text{,}$其中,cs是重建系数且$\sum\limits_{s=1}^{{{k}'}}{{{c}_{s}}}=1\text{,}$解法略.

求出重建系数后,为与类间流形中所计算的距离相统一,我们用各同位置子片的线性组合与疑问子片之间的余弦距离作为该子片的重建精度,流形的距离最终可以表示为所有子片的重建精度均值.

3 实验既然新方法可以通过处理平均脸把基于图像集的视频人脸识别转换成单人脸识别,而且分片思想来自于DMMA,那么我们有理由首先把DJMMA的平均脸阶段与DMMA相比较,然后再就基于图像集的人脸识别把新方法与现有方法相比较,所以整个实验包括两部分:一是单人脸识别,二是基于图像集识别.

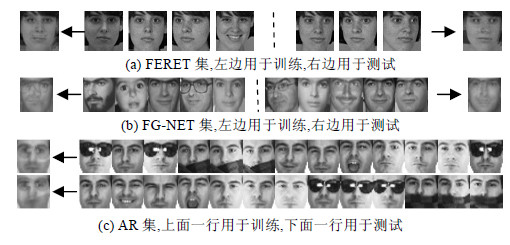

3.1 单人脸识别此处的单人脸指的是每个画廊集的平均脸.跟大多数单人脸识别方法做实验时一样,我们也用FERET[34], FG-NET[31]和AR[35]这3个数据集.

FERET数据集一共包含1 565个不同种族、性别和年龄的人的共13 539幅图像.我们使用其中的一个子集,包含200个人的1 400幅图像,每人7幅,包括正面、小角度侧面和不同光照几种情况.选取其中4幅的平均脸用来训练,剩下3幅的平均脸用来测试.所有图像被重定义为80×80的灰度图,具体如图 5(a)所示.

| Fig. 5 Sample face images from three databases图 5 3个数据集中的样例,箭头所指的是平均脸 |

FG-NET数据集一共包含82个人的1 002幅图像,每幅图在光照、姿态、表情上都有较大的变化,年龄从0到69岁,平均每人12幅左右.我们为每个人建2个子集:一个的平均脸用来训练,另一个的平均脸用来测试.每个子集包含5幅图像,覆盖不同的年龄段,若总图像不足10幅则先满足测试集.所有图像被重定义为60×60的灰度图,具体如图 5(b)所示.

AR库共包含126个人的4 000幅彩色图像,每人26幅,共分成2个组,每组每人13幅.我们把其中一个组的每人13幅的平均脸用来训练,另一组的用来测试.所有图像被重定义为60×60的灰度图,具体如图 5(c)所示.

FERET的每幅平均脸都被分成25个16×16的子片,FG-NET和AR库的每幅平均脸被分成12×12的子片.DMMA的参数取值与原文献一致,DJMMA的di,即第2.2.1节定义的低维流形的维数,在AR和FG-NET库上第1次迭代是20,第2次是6,在FERET库上两次迭代分别是30和10.两种方法的识别正确率见表 2.

| Table 2 Recognition accuracy (%) of two different methods 表 2 两种方法识别正确率(%)对比 |

从表 2中可以看出,两种方法的共同点是FERET库识别率最高,AR次之,FG-NET最低.这是因为FERET库中姿态和光照变化较少,且无遮挡无年龄变化;而AR库有遮挡,FG-NET年龄变化大.同时也可以看出,在每个库中,DJMMA比DMMA的正确率至少要高8%,并且训练集成员越多,正确率的差距就越大.本实验的测试阶段, DJMMA用的是余弦距离,精度会低于DMMA的基于重建的方法,所以测试阶段并没有为新方法的高识别率做出贡献.但在训练阶段,两方法的思想又相同,唯一的不同之处就在于参与运算的子片数:DMMA用的是所有图像全体子片中的若干近邻,而DJMMA用的是同位置子片,因此可以看出,是最近邻的找法与数目降低了DMMA的识别率.

3.2 基于图像集的人脸识别我们将在3个广为研究的公开库上进行实验对比,它们分别是Honda/UCSD[36],CMU MoBo[37]和YouTube Celebrities(YTC)[28].在对3个库进行简短的介绍后,先用数据详细描述DJMMA的工作细节,再与其他方法进行对比.

3.2.1 数据集Cui等人已经在文献[24]中详细介绍了这3个视频集.我们采用Nilsson等人[38]的方法(包括源代码)检测视频中每个帧的人脸,然后将Honda库中的人脸图像变成80ξ80,将MoBo库中的变成40ξ40,将YTC库中的变为50ξ50的灰度图,除此以外,未对图像做任何预处理.不做预处理和保留较高分辨率的目的是为了尽量多地保留图像的原始特征,它将为DJMMA和其他方法的对比带来挑战.

对于所有数据集,我们都采用与Cui等人[24]相同的方式进行训练和测试配置:在Honda和MoBo库中,选取每个人的一个序列用做训练,剩下的用做测试;在YTC库中,每个人有3个组平均41个视频序列,从每个人的每个组里各选1个用做训练,各选6个用做测试.为了提高识别的可信度,所有的实验都被重复5次,每次都有机选训练集和测试集,平均起来即为最终识别率.

为了更好地描述所有方法的工作效果,每个图像集中随机选来用做训练的图像数目会有所变化:在第3.2.2节中,每个图像集分别包含30,50,100,200和300幅图像;在第3.2.3节中,每个图像集分别包含30,100和300幅图像;疑问集中的图像数目在第3.2.2节中分别是2和20,在第3.2.3节则与画廊集中图像的数目相同.如果一个图像集中所含的图像数未达到指定值,则默认为该集中的所有图像.图像集中小数目的图像参与训练或测试是有很大的实用价值的,因为生活中所获取的视频段往往总是不够长.

3.2.2 DJMMA的工作细节本节中,我们将分别分析DJMMA的类间和类内的识别精度,尤其侧重于不充足采样实验,即,待识别视频段不够长的情况.Honda库中的每个图像被分成25个16ξ16的子片,MoBo和YTC分别被分成16和25个10×10的子片.类间流形阶段找出的候选图像集数目是5,di在Honda库中两次迭代的取值分别为30和10;在MoBo和YTC库中两次迭代分别取20和6.图 6和表 3从细节上显示了当画廊集中图像数为30、疑问集中图像数为2时,DJMMA在Honda库上的工作过程.

| Fig. 6 Example of 30 trainings for Honda. There are 20 sets in the database and 30 images in each set图 6 Honda库中的人脸示例,每个Set 30幅图像,共20个Set |

| Table 3 Distance between query set and its relevant sets 表 3 疑问集和候选集之间的距离 |

类间流形阶段的任务是寻找5个与疑问集最相似的候选集(表 3中只列出了3个),然后由类内流形阶段从这5个中选出距离最近的一个.如表 3所示,余弦距离越大,两图像集的相似度越高;当Set 1是疑问集时,对应的画廊集Set 1却不是5个候选集中排在最前面的一个,但最终由类内流形将其正确选出.

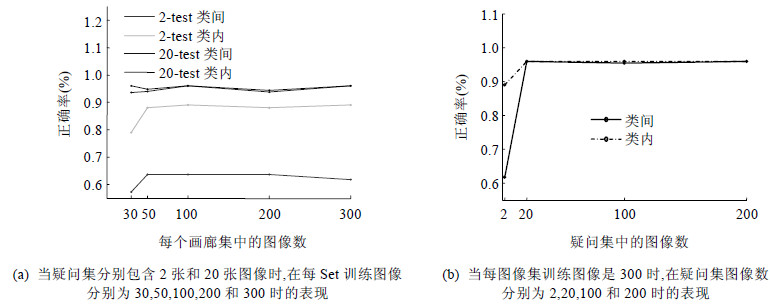

图 7显示了当每个图像集中参与训练的图像数不同时,不充足采样和充足采样的识别精度,最终精度由类内流形阶段决定.在图 7中,YTC库中的识别精度随着画廊集和疑问集中图像数目的不同而变化.类间流形阶段的精度表示正确的图像集被选入到候选集中的正确率,类内流形阶段的精度表示把正确的图像集从候选集中选出的正确率.图 7(a)中的2-test和20-test表示的是疑问集中的图像数目,2-test是严重的不充足采样,而我们在现实生活中有可能常常会遇到,此时,类间流形的精度不高,最高时仅达到65%,但类内流形的却可以高达89%,虽然仍低于20-test的,但后面的实验将显示其仍然比其他方法高出很多.图 7(a)同时还显示出:当画廊集中训练图像数达到50幅以后,2-test和20-test都将趋于稳定,保持着较高的识别率.也就是说,利用DJMMA可以仅计算疑问集中的部分图像,极大地节省了时间.在图 7(b)表示的是当画廊集中的训练图像数目不变时,精度随着疑问集中测试图像的数目的变化情况.可以看出,当测试图像数目超过20时,识别率将趋于稳定并保持较高的正确率.也就是说,如果画廊集中的训练图像数目足够大(YTC库是每图像集50幅),则不必让画廊集中的所有图像都参与识别,节省了计算时间.图 7还显示出:当每图像集中参与测试和训练的图像足够多时,类间流形的精度是令人满意的,此时,类内流形就可以省略了.MoBo库的情况将在下一节介绍.

| Fig. 7 Accuracy of Inter-class and Intra-class manifolds on YTC图 7 YTC库上类间和类内的识别精度 |

将新方法与常用方法在经典数据集上对比是衡量新方法好坏的常用手段,本文将把DJMMA与近年来常用的5个基于图像集的方法在上述3个视频库上进行对比.这5种方法分别是Mutual Subspace Method (MSM)[17],SANP[19],MMD[15],Manifold Discriminate Analysis(MDA)[32]和JSR[24].除JSR外,其他4个方法的源代码均从原作者的网站上获取.JSR的程序代码无法获得,我们遵循原文思想进行了认真编写.所有方法的重要参数均取自其原文,DJMMA的参数与第3.2.2节相同.表 4~表 6显示了所有方法在3个数据集上的识别结果,除了2-test实验以外,所有疑问集中测试图像的数目均与其画廊集中的训练图像数目相同,它们分别是30,100和300. 2-test实验中的识别精度是每个画廊集中训练图像数目分别为30,100和300时的识别精度的均值.MMD和MDA的k-NN数是1,JSR的结果是取不同的λ1和λ2时所有结果的均值,MMD的结果是Exemplar,Variation和Exemplar-ED这3种情况的均值.

| Table 4 Recognition accuracy (%) on Honda 表 4 Honda库上的识别率(%) |

| Table 5 Recognition accuracy (%) on MoBo 表 5 MoBo库上的识别率(%) |

| Table 6 Recognition accuracy (%) on YTC 表 6 YTC库上的识别率(%) |

从表 4~表 6可以看出:MSM和JSR在所有实验中表现都很平稳,MMD在Honda库中对图像集中的图像数目敏感,MDA和SANP因为光照变化的影响而在Honda库中表现得不是很令人满意.原因是做实验前我们未对图像做任何预处理,例如直方图均衡化.这5种用来对比的方法有两个共同点:一是在所有实验中,2-test的识别率都不高,在3个库中的平均识别率分别为60.7%,59%,60.4%,58.6%,68.7%;二是MoBo和YTC库中的识别率都低于Honda库,特别是YTC库,识别率均未超过65%,这是因为YTC中的视频完全来自不受控环境,本身的低分辨率和大尺度的表情、光照、姿态变化都严重影响了识别率.DJMMA却在这两个方面表现良好,2-test的识别率始终保持在85%以上,说明适用于短视频识别;新方法在3个库上的识别率相差不大,尤其在YTC库上,识别率远高于现有方法.据我们所知,目前已有方法在YTC上的识别率没有一个高于77%,而DJMMA却高达95%,这说明分片流形的思想能够更好地抓住人脸的本质特性,而这些特性不受分辨率、光照和姿态变化的影响,结合上一节在FG-NET库中的实验还可以看出:DJMMA所获取的特征还能减轻年龄对面部特征的影响,具有非常大的实用价值.另外,当每个画廊集中用来训练的图像数目超过50的时候,类间流形阶段就已达到很高的识别率,可以省略类内阶段.

4 结论平均脸的概念许多年前就已被提出并使用[39],但从未被当作关键技术应用在人脸识别中,在多数算法中只是起辅助作用.本文中首次将其与流形结合用于图像集分类,并在很多实验中取得了良好的效果.分片思想和联合多流形技术充分考虑了类内和类间距离,通过这种方式获取的特征极具判别性,进而有效地减少了误判的可能.在计算投影矩阵的过程中,所有的同位置子片都参与进去,尽可能地弥补了因分开计算而导致的不是全局最优解的不足.就识别效果而言,DJMMA更适合于现实生活应用,对光照、姿态、表情和年龄变化具有极强的鲁棒性,并且尤其适用于短视频情况,既包括用于训练的短视频也包括用于测试的短视频.

新方法仍有一些问题没有解决好,例如识别结果过于依赖类间流形阶段,如果指定的候选集的个数过小,则有可能漏掉正确图像集.这样,无论类内阶段有多么精确都无法得到正确的识别结果.但指定几个才是合适的数目,还需要进一步研究.而且,类内流形阶段也并非总能完美地工作,我们不能杜绝这种现象的发生:正确的图像集在类间阶段被选到候选集里面来了,但却在类内阶段被排除了.因此,如何进一步提高类内流形阶段的识别精度,是下一步的工作.

致谢 感谢南京大学计算机软件新技术国家重点实验室(南京大学)高阳教授课题组的所有老师和同学对本工作的帮助.| [1] | Barr JR, Bowyer KW, Flynn PJ, Biswas S. Face recognition from video: A review. Int’l Journal of Pattern Recognition and Artificial Intelligence, 2012,26(5):1-56 . |

| [2] | Liu X, Chen T. Video-Based face recognition using adaptive hidden Markov models. In: Proc. of the Int’l Conf. on Computer Vision and Pattern Recognition. Washington: IEEE Computer Society, 2003. 340-345 . |

| [3] | Kim M, Kumar S, Pavlovic V, Rowley H. Face tracking and recognition with visual constraints in real-world videos. In: Proc. of the Int’l Conf. on Computer Vision and Pattern Recognition. Anchorage: IEEE Computer Society, 2008. 1-8 . |

| [4] | Lee KC, Ho J, Yang MH, Kriegman D. Visual tracking and recognition using probabilistic appearance manifolds. Computer Vision and Image Understanding, 2005,99(3):303-331 . |

| [5] | Yan Y, Zhang YJ. State-of-the-Art on video-based face recognition. Chinese Journal of Computers, 2009,32(5):878-886 (in Chinese with English abstract) . |

| [6] | Arandjelović O, Shakhnarovich G, Fisher JW, Cipolla R, Darrell T. Face recognition with image sets using manifold density divergence. In: Proc. of the Int’l Conf. on Computer Vision and Pattern Recognition. IEEE Computer Society, 2005. 581-588 . |

| [7] | Shakhnarovich G, Fisher JW, Darrell T. Face recognition from long-term observations. In: Proc. of the 7th European Conf. on Computer Vision. Berlin, Heidelberg: Springer-Verlag, 2002. 851-865 . |

| [8] | Cevikalp H, Triggs B. Face recognition based on image sets. In: Proc. of the Int’l Conf. on Computer Vision and Pattern Recognition. San Francisco: IEEE Computer Society, 2010. 2567-2573 . |

| [9] | Huang LK, Lu JW, Tan YP, Feng X. Collaborative reconstruction-based manifold-manifold distance for face recognition with image sets. In: Proc. of the 2013 IEEE Int’l Conf. on Multimedia and Expo (ICME). San Jose: IEEE Computer Society, 2013. 1-6 . |

| [10] | Aggarwal G, Chowdhury AKR, Chellappa R. A system identification approach for video-based face recognition. In: Proc. of the 17th Int’l Conf. on Pattern Recognition. IEEE Computer Society, 2004. 175-178 . |

| [11] | Fukui K, Yamaguchi O. The kernel orthogonal mutual subspace method and its application to 3D object recognition. In: Proc. of the 8th Asian Conf. on Computer Vision. Berlin, Heidelberg: Springer-Verlag, 2007. 467-476 . |

| [12] | Kim TK, Kittler J, Cipolla R. Discriminative learning and recognition of image set classes using canonical correlations. IEEE Trans. on Pattern Analysis and Machine Intelligence, 2007,29(6):1005-1018 . |

| [13] | Sanderson MTCC, Shirazi S, Lovell BC. Graph embedding discriminant analysis on grassmannian manifolds for improved image set matching. In: Proc. of the Int’l Conf. on Computer Vision and Pattern Recognition. Providence: IEEE Computer Society, 2011. 2705-2712 . |

| [14] | Wang R, Shan S, Chen X, Chen J, Gao W. Maximal linear embedding for dimensionality reduction. IEEE Trans. on Pattern Analysis and Machine Intelligence, 2011,33(9):1776-1792 . |

| [15] | Wang R, Shan S, Chen X, Dai Q, Gao W. Manifold-Manifold distance and its application to face recognition with image sets. IEEE Trans. on Image Processing, 2012,20(10):4466-4479 . |

| [16] | Cui Z, Shan S, Zhang H, Lao S, Chen X. Image sets alignment for video-based face recognition. In: Proc. of the Int’l Conf. on Computer Vision and Pattern Recognition. Providence: IEEE Computer Society, 2012. 2626-2633 . |

| [17] | Yamaguchi O, Fukui K, Maeda K. Face recognition using temporal image sequence. In: Proc. of the IEEE Int’l Conf. on Automatic Face and Gesture Recognition (AFGR). Nara: IEEE Computer Society, 1998. 318-323 . |

| [18] | Hu Y, Mian AS, Owens R. Sparse approximated nearest points for image set classification. In: Proc. of the Int’l Conf. on Computer Vision and Pattern Recognition. Providence: IEEE Computer Society, 2011. 121-128 . |

| [19] | Kim TK, Arandjelović O, Cipolla R. Boosted manifold principal angles for image set-based recognition. Pattern Recognition, 2007, 40(9):2475-2484 . |

| [20] | Fan W, Yeung DY. Locally linear models on face appearance manifolds with application to dual-subspace based classification. In: Proc. of the Int’l Conf. on Computer Vision and Pattern Recognition. New York: IEEE Computer Society, 2006. 1384-1390 . |

| [21] | Elhamifar E, Vidal R. Robust classification using structured sparse representation. In: Proc. of the Int’l Conf. on Computer Vision and Pattern Recognition. Providence: IEEE Computer Society, 2011. 1873-1879 . |

| [22] | Chen YC, Patel VM, Shekhar S, Chellappa R, Phillips PJ. Video-Based face recognition via joint sparse representation. In: Proc. of the 10th IEEE Int’l Conf. and Workshops on Automatic Face and Gesture Recognition. Shanghai: IEEE Computer Society, 2013. 1-8 . |

| [23] | Chen SK, Sanderson C, Harandi MT, Lovell BC. Improved image set classification via joint sparse approximated nearest subspaces. In: Proc. of the Int’l Conf. on Computer Vision and Pattern Recognition. Portland: IEEE Computer Society, 2013. 452-459 . |

| [24] | Cui Z, Chang H, Shan S, Ma B, Chen X. Joint sparse representation for video-based face recognition. Neurocomputing, 2014,135: 306-312 . |

| [25] | Bhatt HS, Singh R, Vatsa M. On recognizing faces in videos using clustering-based re-ranking and fusion. IEEE Trans. on Information Forensics and Securit, 2014,9(7):1056-1068 . |

| [26] | Patel VM, Chen YC, Chellappa R, Phillips PJ. Dictionaries for image and video-based face recognition. Journal of the Optical Society of America A, 2014,31(5):1090-1103 . |

| [27] | Hadid A, Pietikäinen M. From still image to video-based face recognition: An experimental analysis. In: Proc. of the 6th IEEE Int’l Conf. on Automatic Face and Gesture Recognition. EEE Computer Society, 2004. 813-818 . |

| [28] | Kim M, Kumar S, Pavlovic V, Rowley H. Face tracking and recognition with visual constraints in real-world videos. In: Proc. of the Int’l Conf. on Computer Vision and Pattern Recognition. Anchorage: IEEE Computer Society, 2008. 1-8 . |

| [29] | Lu JW, Tan YP, Wang G. Discriminative multimanifold analysis for face recognition from a single training sample per person. IEEE Trans. on Pattern Analysis and Machine Intelligence, 2013,35(1):39-51 . |

| [30] | Yao B, Ai H, Lao S. Person-Specific face recognition in unconstrained environments: A combination of offline and online learning. In: Proc. of the 11th IEEE Int’l Conf. on Automatic Face and Gesture Recognition. EEEE Computer Society, 2009. 1-8 . |

| [31] | Lanitis A. Evaluating the performance of face-aging algorithms. In: Proc. of the 10th IEEE Int’l Conf. on Automatic Face and Gesture Recognition. Amsterdam: IEEE Computer Society, 2008. 1-6 . |

| [32] | Wang R, Chen X. Manifold discriminant analysis. In: Proc. of the Int’l Conf. on Computer Vision and Pattern Recognition. Miami: IEEE Computer Society, 2009. 429-436 . |

| [33] | Tan PN, Steinbach M, Kumar V. Introduction to Data Mining. Addison-Wesley, 2005. 500-500. |

| [34] | Phillips PJ, Rizvi SA, Rauss PJ. The FERET evaluation methodology for face-recognition algorithms. IEEE Trans. on Pattern Analysis and Machine Intelligence, 2000,22(10):1090-1104 . |

| [35] | Martinez AM, Benavente R. The AR face database. Technical Report, #24, Barcelona: Computer Vision Center (CVC), Universitat Autònoma de Barcelona, 1998. |

| [36] | Lee K, Ho J, Yang M, Kriegman D. Video-Based face recognition using probabilistic appearance manifolds. In: Proc. of the Int’l Conf. on Computer Vision and Pattern Recognition. Washington: IEEE Computer Society, 2003. 1-8 . |

| [37] | Gross R, Shi J. The CMU motion of body (MoBo) database. Technical Report, CMU-RI-TR-01-18, Robotics Institute, Carnegie Mellon University, 2001. |

| [38] | Nilsson M, Nordberg J, Claesson I. Face detection using local SMQT features and split up SNOW classifier. In: Proc. of the IEEE Int’l Conf. on Acoustics, Speech, and Signal Processing (ICASSP). Honolulu: IEEE Computer Society, 2007. 589-592 . |

| [39] | Sirovich L, Kirby M. Low-Dimensional procedure for the characterization of human faces. Journal of the Optical Society of America A, 1987,4(5):519-525 . |

| [5] | 严严,章毓晋.基于视频的人脸识别研究进展.计算机学报,2009,32(5):878-886 . |

2015, Vol. 26

2015, Vol. 26