2. 国家数字家庭工程技术中心, 广东 广州 510006;

3. 中山大学 信息科学与技术学院, 广东 广州 510006;

4. 华南家禽疫病防控与产品安全协同创新中心, 广东 广州 510640

2. National Engineering Research Center of Digital Life, Guangzhou 510006, China;

3. School of Information Science and Technology, Sun Yat-Sen University, Guangzhou 510006, China;

4. South China Collaborative Innovation Center for Poultry Disease Control and Product Safety, Guangzhou 510640, China

目标跟踪是计算机视觉领域的研究热点之一, 它在视频监控、普适计算、智能人机交互等领域具有广泛的应用.近年来, 大量目标跟踪方法已被提出, 但由于受光照、非刚性变化、同类物体干扰、遮挡等因素的影响, 稳定且准确的目标跟踪方法仍是极具挑战性的研究课题[1, 2].大量研究证明, 建立自适应表观模型, 是实现目标跟踪的关键[3, 4, 5, 6, 7, 8, 9, 10, 11].本文根据中层视觉线索超像素构建部件级表观模型, 建立部件库特征补集以增强表观模型更新的自适应性和健壮性, 提出相似物体干扰的检测和处理算法以避免漂移.与现有方法相比, 本文方法可更准确、稳定地跟踪复杂环境下的目标.

1 相关工作构建强健有效的表观模型, 是目标跟踪算法的核心和关键.根据建模方法, 当前目标跟踪方法可分为基于像素级的方法、基于整体模板级的方法和基于局部信息级的方法.

· 基于像素级的跟踪方法[3, 4]根据目标区域的像素信息构建和更新表观模型.例如:Avidan等人[3]在像素级上利用AdaBoost算法建立和更新强分类器以识别目标;施华等人[4]提出一种基于像素可信度和空间位置的跟踪方法, 通过Kalman滤波在时域上的中值背景模型与空间域的交叉熵检测运动目标.尽管该类方法能够初步区分目标和背景, 但它们在处理严重遮挡和复杂背景的跟踪时很不理想;

· 基于整体模板级的跟踪方法[6, 7]根据目标区域建立描述物体的正/负模板, 以模板为整体构建和更新物体的表观模型.例如:Babenko等人[6]通过学习正样本和负样本模板构建判别式模型进行目标跟踪;Mei等人[7]利用大量模板构造表观模型, 把目标跟踪看作粒子滤波框架的稀疏逼近问题.该类方法极大地减少了复杂背景和遮挡时的跟踪漂移, 但不能有效处理非刚性变化和同类物体干扰下的目标跟踪;

· 基于局部信息级的跟踪方法[8, 10]通过记录和分析目标的局部变化建立和更新表观模型, 其中, Kwon等人[8]利用若干随机局部子块构建表观模型, 通过增加和删除子块处理遮挡和非刚性;Wang等人[10]基于超像素建立表观模型对目标进行跟踪, 在遮挡、姿态变化和快速运动方面比较有效.该类方法能够灵活地表达视频序列中动态变化的目标和背景, 近年来引起了人们的广泛关注.

本文提出一种新的基于局部信息级表观模型的跟踪方法, 该方法通过学习、分类和更新物体的部件级信息构建和更新表观模型:首先对图像帧进行超像素分割, 以超像素描述物体部件;然后, 利用部件信息构造物体特征库以建立和更新目标的表观模型;最后, 建立基于最大后验概率和同类物体检测策略以计算目标位置.本文方法的优势在于:

(1)与当前主流方法相比, 本文方法能够更准确地跟踪复杂背景、光照变化、剧烈变形以及严重遮挡时的目标;

(2)与Wang等人[10]同样基于超像素建模的方法相比, 本文通过建立目标部件的特征补集和进行同类物体分析, 能够更实时、有效地反映动态变化的目标和背景, 从而更有效地处理非刚性变化和同类物体遮挡下的跟踪.

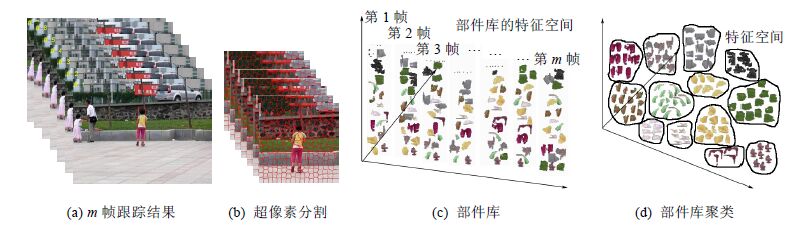

2 系统框架本文根据物体的局部信息建立和更新目标的表观模型, 通过物体部件描述其局部信息, 提出一种基于部件级的跟踪方法.为了有效计算物体部件, 采用超像素集表示物体部件.超像素由于具有丰富的图像结构信息和明显的目标边界, 比高层整体模型和低层视觉特征具有更出色的灵活性和自适应性, 是一种有效的特征表达方式, 已在物体的分割、分类、表示等领域表现出色[12, 13, 14, 15, 16].本文算法的流程如图1所示, 包含初始阶段、目标跟踪阶段和更新阶段.

|

图1 本文目标跟踪算法的流程图 Fig.1 Flowchart of the tracking method |

· 初始阶段:建立基于目标物体部件库的表观模型.首先, 简单跟踪前m帧图像(如m=7), 以它们的目标区域为中心向四周扩展得到m个扩展区域, 超像素分割这些扩展区域, 用超像素表示物体部件, 提取各部件HSI颜色空间的直方图作为部件特征, 集合这些部件特征建立物体部件库;然后, 利用均值聚类法聚类部件库内部件, 将描述相同部件的超像素集合到一个聚类, 用每个聚类的总体特征描述相应物体部件;最后, 计算每个聚类属于目标的置信度描述对应部件属于目标的概率.如此< /span>, 利用部件的特征和置信度来描述目标的初始表观模型;

· 目标跟踪阶段:根据部件匹配和相似干扰进行目标跟踪.对新一帧输入图像, 首先根据其前一帧跟踪结果建立扩展区域;再对扩展区域进行超像素分割得到该帧的部件集, 根据部件匹配算法计算每个部件的置信度;然后, 在扩展区域采样多个候选样本, 并在贝叶斯框架下根据各样本所含部件的置信度计算样本置信度;最后, 根据相似物体干扰处理优化样本置信度, 进而得到目标区域;

· 更新阶段:利用部件库的特征补集更新表观模型.首先, 确定部件库被替换帧的特征集, 分别计算该特征集与当前帧部件特征矢量的距离;然后, 寻找被替换帧中不在当前帧内的部件特征, 以构造当前帧的特征补集, 合并当前帧的特征集及其补集, 替换被替换帧的特征集, 构造更新后的部件库;最后, 对新部件库的特征集进行聚类并计算各聚类的置信度, 完成对表观模型的更新.

3 构建基于部件库的表观模型本节首先描述建立表观模型的特征, 进而给出如何根据目标/背景的特征构建目标物体的表观模型.

3.1 特征提取和部件库的建立本文采用超像素的颜色信息作为图像特征来构建表观模型.超像素是一种典型的中层视觉特征, 一个超像素包含若干像素点, 对应图像中一个具有相似结构的局部连通区域.由于中层视觉特征具有丰富的图像结构信息, 与高层外观模型和低层视觉相比, 它更灵活且适应性更强.因此, 与目标跟踪中普遍采用的直方图、轮廓等特征相比, 超像素对目标表达能力更强.本文利用超像素描述物体部件, 首先采样SLIC方法[15]对输入图像进行超像素分割.SLIC分割算法是一种简单的线性迭代聚类方法, 它在一个5维空间内(3维颜色空间+2维位置空间)对像素点进行聚类, 并提出新的距离函数约束超像素的划分.该方法得到的超像素尺寸均匀、内容紧凑 、简单易用(只需超像素总数)且执行效率高(复杂度为O(N)), 被广泛应用于物体识别和分类.

将图像分割为若干超像素后,这些超像素具有相似的灰度值和纹理特性,表达了物体的局部部件.本文利用超像素描述物体部件,根据超像素构建表观模型.假设对第t帧图像进行超像素分割,得到Nt个超像素sp(t,j) (j=1,…,Nt).有些超像素描述目标部件,如图2(c)表示女孩黄色上衣的超像素和红色裤子的超像素;有些则描述背景,如图2(c)描述灰色地板的超像素.由于HSI模型[17, 18]能够准确反映人眼视觉系统对色彩的感知,本文提取超像素HSI颜色空间的直方图作为其特征.对于第t帧Nt个超像素的特征集,用${{F}_{t}}=\{f_{t}^{r}|r=1,...,{{N}_{t}}\}$表示.

|

图2 部件库的聚类过程 Fig.2 Procedure of clustering the component library |

为了构建能够有效区分目标和背景的外观模型,需建立部件库作为先验知识.先验知识在当前跟踪场景中是不可得的,由已跟踪若干结果提供.首先,采用简单模板匹配方法[19]跟踪图像序列的前m帧;然后,把第i(1≤i≤m)帧目标区域的周围区域(以目标区域中心为中心,目标区域对角线长度的ls倍作为边长)分割成Ni个超像(本文实验中,ls取1.5,m取7,Ni取300),并计算超$F=\{f_{{{t}'}}^{r}|{t}'=1,...,m,\ r=1,...,{{N}_{{{t}'}}}\}.$像素的特征;最后,集合m帧超像素及其特征,建立初始部件库,并得到其特征集由于采用对目标位置的周围区域进行分割而获取超像素集合,因此部件库中包含描述目标和背景的超像素(如图2(c)所示).

3.2 初始表观模型的建立本文根据描述先验知识的初始部件库建立初始表观模型,包括两步:聚类部件库的特征集和计算部件置

信度.

步骤1. 聚类部件库的特征集.

部件库中的一个部件可能对应多个超像素,需要对部件库的特征集进行聚类,每个聚类描述一个部件,如图2(d)中的红色聚类描述目标物体的上衣,灰色聚类描述背景地板.利用均值聚类法[20, 21, 22, 23, 24]把部件库的特征集聚类成n类clst(k)(k=1,…,n),描述n个部件.第k个部件包含信息fc(k)(聚类k中心的特征矢量,等于它所包含的所有特征矢量的均值,用于近似描述其特征)、rc(k)(聚类k的半径)和特征集$\{f_{{{t}'}}^{r}|f_{{{t}'}}^{r}\in clst(k)\}$(聚类k的特征成员).

步骤2. 计算每个部件的置信度,描述部件属于目标的概率.

部件的置信度等于其所对应的聚类置信度,而聚类置信度取决于它所包含的超像素.当某个聚类中超像素全部位于目标区域时,该聚类完全属于目标;但当聚类的超像素全部位于背景时,该聚类则完全属于背景.但事实上,超像素常部分属于目标区域,部分属于背景,本文根据超像素属于目标和背景的面积来计算其所从属聚类的置信度.假设用S+(k)表示聚类k所有超像素位于目标区域内的像素数,用S-(k)表示目标区域外的像素数,则聚类k的置信度为

\[{{C}_{k}}=\frac{{{S}^{+}}(k)-{{S}^{-}}(k)}{{{S}^{+}}(k)+{{S}^{-}}(k)},\forall k=1,...,n\]

(1)

本节中,根据已建立的初始表观模型提出目标跟踪方法.首先,利用贝叶斯滤波模型获取初始目标状态;然后,采用相似物体干扰检测与处理策略优化目标位置,得到更准确的跟踪结果.

4.1 贝叶斯框架

在目标跟踪领域,贝叶斯滤波原理是众多跟踪算法的理论基础,其中,粒子滤波在处理非线性、非高斯系统时表现得十分出色,具有较强的鲁棒性.本文基于贝叶斯滤波模型对目标进行跟踪,对于给定t时刻的状态Xt和到t时刻的观察值Y1:t,可将目标跟踪问题转化为求解后验概率p(Xt|Y1:t).

\[p({{X}_{t}}|{{Y}_{1:t}})\approx p({{Y}_{t}}|{{X}_{t}})\int{p({{X}_{t}}|{{X}_{t-1}})p({{X}_{t-1}}|{{Y}_{1:t-1}})\text{d}{{X}_{t-1}}}\]

(2)

在贝叶斯框架下,当前大量跟踪方法是针对观察模型进行研究[7, 8, 9, 10, 25, 26],通过研究观察模型和运动模型,利用贝叶斯滤波原理计算后验概率,进而通过最大后验概率获得目标状态.假设t时刻有N个候选样本,根据贝叶斯滤波原理的最大后验概率,$X_{t}^{(l)}$代表状态t时刻的第l个候选样本,则t时刻目标状态${{\hat{X}}_{t}}$为

| \[{{\hat{X}}_{t}}=\underset{X_{t}^{(l)}}{\mathop{\arg }}\,\max p(X_{t}^{(l)}|{{Y}_{1:t-1}}),\forall l=1,...,N\] | (3) |

根据公式(2)和公式(3),构建观察模型p(Yt|Xt)是基于贝叶斯框架目标跟踪的关键.本文提出一种新的观察模型来预测候选样本属于目标或背景的可能性,利用样本置信度描述这种可能性,通过构建置信度图计算样本置信度,具体方法见第4.2节.

4.2 计算样本的置信度本文提出的观察模型用于估计样本置信度,该置信度计算通过以下两步实现:首先,计算该样本所在图像的置信度图;然后,根据样本区域计算其置信度.

(1) 构建图像置信度图

本节以如何获取第t帧的置信度图为例阐述置信度图的计算.为了简化第t帧置信度图的计算,通过保持第t-1帧目标区域的中心并增大目标区域的尺寸,在第t帧上确定一个扩展区域.因为视频序列中物体运动的连续性和一致性,导致相邻帧目标区域的位置和尺寸的变化不大,所以第t帧的所有候选样本均取自该扩展区域.对第t帧的扩展区域进行超像素分割,每个超像素近似对应一个物体部件,得到Nt个部件(如图3(b)所示).第t帧的置信度图由这些部件的置信度确定.每个部件根据以下两个因素得到其置信度:所属聚类的置信度和该部件与对应聚类中心的距离.第1因素的原理是如果部件在特征空间上属于表观模型中某个聚类,那么部件的置信度应正比于该聚类的置信度;第2因素考虑部件的特征矢量在特征空间上与相关聚类中心的距离,距离越远,说明该部件置信度与相关聚类置信度的相关系数越小.假设第t帧的第r个部件的特征为$f_{t}^{r},$通过计算$f_{t}^{r}$与所有聚类中心特征的距离,判断r所属的聚类.当$f_{t}^{r}$与聚类clst(k)的中心特征fc(k)距离最小时,则认为部件r属于聚类clst(k).部件r的置信度$C_{k}^{c}$由聚类clst(k)的置信度$$和r与聚类clst(k)的相关系数w(r,k)决定(见公式(5)),其中,w(r,k)的计算如下:

| \[w(r,k)=\exp \left( -{{\lambda }_{d}}\times \frac{||f_{t}^{r}-{{f}_{c}}(k)|{{|}^{2}}}{{{r}_{c}}(k)} \right),\forall r=1,...,{{N}_{t}},k=1,...,n\] | (4) |

| \[C_{t}^{r}=w(r,k)\times C_{k}^{c},\forall r=1,...,{{N}_{t}}\] | (5) |

|

图3 贝叶斯框架的跟踪过程 Fig.3 Procedure of object tracking based on Bayesian framework |

公式(4)的λd为常数(实验中取值为2).第t帧扩展区域内像素点的置信度由它所属的超像素的置信度决定(图3(c)是图3(a)的置信度图,蓝色越深,代表属于背景的可能性越大,红色越深,代表属于目标的可能性越大),而扩展区域外的像素点则均视为背景,它们的置信度赋值背景区域的置信度即为-1.

(2) 计算样本的置信度

假设$$表示第t帧的第l个样本$$在置信度图上的覆盖区域(如图3(d)所示,在该样本置信度图中,第1个样本的置信度较高,说明其属于目标区域的概率较大),用V(i,j)表示位于(i,j)的像素点的置信度,那么,$X_{t}^{(l)}$的置信度Ct(l)为

| \[{{C}_{t}}(l)=\sum\nolimits_{(i,j)\in A_{t}^{(l)}}{V(i,j)}\] | (6) |

但直接使用样本置信度不能有效反映目标尺寸的变化,需要对样本置信度作正则化处理,将其归入到区间[0,1].设$S(X_{t}^{(l)})$表示样本$X_{t}^{(l)}$的区域大小,S(Xt-1)表示第t-1帧的目标区域Xt-1的区域大小,则Ct(l)的正则化结果为${{\hat{C}}_{t}}(l)={{{C}'}_{t}}(l)\times [S(X_{t}^{(l)})/S({{X}_{t-1}})].{{\hat{C}}_{t}}(l)$描述了样本$X_{t}^{(l)}$在观察模型$p({{Y}_{t}}|X_{t}^{(l)})$中的取值,满足$p({{Y}_{t}}|X_{t}^{(l)})\propto {{\hat{C}}_{t}}(l).$本文中取$p({{Y}_{t}}|X_{t}^{(l)})={{\hat{C}}_{t}}(l),$并利用高斯模型计算$p(X_{t}^{(l)}|{{X}_{t-1}}),$再根据公式(3)得到每个样本的后验概率,并取后验概率最大的样本区域为第t帧的目标区域.

4.3 相似物体干扰的检测与处理在贝叶斯框架下,通过第4.2节的观察模型和第4.1节的运动模型,通常场景下能获取目标位置的准确状态.然而,跟踪中经常出现与目标非常接近的物体,如图4中653帧处与红色矩形框内的目标区域相邻的绿色球衣运动员.这些相似物体与目标的特征非常接近,在观察模型中,它们的置信度与目标区域的置信度接近相同(如下文图5(a)第1列的置信度图所示).当这类相似物体出现在目标周围时(如图4中653帧所示),会对目标检测形成不利干扰,处理不当时,相似物体会被识别为目标 物体,从而产生跟踪漂移(如图4(b)第3列所示).

|

图4 有无相似对象干扰处理结果 Fig.4 Tracking result with and without dealing with disturbance introduced by similar object |

|

图5 检测相似对象干扰导致的异常扩展 Fig.5 Detect the exception extension of target frame caused by disturbance introduced by similar object |

本文对相似物体的预测和处理,通过以下3个步骤实现.

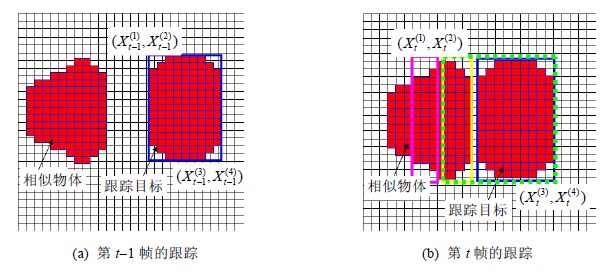

步骤1. 相似物体干扰的预测.

对比第t帧与第t-1帧目标区域的4个方向的坐标,判断第t帧目标区域是否发生最大限度的扩展.设$\{x_{t}^{(1)},...,x_{t}^{(4)}\}$分别代表第t帧目标框左上角的横、纵坐标和右下角的横、纵坐标(如图5(a)所示),$\{x_{t-1}^{(1)},...,x_{t-1}^{(4)}\}$表示第t-1帧目标框左上角的横、纵坐标和右下角的横、纵坐标,L为目标t时刻所允许的最大位移,$\{X_{t}^{(h)},X_{t}^{(w)}\}$和$\{X_{t-1}^{(h)},X_{t-1}^{(w)}\}$分别代表第t帧和第t-1帧目标框的高和宽.当同时满足以下两个条件时,说明可能出现相似物体干扰:

(1) 目标区域在方向d外延伸了最大距离,即$|x_{t}^{(d)}-x_{t-1}^{(d)}|\ \ge L,\forall d=1,2,3,4;$

(2) 目标区域在高度或宽度上发生最大限度的扩展,即$|X_{t}^{(s)}-X_{t-1}^{(s)}|\ \ge L,\forall s=h,w.$

这种超过最大限度的扩展被定义为异常扩展.其中,L与目标框大小有关(本文实验中,当边框长度大于40时,L取15;否则,L取1/4边框大小).

步骤2. 相似性物体干扰的确定.

根据相似物体预测,当检测到目标框发生异常扩展时,需进一步确定该异常扩展是否为相似物体干扰.因为相似物体可能从目标的左/右/上/下和4个对角方向靠近,需从这8个方向判断.以相似物体从左边靠近为例解释异常扩展的判断.假设第t-1帧相似物体离目标较远,目标框能够恰好包围目标(如图5(a)中蓝框所示);第t帧发生从左侧相似物体干扰(如图4(b)所示),利用最大后验概率得到异常扩展的目标区域(如图5(b)中绿框所示).但实际上图5(b)蓝框所示才是正确的目标区域.是否发生异常扩展的判断,通过比较绿框本身的扩展区域(图5(b)中黄框所示)和绿框左侧与扩展区域相同大小区域(如图5(b)中粉色框所示)来实现.设Ne1表示扩展区域,即黄框中置信度大于0的像素数;Ne2表示粉色框中置信度大于0的像素数;θ1为常量,表示阈值(实验中取0.6).当Ne2/Ne1≥θ1时,说明粉色框内置信度大于0的像素比黄框多,即粉色框包含与黄框相似的物体,由此可以预测绿框左侧出现与目标相似的物体区域.据此断定黄框发生了异常扩展,该扩张由目标周围相似物体的干扰产生.

步骤3. 相似性物体干扰处理.

当检测到相似物体干扰后,需调整目标框以优化目标区域.本文把发生异常扩展的边向扩展反方向收缩L长度(L为t时刻最大位移).如图4所示,第1行、第2行分别是跟踪结果和置信度图.图4(a)有相似物体干扰结果,相似物体靠近目标(见第1列)、对目标遮挡(见第2列)和离开目标时(见第3列)都能有效跟踪目标;图4(b)所示为无相似对象干扰处理策略结果,在相似物体靠近目标(见第1列)时可跟踪目标,在对目标部分遮挡(见第2列)时目标框偏向干扰物体,遮挡消失时(见第3列)出现跟踪漂移.

5 基于部件特征补集的表观模型更新随着时间的推移,光照变化、遮挡、运动模糊、目标物体变形等现象均有可能出现,需要根据背景和目标的变化不断调整目标表观模型.表观模型由其所包含的部件库的聚类、聚类属性(含特征矢量、半径和置信度)所确定.因此,对表观模型的更新也通过以下两步实现:更新构建表观模型部件库的聚类和更新这些聚类的属 性值.

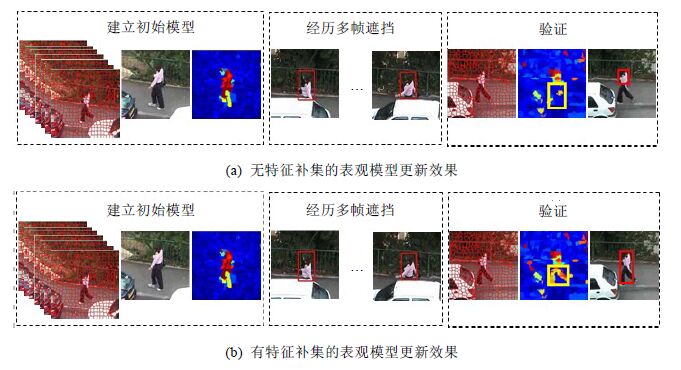

5.1 更新构建表观模型的部件库的特征聚类传统的表观模型更新方法,每跟踪若干帧后就用最新帧(时间最近帧)换掉最旧帧(时间最久帧),然后重新建模实现.为了处理严重遮挡和漂移问题,常通过寻找最佳被替换帧的方式以增强新表观模型的有效性.文献[10]将发生严重遮挡帧作为被替换帧.但当更新表观模型只通过替换整帧来实现时,无法表示目标被遮挡或形变等区域,使表观模型不能完整地表达目标区域(如图6(a)中第3列黄框区域所示).当恢复遮挡时,不完整表观模型无法识别曾经被遮挡或发生大形变的部件,从而产生不准确的跟踪结果(如图6(a)中第3列所示).本文提出部件库特征补集方法以保留被替换帧中被丢弃的目标特征,使表观模型对目标的描述更加完整.本文对于表观模型的更新通过以下3步实现.

|

图6 特征补集在表观模型更新中的效果 Fig.6 Influence of the complementary set to updating appearance model |

步骤1. 构建部件库的特征补集.

若不建立特征补集,这类特征将被舍弃,导致新表观模型无法表示相应的物体部件.为了处理严重遮挡或跟踪漂移问题,在没有发生严重遮挡或漂移时,选择最旧帧作为被替换帧;否则,选择距离当前最近的第k帧(实验中,k取3)作为被替换帧.当被替换帧目标区域内置信度大于0的特征数量大于b时(β为常数,用于限制特征补集所含特征的数量,实验中,β=15),从中选出β个特征作为当前帧特征集的补集(要求它们与当前帧所属聚类中心的距离较大);当置信度大于0的特征小于β时,把这些特征直接作为补集.

本文根据公式(7)对严重遮挡或漂移进行判断.假设t时刻共有Nt个样本(实验中,200≤Nt≤600),其置信度为Ct(l),l=1,…,N.设θ0为检测严重遮挡或漂移的阈值,μ为构建部件库的m帧图像置信度的平均值.Ct(l¢)为当前帧目标区域置信度,$X_{t}^{({l}')}$为其对应的采样,$S(X_{t}^{({l}')})$为该采样的面积值.公式(7)左边分母使得左边值的范围为[0,1].当公式(7)左侧的比值大于θ0时,说明当前帧目标区域置信度远远小于用于构建部件库保留的各帧的置信度的平均值,意味着当前帧的目标区域大部分属于背景区域,即可断定当前帧发生了严重的遮挡或漂移.

| \[\frac{\mu -{{C}_{t}}({l}')}{2\times S(X_{t}^{({l}')})}>{{\theta }_{0}},\text{ s}\text{.t}\text{. }{{C}_{t}}({l}')=\max (\{{{C}_{t}}(l)\}_{l=1}^{{{N}_{t}}})\] | (7) |

步骤2. 更新部件库特征集.

得到部件库特征补集后,合并入当前帧特征集作为新特征集加入部件库,并删除被替换帧的特征集,完成一次部件库的特征集更新,得到描述新表观模型的部件库特征集.

步骤3. 更新表观模型的聚类.

根据第3节可知,表观模型由其特征聚类描述.因此,更新表观模型首先要更新其特征聚类.由步骤2可以得到新表观模型的特征集,对该特征集重新聚类,即得到新表观模型.

5.2 表观模型的聚类属性的更新聚类属性描述了目标物体的性质,主要包括聚类半径、聚类中心的特征和聚类置信度.更新表观模型时,必须更新相应的聚类属性.其中,聚类半径和聚类中心特征在重新聚类时得到,因此属性更新的关键是更新其置信度.

新表观模型通过重新聚类新部件库的特征集来实现,因此,新部件库每个聚类的特征集来自两个方面:部件库的特征补集和检测到的部件库的特征集.假设重建表观模型的特征中来自检测到的部件库的特征集为F,来自部件库的特征补集为$\tilde{F}.$当任意一个新聚类clst(k)的特征全属于F时,计算其置信度的S+(k)和S-(k)的方法与第3.2节相同;但当新聚类clst(k)的特征既来自F又来自$\tilde{F}$时,根据公式(8)和公式(9)计算其S+(k)和S-(k),其中,$S_{F}^{+}(k)$和$S_{{\tilde{F}}}^{+}(k)$分别表示clst(k)中来自F和$\tilde{F}$的特征所对应部件属于目标的像素数,$S_{F}^{-}(k)$和$S_{{\tilde{F}}}^{-}(k)$则表示这些特征所对应部件属于背景的像素数.$S_{F}^{+}(k)$和$S_{F}^{-}(k)$的计算方法与第3.2节相同.

因为部件库的特征补集所对应的部件全部被识别为目标,这些部件所含像素数量应加入对应聚类位于目标的像素数量.因此,假设$\sum\nolimits_{\tilde{f}\in \tilde{F}}{Area(\tilde{f})}$表示特征$\tilde{f}(\tilde{f}\in \tilde{F})$对应部件的面积,则$S_{{\tilde{F}}}^{+}(k)=\sum\nolimits_{\tilde{f}\in \tilde{F}}{Area(\tilde{f})},S_{{\tilde{F}}}^{-}(k)=0.$进而,包含特征补集的聚类的S+(k)和S-(k)为

| \[{{S}^{+}}(k)=S_{F}^{+}(k)+S_{{\tilde{F}}}^{+}(k)=S_{F}^{+}(k)+\sum\nolimits_{\tilde{f}\in \tilde{F}}{Area(\tilde{f})}\] | (8) |

| \[{{S}^{-}}(k)=S_{F}^{-}(k)+S_{{\tilde{F}}}^{-}(k),\text{ s}\text{.t}\text{. }S_{{\tilde{F}}}^{-}(k)=0\] | (9) |

图6(a)所示为无特征补集更新表观模型,由图可知:经过多帧遮挡后,目标的腿部特征信息丢失,该部件在遮挡完成后被识别为背景(如图6(a)中黄框所示).图6(b)采用特征补集方法更新表观模型,腿部特征集作为部件库的特征补集而加以保留,所以当该部件重新出现时,能被正确识别(如图6(b)中黄框所示).虽然图6(a)与图6(b)有初始表观模型和遮挡,但图6(b)比图6(a)的跟踪结果(对比两组第3列红色框)更准确.

6 实验与结果分析 6.1 本文实验设置本文在CPU 2.53GHz、内存2G的PC机,MATLAB(R2011b)下进行相关实验.利用SLIC算法[15]实现超像素分割(其权重参数和超像素个数分别设为10和300),采用HSI颜色空间直方图描述部件的特征,采用Mean Shift聚类算法[20]对实现聚类(聚类的核宽参数设为[0.15~0.20]),并设定检测遮挡的阈值θ0的范围为[-0.25~0.3].

本文采用12组视频序列(见附录表4)进行实验.这些序列涵盖了目标跟踪的主要挑战,包括复杂背景、目标快速移动、姿态和尺寸严重变形、部分或严重遮挡、严重的形状畸变、光照变化.为验证本文方法的优越性,我们将其与现有主流的10种跟踪方法(包括IVT[5],L1[7],SCM[27],LSAM[28],Godec[9],BHMC[26],LOT[29],VTD[8],VTS[25],SPT[10])进行对比分析,具体见第6.2节和第6.3节.

| 表4 图像序列汇总表 Table 4 Total image sequences |

分别从7个跟踪挑战的角度来分析本文方法的有效性(包括遮挡、快速移动、姿势变化、剧烈形变、相似对象干扰、复杂背景、光照变换),并将本文与现有方法进行对比分析.

(1) 遮挡实验

图7展示了Woman_sequence视频中行人多次被汽车遮挡的跟踪效果,其中,Godec,IVT,L1,VTD,SPT和Ours方法的跟踪结果分别用黑色(虚线)、紫色(虚线)、蓝绿色(虚线)、黑色(实线)、黄色(虚线)和红色(实线)表示.由于基于部件库特征补集的表观模型可同时学习目标和背景的特征,并通过特征补集保留被遮挡目标,即使经历长时间遮挡仍能识别出被遮挡部分(如第167帧的人腿),从而克服遮挡引起的漂移,在遮挡发生时仍能准确跟踪目标.而其他方法(如IVT,VTD,Godec,L1和SPT)由于不能有效保留目标被遮挡部分的特征,在遮挡发生后无法跟踪到目标.如在32帧,行人的裤子与车窗色彩相似,Godec方法没有限定目标导致目标区域过大,引起跟踪漂移.IVT和L1方法采用整体模板为图像特征,遮挡发生时易将背景识别为目标,在65帧导致跟踪失败. SPT方法未用特征补集更新表观模型,长时间遮挡后被遮挡部件特征被丢弃,最终使目标区域不能准确覆盖物体(如319帧的黄色框).

|

图7 遮挡跟踪结果 Fig.7 Tracked results of occlussion |

(2) 快速运动实验

图8展示了Liquor序列快速运动引起运动模糊的跟踪结果,其中,LOT,VTS,VTD和Ours方法的跟踪结果分别用白色(实线)、蓝色(虚线)、黑色(实线)和红色(实线)表示.本文方法基于部件级信息更新表观模型,当目标快速运动时,其表观模型的背景信息被迅速更新,从而在运动模糊情况下仍能准确跟踪到物体.LOT方法有时能捕捉快速运动的物体(如第872帧的白色框),但当出现相似物体干扰时(如1013帧的黄色瓶子),则引起跟踪失败.VTD方法和VTS方法因无法有效地响应背景快速变化,产生了跟踪漂移.

|

图8 快速运动跟踪结果 Fig.8 Tracked results of quick motions |

(3) 姿势变化实验

图9展现了Lemming序列中目标姿势变化的跟踪效果,其中,VTD,LOT,IVT,VTS和Ours方法的跟踪结果分别用黑色(实线)、白色(实线)、紫色(虚线)、蓝色(虚线)和红色(实线)表示.IVT方法采用整体表观模型在没有姿势变化时能够很好地跟踪目标,但常在目标姿势和尺寸发生较大变化时跟踪失败(如第1081帧的紫色框).而VTD方法和LOT方法基于局部块的匹配,不能有效区分目标和背景,无法更新发生大变换的物体.本文方法在更新表观模型时采用部件集的替换方式,能够保留目标的特征,增强处理姿势和尺寸大变化时跟踪的健壮性.

|

图9 姿势和尺寸发生较大变化时的跟踪结果 Fig.9 Tracked results of variation of pose and scale |

(4) 剧烈形变和复杂背景实验

图10展现了Diving序列目标剧烈形变的跟踪效果,其中,LOT,VTD,Godec,IVT,SPT和Ours方法的跟踪结果分别用白色(实线)、黑色(实线)、黑色(虚线)、白色(虚线)、黄色(虚线)和红色(实线)表示.IVT方法因其表观模型的整体性,对刚性目标的跟踪效果良好,但在目标剧烈形变时会出现跟踪漂移(如第76帧紫色框 ).VTD方法和LOT方法基于局部匹配跟踪模式,对非刚性变化不敏感,无法捕捉到剧烈形变下的目标区域(如第76帧的白色框和黑色框).Godec方法对目标区域边界不确定,跟踪过程容易受复杂背景的影响,目标框常被扩大进而导致跟踪失败(如第76帧黑色虚线框).SPT方法在超像素尺寸下区分目标和背景,对目标发生缓慢形变时有很好的跟踪效果,但常无法跟踪剧烈形变下的目标(如第76帧黄色虚线框).本文方法在部件级表观模型下,能够通过扩展和收缩采样框使目标框贴近物体,以获取准确的跟踪效果(如图10中红色框所示).

|

图10 严重的形状畸变的跟踪结果 Fig.10 Tracked results of objects with non-rigid deformation |

(5) 相似物体干扰实验

图11中展现了Face序列中目标在相似物体靠近或遮挡时的跟踪效果,其中,SPT,VTS,VTD,IVT,SCM,L1和Ours方法的跟踪结果分别用黄色(实线)、蓝色(虚线)、黑色(实线)、紫色(虚线)、绿色(实线)、蓝绿(虚线)和红色(实线)表示.其中,相似物体(男孩)从目标左侧靠近并遮挡目标(女孩),并在最后返回左侧.现有主流的跟踪方法(如SPT,SCM,VTD,IVT和VTS)因干扰物体的特征与目标相似,常把干扰对象识别为目标,引起跟踪漂移.L1方法根据图像的灰度值进行跟踪,虽然可以避免相似物体靠近时的干扰,但无法处理遮挡情况(如第38帧蓝绿色框).本文方法通过检测和处理相似物体,能够有效区分干扰对象和目标物体,得到更准确的跟踪结果.

|

图11 相似对象干扰的跟踪结果 Fig.11 Tracked results of disturbance introduced by similar object |

(6) 光照变化实验

图12展现了Singer1序列中光照变化的跟踪效果,其中,LOT,L1,IVT,VTD和Ours方法的跟踪结果分别用白色(实线)、蓝绿色(虚线)、紫色(虚线)、黑色(实线)和红色(实线)表示.其中,VTD方法和LOT方法因无法适应剧烈的光照变化,导致目标框太大或太小(如第135帧黑色框和白色框).IVT方法可适应光照变化下的目标运动,但当目标与光照的色彩接近时(白色目标和白色光照),导致跟踪漂移(如第135帧紫色框).本文方法基于部件级的表观模型建模机制,能够快速记录局部背景信息的变换,从而在光照变化时准确跟踪到物体.

|

图12 光照变化的跟踪结果 Fig.12 Tracked results when there are large illumination variation |

本文采用平均中心位置误差和平均跟踪成功率对目标跟踪进行定量分析.平均中心位置误差反映了跟踪结果与实际目标中心偏差的均值,该值越小,说明跟踪结果的中心与目标的中心越接近,跟踪精确度越高.平均跟踪成功率描述了视频序列中跟踪成功的帧数,该值越大,说明跟踪成功的帧数越多,跟踪准确率越高.

表1给出了多种方法(包括IVT,L1,SCM,LSAM,Godec,BHMC,LOT,VTD,VTS,SPT)跟踪12组视频序列的跟踪结果中心位置误差(以像素为单位).平均中心位置误差越小,跟踪越准确.表中红色数值代表同一视频中的最小平均误差,蓝色数值表示次小值.由表1可知,本文方法(Ours列)在所有视频序列中引起的平均中心误差都处于最小值和次小值.说明本文方法引起的平均误差均较小,能够产生稳定且准确的跟踪结果.

| 表1 跟踪结果的平均中心点误差 Table 1 Average errors of center location in pixels |

表2给出了表1中不同方法跟踪成功的帧数,其中,红色表示同一行内的最优值,蓝色表示次优值.本文采用PASCAL VOC challenge的检测准则[30]来判断是否跟踪成功.假设RT为某一帧的跟踪结果,RG为该帧的标准目标位置,若score>0.5,则说明该帧跟踪成功;否则,跟踪失败.其中,score=area(RTÇRG)/area(RTÈRG),area()为面积函数.同一视频序列中,跟踪成功帧数越多,说明该方法越有效.表2中,红色数值代表成功帧数最多,对应最优跟踪方法,蓝色数值次之.由表2可知:本文方法(Ours列)在80%以上的视频序列跟踪成功的帧数最多,其余序列跟踪成功的帧数也属于次多.这进一步说明,与现有主流跟踪方法相比,本文方法能够得到更好的跟踪结果.

| 表2 跟踪结果的成功跟踪帧数 Table 2 Count of successful frame |

Wu等人[31]提出Benchmark用以对比跟踪方法,采用每秒处理视频帧数度量计算效率,处理帧数越多,跟踪效率越高.本文采用相同方法进行效率对比,统计数据见表3.由表3数据可知:本文方法执行效率明显优于LOT方法,在大部分情况下略优于SPT方法.主要因为本文优化了表观模型更新时的超像素,缩短了建模时间.虽然VTD方法和VTS方法的计算效率略高于本文方法,但它们是以牺牲质量来换取效率,常引起跟踪失败或漂移.此外, 在精度要求不高时,本文方法通过减少建模超像素数可大幅度提高计算效率.

| 表3 跟踪方法的计算效率,数值表示每秒跟踪帧数 Table 3 Efficiency of algorithms,the value is frames per second |

本文针对目标跟踪中的若干挑战性问题展开研究,提出一种基于部件级表观模型的目标跟踪方法.该方法以超像素描述目标部件,通过分析部件库的特征构建表观模型,能够灵活、有效地表达不断变化的目标和背景.其中,基于部件库特征补集的表观模型更新方法,使本文方法能够在目标被长期遮挡、发生剧烈形变或遭受运动模糊时仍能准确记录目标特征,提供强健、有效的表观模型.此外,本文方法还检测和处理与目标相似的物体靠近和遮挡目标时所带来的干扰,有效地解决了相似物体引起的跟踪漂移问题.基于大量视频序列的实验结果表明:与现有主流跟踪方法相比,在多种跟踪挑战情况下(含遮挡、剧烈形变、光照变化、运动模糊、姿势变化、相似物体干扰、复杂背景),本文方法的跟踪结果具有更多的跟踪成功帧数和更小的跟踪结果中心误差,说明本文方法能够更有效地处理跟踪中的这些挑战,提供更准确且稳定的跟踪结果.

| [1] | Yilmaz A, Javed O, Shah M. Object tracking: A survey. ACM Computing Surveys, 2006,38(4). |

| [2] | Yang HX, Shao L, Zheng F, Wang L, Song Z. Recent advances and trends in visual tracking: A review. Neurocomputing, 2011, 74(18):3823-3831. |

| [3] | Avidan S. Ensemble tracking. In: Proc. of the 18th IEEE Int'l Conf. on Computer Vision and Pattern Recognition (CVPR). San Diego, 2005. 494-501. |

| [4] | Hua S, Li CH, Wei FM, Wang HW. Moving object tracking based on location and confidence of pixels. Journal of Computer Research and Development, 2008,42(10):1726-1732 (in Chinese with English abstract). |

| [5] | Lim J, Ross D, Lin RS, Yang MH. Incremental learning forvisual tracking. In: Proc. of the Neural Information Processing Systems Foundation. 2005. 793-800. http://papers.nips.cc/book/advances-in-neural-information-processing-systems-18-2005 |

| [6] | Babenko B, Yang MH, Belongie S. Visual tracking with onlinemultiple instance learning. In: Proc. of the 22th IEEE Int'l Conf. on Computer Vision and Pattern Recognition (CVPR). 2009. 983-990. |

| [7] | Mei X, Ling H. Robust visual tracking using l1 minimization. In: Proc. of the 12th IEEE Int'l Conf. on Computer Vision (ICCV). Kyoto, 2009. 1436-1443. |

| [8] | Kwon J, LeeK M. Visual tracking decomposition. In: Proc. of the 23th IEEE Conf. on Computer Vision and Pattern Recognition (CVPR). San Francisco, 2010. 1269-1276. |

| [9] | Godec M, Roth PM, Bischof H. Hough-Based tracking of non-rigid objects. In: Proc. of the 13th IEEE Int'l Conf. on Computer Vision (ICCV). Barcelona, 2011. 81-88. |

| [10] | Wang S, Lu H, Yang F, Yang MH. Superpixel tracking. In: Proc. of the 13th IEEE Int'l Conf. on Computer Vision (ICCV). Barcelona, 2011. 1323-1330. |

| [11] | Wang JY, Chen XL, Gao W, Zhao DB. Adaptive appearance model robust to background variations. Ruan Jian Xue Bao/Journal of Software, 2006,17(5):1001-1008 (in Chinese with English abstract). http://www.jos.org.cn/1000-9825/17/1001.htm |

| [12] | Ren X, Malik J. Learning a classification model for segmentation. In: Proc. of the 9th IEEE Int'l Conf. on Computer Vision (ICCV). Nice, 2003. 10-17. |

| [13] | Mori G, Ren X, Efros A, Malik J. Recovering human body configurations: Combining segmentation and recognition. In: Proc. of the 17th IEEE Int'l Conf. on Computer Vision and Pattern Recognition (CVRP). Washington, 2004,2:326-333. |

| [14] | Vedaldi A, Soatto S. Quick shift and kernel methods for mode seeking. In: Proc. of the 10th European Conf. on Computer Vision (ECCV). Marseille: Springer-Verlag, 2008. 705-718. |

| [15] | Levinshtein A, Stere A, Kutulakos K, Fleet D, Dickinson S, Siddiqi K. Turbopixels: Fast superpixels using geometric flows. IEEE Trans. on Pattern Analysis and Machine Intellience, 2009,31(12):2290-2297. |

| [16] | Radhakrishna A, Shaji A, Smith K, Lucchi A, Fua P, Susstrunk S. Slicsuperpixels. Technical Report, 149300, EPFL, 2010. |

| [17] | Ai HZ, Liang LH, Xu GY, Zhang B. Face detection based on skin color and template. Ruan Jian Xue Bao/Journal of Software, 2001, 12(12):1784-1792 (in Chinese with English abstract). http://www.jos.org.cn/1000-9825/20011207.htm |

| [18] | Li HQ, Liu ZK, Zhan S. A segmentation method of color texture image. Chinese Journal of Computers, 2001,24(9):965-971 (in Chinese with English abstract). |

| [19] | Li Y, Huang G, Nevatia R. Learning to associtate: HybridBoosted multi-target tracker for crowded scene. In: Proc. of the 22th IEEE Int'l Conf. on Computer Vision and Pattern Recognition (CVPR). Miami, 2009. 2953-2960. |

| [20] | Comaniciu D, Ramesh V, Meer P. Kernel-Based object tracking. IEEE Trans. on Pattern Analysis and Machine Intelligence, 2003, 25:564-577. |

| [21] | Li XR, Wu FC, Hu ZY. Convergence of a mean shift algorithm. Ruan Jian Xue Bao/Journal of Software, 2005,16(3):365-374 (in Chinese with English abstract). http://www.jos.org.cn/1000-9825/16/365.htm |

| [22] | Wen ZQ, Cai ZX. Convergence analysis of mean shift algorithm. Ruan Jian Xue Bao/Journal of Software, 2007,18(2):205-212 (in Chinese with English abstract). http://www.jos.org.cn/1000-9825/18/205.htm |

| [23] | Sun JG, Liu J, Zhao LY. Clustering algorithms research. Ruan Jian Xue Bao/Journal of Software, 2008,19(1):48-61 (in Chinese with English abstract). http://www.jos.org.cn/1000-9825/19/48.htm |

| [24] | Comaniciu D, Meer P. Mean shift: A robust approach toward feature space analysis. IEEE Trans. on Pattern Analysis and Machine Intelligence, 2002,24(5):603-619. |

| [25] | Kwon J, Lee KM. Tracking by sampling tracker. In: Proc. of the 13th IEEE Int'l Conf. on Computer Vision (ICCV). Barcelona, 2011. 1195-1202. |

| [26] | Kwon J, Lee KM. Tracking of a non-rigid object via patch-based dynamic appearance modeling and adaptive Basin Hopping Monte Carlo sampling. In: Proc. of the 22th IEEE Int'l Conf. on Computer Vision and Pattern Recognition (CVPR). Miami, 2009. 1208-1215. |

| [27] | Zhong W, Lu HC, Yang MH. Robust object tracking via sparsity-based collaborative model. In: Proc. of the 25th IEEE Int'l Conf. on Computer Vision and Pattern Recognition (CVPR). Providence, 2012. 1838-1845. |

| [28] | Jia X, Lu HC, Yang MH. Visual tracking via adaptive structural local sparse appearance model. In: Proc. of the 23th IEEE Int'l Conf. on Computer Vision and Pattern Recognition (CVPR). Providence, 2012.1822-1829. |

| [29] | Oron S, Bar-Hillel A, Levi D, Avidan S. Locally orderless tracking. In: Proc. of the 23th IEEE Int'l Conf. on Computer Vision and Pattern Recognition (CVPR). Providence, 2012. 1940-1947. |

| [30] | Everingham M, Gool LV, Williams C, Winn J, Zisserman A. The pascal visual object classes (VOC) challenge. Int'l Journal of Computer Vision (IJCV), 2010,88(2):303-338. |

| [31] | Wu Y, Lim J, Yang MH, Online object tracking: A benchmark. In: Proc. of the 26th IEEE Int'l Conf. on Computer Vision and Pattern Recognition (CVPR). Portland, 2013. 2411-2418. |

| [32] | 施华,李翠华,韦凤梅,王华伟.基于像素可信度和空间位置的运动目标跟踪.计算机研究与发展,2005,42(10):1726-1732. |

| [33] | 王建宇,陈熙霖,高文,赵德斌.背景变化鲁棒的自适应视觉跟踪目标模型.软件学报,2006,17(5):1001-1008. http://www.jos.org.cn/ 1000-9825/17/1001.htm |

| [34] | 艾海舟,梁路宏,徐光祐,张钹.基于肤色和模板的人脸检测.软件学报,2001,12(12):1784-1792. http://www.jos.org.cn/1000-9825/ 20011207.htm |

| [35] | 李厚强,刘政凯,詹曙.一种彩色纹理图像的分割方法.计算机学报,2001,24(9):965-971. |

| [36] | 李乡儒,吴福朝,胡占义.均值漂移算法的收敛性.软件学报,2005,16(3):365-374. http://www.jos.org.cn/1000-9825/16/365.htm |

| [37] | 文志强,蔡自兴.Mean Shift算法的收敛性分析.软件学报,2007,18(2):205-212. http://www.jos.org.cn/1000-9825/18/205.htm |

| [38] | 孙吉贵,刘杰,赵连宇.聚类算法研究.软件学报,2008,19(1):48-61. http://www.jos.org.cn/1000-9825/19/48.htm |

2015, Vol. 26

2015, Vol. 26