2 厦门大学 计算机科学与技术系, 福建 厦门 361005

2 Department of Computer Science, Xiamen University, Xiamen 361005, China

隐喻是无所不在的,它充斥在我们的语言和思想中,是在一类事物的暗示下谈论另一类事物的语言行为,也是由此及彼的心理活动.近年来,隐喻现象作为自然语言处理中的“异常”现象,正逐渐被人们所重视.隐喻的机器理解问题不被解决,将严重制约自然语言处理和机器翻译的发展.但是,至今为止,还没有一个广泛应用的计算模型来解决隐喻问题.

如果不能很好地解决隐喻问题,将严重制约自然语言处理的发展.在机器翻译方面,众所周知,无论汉语还是英语中都存在着大量的隐喻现象,如:

(1) John is a pig(约翰是头猪)[1].

(2) I kill a process.

在(1)中,如果仅仅依靠字面直译,那么往往会解释为“约翰是一头猪”,这样的翻译显然是不符合大部分要求的.作为隐喻的理解,“约翰是可爱的”或“约翰是愚蠢的”,这样的结果无疑将准确得多.(2)中的“kill”在语言中的宾语应是生物,显然“杀死一个程序”这样的解释不会得到认可.

汉语中的谚语、歇后语、成语等往往都蕴含着大量的隐喻,如“种瓜得瓜,种豆得豆”显然表示的不仅仅是“瓜”和“豆”.而诗词歌赋更是如此,往往一首诗整体就是一个隐喻,可以说没有隐喻就没有诗歌.这些诸多的隐喻现象如果仅仅依靠字面翻译,结果往往是不理想的.

对隐喻的研究最早可以追溯到亚里士多德,他提出的对比论和替代论认为隐喻是一种词语层面的修辞方法,将隐喻看作一种附加的、可有可无的“修饰”,缺乏对隐喻的本质认识.随后,Black从结构语义学和哲学的角度提出了隐喻的互动理论,指出隐喻的理解涉及到本体和喻体间的互动[1].20世纪80年代,Lakoff和Johnson从认知角度提出了概念隐喻理论[2],认为隐喻是源域和目标域两个概念之间的映射,逐步建立了隐喻在思维及语言中的中心地位.之后,出现了很多隐喻认知模型[3],如概念映射模型[4]、现代隐喻理论[5]等.

本文从隐喻识别和隐喻解释两个方面介绍现有的隐喻计算模型以及隐喻语料资源,并对这些模型的优缺点和适用范围进行比较.

1 基本理论 1.1 概念隐喻理论(conceptual metaphor)Lakoff和Johnson[2]在《我们赖以生存的隐喻》中提出概念隐喻理论,认为人类认识世界总是以自身的经验为基础,我们日常用来思考和行动的概念系统也是通过隐喻构建的.认知语言学家认为隐喻包括源域,目标域,源域和目标域之间的关系、映射等.隐喻就是把源域映射到目标域上,理解源域的结构来理解目标域.概念隐喻就是从源域到目标域的映射.如:时间是金钱,在这个概念隐喻中,用金钱去类比时间,金钱的特点如宝贵等通过映射的推理方式引伸到时间的概念上.

概念隐喻分为:结构隐喻、方位隐喻和实体隐喻.结构隐喻是用一种概念的结构来映射另一种概念,通常用源域中比较具体而熟悉的概念去映射目标域中比较抽象和陌生的概念,如上述中的“时间是金钱”.方位隐喻是指通过空间概念由源域向目标域映射,通过直观的空间概念理解抽象概念.实体隐喻是指用物体和物质的概念来理解和描述情感、事件等概念.

Lakoff和Johnson认为概念隐喻最主要的功能是通过认知的具体经验知识来理解抽象的领域,概念隐喻是对认知概念化的一种推理方式,是从一个概念域到另一个概念域的映射.

1.2 选择限制异常中断理论(selectional preference restriction)Wilks[6]基于选择优先理论,给出了隐喻理解的选择限制异常中断的方法.他认为隐喻的出现必然会引起选择优先的异常,因此,在选择优先模型的基础上加上隐喻识别,通过语义选择优先的异常中断来触发对隐喻的识别和理解.此外,Wilks还加入了辅助理解的情景知识——伪文本(pseudo-text).一旦隐喻触发了异常中断,那么就在伪文本中寻找一个合适的语义框架来解释异常现象.例如“my car drinks gasoline”,其中drink的主语应为生命体,宾语应为液体,也就是drink的优先语义为((ANIMATE,SUB),(LIQUID,OBJ)),而这里的car不是生命体,因此触发了异常中断,隐喻解释系统从伪文本中选择一个合适的语义框架来代替.

1.3 结构映射理论(the structure-mapping theory)Gentner[4]指出,隐喻映射是一种结构映射.结构映射不区分匹配和投射,它把隐喻的理解看作是匹配和投射都存在的过程.映射首先表现出匹配映射,接着才是投射映射.不同的隐喻映射只是在这两个过程表现出来的优越性不同.在匹配阶段,主要是寻找两个域的相似性,利用这个不明显的相似性来凸显这两个域中的共同属性.在投射中,映射的作用主要是揭露目标域中隐藏的部分.Gentner详细地阐述了结构映射的处理过程,同时也指出结构映射在语言进化中也起到特别重要的作用,它有助于新概念的生成.

2 隐喻识别 2.1 基于语法搭配的方法Krishnakumaran和Zhu[7]基于Wilks的优先中断的思想,利用WordNet中的上、下位义关系,提出了“A is B”,“verb+noun”,“adj+noun”的隐喻识别方法.给定一个含有“A is B”的句子,如果主语A和宾语B之间存在WordNet中的上、下位义关系,那么这个句子为字面义表达,否则为隐喻表达.

对于含有“verb+noun”,“adj+noun”结构的句子,首先用二元语法对Web 1T语料库进行语法标注,计算“verb+noun”和“adj+noun”(包括名词的上下位义词)在语料库中共同出现的频率,如果这个频率大于给定的阈值,那么认为这个句子为字面义用法,否则认为是隐喻用法.

不同于Wilks和Fass[8],Krishnakumaran提出的这种方法只依赖于WordNet中的上、下位义关系和Web 1T的二元语法选择限制,而不是人工标注的知识库.Krishkumaran不仅仅解决了动词的选择限制,也包括形容词和“A is B”形式的隐喻表达.

但是,由于依赖二元语法分析,语法分析器的精确性成为制约此方法正确率的重要因素,并且这些算法对于代词“it”造成的错误分类并没有有效地得到解决.另外,利用WordNet带来歧义的影响仍然存在.

2.2 基于聚类的方法Shutova[9]提出通过对动词和名词的聚类来进行隐喻识别.首先,他以英国国家语料库(BNC)中部分已经标注的隐喻表达为种子集合(动宾结构),将这些动宾词组的动词看作是源域概念,其中的名词看作目标域概念,通过名词聚类获得同一源域映射大量目标域概念,通过动词聚类获得大规模的源域概念集合.这样获得的动词和名词聚类形成映射关系,可以用来对更大语料库的隐喻现象进行标注,标注结果加入到系统最先采用的种子集合中,不断丰富聚类的类型.例如,种子集合中有“stir excitement”这样的隐喻表达,通过名词聚类,发现“anger,comment,enthusiasm”等和“excitement”处于同一个类别中,通过动词聚类得到“swallow,hurl,spark”等和“stir”处于同一类别.这样,当文章中出现如“swallow anger,hurl comment”的短语时,系统就可以识别为隐喻表达.

我们可以看到,其中的关键部分就是聚类.这里的聚类不同于WordNet中简单的同义关系的聚合,Shutova采用了谱聚类(SPEC)[10]的方法得到大量的源域和目标域概念集合,然后对其中的词按照选择优先强度(SPS)[11]的方法进行过滤,将弱选择优先的词汇删除,这样就得到了最终的源域和目标域概念集合.

Shutvoa结合了概念隐喻理论和语义优先理论,以BNC(British National Corpus)为语料库,提出了采用谱聚类的新颖的隐喻识别系统.这种方法类似于基于WordNet的隐喻识别,所不同的是,它是以BNC为语料库,因此没有识别域的限制.另外,不同于WorldNet中单纯的同义关系,采用聚类的算法可以更加有效地将尽可能多的具有内在联系的动词(名词)形成概念集合,能够识别更大范围的隐喻表达.但是,由于采用初始的种子集合,这样便使得系统的召回率存在问题.另外,Shutvoa的这种方法还只是初步适用于V+N形式的隐喻表达,有待进一步应用在更多形式的隐喻映射.

2.3 基于语料库的方法 2.3.1 基于概念特征的聚合Mason[12]给出了一个基于语料库的识别和分析规范隐喻的计算系统CorMet,主要从大量语料中识别和分析隐喻.

首先,通过搜索引擎收集各个领域语料,之后用英语语义分析器(APP)分析收集到的文档,获得语句的框架.

然后,根据语料中各词干在左右词干中的比率与通用的频率词典进行比较提取特征谓词,相对频率较高的那些词干即为特征谓词.如在LAB领域,动词“vapor”在语料库中出现的频率为0.000 7,在通用英语词典中频率为5.2e-7,因此,“vapor”的相对频率为1 325.527,这表明“vapor”在LAB领域中出现的频率远远高于通用频率.

随后,CorMet采用Resnik的选择优先学习算法[13]获取一个动词的优先语义,即出现在动词各个格位上的选择偏好,由选择强度来度量.谓词的选择优先表示为一个四元组(verb,case,node,A),表示WordNet节点node出现在动词格位case上的选择优先度A.这样,动词在一个格位上的优先语义就可以用一个向量来表示.然后用K近邻聚类算法对这些动词聚类,就获得了一个领域的概念特征.

最后,CorMet 利用极性(polarity)来确定两个概念在隐喻句中的成分,极性表示两个概念或领域之间概念转移的方向和数量.当一个概念在某个领域的语言特性被应用于其他领域的另外一个概念时,极性就变为非零.如果一个概念a适用的动词同样适用于概念b,而有些b适用的动词在a中不适用,则称a为喻体(源)概念,b为本体(目标)概念.

CorMet利用机器学习的方法自动获取动词的选择优先,避免了手工标注的缺点.但是,CorMet所能处理的是两个所属不同概念域的动词隐喻,对于非规范的模糊隐喻则无法解释.

2.3.2 基于论元角色的抽取Gedigian[14]在WSJ等语料库和PropBank命题库[15]以及FrameNet映射标注方法的基础上,利用最大熵模型,给出了动词隐喻的分类器.

Gedigian认为隐喻就是具体域到抽象域的映射,但是没有语料库的帮助,这些映射很容易出错.因此,Gedigian首先选取WSJ语料库(Wall Street Journal Corpus)中的部分动词作为子集,将其标注为隐喻表达或者字面义表达.在对已标注的动词子集进行分析之后,Gedigian认为目标动词论元的类型对未知句子的隐喻识别具有决定性的作用,因此他用WordNet作为类型层级,从PropBank标注的句子中提取论元信息,将隐喻概括为两个框架角色之间的映射.如果论元来自于源域(具体概念),那么这个动词就判别为字面表达,反之,如果论元来自于目标域(抽象概念),那么这个动词就判别为隐喻表达.Gedigian利用PropBank直接提取论元,根据Collins语料库的方法,对每一个论元,提取首词的信息.如果首词是代词,那么这个论元被判别为代词类型;如果首词是已命名实体,用BNN的IdentiFinder包作为论元的类型[16];如果两者都不是,那么用WordNet中该论元的同义词集合作为论元的类型.对已有的数据集做上述处理后,他将其中65%的数据作为训练集,20%作为测试语料.最后,Gedigian使用Standford 线性分类器[17]来训练语料.这样,根据目标动词的论元类型,就建立了一个动词隐喻的分类器.

Gedigian认为其方法与CorMet等其他基于优先选择的识别模型的区别在于,CorMet使用关键字作为域的特征,而他使用论元的语义角色,这样可以避免映射过程中存在的诸多噪音干扰现象的发生.但是,由于动词存在极大的偏向性,当一个动词在语料库中全部偏向隐喻表达或者全部偏向字面义表达时,分类器不可避免地会出现较大误差.另外,对于训练语料之外的动词,分类器的识别能力较差.

2.4 基于相似度的机器学习方法 2.4.1 句子相似度计算Brike和Sarker[18]给出了一个识别字面义表达和非字面义表达的计算模型——TroFi(Trope Finder)系统,解决了动词的字面义和非字面义用法的识别与分类问题.

TroFi通过对Karov和Edelman的词义消歧算法[19]结合句子的上下文信息进行改进,以实现对目标动词的字面义和非字面义的识别.TroFi将BNC,WSJ以及WordNet提取的高频词汇和成语、习语、熟语等人工地分为字面义用法集合和非字面义用法集合.Brike和Sarker认为,如果两个句子含有相似的词,那么这两个句子相似;如果两个词分别处于两个相似的句子中,那么这两个词语相似.基于这样的理论,TroFi系统将目标词汇所处的句子集合分别与字面义和非字面义集合中的每一个句子计算相似度并求和,如果与字面义集合的相似度较大,那么该目标动词为字面义用法,反之亦然.基于这样的方法,TroFi系统将动词以字面义和非字面义进行聚类,实现了对二者的识别.

与Mason提出的CorMet系统相似,TroFi系统也采用WordNet作为知识库,并从大量的语料库中提取上下文信息.但是,TroFi摒弃了CorMet以及Wilks,Fass等人的选择优先异常中断的方法,采用了聚类的算法.

Brike和Sarker提出的基于词义消歧的算法和聚类的方法仅仅解决了动词的字面义和非字面义的识别问题,对于非字面义中的隐喻、比喻、成语、习语等并没有进行细致的划分.

2.4.2 词义相似度计算Nissim和Market[20]也提出了一种基于计算词义相似性的机器学习方法来识别转喻——PMWs.与TroFi相同的是,PMWs也采用计算上下文相似度的方法来确定目标词汇的相似度,但是区别于PMWs的有监督的机器学习方法,TroFi采用了无监督的相似度计算算法.

通过对语料的分析,Nissim发现转喻都是按照既定的模式进行的,因此,转喻的识别可以归结为分类问题,可以用词义消歧的方法来解决.但不同于传统的词义消歧,转喻的识别是训练同一语法层次的不同词语,将它们的字面义和转喻义分配给该语法层次上的新语句.Nissim认为偏正关系是语法层面上转喻识别精度最高的特征,因此对于整篇文本或者句子,他将其简化为偏正模式,如“Pakistan had won the World Cup”简化为“Pakistan- subj-of-win”,“Scotland lost in the semi-final”简化的“Scotland-subj-of-win”.这样两个句子建立了一种语法层次上的相似,对于两个谓词“win”和“lose”也存在相似性.

Nissim将训练语料用上述的简化方式标注后,提取出特征词,用决策表(decision list)的形式列出,然后计算特征词和上下文的最大似然概率,从而区别出是字面义还是转喻.

Nissim和Market提出的这种基于计算词义相似度的机器学习方法,从语法层次上很好地解决了转喻的识别问题.通过借助词典避免了类似方法中的数据稀疏问题.他将转喻的识别划归为分类问题,并且借用词义消歧的方法.但是,传统的词义消歧和转喻识别有很大差距,Nissim并没有提出很好的方法来解决这一问题.

3 隐喻解释 3.1 基于优先语义方法Fass[8]在选择优先中断的基础上,提出了修正语义学,并给出了一个用于解释隐喻性语言的系统Met*.Met*区分了隐喻、转喻、字面义以及异常语言.在Met*中,转喻是指用一个事物引用另一个事物的方法,主要是基于事物之间的基本关系,允许一个事物代替另一个事物.而隐喻则是基于相关概念之间共有的属性,揭示两个事物之间关系的方法.对于形如“X is Y”语句,Met*首先查找X与Y之间是否满足优选限制.若满足,则表示可以从字面意义理解,算法结束;若存在优选限制冲突,则进入转喻搜索,寻找可用的转喻.若找到,表示X与Y之间可以通过转喻解释来形成字面意义关系;若没有,则继续在转喻链寻找其他可用的转喻关系,直到所有可能的转喻均没有找到,跳出转喻搜索,进入寻找隐喻关系.若没有,则认为X和Y之间属于异常运用.Met*系统中,动词的意义由一个向量来表示,其中的元素为动词参数的优先选择类型.如动词“drink”的优先选择向量是(animal,drink,liquid),通过实际词义向量与动词优先参数和实际参数共同祖先的匹配向量进行隐喻的解释.比如对于“My car drinks gasoline”,词义向量表示为(car,drink,gasoline),这与drink的优先向量(animal,drink,liquid)不匹配,系统为两个向量搜索一个公共的祖先向量,即(thing,use,energy-source).因此,该隐喻就解释为“My car uses gasoline as an energy source”.

这种方法认为隐喻语言的理解可以通过使用所涉及概念的泛化知识来理解,而不需要具体词义.但是,这就要求首先要通过判断,辨别其是否偏离了已知字面解释的语义,从而识别出隐喻句的存在,也就是要有识别隐喻句的过程.这说明隐喻的解释被看作是一种认知过程,需要上下文、世界知识以及类比推理技术,符合认知语言学的观点.然而,基于优先语义学的方法受限于所构造的本体(ontology),也依赖于手工构造的字面意义选择优先,因此在构造规模和一致性上难以得到保障.

3.2 基于推理的方法 3.2.1 基于词义替换的推理Veale和Hao[21]提出了一个基于推理的隐喻解释模型——Talking Points.Talking Points利用WordNet和网页来提取源域和目标域概念的特征集合,提取的原则有:1) 如果某个词在WordNet中的注释是形如Adj+Noun的形式,那么Talking Points注释为“is_Adj:Noun”;2) 如果一个名词在WordNet中有形如{Adj+Noun}的上位词,那么这个名词的Talking Points解释为“is_Adj:Noun”;3) 如果一个词在WordNet中的解释具有“主+谓+宾”的结构,那么其Talking Points解释为“谓语:宾语”.

然后,Talking Points将其中提取到的特征集按照Slipnet的规则[22]进行插入、删除、替换等操作,建立源域和目标域概念之间的联系,这样就对隐喻表达进行了解释.

从上图的例子中可以看出,对make-up原有的解释“typically worn by women”进行插入、替换等操作后,形成了新的解释“must be worn by Muslim women”,也就是WordNet中“Burqa”的解释,这样就解释了“make-up”和“burqa”隐喻表达.但是Veale和Hao并没有说明Talking Points推理隐喻解释的应用范围.

3.2.2 基于类比的推理Martin[23]给出了一个隐喻识别系统——MIDAS,并将其应用于Unix操作系统的教学软件.

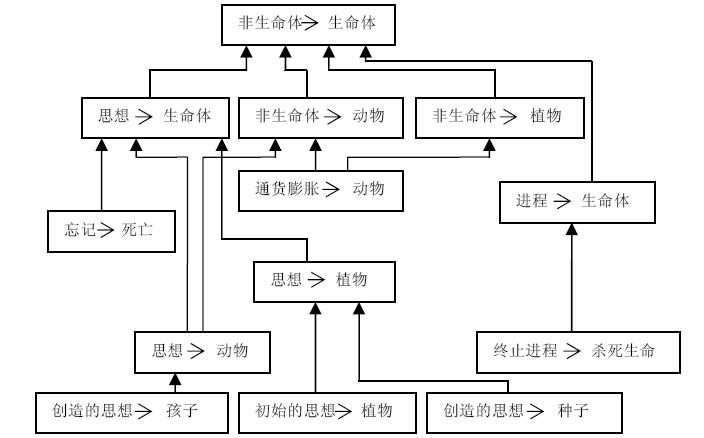

MIDAS采用KL2ONE 的扩展语义系统KODIAK作为知识表示语言,KODIAK通过继承机制和概念层次结构联结各知识元素.MIDAS中隐喻映射的层次关系如图 1所示,图中方框内的小箭头表示把前一个概念看作后一个概念,方框之间的箭头表示映射之间的继承关系.

| Fig. 1 Hierarchical relationships of metaphorical mapping图 1 隐喻映射的层次关系 |

隐喻解释系统分两步处理:第1步对输入的句子进行句法分析,并形成初步的语义表示,这一步得到的是初步内容(primal content),可以认为是解释过程的一个中间阶段,主要来源于分析器的语法和词库;第2步把这个初步内容替换为能解释输入的具体解释,即真实内容,它可能是字面意义或者是某个常规隐喻解释.第2步中涉及两种推理模式:一种称为具体化模式,用具体概念替换抽象概念;另一种是用相应的目标概念替换源概念.当出现新的隐喻时,MIDAS通过隐喻扩展系统(MES)对现有的隐喻进行扩展来解释,其中涉及到3种扩展推理方法:相似性扩展主要是基于类比推理原则,同一个喻源概念可应用于类似的目标概念;核心扩展的前提是喻源概念之间的关系可以根据核心保留的原则转移到目标领域;组合扩展则综合了前两种扩展.隐喻扩展算法首先搜索与新隐喻相关的隐喻,然后通过计算新隐喻与各相关隐喻之间的概念距离来选取概念上最接近的相关隐喻,应用该隐喻来解释新隐喻,最后存储新的隐喻.

MIDAS最大的特点在于它是一种基于推理的方法,能够解释新进入系统的隐喻[24].

3.3 基于语料库的方法Shutova[25]在优先语义学的基础上,提出了由BNC语料库引导动词隐喻解释的方法.他认为,隐喻解释就是将隐喻表达直译为字面义表达.Shutova首先选取BNC作为实验语料库,利用MIP[26]对语料库标注,根据上下文信息生成隐喻动词的可能释义,应用概率模型决定每个可能释义的排列,然后根据Resnik提出的选择性关系测量过滤其中不相关的或者仍为隐喻表达的释义,这样就得到了隐喻动词可能释义的候选列表,最后利用WordNet进行词义消歧得到最终的隐喻释义.Shutova用动宾结构隐喻对提出的模型进行测试,并得到0.82的准确率.

3.4 基于向量空间的方法Shutova[27]提出了一种基于向量空间的隐喻解释模型,他抛弃了以往对于人工标注数据以及字典资源(如WordNet)的依赖,率先以完全无监督的方式解决了隐喻释义问题.他认为,与简单的词汇替换不同,隐喻解释还需要识别生成释义中的字面义和隐喻部分.

Shutova选用了UKwac语料库[28]和Stanford Part-Of-Speech标注语料[29]对文本进行自动标注,提取出其中每个动词的依存关系组.通过因式分解模型(factorization model)[30],Shutova获得了目标动词所在文本的潜在特征,并计算每个特征的条件概率p(z|dj),通过公式p(d|dj)=p(z|dj)p(d|z)可以获得每个释义的条件概率.但是,Shutova认为,隐喻的释义还受到目标动词本身的制约,因此将公式引入目标动词wi变形为p(d|wi,dj)=p(d|wi)p(d|dj),其中d为包含目标动词可能释义的向量.如“reflect concern”中“reflect”的释义向量为(address,0.1657;highlight,0.1638; express,0.1608;focus,0.1488;outline,0.1473;comment,0.1415).可以看到,向量空间里的有些释义(比如highlight)对于“concern”来说也是隐喻用法.基于此,Shutova根据Resnik提出的优先词义的方法对结果进行过滤重排,得到新的向量(express,0.1822;nurture,0.0809;share,0.0771;reinforce,0.0522;demonstrate,0.0088;lack,0.0088),这样,就完成了“reflect”的隐喻解释.

Shutova提出的这种基于向量空间的方法主要完成了对“verb+obj”和“subj+verb”结构的隐喻解释,并取得了良好的测试效果.但是,由于该方法是在单一文本的基础上构建模型,对于准确率必然会产生影响.Shutova只解决了动词的隐喻解释问题,对于名词以及形容词等其他词汇并没有过多的涉及.

4 隐喻语料资源[31]综上我们可以看到,隐喻是一种基于知识获取的语言现象.因此,如何人工或者自动地获取这些知识,亦即语料资源,成为隐喻识别和解释过程中必不可少的部分.

4.1 Master Metaphor List[32]Lakoff最早提出了基于源域和目标域映射的在线知识库——重要隐喻目录(Master Metaphor List),用来处理常规隐喻表达.

Lakoff从出版的隐喻文献、Berkely分校研究生论坛中收集隐喻实例,手工编辑而成.他将数据库中的隐喻实例分为event structure(时间结构)、mental events(心理事件)、emotions(情感)和other(其他)这4个范畴,每个词条又分为不同层级的隐喻类别.每个隐喻类别都包含了各种隐喻的源域和目标域的描述及例句.

Master Metaphor List是最早的隐喻知识库之一,将各种隐喻形式按照专家们的直觉划分成不同的概念隐喻类别,而没有考虑这些隐喻是否已经词汇化.

4.2 Sense-Frame[8]Fass在Met*系统中创建了词例化隐喻知识库——Sense-frame.其中每个词义框架包含了arcs和node两部分.Arcs包含了该词条类属条目,语义框架内所有的arcs共同构成了深层结构化的语义网络.Node包含了各个语义框架的差异.

例如动词“eat”在Sense-frame中的描述:

其中,[supertype,[ingest1,expend1]]代表了一个语义网络,node2表示“eat”是一个动词,[object,[preference,food1]]则表示该词条的优先语义特征.

利用Sense-frame对名词、动词和形容词不同的形式化描述,Fass实现了Met*对隐喻的解释.

4.3 MetaBank[33]Martin将经验诱导与理论驱动相结合,从文本语料的收集和语言知识的泛化、资源的扩展方法、知识库的构建3个方面探索了隐喻知识库的构建.他将这3个方面综合为一个整体框架,提出了MetaBank.

在文本语料的收集和语言的泛化方面,MetaBank采用了Master Metaphor List、WSJ语料库以及一个UNIX操作系统用户邮件语料库,为Martin研究相关语料库提供了必要的资源.

在资源的拓展方面,Martin采用了习惯性思维的定义,以直接搜索已知隐喻并随机抽取的方法来实现.另外,MetaBank还是用了OntoLingua知识表达语言,这样能够提供隐喻的独立规范的表示方法,并能为知识库的潜在使用提供帮助.

此外,还有如ATT-Meta[34],Metalude[35],Hamburg Metaphor Database[36],ItalWordNet等隐喻知识库.

5 中文隐喻研究相比于英文隐喻的计算研究,中文隐喻研究起步较晚.要建立汉语隐喻的理解机制,首先要对汉语隐喻现象进行分析归类[37].杨芸[38]通过对大规模语料的归纳,从本体和喻体的相似点出发,将隐喻理解由难及易地划归为九大类.戴帅湘[39]在杨芸的隐喻分类基础上,针对隐喻计算化,从语句的结构出发提出了新的形式化网络,方便地引入了语义中的世界知识,对隐喻识别和理解的计算化模型有一定的意义.

在隐喻识别方面,王治敏[40]在机器学习的基础上,借助于CCD词典,利用相似度的推理方法对形如“n+n”的名词隐喻进行了有效的识别,取得了令人满意的效果.赵红艳[41]在条件随机场和最大熵模型的基础上,融入《同义词词林》的同义词信息和《知网》的语义信息,将两者结合起来实现隐喻识别,为解决隐喻识别问题提供了新的思路.徐扬[42]和王治敏[43]分别利用最大熵的分类方法构建了统计模型,在人工语料库标注的基础上,进一步预测和识别了名词隐喻.徐扬提出了更加具体的特征提取和模型训练方法.李斌、于丽丽[44]等人将最大熵模型和条件随机场模型相结合解决了“像”的明喻计算问题,并识别出本体、喻体和相似点.黄孝喜[45]利用依存句法得出隐喻句的各种依存模式,最终提出了一种树模式匹配算法,实现了隐喻的识别.

在隐喻理解方面,周昌乐[46]认为应从隐喻的认知机制出发,结合语言活动中隐喻的产生和理解过程机理、人类隐喻能力的神经生物学与认知心理学基础,将隐喻的理解作为一种认知手段,而不是传统意义上的修辞手法.张威[47]从隐喻的语义真值问题和逻辑全知问题这一角度入手,参考局部框架理论,引入池空间、理解算子和格式塔等概念,提出了汉语隐喻逻辑系统.苏畅[48]从理解者的理解角度,忽视理解过程本身的复杂性,着眼于被理解的句子和其表述义之间的关系,构建了隐喻认知逻辑.贾玉祥、俞士汶[49]在利用Web搜索引擎获取海量明喻实例的基础上,建立了明喻知识库,基于所构建的知识库,提出了基于实例的隐喻自动理解和生成系统.游维、周昌乐[50]在对大规模语料库进行统计研究的基础上,建立起基于向量空间的模型,进行了词义相似度和词义相关度的计算,并构建了隐喻句生成系统.王金锦[51]从隐喻字面语义表示的角度出发,将汉语隐喻分为无嵌套隐喻和嵌套隐喻两种,并在分析隐喻字面语义的基础上,提出了将隐喻角色依存表示语言作为隐喻字面表示语言,最后给出隐喻角色依存表示语言生成算法.苏畅和周昌乐[52]在隐喻互动理论的基础上,将基于知识的方法和基于语料库的方法有机地结合在一起,创新性地使用合作机制来对隐喻进行理解.杨芸[53]采用特征匹配的方法对具有不同类型喻源概念的隐喻,提出了基于目标概念属性驱动的隐喻意义获取机制.

6 总 结本文从隐喻的基本理论出发,综述了隐喻计算模型,它们在处理局部问题或者某些特定的隐喻上取得了很好的效果,虽然在普遍地展开应用方面还有一定的局限性,但是不难发现,在上述诸多方法中,语料库扮演了一个非常重要的角色,因此,如何建立一个大规模的语料库就成为隐喻研究发展的重要因素.其次,上述方法都是针对某一特定类型的隐喻进行分析,例如“X is Y”型的隐喻,对于更为复杂或者更加生僻的隐喻尚未有一种良好的解决方法.

从上文来看,我们认为未来隐喻自动理解研究的难点主要集中在以下几个方面:

(1) 很多隐喻以篇章的形式存在,诸如诗歌、小说等文学作品中的以物喻人等写作手法下蕴含的篇章隐喻目前还无法实现.因此,确定可以面向机器理解的隐喻类型变得很重要.

(2) 对于相同的隐喻,不同的认知主体的理解结果可能并不相同.因此在隐喻理解时,有必要将认知主体的主观知识和认知角度纳入考虑范畴.如张威在逻辑系统中引入了理解算子,苏畅在认知逻辑中引入认知主体及观测角度,这些方法对于在隐喻模型中加入认知主体的主观状态提供了参考.

(3) 不同的文化背景下对于隐喻的处理往往也会产生差异.例如,在汉语中,龙的形象通常象征着吉祥、权威和尊贵.而在英语中,龙却是邪恶的.这种文化上的差异使得隐喻的研究,特别是隐喻理解必须将文化背景纳入考虑范畴.

因此,隐喻理解还需要从以下几个方面来考虑拓展和深入:

(1) 对于隐喻的分类.现有的隐喻分类方法主要从语言学的角度出发,侧重于语句的语言学特征.在当代隐喻研究的成果上,有必要充分利用语料,针对理解方式的不同,建立一种分类体系,给出详细的属性特征.

(2) 现有隐喻计算模型的应用往往比较单一,国外目前主要集中在动词隐喻的识别和理解上(如Shutova等人的方法),国内目前主要的研究集中在名词性隐喻的自动处理(如王治敏、苏畅等人的方法).我们认为,未来对于隐喻的自动处理研究可以着眼于提出一个广泛应用的、不拘泥于隐喻类型的计算模型.

(3) 语料库的建设.由上文我们可以看到,无论是MetaBank,ATT-meta,还是Sense-frame,都是从Master Metaphor List的基础上引伸而来.而国内的语料库在这方面的借鉴很少,远远没有达到国外的水平.另外,现有的语料库建设还处在各自为战的状态,都是为了给自身的研究做出相应的语料库,缺乏一个广泛适用和公开评测的语料资源.

(4) 从认知的角度来说,情感计算是隐喻理解的必然要求,然而目前的隐喻解释模型大多未涉及此类的研究.因此,如何把隐喻的情感计算加入到隐喻理解的范畴应成为隐喻研究的一个新课题.

(5) 从模型的理论基础来说,现今的多数方法都是基于统计理论的(如TroFi系统、PMWs系统等).隐喻更是一种认知现象,如果仅仅基于统计方法模型去处理隐喻理解问题,这是不够的.因此,我们认为必须要把隐喻的处理纳入认知的范畴,将现有的计算模型结合认知的方法,这样才能更好地处理隐喻问题.

(6) 从上文可以看出,Martin和Hao都是采用知识表达的方法展示隐喻理解的结果,而Shutova采用了类似于WordNet中释义的方法或者向量表的形式来表示.因此,应该如何统一地表示隐喻理解的结果,也是未来隐喻研究的一个方向.另外,目前对于隐喻理解的结果还缺少一个广泛适用的评价标准.

总之,隐喻计算化研究任重而道远,是一项迫切需要解决的科学难题,对于自然语言的处理技术发展有着十分重要的意义.

致谢 在此,我们向对本文给予帮助、支持和建议的同行,尤其是给我们提出宝贵建议的审稿人表示衷心的感谢.| [1] | Shu DF. Studies in Metaphor. Shanghai: Shanghai Foreign Language Education Press, 2000 (in Chinese). |

| [2] | Lakoff G, Johnson M. Metaphors We Live By. Chicago: University of Chicago Press, 1980. |

| [3] | Simone SE, Korhonen A. Statistical metaphor processing. Computational Linguistics, 2013,39(2):301-353 . |

| [4] | Gentner D. Structure mapping: A theoretical framework for analogy. Cognitive Science, 1983,7:155-170 . |

| [5] | Lakoff G. The contemporary theory of metaphor. In: Ortony A, ed. Metaphor and Thought. Cambridge: Cambridge University Press, 1993. 202-251. |

| [6] | Wilks Y. A preferential, pattern-seeking, semantics for natural language inference. In: Words and Intelligence I. Springer-Verlag, 2007. 83-102 . |

| [7] | Krishnakumaran S, Zhu XJ. Hunting elusive metaphors using lexical resources. In: Feldman A, Lu XF, eds. Proc. of the Workshop on Computational Approaches to Figurative Language. Stroudsburg: Association for Computational Linguistics, 2007. 13-20. |

| [8] | Fass D. Met*: A method for discriminating metonymy and metaphor by computer. Computational Linguistics, 1991,17(1):49-90. |

| [9] | Shutova E, Sun L, Korgonen A. Metaphor identification using verb and nouns clustering. In: Joshi AK, Huang CR, Jurafsky D, eds. Proc. of the 23rd Int’l Conf. on Computational Linguistics (Coling 2010). Stroudsburg: Association for Computational Linguistics, 2010. 1002-1010. |

| [10] | Brew C, im Walde SS. Spectral clustering for German verbs. In: Proc. of the EMNLP.2002 . |

| [11] | Sun L, Korhonen A. Improving verb clustering with automatically acquired selectional preferences. In: Koehn P, Mihalcea R, eds. Proc. of the EMNLP 2009. Stroudsburg: Association for Computational Linguistics, 2009. 638-647. |

| [12] | Mason J. Cormet: A computational corpus-based conventional metaphor extraction system. Computational Linguistics, 2004, 30(1):23-44 . |

| [13] | Resnik PS. Selection and information: A class based approach to lexical relationships [Ph.D. Thesis]. Philadelphia: University of Pennsylvania, 1993. |

| [14] | Gedigan M, Bryant J, Narayanan S, Ciric B. Catching metaphors. In: Allen J, Alexandersson J, Feldman J, Porzel R, eds. Proc. of the 3rd Workshop on Scalable Natural Language Understanding. Stroudsburg: Association for Computational Linguistics, 2006. 41-48. |

| [15] | Kingsbury P, Palmer M. From TreeBank to PropBank. In: Zampolli A, Carreras AO, eds. Proc. of the LREC-2002. Gran Canaria, 2002. 1989-1993. |

| [16] | BBN Identifinder. 2004. http://www.bbn.com/technology/speech/identifinder |

| [17] | Stanford Classifier. 2003. http://nlp.stanford.edu/software/classifier.shtml |

| [18] | Birke J, Sarkar A. A clustering approach for the nearly unsupervised recognition of nonliteral language. In: Kilgarriff A, Baroni M, eds. Proc. of the EACL-06. Stroudsburg: Association for Computational Linguistics, 2006. 329-336. |

| [19] | Karov Y, Edelman S. Similarity-Based word sense disambiguation. Computational Linguistics, 1998,24(1):41-59. |

| [20] | Nissim M, Markert K. Syntactic features and word similarity for supervised metonymy resolution. In: Proc. of the 41st Annual Meeting of the Association for Computational Linguistics (ACL-03). Sapporo, 2003. 56-63 . |

| [21] | Veale T, Hao YF. A fluid knowledge representation for understanding and generating creative metaphors. In: Scott D, Uszkoreit H, eds. Proc. of the COLING 2008. Stroudsburg: Association for Computational Linguistics, 2008. 945-952. |

| [22] | Hofstadter DR, Mitchell M. The copycat project: A model of mental fluidity and analogy-making. In: Holyoak KJ, Barnden JA, eds. Advances in Connectionist and Neural Computation Theory, Vol. 2. Norwood: Ablex, 1995. 205-267. |

| [23] | Martin H. A corpus-based analysis of context effects on metaphor comprehension. In: Stefanowitsch A, Gries ST, eds. Corpus-Based Approaches to Metaphor and Metonymy. Berlin: Mouton de Gruyter, 2006. 207-228. |

| [24] | Huang XX, Zhou CL. Survey to models of metaphor comprehension. Computer Science, 2006,33(8):178-183 (in Chinese with English abstract) . |

| [25] | Shutova E. Automatic metaphor interpretation as a paraphrasing task. In: Kaplan RM, ed. Proc. of the NAACL 2010. Stroudsburg: Association for Computational Linguistics, 2012. 1029-1037. |

| [26] | Pragglejaz Group. MIP: A method for identifying metaphorically used words in discourse. Metaphor and Symbol, 2007,22:1-39 . |

| [27] | Shutova E, Van de Cruys T, Korhonen A. Unsupervised metaphor paraphrasing using a vector space model. In: Kay M, Boitet C, eds. Proc. of the COLING 2012. Mumbai, 2012. 1121-1130. |

| [28] | Baroni M, Bernardini S, Ferraresi A, Zanchetta E. The Wacky Wide Web: A collection of very large linguistically processed Web-crawled corpora. Language Resources and Evaluation, 2009,43(3):209-226 . |

| [29] | Toutanova K, Klein D, Manning CD, Singer Y. Feature-Rich part-of-speech tagging with a cyclic dependency network. In: Proc. of the HLT-NAACL 2003. 2003. 252-259 . |

| [30] | Van de Cruys T, Poibeau T, Korhonen A. Latent vector weighting for word meaning in context. In: Merlo P, Barzilay R, Johnson M, eds. Proc. of the 2011 Conf. on Empirical Methods in Natural Language Processing. Stroudsburg: Association for Computational Linguistics, 2011. 1012-1022. |

| [31] | Zhang XJ, Qu WG. Survey to the metaphor resources. Application Research of Computers, 2008,25(9):2561-2565 (in Chinese with English abstrct). |

| [32] | Shutova E. Models of metaphor in NLP. In: Hajič J, ed. Proc. of the 48th Annual Meeting of the Association for Computational Linguistics. Stroudsburg: Association for Computational Linguistics, 2010. 688-697. |

| [33] | Martin H. Metabank: A knowledge-base of metaphoric language conventions. Computational Intelligence, 1994,10:134-149 . |

| [34] | John B, Glasbey S, Lee M, Allan W. Reasoning in metaphor understanding: The ATT-Meta approach and system. In: Isabelle P, Charniak E, eds. Proc. of the 19th Int’l Conf. on Computational Linguistics. Stroudsburg: Association for Computational Linguistics, 2002. 1-5. |

| [35] | Shutova E, Teufel S. Metaphor corpus annotated for source-target domain mappings. In: Calzolari N, Choukri K, Maegaard B, eds. Proc. of the LREC 2010. Malta, 2010. 3255-3261. |

| [36] | Lönneker-Rodman B. The Hamburg metaphor database project: Issues in resource creation. Language Resources and Evaluation, 2008,42(3):293-318 . |

| [37] | Zhou CL. Research on Chinese metaphorical computing. Journal of Zhejiang University (Science), 2007,27(5):43-50 (in Chinese with English abstrct) . |

| [38] | Yang Y, Zhou CL. Preliminary study on Chinese metaphor classification based on machine understanding. Journal of Chinese Information Processing, 2004,18(4):31-36 (in Chinese with English abstrct) . |

| [39] | Dai SX, Zhou CL. Computational metaphor model and its application in metaphor classification. Computer Science, 2005, 32(5):159-166 (in Chinese with English abstrct) . |

| [40] | Wang ZM. Study of metaphorical similarity and metaphorical inference identification. Journal of Chinese Information Processing, 2008,22(3):37-44 (in Chinese with English abstrct) . |

| [41] | Zhao HY. The verbal metaphor identification based on machine learning and semantics. Journal of Nanjing Normal University, 2011,11(3):59-64 (in Chinese with English abstrct) . |

| [42] | Xu Y. Chinese metaphor identification based of the maximum entropy model. Computer Engineering and Science, 2007, 29(4):95-103 (in Chinese with English abstrct) . |

| [43] | Wang ZM, Wang HF, Yu SW. Chinese noun metaphor identification based on machine learning. High Technology Letters, 2006, 17(6):575-580 (in Chinese with English abstrct). |

| [44] | Li B, Yu LL, Shi M, Qu WG. Metaphor computing of “like”. Journal of Chinese Information Processing, 2008,22(6):27-32 (in Chinese with English abstrct) . |

| [45] | Huang XX. Study on some key issues of metaphor computing [Ph.D. Thesis]. Zhejiang: Zhejiang University, 2009 (in Chinese with English abstrct). |

| [46] | Zhou CL. Metaphor as a mean of cognition and its embodiment analysis. Mind and Computation, 2008,2(3):272-278 (in Chinese with English abstrct). |

| [47] | Zhang W, Zhou CL. The logic description of Chinese metaphor comprehension. Journal of Chinese Information Processing, 2004,18(15):23-28 (in Chinese with Engliah abstract) . |

| [48] | Su C. Study on calculation method of Chinese nominal metaphor [Ph.D. Thesis]. Xiamen: Xiamen University, 2008 (in Chinese with English abstrct). |

| [49] | Jia YX, Yu SW. Metaphor comprehension and production based on examples. Computer Science, 2009,36(3):138-141 (in Chinese with English abstrct) . |

| [50] | You W, Zhou CL. Chinese metaphor generation model and its implementation based on statistics. Mind and Computation, 2007,(1):133-141 (in Chinese with English abstrct). |

| [51] | Wang JJ, Yang Y, Zhou CL. Metaphor literal representation and generation. Journal of Chinese Information Processing, 2009, 23(3):85-102 (in Chinese with English abstrct). |

| [52] | Su C, Zhou CL. Chinese nominal metaphor comprehension method based on cooperation mechanism. Application Research of Computers, 2007,24(9):67-70 (in Chinese with English abstrct) . |

| [53] | Yang Y. Computational model of Chinese metaphor recognition and interpretation [Ph.D. Thesis]. Xiamen: Xiamen University, 2008 (in Chinese with English abstrct). |

| [1] | 束定芳.隐喻学研究.上海:上海外语教育出版社,2000. |

| [24] | 黄孝喜,周昌乐.隐喻理解的计算模型综述.计算机科学,2006,33(8):178-183 . |

| [31] | 张宵军,曲维光.国内外隐喻知识库建设综述.计算机应用研究,2008,25(9):2561-2565 . |

| [37] | 周昌乐.探索汉语隐喻计算化研究之路.浙江大学学报,2007,27(5):43-50 . |

| [38] | 杨芸,周昌乐.基于机器理解的汉语隐喻分类研究初步.中文信息学报,2004,18(4):31-36 . |

| [39] | 戴帅湘,周昌乐.隐喻计算模型及其在隐喻分类上的应用.计算机科学,2005,32(5):159-166 . |

| [40] | 王治敏.名词隐喻相似度及推理识别研究.中文信息学报,2011,11(3):59-64 . |

| [41] | 赵红艳.基于机器学习与语义知识的动词隐喻识别.南京师范大学学报,2011,11(3):59-64 . |

| [42] | 徐扬.基于最大熵模型的汉语隐喻现象识别.计算机工程与科学,2007,29(4):95-103 . |

| [43] | 王治敏,王厚峰,俞士汶.基于机器学习方法的汉语名词隐喻识别.高技术通讯,2006,17(6):575-580. |

| [44] | 李斌,于丽丽,石民,曲维光.“像”的明喻计算.中文信息学报,2008,22(6):27-32 . |

| [45] | 黄孝喜.隐喻机器理解的若干关键问题研究[博士学位论文].杭州:浙江大学,2009. |

| [46] | 周昌乐.作为认知手段的隐喻及其涉身性分析.心智与计算,2008,2(3):272-278. |

| [47] | 张威,周昌乐.汉语隐喻理解的逻辑描述初探.中文信息学报,2004,18(15):23-28 . |

| [48] | 苏畅.汉语名词性隐喻的计算方法研究[博士学位论文].厦门:厦门大学,2008. |

| [49] | 贾玉祥,俞士汶.基于实例的隐喻理解和生成.计算机科学,2009,36(3):138-141 . |

| [50] | 游维,周昌乐.基于统计的汉语隐喻生成模型及其系统实现.心智与计算,2007,(1):133-141. |

| [51] | 王金锦,杨芸,周昌乐.隐喻字面义表示与生成.中文信息学报,2009,23(3):85-102. |

| [52] | 苏畅,周昌乐.基于合作机制的汉语名词性隐喻理解方法.计算机应用研究,2007,24(9):67-70 . |

| [53] | 杨芸.汉语隐喻识别与解释计算模型研究[博士学位论文].厦门:厦门大学,2008. |

2015, Vol. 26

2015, Vol. 26